A consolidação dos SSDs de 245TB: O roadmap de storage para 2026

Análise de mercado: Com a Solidigm e Pure Storage rompendo a barreira dos 200TB, avaliamos o impacto no TCO de datacenters, o declínio dos HDDs Nearline e os riscos de latência em 2026.

A indústria de armazenamento corporativo inicia 2026 em um ponto de inflexão que analistas vinham prevendo desde o início da década: a densidade do flash finalmente rompeu a barreira da lógica econômica que protegia os discos rígidos (HDDs) no data center. Com a chegada iminente dos SSDs de 245TB (e a promessa de 300TB da Pure Storage), não estamos apenas falando de "mais espaço", mas de uma rearquitetura fundamental da infraestrutura de hiperescala.

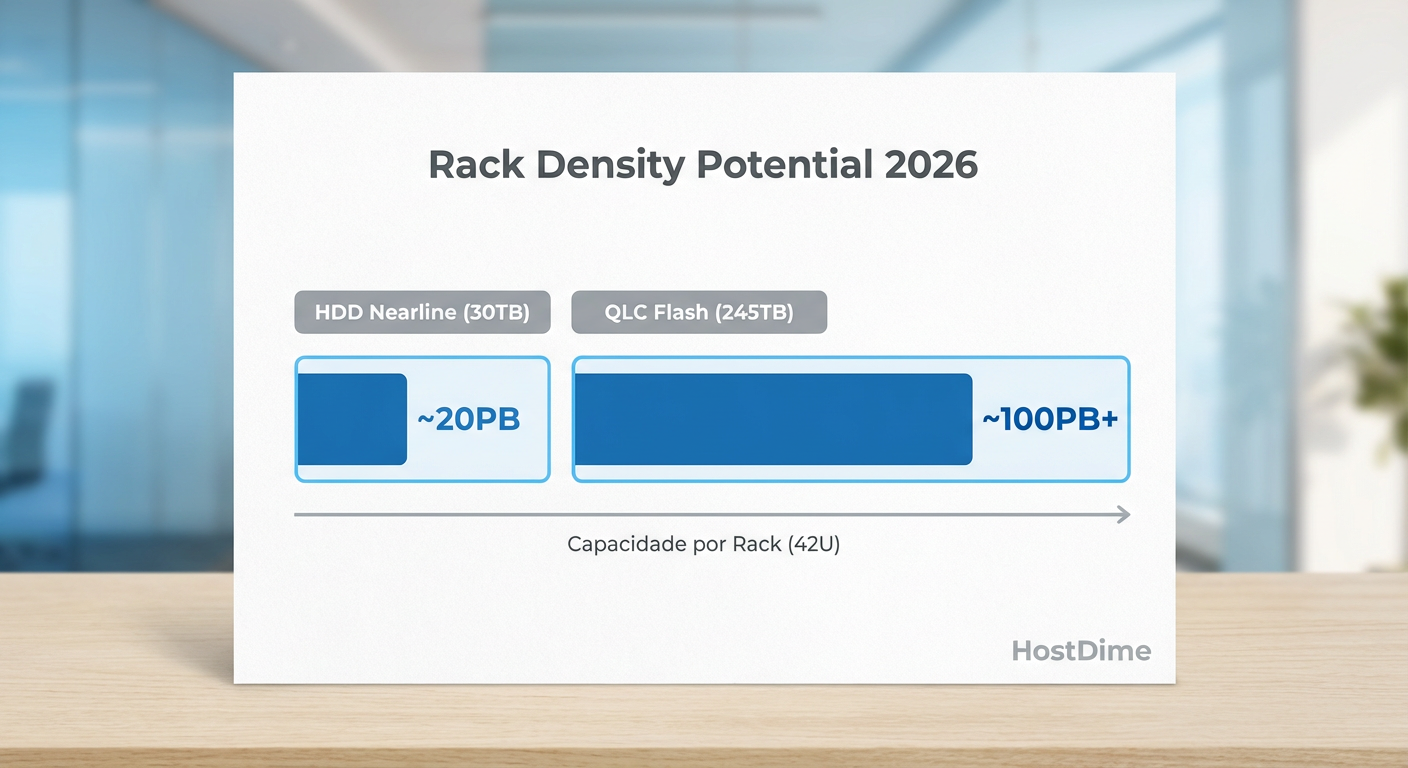

Se 2025 foi o ano em que o QLC (Quad-Level Cell) provou sua confiabilidade em cargas de trabalho de leitura intensiva, 2026 será o ano da consolidação massiva. A métrica chave deixou de ser apenas $/GB (custo por gigabyte) e migrou agressivamente para TB/Watt e TB/Rack Unit. Neste cenário, a tecnologia de estado sólido está dizimando a proposta de valor dos arrays de discos mecânicos legados.

Resumo em 30 segundos

- Guerra de Densidade: A Solidigm lidera com drives QLC de 245TB, enquanto a Pure Storage avança com módulos proprietários de 300TB, ambos visando eliminar HDDs nearline.

- NAND 4D: A tecnologia de 321 camadas da SK Hynix é o motor industrial que permitiu essa escala, reduzindo drasticamente o custo de fabricação por bit.

- Risco Operacional: Drives ultra-densos trazem o desafio do "raio de explosão" (blast radius). Perder um único drive de 245TB exige estratégias de reconstrução (rebuild) que o RAID tradicional não suporta.

A corrida pela densidade: Solidigm vs Pure Storage

O mercado de storage enterprise se bifurcou em duas abordagens distintas para alcançar a ultra-densidade. De um lado, temos a Solidigm (subsidiária da SK Hynix), que aposta na padronização. Seus novos drives de 245TB, sucessores naturais dos modelos D5-P5336 de 122TB lançados anteriormente, utilizam fatores de forma padrão da indústria, como o E1.L (EDSFF), permitindo que servidores off-the-shelf de fabricantes como Dell, HPE e Supermicro alcancem densidades de múltiplos petabytes em apenas 1U ou 2U.

Do outro lado, a Pure Storage mantém sua estratégia de "jardim murado" com os DirectFlash Modules (DFM). A promessa de atingir 300TB por módulo em 2026 coloca a empresa em uma posição única. Diferente dos SSDs convencionais que escondem a complexidade da NAND atrás de um controlador interno (FTL), a Pure gerencia a memória flash diretamente via software do array.

💡 Dica Pro: Para CTOs planejando renovação de hardware em 2026, a escolha entre SSDs padrão (Solidigm/Samsung/Micron) e módulos proprietários (Pure/IBM) deve basear-se na estratégia de vendor lock-in. Drives padrão oferecem flexibilidade de fornecedor; módulos proprietários geralmente entregam melhor eficiência de garbage collection e longevidade, mas prendem você ao ecossistema.

Essa competição não é apenas sobre quem tem o maior número na etiqueta. É sobre a densidade por rack. Com drives de 245TB, é possível, teoricamente, alocar quase 8 Petabytes em um servidor 1U (considerando 32 slots E1.S/L). Isso transforma radicalmente a economia de colocation e energia.

Fig. 1: A disparidade de densidade por rack entre HDDs modernos e a nova geração de Flash QLC amplia o abismo de eficiência energética.

Fig. 1: A disparidade de densidade por rack entre HDDs modernos e a nova geração de Flash QLC amplia o abismo de eficiência energética.

O alicerce técnico: NAND de 321 Camadas

A viabilidade comercial desses monstros de capacidade deve-se quase inteiramente aos avanços na litografia 3D NAND. A SK Hynix, controladora da Solidigm, iniciou a produção em massa de sua 4D NAND de 321 camadas (V9), que representa um salto de eficiência de produção de 59% em comparação com a geração anterior de 238 camadas.

O termo "4D" refere-se à arquitetura Periphery under Cell (PuC), onde os circuitos lógicos são colocados sob as células de memória, economizando espaço no die de silício. Isso permite chips de 1 Terabit (Tb) com rendimento excepcional.

Para o mercado, isso significa que o custo de fabricação de um SSD de 245TB caiu a níveis onde ele compete diretamente com arrays de HDDs Nearline de alta performance em TCO (Custo Total de Propriedade) de 5 anos. Não é que o SSD custe menos na compra inicial, mas a redução de 90% no consumo de energia e espaço físico compensa a diferença (o "prêmio do flash") em cerca de 18 a 24 meses.

Fig. 2: A arquitetura de 321 camadas da SK Hynix (4D NAND) é o alicerce técnico que viabiliza chips de 1Tb e drives de 200TB+.

Fig. 2: A arquitetura de 321 camadas da SK Hynix (4D NAND) é o alicerce técnico que viabiliza chips de 1Tb e drives de 200TB+.

O fim da "Lei de Moore" para HDDs

Enquanto o roadmap de NAND Flash segue uma curva agressiva de duplicação de densidade, a indústria de discos rígidos enfrenta barreiras físicas severas. Em 2026, os HDDs baseados em HAMR (Heat-Assisted Magnetic Recording) da Seagate e as tecnologias equivalentes da Western Digital estão lutando para escalar além de 40TB-50TB em volume de massa com rendimentos aceitáveis.

Existe agora um gap de densidade de 5x a 6x entre o maior HDD disponível e o maior SSD disponível.

⚠️ Perigo: Insistir em HDDs para workloads que exigem alta densidade de throughput (IOPS/TB) está se tornando um erro financeiro. Um HDD de 40TB ainda oferece os mesmos ~500 IOPS de um HDD de 10TB de uma década atrás. A densidade de IOPS (IOPS por GB) caiu drasticamente, criando gargalos severos em aplicações modernas de Analytics e IA.

O problema do "Blast Radius" e a morte do RAID

A adoção de drives de 245TB ou 300TB introduz um risco crítico que arquitetos de soluções devem mitigar: o raio de explosão.

Quando um disco de 10TB falhava, a reconstrução (rebuild) demorava horas. Quando um drive de 245TB falha, estamos falando de uma quantidade de dados que, mesmo saturando um link PCIe 4.0 ou 5.0, pode levar um tempo considerável para ser restaurada, deixando o array vulnerável a uma segunda falha.

O RAID tradicional (5 ou 6) é matematicamente inviável para essas capacidades. A probabilidade de um erro de leitura irrecuperável (URE) durante a reconstrução de 245TB é estatisticamente alta demais.

Soluções Mandatórias para 2026:

Erasure Coding (EC) Avançado: Sistemas como MinIO ou Ceph, configurados com paridade ampla (ex: 16+4), são essenciais.

Rebuild Declustered: A reconstrução não deve depender de um disco "hot spare" passivo, mas sim utilizar o espaço livre de todos os discos do cluster para paralelizar a escrita, reduzindo o tempo de vulnerabilidade de dias para horas.

Inteligência Preditiva: O armazenamento deve monitorar a telemetria do SSD e evacuar dados antes da falha total do componente.

Previsão: O ponto de inflexão para IA

A inteligência artificial generativa e os LLMs (Large Language Models) mudaram o perfil de I/O. O treinamento de modelos requer checkpoints frequentes. Se um cluster de GPU tiver que esperar 30 minutos para gravar um checkpoint em HDDs lentos, isso representa milhões de dólares em tempo de computação ociosa.

Em 2026, observamos que o armazenamento para IA abandonará definitivamente o conceito de "Tiering para HDD". O custo de manter as GPUs paradas esperando dados supera em muito a economia de comprar discos rotacionais. SSDs de ultra capacidade, como os de 245TB, permitem criar data lakes de exabytes que são inteiramente flash, alimentando as GPUs via barramentos CXL ou InfiniBand sem latência mecânica.

Perspectiva Estratégica

O lançamento e a consolidação dos SSDs de 245TB em 2026 marcam o início do fim para os discos rígidos no datacenter primário e secundário. O HDD não desaparecerá este ano, mas será relegado exclusivamente ao "Cold Storage" (arquivamento profundo/fita virtual).

Para as empresas, a recomendação é clara: pare de planejar expansões de datacenter baseadas em contagem de eixos (spindles). O futuro é densidade de silício. Ignorar essa transição resultará em infraestruturas com custos operacionais de energia e refrigeração insustentáveis antes do final da década.

Perguntas Frequentes (FAQ)

1. Drives de 245TB são confiáveis para dados críticos? Sim, mas com ressalvas arquiteturais. A tecnologia QLC moderna atingiu níveis de resistência (DWPD) adequados para a maioria das cargas de trabalho de leitura intensiva (datalakes, streaming, IA). O risco não é a célula de memória falhar, mas sim o impacto operacional de perder 245TB de uma vez. Redundância em nível de software/cluster é obrigatória.

2. Qual a interface necessária para esses drives? Para justificar o investimento, utiliza-se predominantemente NVMe sobre PCIe Gen5. Interfaces SAS ou SATA são gargalos inaceitáveis para essa densidade. O formato físico dominante tende a ser o EDSFF (E1.S ou E3), projetado para melhor dissipação térmica do que o antigo M.2 ou U.2.

3. O preço por TB do SSD já é menor que o do HDD? No custo de aquisição (CapEx), não. O HDD ainda é cerca de 5x a 7x mais barato por TB na compra. No entanto, o TCO (Custo Total de Propriedade) em 3 a 5 anos favorece o SSD de alta densidade devido à economia massiva de energia, refrigeração e, principalmente, licenças de software que são cobradas por soquete de CPU ou por nó (menos servidores para a mesma capacidade).

Arthur Siqueira

Analista de Mercado de Storage

"Analiso o cenário macroeconômico do armazenamento corporativo. Meu foco está nos movimentos de consolidação, flutuações de market share e na saúde financeira que dita o futuro dos grandes players."