A Era dos Agentes: O Colapso e o Renascimento do Storage Corporativo

Agentes de IA autônomos exigem uma nova arquitetura de dados. Descubra como CXL, Computational Storage e NVMe estão redefinindo a infraestrutura para o operador sintético.

A infraestrutura de dados que construímos nas últimas três décadas foi desenhada para um ritmo biológico. O clique do mouse, o envio de um formulário, o streaming de um vídeo. Tudo operava na escala de tempo humana. Estamos agora à beira de um precipício evolutivo onde essa lógica deixa de funcionar. A chegada dos Agentes de IA autônomos não é apenas uma mudança de software; é um evento de extinção para a arquitetura de armazenamento tradicional.

O operador sintético não dorme, não pausa para o café e, crucialmente, não lê dados sequencialmente. Ele "pensa" através de milhares de consultas vetoriais simultâneas, exigindo uma granularidade de acesso que faria um array All-Flash de 2020 engasgar. O futuro do hardware não é sobre armazenar mais; é sobre eliminar a distância física entre a lógica e o bit.

Resumo em 30 segundos

- O Fim do I/O Humano: Agentes de IA geram padrões de tráfego "ruidosos", aleatórios e massivos (RAG), tornando obsoletos os sistemas otimizados apenas para leitura sequencial.

- A Revolução CXL: O protocolo Compute Express Link quebrará as barreiras físicas dos servidores, permitindo pools de memória compartilhada que eliminam o gargalo da DRAM local.

- Storage Computacional: Para lidar com a gravidade dos dados, o processamento (busca vetorial) migrará da CPU para dentro do próprio SSD, economizando energia e largura de banda.

A ascensão do operador sintético

Até ontem, o gargalo era o disco mecânico. Resolvemos isso com o NAND Flash. Hoje, o gargalo é a própria arquitetura de Von Neumann. Quando um Agente de IA executa uma tarefa complexa — digamos, auditar toda a base de contratos de uma multinacional em busca de riscos climáticos — ele não baixa os arquivos. Ele realiza um processo chamado RAG (Retrieval-Augmented Generation).

Isso gera um padrão de I/O (Input/Output) que chamo de "tempestade de agulhas". São milhões de pequenas leituras aleatórias de 4KB ou 8KB em bancos de dados vetoriais, buscando similaridade semântica. O storage tradicional, desenhado para entregar grandes blocos de dados para aplicações monolíticas, entra em colapso sob essa latência de cauda.

Figura: Visualização comparativa: O fluxo linear do I/O humano versus a "tempestade de agulhas" do I/O de Agentes de IA.

Figura: Visualização comparativa: O fluxo linear do I/O humano versus a "tempestade de agulhas" do I/O de Agentes de IA.

Para o storage corporativo sobreviver, ele precisa deixar de ser um "armário de arquivos" passivo para se tornar um participante ativo na computação.

O muro da memória e a libertação via CXL

A lei de Moore para processadores continuou, mas a capacidade de memória por soquete de CPU estagnou. Estamos vivendo o que a indústria chama de "Memory Wall". Seus aceleradores (GPUs, NPUs) estão famintos, mas os dados estão presos em SSDs "lentos" ou limitados pela quantidade de slots DDR5 na placa-mãe.

A solução que redefinirá os datacenters nos próximos 5 anos é o CXL (Compute Express Link).

Imagine que a memória RAM não pertença mais a um servidor específico. Com o CXL 3.0 e 3.1, a memória torna-se um recurso desagregado, um pool líquido que pode ser acessado por qualquer processador no rack via barramento PCIe, com latência próxima à da DRAM nativa.

💡 Dica Pro: Não confunda CXL com RDMA ou NVMe-oF. Enquanto estes últimos movem dados via rede (Ethernet/InfiniBand), o CXL opera no protocolo de coerência de cache, permitindo que a CPU "enxergue" a memória remota como se fosse local.

Isso permite a criação de "Memory Appliances". Se o seu Agente de IA precisa carregar um modelo de 500GB na memória para inferência rápida, você não precisa comprar um servidor com 1TB de RAM que ficará ocioso depois. Você aloca dinamicamente 500GB do pool via CXL, usa e devolve.

Comparativo: Arquitetura Atual vs. Arquitetura CXL

| Característica | Arquitetura Tradicional (NUMA) | Arquitetura CXL (Desagregada) |

|---|---|---|

| Localização da RAM | Presa fisicamente ao slot da CPU | Compartilhada em pool no rack ou chassi |

| Escalabilidade | Limitada pelos slots da placa-mãe | Limitada apenas pelo barramento/switch CXL |

| Latência | Baixíssima (<100ns) | Baixa (~170-250ns) - Aceitável para Tier 2 |

| Custo por GB | Alto (DRAM superprovisionada) | Otimizado (DRAM alocada sob demanda) |

| Uso Ideal | OS, Apps sensíveis à latência zero | Bancos de dados In-Memory, Cache de IA massivo |

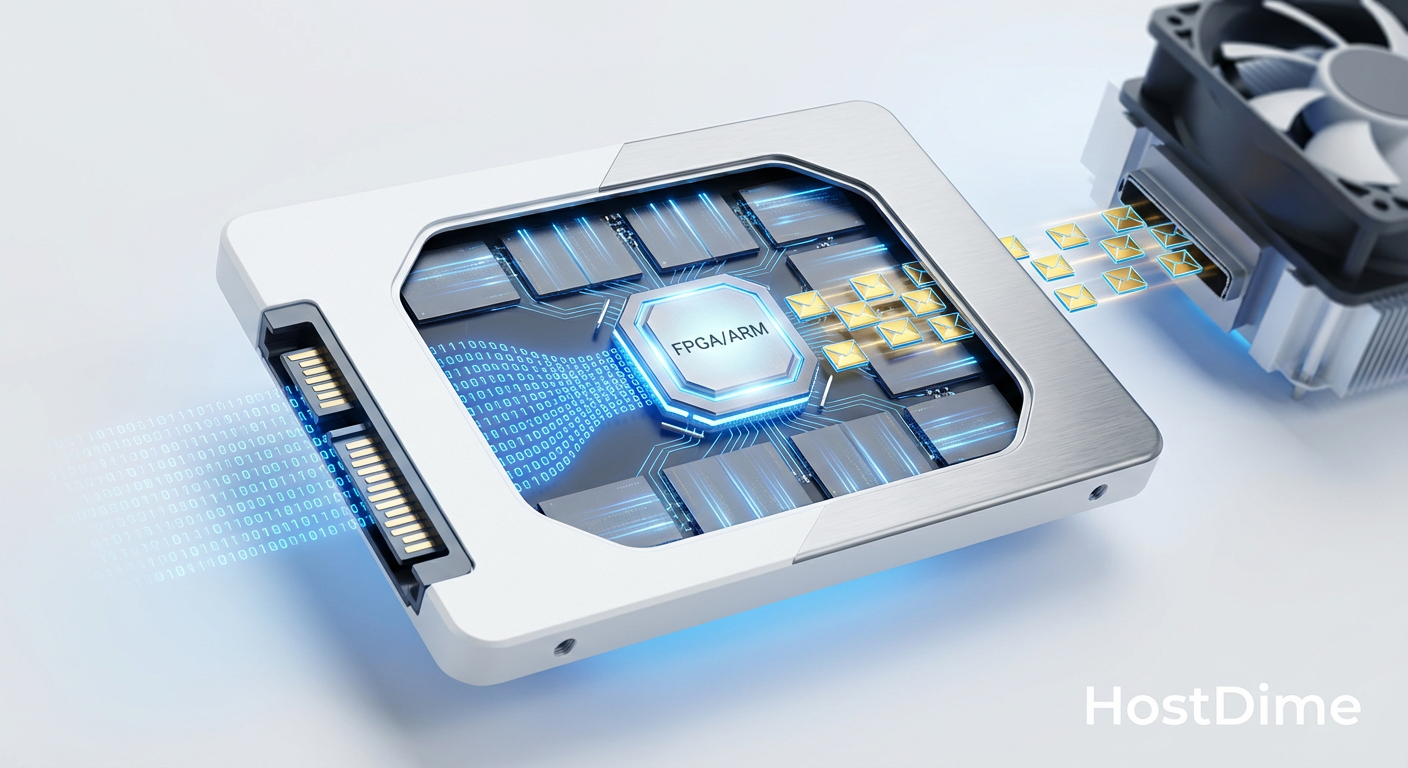

Computational storage: O SSD inteligente

Mover petabytes de dados do storage até a CPU apenas para filtrar 99% deles é um desperdício energético que não podemos mais sustentar. A gravidade dos dados dita que a computação deve ir até o dado, e não o contrário.

Aqui entra o Computational Storage (CS). Em vez de um SSD NVMe passivo, temos drives equipados com processadores ARM ou FPGAs integrados.

No cenário de IA, isso é revolucionário para a busca vetorial. Imagine um array com 100 SSDs. Ao receber uma query complexa, em vez de o servidor principal ler todos os dados, ele envia a instrução de busca para os 100 SSDs. Cada drive processa seus próprios dados internamente e retorna apenas os resultados (os vetores similares).

O tráfego no barramento PCIe cai drasticamente. A CPU do servidor fica livre para gerenciar o raciocínio do Agente, enquanto o "trabalho sujo" de varredura é feito na ponta.

Figura: Diagrama de um drive de Storage Computacional: O processamento ocorre dentro do SSD, filtrando dados antes que eles atinjam o barramento principal.

Figura: Diagrama de um drive de Storage Computacional: O processamento ocorre dentro do SSD, filtrando dados antes que eles atinjam o barramento principal.

A falácia do selo "AI-Ready"

Caminhando pelos corredores de conferências de tecnologia, vejo o selo "AI-Ready" colado em tudo, desde NAS domésticos até HDDs externos. Cuidado.

Para um ambiente de storage corporativo suportar a era dos agentes, velocidade de transferência (MB/s) é secundária. O que importa são:

Paralelismo Extremo: O sistema de arquivos deve suportar milhares de conexões simultâneas sem travar metadados (o problema clássico de "locking").

Qualidade de Serviço (QoS): Garantir que a latência de um Agente crítico não seja afetada por um backup em andamento.

Integração com Data Pipelines: O storage precisa falar a língua do Kubernetes e dos frameworks de ML (PyTorch/TensorFlow) nativamente, via drivers CSI (Container Storage Interface) robustos.

⚠️ Perigo: Implementar All-Flash arrays sem uma estratégia de gerenciamento de ciclo de vida de dados (ILM) é queimar dinheiro. Dados de treinamento antigos devem migrar automaticamente para camadas mais baratas (Object Storage ou Tape), deixando o NVMe apenas para o "Hot Data" dos Agentes ativos.

O horizonte distante: DNA Storage

Se extrapolarmos a geração de dados por agentes sintéticos para a próxima década, encontraremos um problema físico de densidade. Agentes gerarão logs de "pensamento", históricos de decisões e versões de modelos que precisarão ser arquivados por razões regulatórias ou de segurança. A fita magnética (LTO) tem um roadmap sólido, mas tem limites físicos.

O armazenamento em DNA deixa de ser ficção científica e entra no radar de longo prazo. A densidade teórica é absurda: todos os dados do mundo hoje caberiam em uma caixa de sapatos cheia de DNA.

Embora as velocidades de escrita (síntese) e leitura (sequenciamento) ainda sejam lentas para operações em tempo real, o DNA Storage se posiciona como o "Cold Storage" definitivo. O arquivo imutável da história das nossas IAs. Empresas e consórcios (como a DNA Data Storage Alliance) já padronizam como codificar bits em pares de bases (A, C, T, G). Para o futurista de hardware, o silício é rápido, mas a biologia é densa.

Previsão

Estamos desmontando a arquitetura centrada na CPU. O servidor do futuro próximo não é uma caixa fechada; é uma rede de componentes desagregados onde o storage possui inteligência própria e a memória é um recurso fluido.

Quem insistir em arquiteturas monolíticas e discos passivos nos próximos 5 anos não enfrentará apenas lentidão. Enfrentará a irrelevância operacional. Os Agentes não terão paciência para esperar o prato girar. Prepare sua infraestrutura para a velocidade do pensamento sintético, ou prepare-se para ser deixado para trás.

Perguntas Frequentes (FAQ)

Qual a diferença entre storage para LLMs e storage para Agentes de IA?

Enquanto o treinamento de LLMs exige largura de banda massiva para leituras sequenciais (alimentar a GPU com grandes datasets), os Agentes de IA geram padrões de I/O aleatórios, contínuos e de baixa latência (RAG). Eles exigem IOPS extremos e acesso rápido a bancos de dados vetoriais para "lembrar" e "raciocinar" em tempo real.O que é CXL e por que ele é vital para a IA?

O Compute Express Link (CXL) é um padrão de interconexão que permite que a memória (RAM) seja compartilhada entre processadores e aceleradores via barramento PCIe. Ele quebra a barreira de capacidade de memória dos servidores individuais, permitindo pools de memória massivos necessários para manter grandes modelos e contextos de IA acessíveis sem latência de rede.Como o Computational Storage ajuda na busca vetorial?

Ele move o processamento da busca (query) para dentro do próprio SSD. Em vez de enviar terabytes de dados brutos para a CPU filtrar, o SSD processa a busca internamente e envia apenas os resultados relevantes. Isso economiza energia, libera o barramento PCIe e reduz drasticamente a latência em grandes datasets.

Julian Vance

Futurista de Tecnologia

"Exploro as fronteiras da infraestrutura, do armazenamento em DNA à computação quântica. Ajudo líderes a decodificar o horizonte tecnológico e construir o datacenter de 2035 hoje."