A singularidade da densidade: Discos de 50TB, HAMR e o novo limite físico

A era dos 50TB chegou. Descubra como a tecnologia HAMR venceu a termodinâmica, o fim do RAID tradicional e o que o futuro reserva para o armazenamento de dados em hiperescala.

Estamos testemunhando o fim da era magnética convencional e o início de um novo paradigma de física aplicada ao armazenamento. A Lei de Moore, frequentemente citada em processadores, encontra seu paralelo brutal na densidade de área dos discos rígidos. Contudo, diferentemente do silício, onde lutamos contra o tunelamento quântico, no armazenamento magnético a batalha é contra o limite superparamagnético. A chegada dos discos de 30TB foi apenas o tiro de largada. A verdadeira revolução, a singularidade da densidade que nos levará aos 50TB e além até 2027, reside na manipulação térmica da matéria em escala nanométrica.

Não estamos apenas "guardando mais arquivos". Estamos alterando a arquitetura fundamental de como a humanidade preserva sua memória digital. A transição para tecnologias como HAMR (Heat-Assisted Magnetic Recording) não é uma melhoria incremental; é um salto evolutivo comparável à mudança do tubo de vácuo para o transistor. Para o arquiteto de dados, o engenheiro de datacenter ou o entusiasta com um servidor TrueNAS no escritório, as regras de engajamento mudaram.

Resumo em 30 segundos

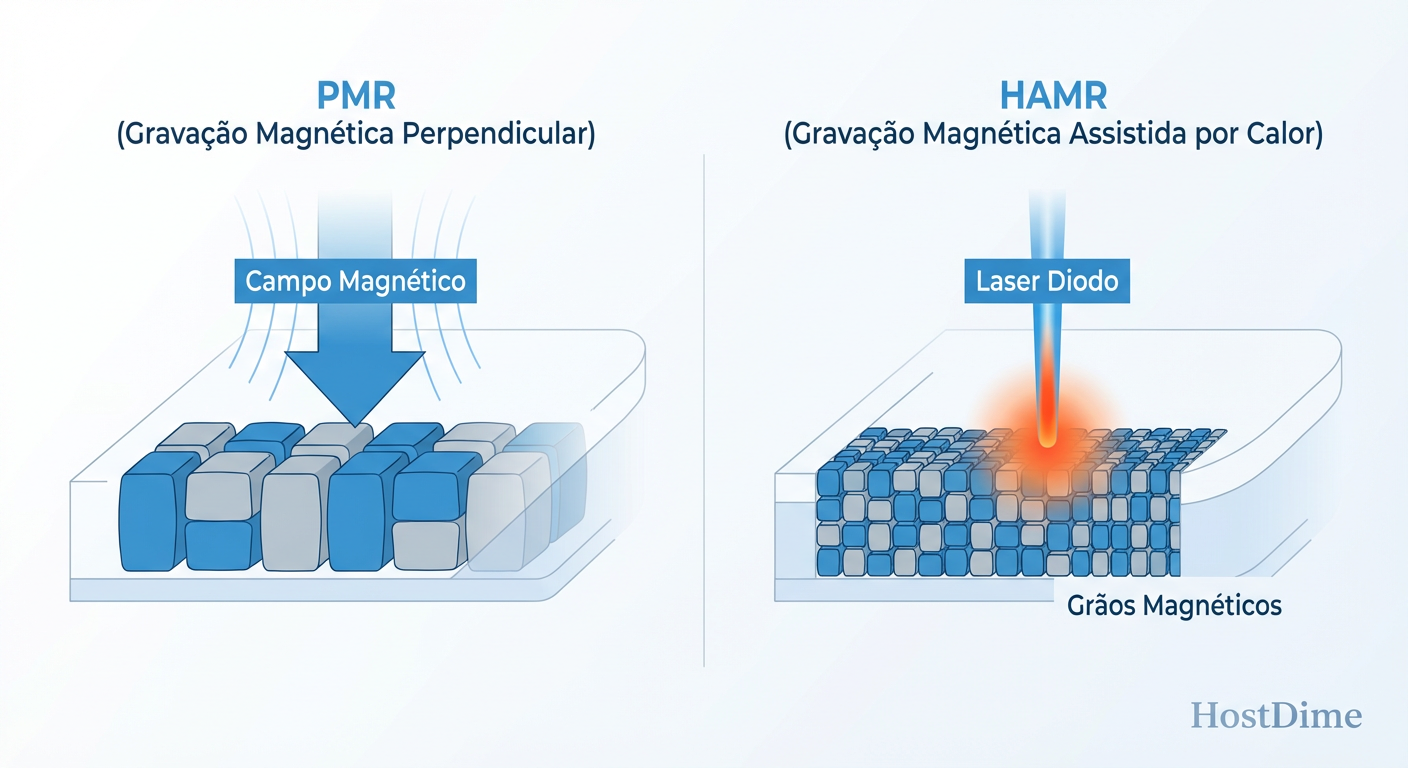

- A física mudou: O HAMR usa lasers para aquecer pratos de Ferro-Platina (FePt) a 400°C em nanossegundos, permitindo densidades de escrita impossíveis com a tecnologia PMR atual.

- O risco do RAID: Reconstruir um array com discos de 50TB usando métodos tradicionais é matematicamente insustentável; a probabilidade de falha secundária durante o rebuild exige novas estratégias como dRAID e Erasure Coding.

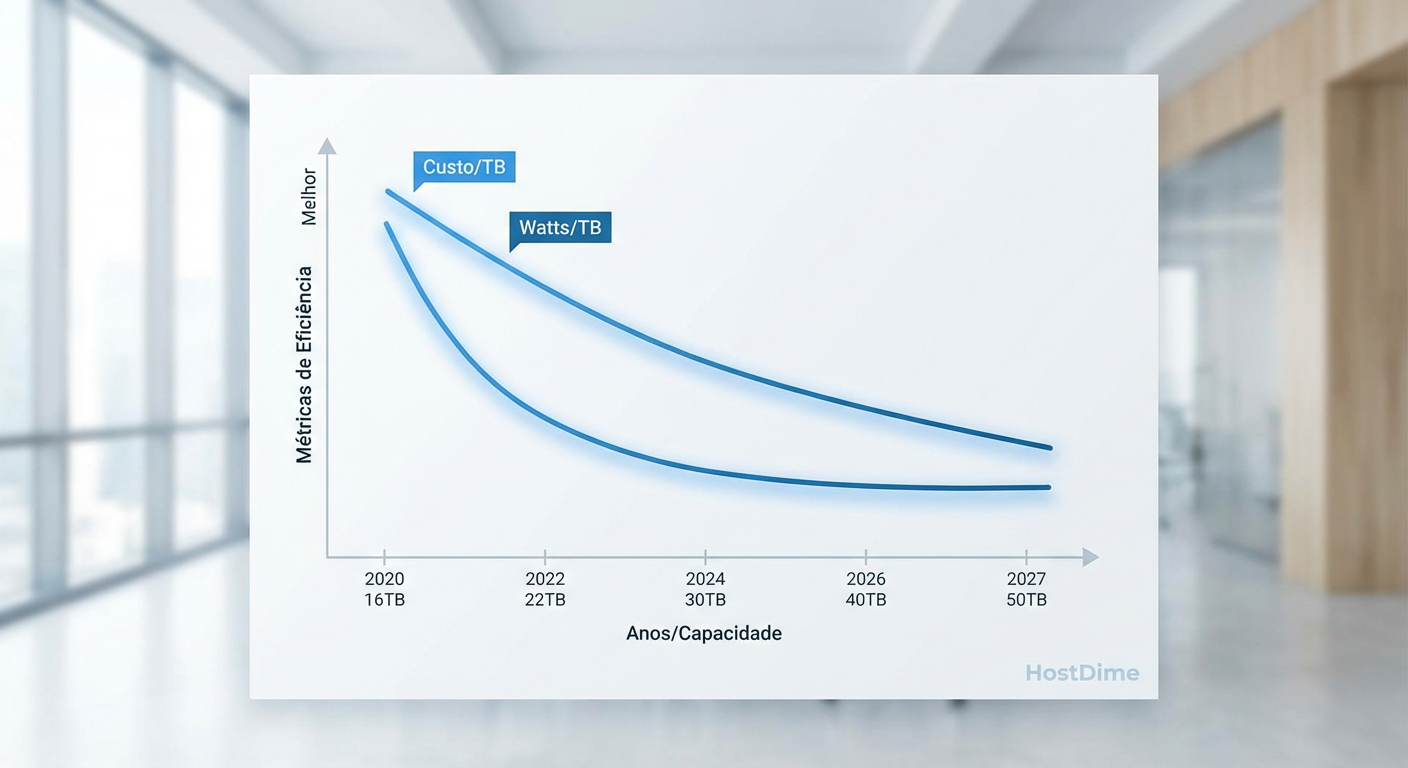

- Economia de escala: A densidade não serve apenas para "caber mais"; ela reduz drasticamente o TCO (Custo Total de Propriedade) ao diminuir o consumo de energia por petabyte e a pegada física no rack.

A barreira dos 30TB foi rompida e o mapa para 2027 está traçado

Até recentemente, a indústria de HDDs operava sob a tecnologia de Gravação Magnética Perpendicular (PMR) e suas variantes, como o SMR (Shingled Magnetic Recording), que empilhava trilhas como telhas num telhado para espremer bits extras. No entanto, essas tecnologias atingiram um muro físico. Tentar escrever bits menores em mídia magnética convencional resultava em instabilidade térmica; os bits simplesmente "evaporavam" ou invertiam sua polaridade espontaneamente.

A resposta da indústria, liderada por movimentos ousados da Seagate com a plataforma Mozaic 3+ e seguida de perto pela Western Digital e Toshiba, foi mudar o próprio material do disco. A introdução de pratos de vidro revestidos com uma liga de super-rede de Ferro-Platina (FePt) permitiu a criação de grãos magnéticos muito menores e com coercividade (resistência à mudança magnética) extremamente alta.

💡 Dica Pro: Ao planejar seu próximo upgrade de storage para 2026/2027, verifique a compatibilidade do chassi. Discos de alta densidade (30TB+) tendem a manter o formato 3.5", mas o consumo de energia e as vibrações exigem backplanes de alta qualidade e controle térmico rigoroso.

O roteiro agora é claro. Já temos unidades comerciais superando os 30TB. Os laboratórios já validaram protótipos de 50TB com densidades de área superiores a 2 Terabits por polegada quadrada. A previsão conservadora coloca o disco de 50TB nas prateleiras de datacenters e distribuidores especializados até 2027. Isso não é especulação; é engenharia em fase de validação final.

Como o laser nanoscópico venceu o limite superparamagnético

Para entender a magnitude do HAMR, precisamos visualizar o problema. Imagine tentar escrever seu nome na areia da praia com um palito. Se a areia for muito fina e seca (bits pequenos), o vento (energia térmica ambiente) apaga o que você escreveu. Para tornar a escrita permanente em escala nanométrica, precisamos de uma "areia" mais dura, como cimento úmido que seca instantaneamente.

O material FePt é esse cimento. Ele é tão magneticamente "duro" que as cabeças de gravação convencionais não conseguem gerar campo magnético suficiente para alterar um bit de 0 para 1. É aqui que entra a fotônica.

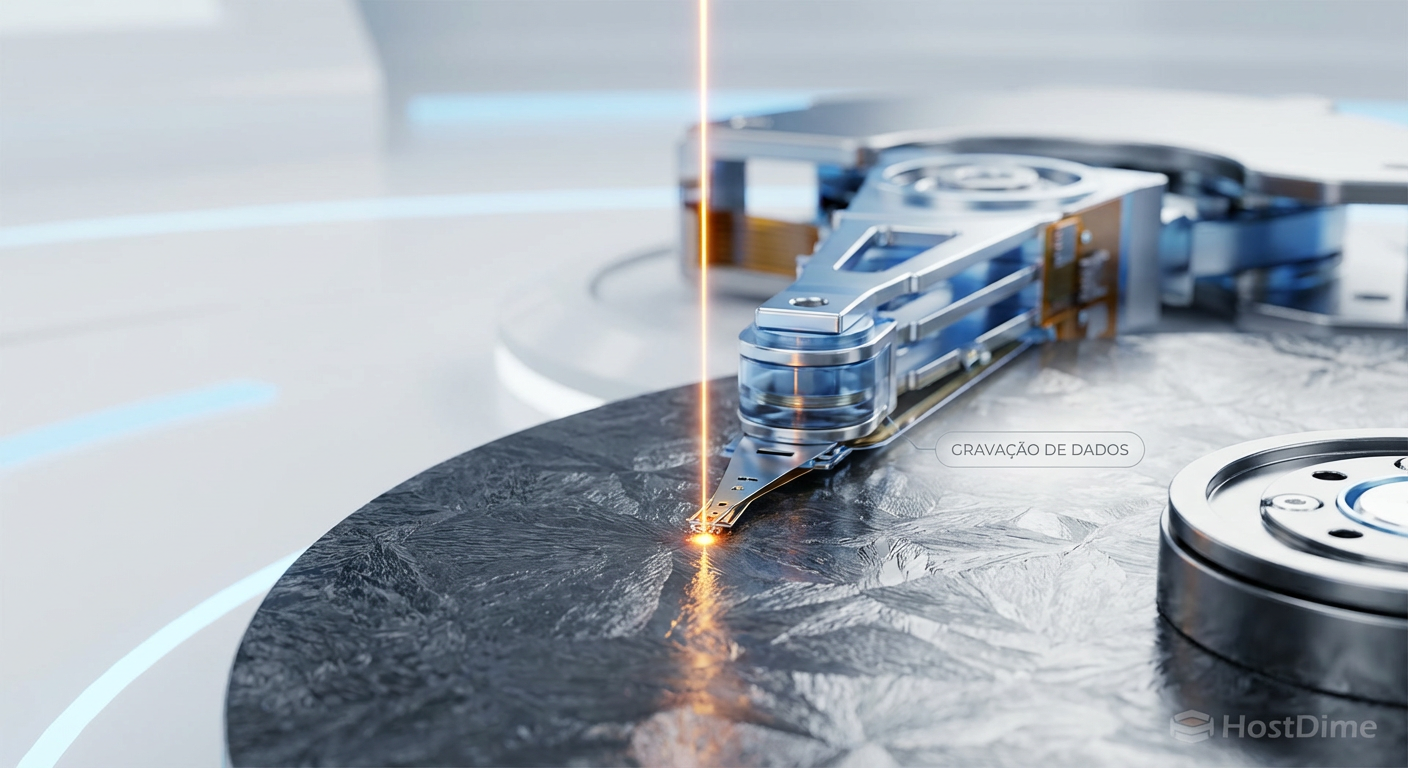

Fig 1. A física da densidade: Como o calor permite a escrita em grãos magneticamente 'duros'.

Fig 1. A física da densidade: Como o calor permite a escrita em grãos magneticamente 'duros'.

Cada cabeça de gravação HAMR possui um diodo laser e um transdutor de campo próximo (NFT). Este sistema aquece uma área minúscula do disco — menor que uma bactéria — a mais de 400°C em menos de um nanossegundo. O calor reduz temporariamente a coercividade do material, permitindo que a cabeça magnética escreva o dado. O resfriamento ocorre tão rápido quanto o aquecimento, "congelando" o bit no lugar.

Este processo ocorre milhões de vezes por segundo, enquanto o prato gira a 7200 RPM. A precisão necessária é alucinante. Estamos voando um Boeing 747 a centímetros do solo e pintando pixels individuais no asfalto enquanto passamos.

A economia brutal dos datacenters e a densidade energética por rack

A adoção de discos de 50TB não será impulsionada apenas pela necessidade de espaço, mas pela implacável matemática do custo operacional (OpEx). Em um ambiente de datacenter ou mesmo em um Home Lab avançado, o custo do hardware é apenas a ponta do iceberg. O verdadeiro vilão é o consumo de energia e o espaço físico.

Considere um petabyte (1PB) de dados.

Cenário Legado (Discos de 16TB): Você precisa de aproximadamente 63 discos. Isso ocupa cerca de 4 a 5 unidades de rack (dependendo do chassi) e consome, digamos, 450-600 Watts apenas para girar os motores.

Cenário Futuro (Discos de 50TB): O mesmo petabyte cabe em apenas 20 discos. Isso é menos de meio chassi padrão de 4U. O consumo cai para cerca de 180-200 Watts.

Fig 2. A curva de eficiência: O impacto direto da densidade de área no TCO do datacenter.

Fig 2. A curva de eficiência: O impacto direto da densidade de área no TCO do datacenter.

Essa densificação altera o TCO (Total Cost of Ownership) de forma dramática. Menos calor gerado significa menos ar condicionado (HVAC). Menos vibração significa maior longevidade dos componentes vizinhos. Para provedores de nuvem e empresas de armazenamento, a migração para 50TB+ não é opcional; é uma questão de sobrevivência econômica.

⚠️ Perigo: A densidade energética por slot aumenta. Embora o consumo total por PB caia, o calor gerado por disco pode subir ligeiramente devido à eletrônica do laser e processamento de sinal. Gabinetes antigos com fluxo de ar deficiente podem cozinhar esses drives novos. O resfriamento precisa ser preciso.

O pesadelo matemático da reconstrução de raid em volumes de 50TB

Aqui reside o grande paradoxo da densidade. Enquanto celebramos a capacidade, devemos temer a recuperação. A velocidade mecânica dos HDDs (taxa de transferência sequencial) não acompanhou o crescimento da capacidade na mesma proporção. Um disco de 50TB, mesmo com otimizações, dificilmente sustentará mais que 280-300 MB/s em operações de prato único.

Faça as contas. Se um disco de 50TB falhar em um array RAID 5 (o que você jamais deve usar nessas capacidades) ou RAID 6, a reconstrução completa do volume, lendo a velocidade máxima teórica, levaria cerca de 50 a 60 horas. No mundo real, com o servidor em uso, esse tempo pode facilmente triplicar, chegando a uma semana.

Durante essa semana de "rebuild", os discos restantes são submetidos a um estresse mecânico intenso (leitura de 100% de seus setores). A probabilidade de um erro de leitura irrecuperável (URE) ou de uma segunda falha de disco dispara. Em um RAID 5, isso significa perda total de dados. Em RAID 6, você perde a redundância e fica exposto.

A solução: Atuadores Duplos e Erasure Coding

Para mitigar isso, a tecnologia de Dual Actuator (como a Mach.2 da Seagate) torna-se obrigatória para drives de ultra-capacidade. Ao dividir o disco em dois volumes lógicos com braços independentes, dobramos efetivamente a taxa de transferência (para ~550 MB/s), cortando o tempo de reconstrução pela metade.

Além disso, sistemas de arquivos modernos como ZFS (usado no TrueNAS) com RAID-Z2 ou Z3, e arquiteturas de armazenamento distribuído (Ceph) usando Erasure Coding, são as únicas formas seguras de gerenciar essas densidades. O conceito de "RAID de hardware" tradicional está se tornando obsoleto diante da física desses novos dispositivos.

A fronteira dos 100TB e a convergência com bit patterned media

Onde isso termina? O laser nanoscópico do HAMR nos levará confortavelmente até os 50TB, talvez 60TB. Mas para atingir a meta visionária de 100TB por unidade na próxima década, precisaremos de mais uma mudança de paradigma: Bit Patterned Media (BPM).

Atualmente, um "bit" é uma ilha magnética composta por vários grãos aleatórios. No BPM, usaremos litografia (similar à fabricação de CPUs) para criar ilhas magnéticas ordenadas e perfeitamente espaçadas no prato. Cada ilha será um único bit.

A convergência do HAMR com o BPM (frequentemente chamada de HDMR - Heated Dot Magnetic Recording) permitirá densidades de 4 a 10 Terabits por polegada quadrada. Estamos falando de armazenar toda a biblioteca de conteúdo de vídeo de uma vida humana em um único dispositivo de 3.5 polegadas.

Ainda mais adiante, tecnologias como armazenamento em DNA ou vidro de quartzo (Project Silica) prometem densidade infinita, mas para o armazenamento "vivo", acessível e regravável, a combinação de magnetismo e óptica reinará suprema pelos próximos 15 anos.

O alerta da densidade

A era do armazenamento "despreocupado" acabou. Com discos de 50TB, cada unidade é um single point of failure massivo. A centralização de dados em fewer spindles (menos eixos) exige uma repensagem completa da estratégia de backup. A regra 3-2-1 precisa evoluir.

Minha previsão é que veremos uma bifurcação clara: o armazenamento flash (SSD/NVMe) dominará completamente a camada de performance e o sistema operacional, enquanto esses monstros magnéticos de 50TB+ se tornarão a camada de "Deep Archive" acessível, a fundação invisível da nuvem e dos grandes repositórios de dados privados. Se você gerencia dados, prepare sua infraestrutura térmica e lógica agora. A onda de densidade não vai esperar.

Perguntas Frequentes

1. O HAMR diminui a vida útil do disco devido ao calor? Não necessariamente. O aquecimento é extremamente localizado e dura menos de um nanossegundo. Os testes de confiabilidade indicam que as cabeças HAMR e a mídia FePt suportam petabytes de escrita, comparáveis ou superiores aos discos PMR atuais.

2. Preciso de conectores especiais para discos de 50TB? Fisicamente, eles manterão o padrão SATA ou SAS. No entanto, a especificação de energia pode exigir revisões, como o recurso Power Disable (PWDIS) já presente em discos enterprise modernos. Controladoras antigas podem não reconhecer a capacidade total sem atualização de firmware.

3. O SSD vai matar o HDD de 50TB? Em performance, o SSD já venceu. Em custo por terabyte, o HDD ainda tem uma vantagem de 5x a 7x. Para armazenar 50TB em SSDs hoje, o custo é proibitivo para a maioria das aplicações de arquivamento. A "morte" do HDD é uma previsão falha; ele está apenas se especializando em armazenamento de massa.

4. Por que não usar apenas a nuvem? A nuvem é apenas o computador (e os discos) de outra pessoa. Com o aumento do volume de dados (vídeos 8K, datasets de IA), o custo de tráfego (egress fees) e o aluguel mensal de 50TB na nuvem superam o custo de aquisição de hardware próprio em cerca de 10 a 14 meses. Para grandes volumes, o armazenamento local (On-Prem) ou híbrido continua sendo economicamente superior.

Julian Vance

Futurista de Tecnologia

"Exploro as fronteiras da infraestrutura, do armazenamento em DNA à computação quântica. Ajudo líderes a decodificar o horizonte tecnológico e construir o datacenter de 2035 hoje."