Adeus GNU Coreutils: O kit de sobrevivência Rust para Storage em 2026

Substitua ferramentas legacy por binários Rust modernos. Guia prático de duf, dust, zenith e ripgrep para engenheiros de storage e sysadmins focados em performance.

Você abre o terminal em um servidor de armazenamento crítico. O array está lento, o espaço está sumindo misteriosamente e o iostat cospe números que parecem criptografia alienígena. As ferramentas que usamos há 40 anos — ls, cp, du, df — foram escritas quando um disco rígido de 10 MB era o auge da tecnologia. Em 2026, com arrays All-Flash NVMe e pools ZFS de múltiplos petabytes, essas ferramentas antigas mostram sua idade. Elas são single-threaded, difíceis de ler e, francamente, perigosas quando a fadiga do operador entra em jogo.

A revolução do Rust na infraestrutura não é apenas sobre "hype". É sobre segurança de memória, paralelismo implícito e uma experiência de usuário (UX) que respeita o tempo do administrador de sistemas. Reescrever o coreutils em Rust gerou um ecossistema de ferramentas modernas que entendem o contexto de storage de alta densidade.

Resumo em 30 segundos

- Velocidade de I/O: Ferramentas Rust utilizam chamadas de sistema modernas e paralelismo (threads) para varrer metadados de discos NVMe e SSDs muito mais rápido que as versões GNU single-threaded.

- Legibilidade Crítica: O output visual (cores, gráficos de barras, tabelas alinhadas) reduz drasticamente o tempo cognitivo necessário para diagnosticar um disco cheio ou um gargalo de latência.

- Independência: Binários estáticos evitam o "inferno de dependências" da glibc, permitindo rodar ferramentas novas em sistemas de storage legados ou appliances fechados (como versões antigas do TrueNAS ou Unraid).

Por que binários Rust processam metadados de NVMe mais rápido

Quando você executa um du -sh em um diretório com 10 milhões de arquivos pequenos, o gargalo raramente é o disco, especialmente se for um array NVMe Gen5. O gargalo é a CPU e a forma como o software percorre a árvore de diretórios. As ferramentas GNU clássicas foram desenhadas em uma era onde a CPU era muito mais rápida que o disco, então elas processam arquivos sequencialmente (um por um).

O Rust muda essa equação com o conceito de "Fearless Concurrency" (Concorrência sem Medo). Ferramentas modernas disparam múltiplas threads para ler diretórios em paralelo. Em um pool ZFS com cache ARC aquecido, a diferença entre listar arquivos sequencialmente e paralelamente é brutal.

Além disso, o gerenciamento de memória do Rust, que dispensa o Garbage Collector (ao contrário de Go ou Java) e garante segurança em tempo de compilação (ao contrário de C/C++), resulta em binários extremamente enxutos que não sofrem pausas aleatórias durante operações intensivas de I/O. Para quem gerencia storage, isso significa que o comando termina antes de você perder a paciência.

Compilando o ecossistema moderno com cargo e crates

Antes de mergulharmos nas ferramentas, precisamos falar sobre entrega. Em 2026, depender do apt ou yum para ferramentas de ponta é pedir para usar software obsoleto. O gerenciador de pacotes do Rust, o cargo, é a via expressa.

Para administradores de storage, a grande vantagem é a compilação estática. Você pode compilar um binário em sua máquina de trabalho e enviá-lo via scp para um servidor de produção, um NAS Synology ou um ambiente TrueNAS Scale, e ele simplesmente funcionará. Não há bibliotecas faltando.

💡 Dica Pro: Se você administra sistemas antigos (CentOS 7, Debian 10), compile suas ferramentas Rust usando a target

x86_64-unknown-linux-musl. Isso cria um binário 100% estático que não depende da versão daglibcdo sistema host. É o canivete suíço definitivo para recuperação de desastres.

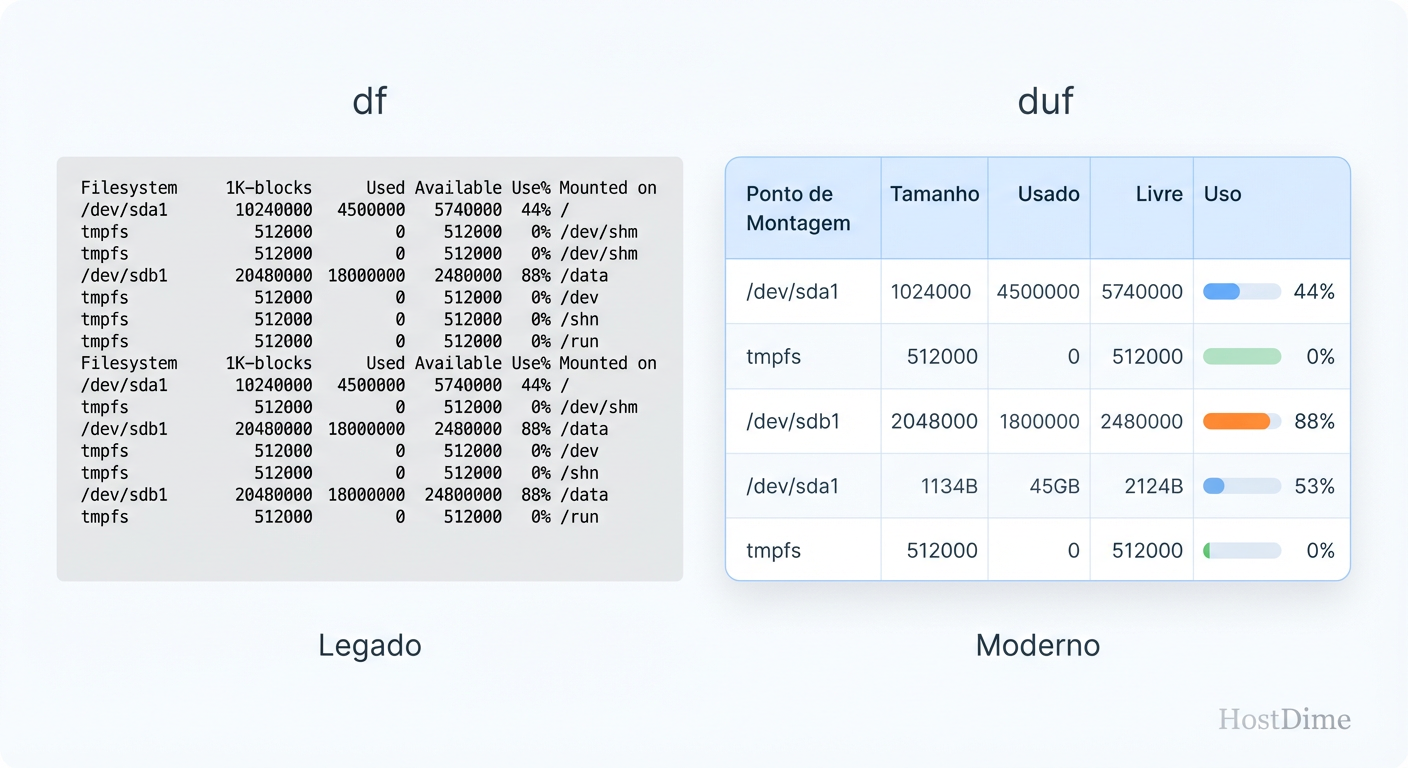

Visualizando inodes e pontos de montagem ZFS com duf

O comando df (disk free) é confuso. Em sistemas modernos com ZFS, Btrfs ou montagens de contêineres (OverlayFS), a saída do df -h torna-se uma lista ilegível de dispositivos virtuais, snaps e loops. É fácil perder o disco real no meio do ruído.

O duf (Disk Usage/Free) resolve isso com uma abordagem tabular inteligente e colorida. Ele agrupa dispositivos por tipo (locais, rede, fuse, especiais) e detecta automaticamente o sistema de arquivos subjacente.

Fig. 1: A legibilidade imediata do duf evita erros de interpretação em crises de disco cheio.

Fig. 1: A legibilidade imediata do duf evita erros de interpretação em crises de disco cheio.

Flags essenciais para storage

--inodes: O assassino silencioso de sistemas de arquivos. Muitas vezes o disco tem espaço (GB), mas a tabela de inodes está cheia (milhões de arquivos pequenos). Odufmostra o uso de inodes e espaço lado a lado.--hide-fs: Em servidores Kubernetes ou Docker, você pode ter centenas de montagensoverlay. Use--hide-fs overlaypara limpar a visão e focar nos volumes persistentes (PVs).--output: Permite customizar as colunas. Para storage, recomendo:duf --output mountpoint,size,used,avail,usage,inodes_usage,type.

A clareza visual do duf impede aquele erro clássico de apagar arquivos no ponto de montagem errado porque a saída do df quebrou a linha no terminal.

Auditando árvores de diretórios em petabytes com dust

O du (disk usage) é a ferramenta padrão para descobrir o que está comendo seu espaço. O problema: ele não lhe dá contexto. Você roda du -sh *, descobre que a pasta /var é grande, entra nela, roda de novo, e repete o processo infinitamente.

O dust é a evolução natural. Ele varre o diretório alvo e apresenta imediatamente uma árvore visual (gráfico de barras) dos maiores ofensores. Ele "sabe" que você não se importa com os arquivos pequenos no momento de uma crise de disco cheio.

Otimização para grandes volumes

Ao contrário do ncdu (que é excelente, mas interativo e requer um scan prévio lento), o dust é desenhado para velocidade de execução em scripts ou verificações rápidas.

Paralelismo: O

dustusa todas as cores da sua CPU para caminhar pela árvore de diretórios. Em um array RAID 10 de HDDs mecânicos, isso ajuda a saturar a fila de comandos e, surpreendentemente, pode ser mais rápido que odusequencial se o cache do sistema operacional ajudar. Em NVMe, a diferença é instantânea.Profundidade Inteligente: Com a flag

-d(depth), você limita a visualização.dust -d 2: Mostra apenas dois níveis de profundidade, ideal para uma visão geral de um dataset ZFS complexo.

Reverse View: A flag

-rinverte a árvore, colocando a raiz no topo ou na base, dependendo de como seu cérebro prefere visualizar a hierarquia.

⚠️ Perigo: Ao usar qualquer ferramenta de varredura de disco (seja

duoudust) em um ambiente com Snapshots ZFS montados ou diretórios.zfsvisíveis, certifique-se de ignorá-los. Odustpossui flags para ignorar diretórios ocultos, evitando loops infinitos ou contagem duplicada de espaço de snapshots.

Rastreando latência de disco em tempo real com zenith

Se o top e o iotop tivessem um filho moderno, seria o zenith. A maioria das ferramentas de monitoramento CLI mostra o uso de disco como um número global (ex: "o disco sda está 80% ocupado"). Isso é inútil para diagnóstico fino. Você precisa saber quem está gerando a carga e, mais importante, qual é a latência dessa carga.

O zenith brilha ao correlacionar métricas. Ele apresenta gráficos de zoomable timeline (linha do tempo com zoom) para CPU, Disco e Rede simultaneamente.

Fig. 2: O zenith correlaciona I/O de disco com uso de CPU na mesma timeline, vital para identificar gargalos.

Fig. 2: O zenith correlaciona I/O de disco com uso de CPU na mesma timeline, vital para identificar gargalos.

Diagnóstico de latência de cauda

Em storage, a latência média mente. O que mata a performance de um banco de dados não é a média de 2ms, mas os picos de 500ms (latência de cauda).

Visualização de I/O: O

zenithsepara leitura e escrita nos gráficos. Você consegue ver visualmente se um processo de backup (rsyncouzfs send) está saturando a banda de escrita e causando iowait na CPU.Navegação no Tempo: Diferente do

top, que atualiza e "esquece" o passado, ozenithmantém um histórico recente na tela. Se houve um pico de latência há 30 segundos, você pode olhar para o gráfico e ver exatamente qual processo estava no topo da lista naquele momento.

Para administradores de Ceph ou vSAN, onde a correlação entre tráfego de rede e gravação em disco é direta, o zenith é a ferramenta de primeira resposta antes de abrir um Grafana pesado.

Minerando logs de erro em arrays massivos com ripgrep

Logs de storage são verbosos. Logs de smartd, kern.log (para erros SCSI/ATA) e logs de aplicações de backup podem gerar gigabytes de texto por dia. Usar grep para buscar um erro específico em um arquivo de 50GB compactado (.gz) é um teste de paciência.

O ripgrep (rg) é, indiscutivelmente, a ferramenta de busca de texto mais rápida disponível hoje. Ele usa aceleração SIMD (instruções de CPU que processam múltiplos dados simultaneamente) para mastigar texto em velocidades absurdas.

Casos de uso em Storage

Busca em Logs Rotacionados: O

ripgreppode buscar diretamente em arquivos compactados sem precisar descompactá-los manualmente.- Comando:

rg -z "SCSI error" /var/log/syslog* - Isso busca a string "SCSI error" em todos os logs, inclusive os

.gzantigos, instantaneamente.

- Comando:

Filtragem de Tipos: Ele respeita arquivos

.gitignore, o que é ótimo para desenvolvedores, mas para sysadmins, a flag--typeé poderosa. Você pode definir tipos de arquivos customizados ou usar os pré-definidos para buscar apenas em arquivos de configuração ou logs, ignorando binários e lixo.Contexto: Assim como o grep, mas mais rápido.

rg -C 5 "checksum error" /var/log/zfs/zed.log- Mostra 5 linhas antes e depois de cada erro de checksum, vital para entender o que aconteceu antes do disco falhar.

Quando a glibc quebra a compatibilidade dos binários

Um dos maiores pesadelos na manutenção de storage de longo prazo (Long Term Support) é a atualização de ferramentas. Você tem um servidor rodando uma versão estável do Debian ou RHEL para garantir a integridade dos dados. Você quer instalar uma ferramenta nova para diagnóstico, mas ela exige uma versão da glibc (biblioteca C padrão) mais nova do que a que você tem.

Tentar atualizar a glibc em um servidor de produção é roleta russa. Pode quebrar o sistema inteiro.

Aqui o ecossistema Rust brilha novamente. Como mencionado na seção de compilação, a cultura de Go e Rust favorece binários estáticos ou com pouquíssimas dependências dinâmicas. Você pode baixar um binário do ripgrep ou fd compilado hoje e ele rodará no seu servidor de 5 anos atrás sem reclamar de bibliotecas faltantes. Isso desacopla a "idade" do sistema operacional da "modernidade" das suas ferramentas de diagnóstico.

Isso permite que você mantenha o sistema base (kernel, drivers ZFS, serviços de boot) extremamente conservador e estável, enquanto usa ferramentas de ponta na camada de usuário (userland) para gerenciar esses dados. É o melhor dos dois mundos.

Recomendação Operacional

Não desinstale o GNU Coreutils. Eles são a base do sistema POSIX e muitos scripts legados dependem de seus comportamentos exatos (e idiossincrasias). No entanto, para interação humana diária e diagnóstico de crises, a transição para o kit Rust é mandatória em 2026.

Comece criando alias no seu shell interativo. Mapeie df para duf, grep para rg e du para dust. A memória muscular dos seus dedos agradecerá, e quando o próximo disco falhar às 3 da manhã, a clareza visual dessas ferramentas pode ser a diferença entre um recovery rápido e um erro catastrófico.

Perguntas Frequentes

1. Essas ferramentas são seguras para ambientes de produção Enterprise?

Sim. Ferramentas como ripgrep e fd já são padrão em muitas distribuições Linux modernas e são usadas massivamente por empresas como Microsoft (no VS Code) e Amazon. Elas apenas leem metadados e arquivos; elas não alteram dados no disco (a menos que você explicitamente use comandos de deleção, o que não é o foco deste artigo).

2. O uso de memória RAM é maior que as ferramentas GNU? Marginalmente, sim. Para ganhar velocidade e criar visualizações ricas, essas ferramentas carregam mais estruturas em memória. No entanto, em um servidor de storage com gigabytes ou terabytes de RAM (comum para ZFS ARC), o consumo de 10-20MB a mais por uma ferramenta de diagnóstico é irrelevante comparado ao ganho de produtividade.

3. O zenith funciona em BSD/TrueNAS Core?

O suporte a BSD no ecossistema Rust é bom, mas varia por ferramenta. O zenith depende de métricas de kernel específicas. Para FreeBSD (base do TrueNAS Core), verifique a compatibilidade da versão específica ou prefira o gstat nativo se o zenith não estiver disponível nos ports. No TrueNAS Scale (Linux), funciona perfeitamente.

4. Como instalo tudo isso de uma vez?

Se você tem o cargo instalado:

cargo install duf dust ripgrep zenith

Alternativamente, a maioria dos gerenciadores de pacotes modernos (brew, scoop, choco, apt em distros rolling release) já possui esses pacotes nos repositórios oficiais.

Mariana Costa

Repórter de Tecnologia (Newsroom)

"Cubro o universo de TI corporativa com agilidade jornalística. Minha missão é traduzir o 'tech-speak' de datacenters e cloud em notícias diretas para sua tomada de decisão."