Agentes de IA: O fim do armazenamento passivo e a nova era da inferência contínua

Análise estratégica sobre como a ascensão dos Agentes de IA (Agentic AI) está forçando uma rearquitetura completa do storage corporativo, matando o HDD no tier primário e impulsionando o CXL.

Agentes de IA: O fim do armazenamento passivo e a nova era da inferência contínua

O mercado de infraestrutura de dados atravessa sua transformação mais agressiva desde a introdução do Flash no data center. Até o final de 2024, o foco dos CIOs e arquitetos de TI estava quase exclusivamente na construção de modelos (treinamento), uma fase caracterizada por ingestão massiva de dados e throughput sequencial. No entanto, ao entrarmos no ciclo de 2025 e 2026, observamos uma inversão tectônica nas prioridades de investimento: a ascensão dos Agentes de IA.

Diferente dos chatbots passivos, os agentes autônomos não apenas respondem; eles raciocinam, buscam informações em tempo real e executam ações. Essa mudança de comportamento do software altera fundamentalmente o perfil de I/O (Entrada/Saída) exigido do armazenamento. O storage, antes visto como um "cofre digital" passivo, agora precisa atuar como um sistema nervoso ativo, capaz de alimentar pipelines de inferência com latência de microssegundos.

Resumo em 30 segundos

- Mudança de Fluxo: O mercado está migrando do foco em throughput (treinamento) para baixa latência e IOPS randômico (inferência de agentes).

- O Fim do HDD no Tier 0: Discos mecânicos não conseguem lidar com a "tempestade de I/O" gerada por bancos de dados vetoriais e RAG, acelerando a adoção de All-Flash QLC.

- Gargalo da Latência: Em agentes que realizam múltiplos passos de raciocínio, a latência de armazenamento se acumula, tornando o tempo de resposta inaceitável sem hardware otimizado.

A transição do treinamento massivo para a inferência agêntica

Durante a fase de "corrida do ouro" da IA Generativa, a métrica rainha era o Gigabyte por Segundo (GB/s). O objetivo era alimentar GPUs H100 ou B200 com grandes volumes de texto e imagem o mais rápido possível para treinar modelos fundacionais. Nesse cenário, sistemas de arquivos paralelos como Lustre ou GPUDirect Storage brilharam.

Agora, a realidade operacional é a inferência. Quando um agente de IA precisa responder a uma solicitação complexa, ele não lê um arquivo gigante sequencialmente. Ele realiza milhares de pequenas leituras aleatórias em bancos de dados vetoriais (como Pinecone, Milvus ou Weaviate) para encontrar contexto relevante.

Isso cria um padrão de tráfego que chamamos de "Liquidificador de I/O". Controladores de armazenamento legados, otimizados para ler grandes blocos de dados, engasgam quando bombardeados por milhões de solicitações de 4KB ou 8KB vindas de múltiplos agentes simultâneos.

Figura: Comparativo visual entre o fluxo de dados sequencial do Treinamento de IA versus o padrão caótico e randômico da Inferência de Agentes.

Figura: Comparativo visual entre o fluxo de dados sequencial do Treinamento de IA versus o padrão caótico e randômico da Inferência de Agentes.

O impacto dos bancos de dados vetoriais e RAG

A arquitetura dominante para agentes corporativos é o RAG (Retrieval-Augmented Generation). Nela, o modelo de IA consulta uma base de conhecimento interna antes de responder. Para o subsistema de armazenamento, isso é um pesadelo de performance se não houver planejamento.

Cada consulta vetorial exige que o sistema de storage localize "vizinhos próximos" em um espaço multidimensional. Em termos de hardware, isso se traduz em acessos não contíguos ao disco. Se sua infraestrutura depende de HDDs (Discos Rígidos) ou mesmo de SSDs SATA antigos para essa camada, o tempo de busca (seek time) destruirá a experiência do usuário.

💡 Dica Pro: Ao dimensionar storage para RAG, ignore a métrica de "MB/s máximos" da folha de especificações. Foque obsessivamente em IOPS de Leitura Randômica 4K QD1 (Queue Depth 1). É aqui que a batalha da latência dos agentes é vencida ou perdida.

A guerra do All-Flash: O declínio definitivo do HDD no tier primário

Analistas de mercado têm observado um movimento agressivo de players como Pure Storage e VAST Data para erradicar o disco mecânico do data center moderno. A tese é econômica e técnica: com o avanço dos SSDs QLC (Quad-Level Cell) de alta densidade (módulos de 30TB, 60TB e até 75TB), o custo por TB do flash está se aproximando perigosamente do custo de HDDs SAS de alta performance (10k/15k RPM), que já estão virtualmente extintos.

Para cargas de trabalho de IA, o HDD tornou-se um passivo técnico. A latência de um HDD é medida em milissegundos (ms). A de um SSD NVMe, em microssegundos (µs). Em um pipeline onde um agente precisa fazer 50 consultas ao banco vetorial para formular uma resposta, a diferença entre 5ms e 100µs por consulta é a diferença entre uma resposta instantânea e uma espera de vários segundos.

Abaixo, comparamos as tecnologias para o cenário de Agentes de IA:

| Característica | HDD (Nearline/Enterprise) | SSD SATA/SAS (Legado) | NVMe QLC (Moderno) | NVMe TLC/Optane (Alta Performance) |

|---|---|---|---|---|

| Custo por TB | Baixo (Ideal para Cold Archive) | Médio | Médio-Alto (Caindo rápido) | Alto |

| Latência Média | 3-10 ms | 0.5-1 ms | 50-100 µs | < 20 µs |

| IOPS Randômico | ~100-200 | ~5.000-20.000 | ~100.000+ | ~500.000+ |

| Adequação p/ Agentes | Inviável | Limitada | Ideal (Sweet Spot) | Nicho (Cache/Metadata) |

| Densidade | Até ~24-30TB | Até ~15TB | Até ~75TB+ | Até ~30TB |

O custo oculto da latência de cauda

Em ambientes de missão crítica, a média não importa; o que importa é a exceção. A "latência de cauda" (ou tail latency, geralmente medida como p99 ou p99.9) refere-se às solicitações mais lentas do sistema.

Imagine um agente de IA em um banco analisando fraudes. Ele precisa cruzar dados de 50 transações em 200ms. Se 49 consultas ao storage levam 100µs, mas uma consulta leva 50ms (devido a um controlador sobrecarregado ou garbage collection do SSD), todo o processo é penalizado por essa única falha.

Controladores de armazenamento modernos estão implementando algoritmos de QoS (Quality of Service) baseados em IA para prever e mitigar esses picos, garantindo que a performance seja consistente mesmo sob carga pesada.

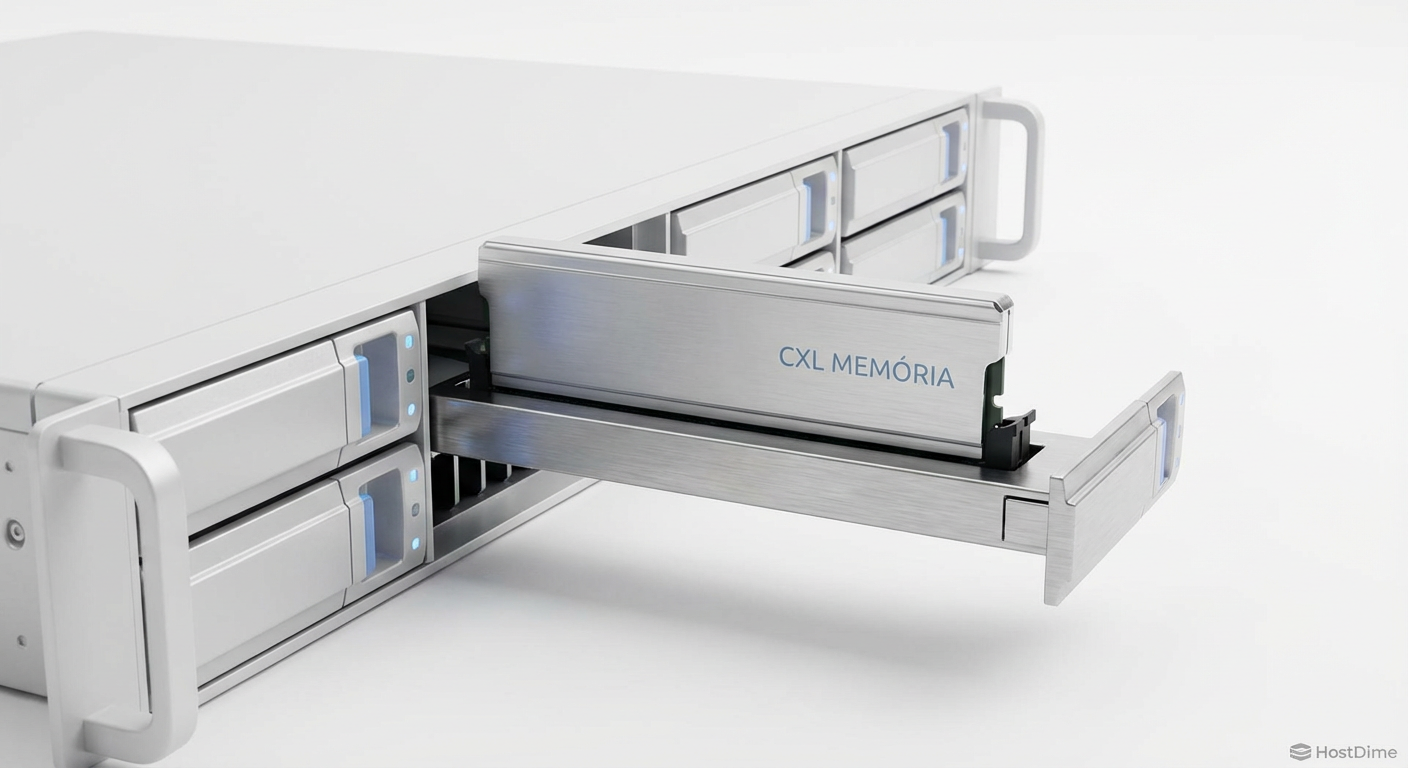

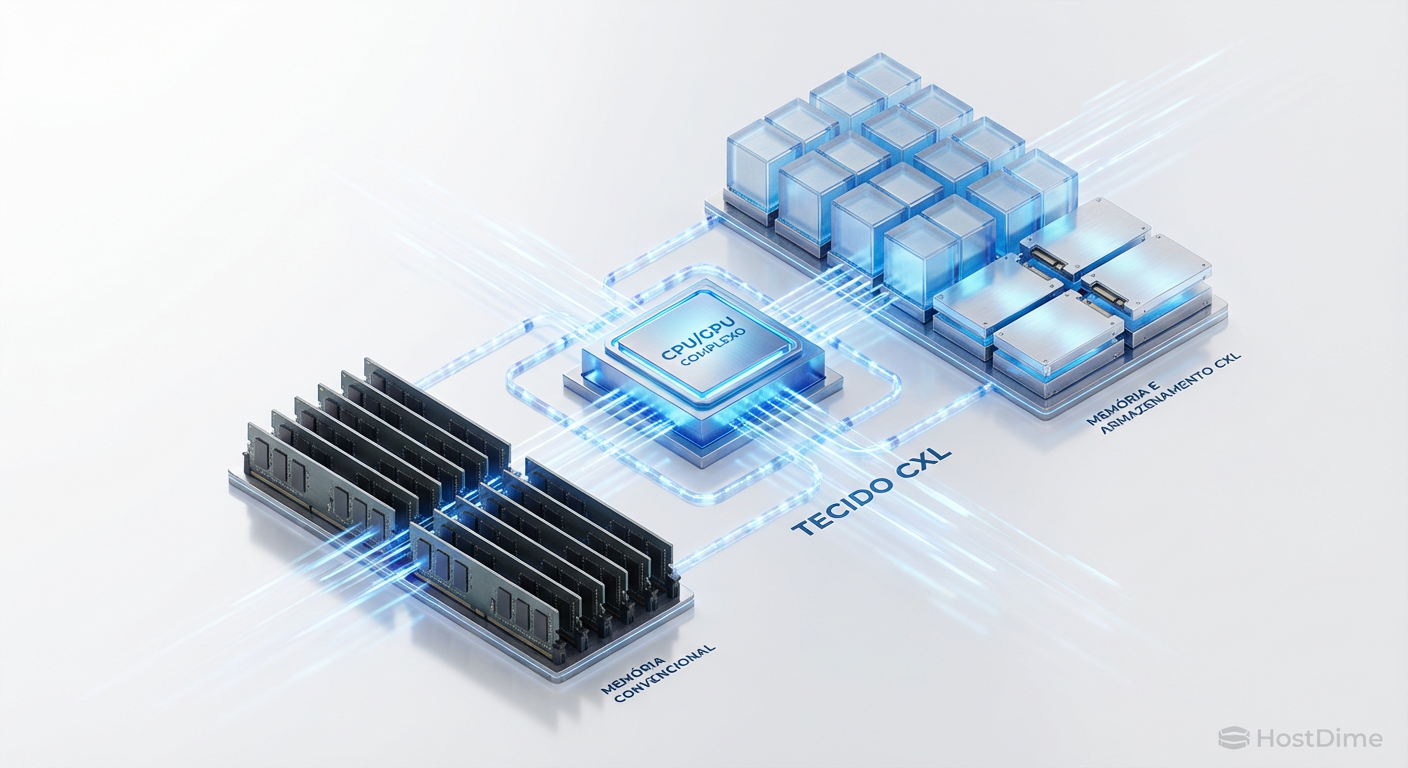

A convergência via CXL: O futuro próximo

Olhando para o horizonte de 2026, a tecnologia que promete redefinir a arquitetura de storage para IA é o CXL (Compute Express Link). Historicamente, existia um muro entre a Memória RAM (rápida, volátil, cara) e o Armazenamento SSD (persistente, mais lento).

O CXL derruba esse muro. Ele permite conectar memória via barramento PCIe, criando "pools" de memória que podem ser compartilhados entre processadores e aceleradores. Para bancos de dados vetoriais massivos que não cabem na RAM do servidor, o CXL permitirá o uso de dispositivos de memória persistente ou SSDs compatíveis com CXL que operam com latências próximas às da DRAM.

Isso significa que, em breve, não falaremos apenas de "ler do disco", mas de acessar um espaço de endereçamento de memória expandido, onde os dados do agente residem em um estado híbrido, prontos para inferência imediata.

Figura: Diagrama arquitetural ilustrando a tecnologia CXL, onde CPU e GPU acessam um pool compartilhado de memória e armazenamento, eliminando gargalos tradicionais.

Figura: Diagrama arquitetural ilustrando a tecnologia CXL, onde CPU e GPU acessam um pool compartilhado de memória e armazenamento, eliminando gargalos tradicionais.

Perspectiva Estratégica

Para líderes de infraestrutura, a mensagem é clara: a arquitetura de armazenamento desenhada para Data Lakes e Big Data da década passada não suportará a era dos Agentes de IA. A latência tornou-se o novo gargalo de performance, substituindo a largura de banda.

A recomendação estratégica é interromper novos investimentos em arrays baseados em HDD para qualquer carga de trabalho que não seja arquivamento frio (Cold Storage). O foco deve ser redirecionado para plataformas All-Flash NVMe com arquiteturas de software modernas (desacopladas), preparadas para lidar com o paralelismo massivo e a aleatoriedade dos vetores. Quem insistir em tratar dados de IA como arquivos estáticos enfrentará custos operacionais crescentes e uma infraestrutura incapaz de entregar a inteligência em tempo real que o negócio exigirá.

Perguntas Frequentes (FAQ)

Qual a diferença fundamental entre storage para Treinamento de IA e para Agentes de IA?

O treinamento de modelos exige throughput massivo e sequencial, ou seja, a capacidade de ler grandes volumes de dados (datasets) o mais rápido possível para alimentar as GPUs. Já os Agentes de IA operam na fase de inferência, exigindo baixíssima latência e alto IOPS randômico para realizar milhares de pequenas consultas simultâneas a bancos de dados vetoriais em tempo real.O HDD ainda tem lugar em projetos de IA Generativa?

Apenas para o arquivamento de longo prazo (Cold Archive) ou datasets que raramente são acessados. Para a camada operacional (Inferência, RAG e Bancos Vetoriais), o HDD é tecnicamente incapaz de atender aos requisitos de latência e acesso aleatório exigidos pelos agentes, sendo substituído por SSDs NVMe, especialmente os de tecnologia QLC de alta densidade.O que é CXL e por que ele é crucial para o futuro do storage?

O Compute Express Link (CXL) é um padrão industrial que permite conectar memória e armazenamento via barramento PCIe com coerência de cache. Ele é vital porque permite criar "pools de memória" compartilhados, reduzindo drasticamente a necessidade de mover dados entre o disco e a RAM. Isso aproxima o armazenamento da velocidade da memória, algo essencial para a performance instantânea dos agentes de IA.Como a técnica de RAG impacta a infraestrutura de armazenamento?

O RAG (Geração Aumentada por Recuperação) transforma o storage de um repositório passivo em um motor de busca ativo. Ele obriga o sistema de armazenamento a realizar buscas semânticas complexas em tempo real para fornecer contexto à IA. Isso exige controladores de storage muito mais potentes e discos rápidos para evitar que a busca pelos dados demore mais do que a geração da resposta pela IA.

Arthur Siqueira

Analista de Mercado de Storage

"Analiso o cenário macroeconômico do armazenamento corporativo. Meu foco está nos movimentos de consolidação, flutuações de market share e na saúde financeira que dita o futuro dos grandes players."