Análise Forense de SSDs NVMe: O Que o SMART Não Te Conta

Vá além do smartctl. Aprenda a extrair logs de telemetria (0x07), decodificar pânicos de controlador e diagnosticar falhas silenciosas no barramento PCIe com precisão cirúrgica.

Você olha para o painel do Grafana. A latência de I/O disparou para 5 segundos. O load average do servidor está subindo verticalmente. Você tenta um ls no diretório de montagem e o terminal congela. O comando não pode ser interrompido, nem mesmo com kill -9. Bem-vindo ao inferno do estado D (Uninterruptible Sleep).

A reação padrão do administrador de sistemas é reiniciar a máquina, rodar um teste curto do SMART, ver o resultado "PASSED" e assumir que foi um "glitch cósmico".

Isso é negligência.

Discos não têm "glitches". Eles têm bugs de firmware, falhas de integridade de sinal no barramento PCIe e estoiros de buffer internos que o SMART foi projetado para ignorar. Se você gerencia storage, seja um array All-Flash em um datacenter ou um pool ZFS no seu TrueNAS doméstico, você precisa parar de tratar o SSD como uma caixa preta e começar a tratá-lo como um computador complexo que roda seu próprio sistema operacional (firmware) e que falha de maneiras espetaculares.

Resumo em 30 segundos

- SMART é insuficiente: Ele monitora desgaste (wear leveling) e erros preditivos, mas raramente captura a causa raiz de travamentos súbitos ou pânicos de firmware.

- Logs de Telemetria são a chave: O padrão NVMe define páginas de log específicas (0x07 e 0x08) que funcionam como a "caixa preta" de um avião, gravando o estado da memória do SSD no momento da falha.

- A correlação é obrigatória: Um erro no

dmesgdo Linux é apenas o sintoma. A causa real está nos timestamps internos do drive, que devem ser cruzados com os logs do kernel para entender a sequência de eventos.

O deadlock do subsistema de armazenamento e o estado D-state

Quando um processo entra em estado D (Disk Sleep), ele está esperando uma resposta de hardware que nunca chega. No contexto de SSDs NVMe, isso geralmente significa que o driver do kernel enviou um comando para a fila de submissão (Submission Queue) e tocou a campainha (Doorbell Register), mas o controlador do SSD nunca escreveu a resposta na fila de conclusão (Completion Queue).

Por que isso acontece? O silício parou de responder.

O SSD NVMe moderno é um sistema embarcado multicore (geralmente ARM ou RISC-V) com sua própria DRAM e complexos algoritmos de Garbage Collection e Wear Leveling rodando em tempo real. Se o firmware encontra uma exceção não tratada — uma bit flip na DRAM do controlador ou uma condição de corrida no acesso à NAND — ele entra em "Panic Mode".

Nesse momento, o SSD para de processar I/O. O kernel do Linux, alheio ao pânico interno do drive, continua esperando a interrupção de conclusão. O timeout padrão do driver NVMe é de 30 a 60 segundos. Durante esse tempo, qualquer coisa que toque no disco congela.

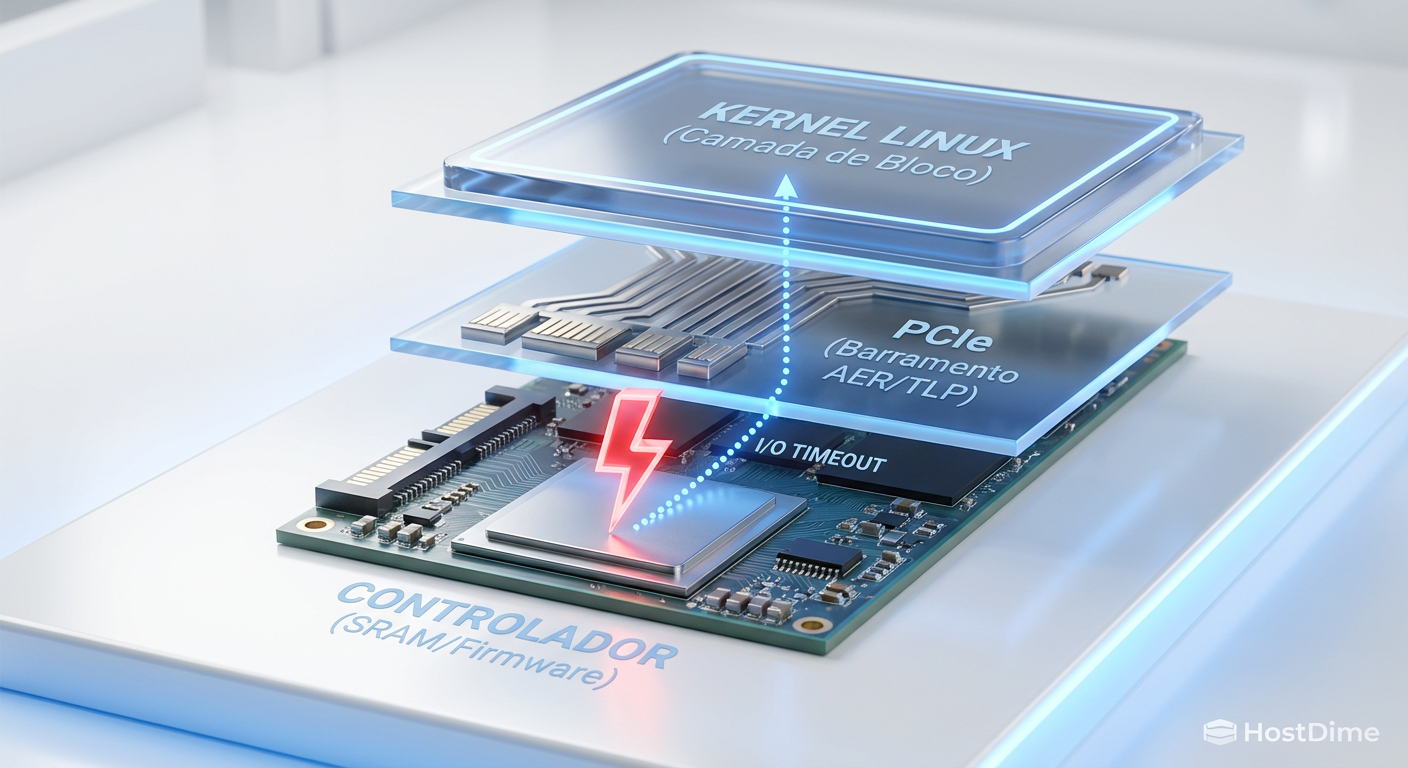

Fig. 1: A propagação da falha: do pânico no silício ao congelamento do Kernel.

Fig. 1: A propagação da falha: do pânico no silício ao congelamento do Kernel.

💡 Dica Pro: Se você vir mensagens como

nvme nvme0: controller is down; will reset: CSTS=0xffffffffnodmesg, isso não é apenas um erro. O valor0xFFFFFFFFem uma leitura de registrador PCIe geralmente significa que o link físico caiu completamente. O dispositivo "desapareceu" do barramento.

Por que confiar apenas nos atributos SMART é uma armadilha mortal

O SMART (Self-Monitoring, Analysis, and Reporting Technology) é uma relíquia da era dos HDDs mecânicos que foi adaptada, de forma desajeitada, para o mundo flash.

Quando você roda smartctl -a /dev/nvme0, você está vendo contadores acumulativos:

Critical Warning: Um bitmask genérico.

Temperature: Termodinâmica básica.

Available Spare: Saúde da NAND.

Percentage Used: Estimativa de vida útil.

Nenhum desses atributos diz: "O firmware travou no endereço de memória 0x4F3A porque a tabela de tradução lógica-física (L2P) estava corrompida". O SMART é um exame de sangue anual; a análise forense que precisamos é uma autópsia completa.

Eu já investiguei casos em servidores de banco de dados onde o disco reportava "Healthy" via SMART, mas causava latências de 2000ms aleatoriamente. A causa? Um bloco de memória defeituoso na DRAM do controlador do SSD (não na NAND), que causava retransmissões internas silenciosas. O SMART não monitora a RAM do controlador.

Extração cirúrgica de logs de telemetria via nvme-cli e decodificação hex

Desde a especificação NVMe 1.3, temos acesso a algo muito mais poderoso: a Telemetria (Telemetry Log Page). Existem dois tipos principais definidos pelo padrão:

Host-Initiated (Log 0x07): O host pede ao drive para gerar um dump do seu estado atual. Útil quando o drive está lento, mas responsivo.

Controller-Initiated (Log 0x08): O drive gera isso automaticamente quando detecta uma falha interna crítica. É aqui que o ouro reside. Este log persiste após um power cycle.

Para extrair esses dados em um ambiente Linux (seja Ubuntu Server, Fedora ou o shell do TrueNAS Scale), usamos o nvme-cli.

O comando de extração

Não execute isso cegamente. Entenda o que você está pedindo:

sudo nvme telemetry-log /dev/nvme0 --output-file=nvme_crash_dump.bin --da=3

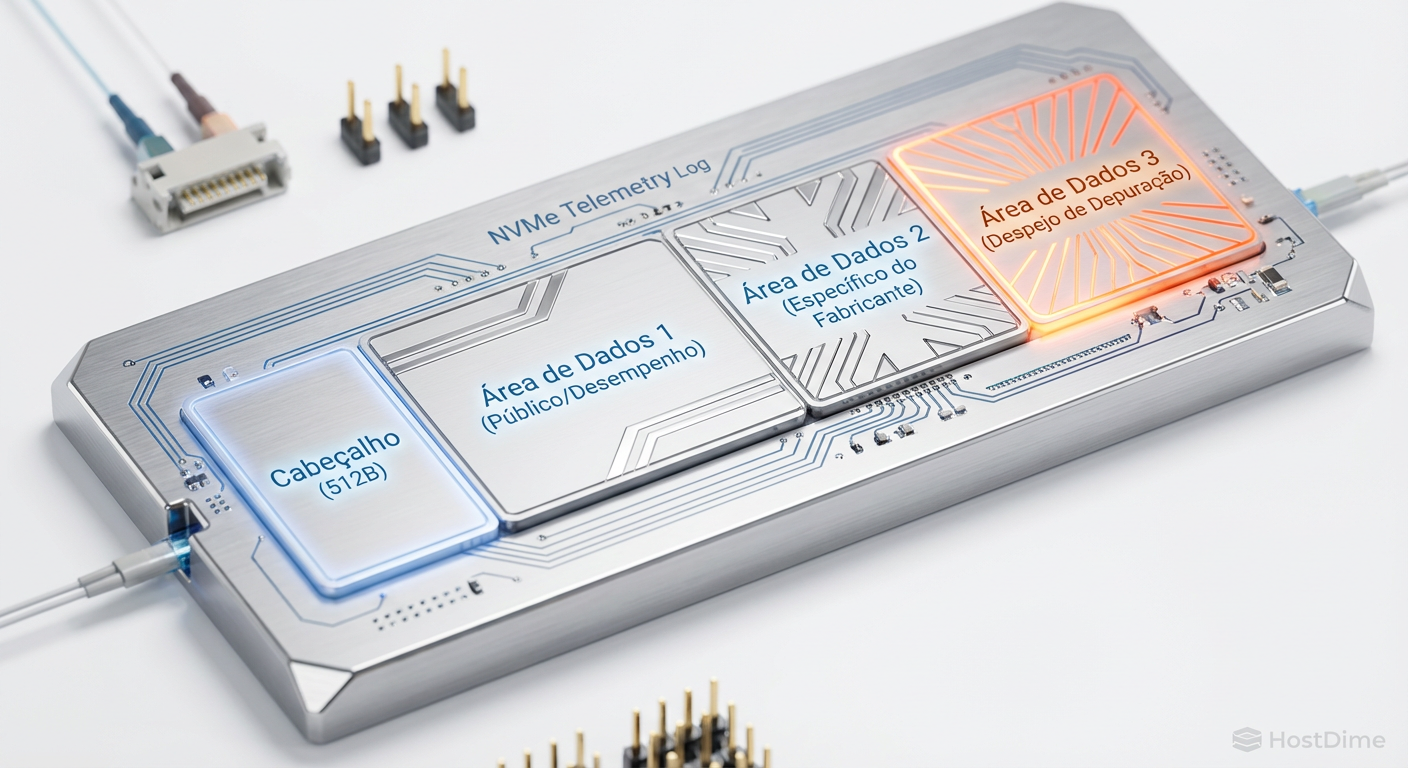

O parâmetro --da=3 (Data Area 3) é crucial. A especificação divide o log em três áreas:

Área 1: Cabeçalho e informações básicas de estado.

Área 2: Dados de telemetria estendidos.

Área 3: O dump completo de debug, muitas vezes contendo o stack trace do firmware e registradores internos.

Fig. 2: Estrutura do Log de Telemetria (0x07/0x08). A Área 3 geralmente contém os dumps de memória vitais para RCA.

Fig. 2: Estrutura do Log de Telemetria (0x07/0x08). A Área 3 geralmente contém os dumps de memória vitais para RCA.

O desafio da decodificação

Aqui está a barreira de entrada: o arquivo .bin gerado é proprietário. Embora o cabeçalho seja padronizado pela especificação NVMe (permitindo ver o tamanho e a razão do trigger), o conteúdo (o payload) é específico do fabricante (Samsung, Western Digital, Micron, Solidigm).

No entanto, mesmo sem as ferramentas de decodificação do fabricante (que raramente são públicas), podemos usar editores hexadecimais (xxd ou hexdump) para buscar strings ASCII legíveis dentro do binário.

strings nvme_crash_dump.bin | grep -i "error" -C 5

Muitas vezes, desenvolvedores de firmware deixam mensagens de debug em texto claro. Já encontrei strings como ASSERT_FAIL: l2p_table.c:402 dentro de um dump binário de um SSD Enterprise. Isso é a prova irrefutável que você envia para o suporte do fabricante para exigir um RMA ou uma atualização de firmware, em vez de aceitar a resposta "o disco está bom".

⚠️ Perigo: Logs de telemetria podem conter fragmentos de dados do usuário que estavam nos buffers de gravação no momento do crash. Trate esses arquivos binários com o mesmo nível de segurança que você trata um dump de memória do kernel.

Validação cruzada: correlacionando timestamps do firmware com o dmesg do Linux

A maior falha em análises forenses de storage é a cegueira temporal. O servidor diz que o erro ocorreu às 14:00:05. O log do SSD diz que o erro ocorreu na hora 4500 de operação. Como você prova que são o mesmo evento?

O kernel do Linux reage ao hardware. O hardware age primeiro.

A anatomia de um pânico no firmware e a queda do link PCIe

Quando o firmware entra em pânico, a sequência é:

T-0ms: Firmware detecta erro fatal. Grava Log 0x08 na NAND reservada.

T+10ms: Firmware para de processar a fila de submissão.

T+50ms: Controlador NVMe para de enviar pacotes de "Keep Alive" ou completações PCIe.

T+30000ms (Timeout do OS): O driver NVMe do Linux percebe que o comando expirou.

T+30001ms: O kernel tenta resetar o controlador.

T+30005ms: O kernel declara o dispositivo morto e coloca o filesystem em Read-Only (RO).

Se você olhar apenas o dmesg ou /var/log/syslog, você verá o erro 30 segundos depois do fato real.

Para correlacionar, você precisa extrair o "Power On Hours" (POH) exato do momento do crash dentro do log de telemetria e cruzar com o POH atual do drive.

Exemplo de cálculo forense:

POH Atual (via SMART): 5000 horas.

Timestamp do último erro crítico (via Log 0x08): 4999 horas e 58 minutos.

Conclusão: O erro no log interno aconteceu há 2 minutos. Isso bate com o momento que o ZFS reportou checksum errors? Se sim, o disco é o culpado. Se o erro no log interno é de 500 horas atrás, então o travamento atual do sistema não foi causado por um pânico de firmware registrado, e você deve investigar o cabeamento, a backplane ou a fonte de alimentação.

Fig. 3: Correlação temporal. Note o atraso entre o evento interno do firmware e a reação do driver NVMe no OS.

Fig. 3: Correlação temporal. Note o atraso entre o evento interno do firmware e a reação do driver NVMe no OS.

O papel do AER (Advanced Error Reporting)

Antes do disco morrer completamente, ele geralmente grita. O protocolo PCIe possui um mecanismo chamado AER. Muitos "mistérios" de performance são resolvidos simplesmente olhando se o link PCIe está degradado.

Use o lspci para interrogar a integridade do sinal:

sudo lspci -vvv -s 04:00.0 | grep -E "UESta|CESta"

CESta (Correctable Error Status): Erros que o hardware corrigiu (ex: retransmissão de pacote). Um número alto aqui indica um cabo ruim, poeira no slot M.2 ou interferência eletromagnética. Isso causa latência, não perda de dados imediata.

UESta (Uncorrectable Error Status): O pacote foi corrompido e não pôde ser recuperado. Isso geralmente resulta em um reset do link e I/O errors no sistema operacional.

Se o seu SSD NVMe está negociando a x2 ou x1 em vez de x4 (verifique com LnkSta no lspci), você tem um problema físico, não lógico. Nenhuma quantidade de formatação resolverá isso.

O veredito forense

Não aceite "não sei" como resposta para falhas de armazenamento. Em um ambiente de infraestrutura moderna, dados são o ativo mais crítico, e o dispositivo que os armazena é o componente mais complexo e opaco do servidor.

Se um SSD NVMe travar seu servidor:

Não reinicie imediatamente se possível; tente extrair o log de telemetria.

Se reiniciar for inevitável, extraia o log 0x08 assim que o sistema voltar.

Ignore o "SMART Health Status: OK".

Busque por padrões hexadecimais e strings de erro no dump.

Correlacione o tempo de atividade do firmware com os logs do kernel.

A diferença entre um "reboot misterioso" e uma "falha confirmada de firmware na gestão da tabela L2P" é o que separa um trocador de peças de um engenheiro de sistemas. Vá fundo nos logs. O silício não mente, ele apenas fala uma língua que exige esforço para traduzir.

Referências & Leitura Complementar

NVM Express Base Specification 2.0: Seções sobre Telemetry Log Page (Log Identifier 07h and 08h).

OCP Datacenter NVMe SSD Specification: Detalhes sobre requisitos de debug e latência em ambientes de hiperescala.

Man pages:

man nvme-telemetry-log,man lspci.JEDEC: Padrões de retenção de dados em NAND Flash (JESD218).

Perguntas Frequentes

1. O comando nvme telemetry-log funciona em qualquer SSD?

Funciona na maioria dos SSDs NVMe modernos (versão 1.3 ou superior) de marcas conceituadas (Samsung, Intel/Solidigm, Micron, WD, Seagate). SSDs genéricos ou "white label" de baixo custo podem implementar a especificação de forma incompleta e retornar lixo ou erros.

2. Extrair o log de telemetria afeta a performance do disco? Sim, a extração do Log 0x07 (Host-Initiated) pode pausar brevemente o processamento de I/O, pois o controlador precisa reunir dados de várias regiões de memória. Evite rodar isso em horários de pico de produção, a menos que o disco já esteja travado.

3. Posso ler o arquivo binário gerado no Bloco de Notas?

Não. É um arquivo binário bruto. Abrir em editores de texto comuns mostrará caracteres ilegíveis. Use um editor hexadecimal (como HxD, xxd ou hexedit) para análise.

4. Isso se aplica a SSDs SATA? Não. O protocolo SATA é completamente diferente e muito mais limitado em termos de logs de debug padronizados. Esta análise é específica para o protocolo NVMe sobre PCIe.

Bruno Albuquerque

Investigador Forense de Sistemas

"Não aceito 'falha aleatória'. Com precisão cirúrgica, mergulho em logs e timestamps para expor a causa raiz de qualquer incidente. Se deixou rastro digital, eu encontro."