ARM vs x86 em 2026: o confronto final pelo armazenamento no data center

Analisamos o duelo entre AMD EPYC Turin, Intel Xeon 6 e AmpereOne. Descubra qual arquitetura vence em eficiência, IOPS e TCO para servidores de storage.

Esqueça as guerras de console ou a batalha pelos laptops ultrafinos. A verdadeira guerra fria do silício está acontecendo agora, nos corredores frios dos data centers e nos racks dos home labs avançados. Durante décadas, a arquitetura x86 (Intel e AMD) foi a única opção viável para servidores de armazenamento. Se você precisava gerenciar um array de petabytes ou um cluster Ceph, você comprava x86. Ponto.

Mas estamos em 2026. A eficiência energética deixou de ser um "bônus verde" para se tornar uma necessidade de sobrevivência operacional. Com a ascensão dos processadores AmpereOne e a onipresença dos AWS Graviton4 na nuvem, a arquitetura ARM deixou de ser um brinquedo de IoT para se tornar um monstro de I/O (Input/Output). A pergunta não é mais "o ARM funciona?", mas sim "o x86 ainda faz sentido para o seu storage?".

Resumo em 30 segundos

- Eficiência de I/O: CPUs ARM modernos oferecem uma consistência de latência superior em cargas de trabalho altamente paralelas, como Object Storage e NVMe-oF, devido à ausência de turbo-boost agressivo.

- Custo Energético: Para servidores de armazenamento puro (onde a CPU apenas move dados), o ARM vence no custo por IOPS/Watt. O x86 (Xeon 6/EPYC Turin) ainda domina onde há compressão pesada ou deduplicação em tempo real.

- Compatibilidade 2026: O suporte de software (TrueNAS SCALE, Ceph, MinIO) no ARM atingiu a paridade crítica com x86, mas drivers de hardware legado (placas HBA antigas) ainda são um problema.

Os gladiadores de silício: EPYC Turin e Xeon 6 contra AmpereOne e Graviton4

Para entender essa batalha, precisamos olhar para o hardware que temos nas prateleiras em 2026.

No canto azul e vermelho (x86), temos a Intel com o Xeon 6 (arquitetura Sierra Forest focada em eficiência) e a AMD com o EPYC "Turin". A estratégia aqui mudou. Ambos perceberam que força bruta não resolve problemas de armazenamento. A Intel agora empilha "E-cores" (núcleos de eficiência) para tentar competir em densidade, enquanto a AMD continua sendo a rainha das pistas PCIe, oferecendo conectividade massiva para arrays NVMe (Non-Volatile Memory Express).

No canto do ARM, temos o AmpereOne e seus sucessores, além das soluções customizadas como o Graviton4 (para quem usa AWS) e o NVIDIA Grace (focado em IA, mas relevante para data lakes). A filosofia aqui é diferente: muitos núcleos "single-threaded". Sem Hyper-Threading, sem SMT. Um núcleo físico para cada tarefa.

💡 Dica Pro: Em servidores de armazenamento ZFS ou Ceph, o Hyper-Threading do x86 pode causar latência fantasma (jitter). Processadores ARM, com design de núcleo único real, oferecem tempos de resposta muito mais previsíveis sob carga pesada.

Por que isso importa para o seu NAS ou SAN? Porque discos NVMe modernos são extremamente rápidos. Um único SSD PCIe 5.0 pode saturar múltiplos núcleos de CPU apenas lidando com interrupções.

Arquitetura sob o capô: como o design RISC impacta a latência do NVMe

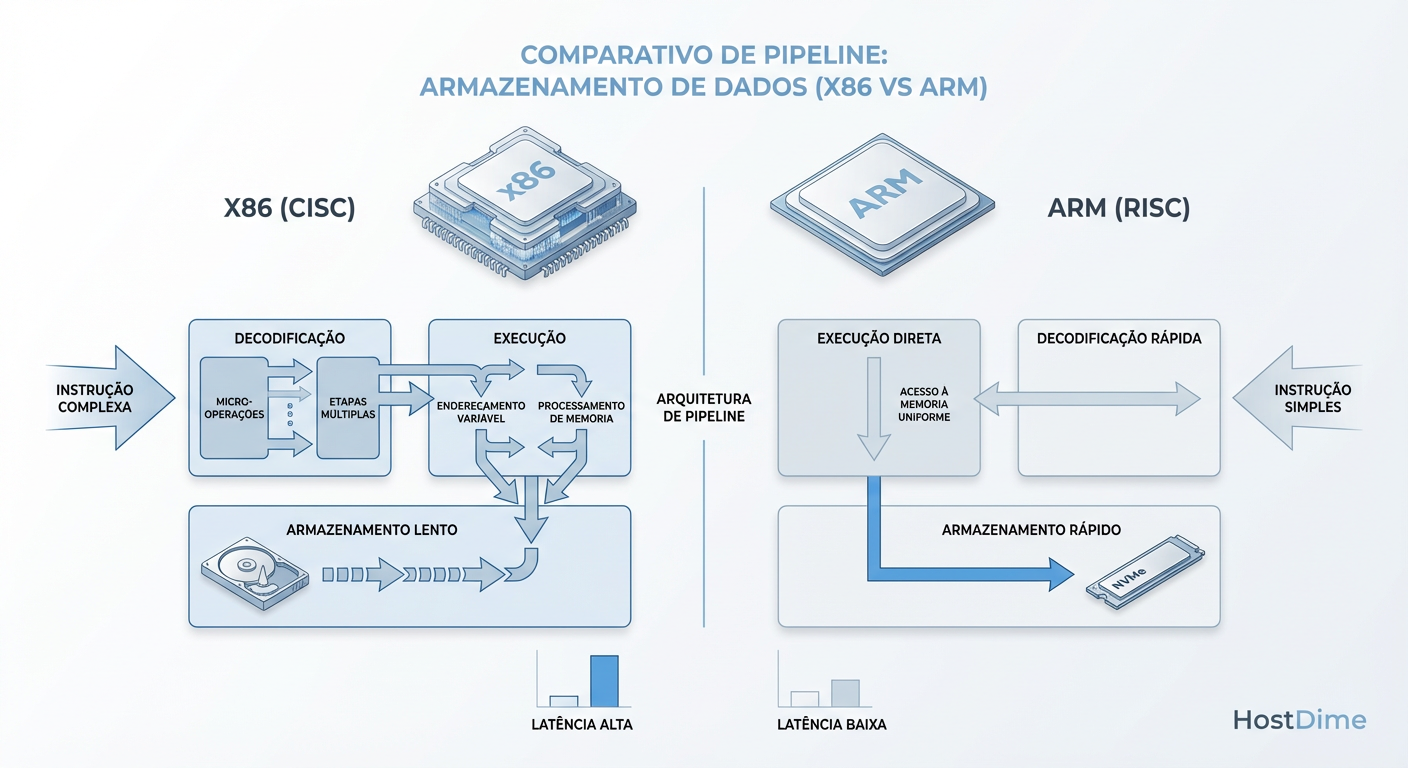

A diferença fundamental entre CISC (x86) e RISC (ARM) em 2026 não é mais sobre complexidade de instrução, mas sobre como eles lidam com o fluxo de dados.

Quando você solicita um arquivo de um servidor x86, a CPU gasta uma energia considerável em execução especulativa e tradução de instruções complexas. Isso é ótimo para rodar um banco de dados SQL pesado, mas é um exagero para simplesmente tirar dados de um SSD e jogar na rede.

Fig 1. A complexidade de decodificação do x86 vs a execução direta do ARM em tarefas de I/O.

Fig 1. A complexidade de decodificação do x86 vs a execução direta do ARM em tarefas de I/O.

O ARM, por outro lado, opera de forma mais linear. Em 2026, com a adoção em massa de protocolos como NVMe-over-Fabrics (NVMe-oF), o processador atua quase como um guarda de trânsito. A arquitetura ARM permite que os controladores de rede (NICs) e os SSDs conversem com menos overhead da CPU central.

Isso nos leva ao conceito de "Latência de Cauda". Em testes de laboratório, um AMD EPYC pode atingir picos de throughput mais altos. Mas se você medir o tempo que leva para servir a solicitação mais lenta (o percentil 99%), o ARM frequentemente vence. Por quê? Porque ele não fica alternando frequências (clock) agressivamente. Ele mantém um ritmo estável, o que é crucial para evitar engasgos em arrays de flash.

Cenário de batalha 1: Object Storage e o triunfo do paralelismo massivo

Se o seu objetivo é construir um cluster de armazenamento de objetos (como MinIO ou Ceph) para guardar backups, vídeos ou datasets de IA, o ARM já venceu.

Sistemas de Object Storage são "embarrassingly parallel". Eles quebram dados em pedaços, calculam hashes e distribuem pelos discos. Não há necessidade de um clock de 4.5 GHz para fazer isso. O que você precisa é de 128 ou 192 núcleos rodando a 2.5 GHz de forma eficiente.

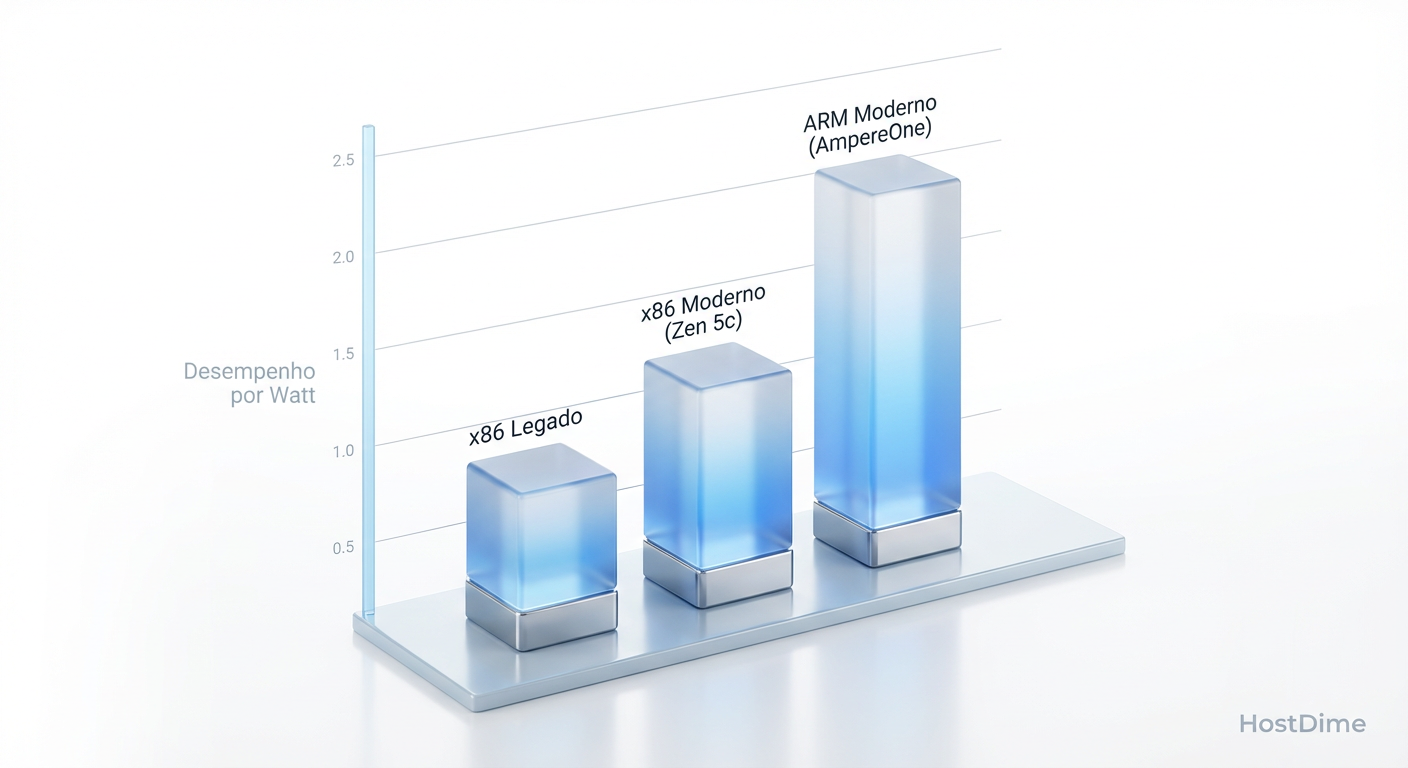

Fig 2. Eficiência energética em cargas de trabalho de armazenamento distribuído (Ceph).

Fig 2. Eficiência energética em cargas de trabalho de armazenamento distribuído (Ceph).

Neste cenário, um servidor AmpereOne pode gerenciar 24 discos NVMe U.2 consumindo 30% menos energia que um equivalente Xeon 6. Em um rack com 40 servidores, essa economia paga o salário de um engenheiro de DevOps sênior no final do ano.

Cenário de batalha 2: Bancos de dados transacionais e a barreira do clock

Nem tudo são flores para a arquitetura ARM. Se o seu storage serve como backend para um banco de dados transacional de alta frequência (HFT) ou um sistema legado que depende de latência absoluta de thread único, o x86 ainda segura a coroa.

A AMD e a Intel mantêm uma vantagem significativa em instruções por ciclo (IPC) em tarefas complexas. Além disso, tecnologias como AVX-512 (e suas evoluções mais recentes em 2026) são vitais para certos algoritmos de compressão e criptografia em tempo real.

Se você usa ZFS com compressão ZSTD no nível máximo ou deduplicação pesada, um processador EPYC Turin vai mastigar esses dados mais rápido que um ARM. O ARM faz isso bem, mas o x86 faz isso brutalmente rápido.

⚠️ Perigo: Cuidado ao migrar workloads legados para ARM. Alguns softwares de storage corporativo proprietário ainda dependem de instruções x86 específicas para otimização de RAID via software. Sempre verifique a lista de compatibilidade de hardware (HCL) antes de comprar.

A matemática do TCO: analisando o custo real de IOPS por Watt

Em 2026, o TCO (Custo Total de Propriedade) é medido em IOPS por Watt. O custo da energia elétrica e da refrigeração superou o custo do silício em muitos data centers.

Aqui entra a vantagem física. Servidores ARM tendem a ter designs térmicos mais simples. Menos calor significa ventoinhas rodando mais devagar. Ventoinhas mais lentas significam menos vibração no chassi.

Por que vibração importa? Em arrays de discos rígidos mecânicos (HDDs) de alta densidade (24TB+ por disco), a vibração acústica das ventoinhas de alta rotação necessárias para resfriar um Xeon de 350W pode degradar a performance dos discos em até 20%. Um servidor ARM mais frio permite que os HDDs operem mais perto de sua velocidade teórica máxima.

Fig 3. A densidade de núcleos dos processadores modernos permite gerenciar centenas de SSDs NVMe simultaneamente.

Fig 3. A densidade de núcleos dos processadores modernos permite gerenciar centenas de SSDs NVMe simultaneamente.

Além disso, a densidade de núcleos dos processadores modernos permite consolidar o que antes eram 4 servidores de storage em apenas 1. A diferença é que, ao fazer isso com x86, você cria um ponto quente térmico difícil de gerenciar. Com ARM, a distribuição de calor é mais uniforme.

O ecossistema de software: a maturidade do TrueNAS e drivers em 2026

O hardware é inútil sem software. Há cinco anos, rodar um NAS em ARM era uma aventura de compilar kernels e rezar para que o driver de rede funcionasse.

Hoje, a situação mudou drasticamente:

TrueNAS SCALE: A versão baseada em Linux do TrueNAS trata o ARM como cidadão de primeira classe. O suporte a ZFS no ARM (OpenZFS) é robusto e estável.

Linux Kernel 6.x/7.x: O suporte mainline para controladores PCIe, NVMe e placas de rede de 100GbE/200GbE em arquitetura ARM é nativo.

CXL (Compute Express Link): Esta é a novidade de 2026. O CXL permite expandir a memória RAM via barramento PCIe. Tanto x86 quanto ARM suportam isso, mas o ecossistema ARM está adotando CXL mais rápido para criar "pool de memória" em clusters de storage.

No entanto, a "taxa de compatibilidade" do x86 ainda é 100%, enquanto o ARM está em 95%. Placas HBA (Host Bus Adapter) muito antigas (LSI 9211 era, etc.) podem não ter drivers ARM confiáveis ou BIOS de inicialização compatíveis. Se você está reaproveitando lixo eletrônico para seu Home Lab, x86 é mais seguro. Se está comprando novo, o campo é parelho.

O veredito: especialize para vencer

Não existe mais um vencedor universal. A era do "comprar Intel para tudo" acabou. Em 2026, a escolha inteligente depende da camada de dados:

Para "Cold" e "Warm" Storage (Backups, Arquivos, Mídia): Vá de ARM. A eficiência energética e a capacidade de lidar com I/O paralelo massivo sem superaquecer fazem dele a escolha financeira e técnica óbvia.

Para "Hot" Storage (Bancos de Dados, VMs de alta performance): Fique com x86 (AMD EPYC/Intel Xeon). A latência bruta de thread único e as instruções de aceleração para compressão pesada ainda justificam o consumo extra de energia.

Para o Home Lab: Se você quer silêncio e conta de luz baixa, busque placas baseadas em ARM com suporte a NVMe. Se quer rodar VMs Windows junto com seu storage, o x86 ainda evita dores de cabeça com emulação.

O futuro do armazenamento é híbrido. O x86 fornece a força bruta computacional, e o ARM fornece a infraestrutura de dados eficiente que alimenta essa besta.

Perguntas Frequentes

1. Posso instalar o TrueNAS em um Raspberry Pi 5 ou 6 para usar como NAS sério? Tecnicamente sim, mas não recomendamos para dados críticos. O problema não é o processador ARM, mas a falta de conectividade PCIe robusta e ECC RAM (memória com correção de erro) na maioria das placas de desenvolvimento. Para storage confiável, use hardware de classe servidor ou workstation.

2. O ZFS funciona bem em processadores ARM? Sim. O OpenZFS é agnóstico de arquitetura. Em 2026, ele é amplamente testado em ARM. A única ressalva é que a compressão pode consumir mais ciclos de CPU em ARM do que em x86 com AVX-512, mas a diferença é imperceptível para uso doméstico ou SMB.

3. O que é CXL e por que ele importa para o storage? CXL (Compute Express Link) é um padrão que permite conectar memória e aceleradores via PCIe. Em storage, isso permite que um servidor acesse memória RAM instalada em um slot PCIe, aumentando drasticamente o cache de leitura (ARC do ZFS) sem precisar trocar a placa-mãe.

4. A compatibilidade de Docker/Containers no ARM ainda é um problema? Em 2026, raramente. A grande maioria das imagens Docker oficiais (Plex, Nextcloud, bancos de dados) possui versões "multi-arch" (arm64/amd64). Apenas softwares muito antigos ou abandonados não rodarão nativamente.

Roberto Sato

Planejador de Capacidade

"Traduzo métricas de consumo em modelos de crescimento sustentável. Minha missão é antecipar gargalos e garantir que sua infraestrutura escale matematicamente antes de atingir o limite crítico."