Batalha por Densidade: A Viabilidade dos HDDs de 50TB vs o Avanço do Flash QLC

Análise estratégica sobre o futuro do armazenamento: enquanto a Seagate e WD buscam o disco de 50TB, o Flash QLC de 61TB já reescreve as regras de TCO no datacenter.

A era do armazenamento de dados em hiperescala vive um momento de inflexão crítica. Enquanto a demanda global por capacidade continua a crescer em um ritmo exponencial — impulsionada pela ingestão massiva de datasets para treinamento de IA e analytics em tempo real —, a infraestrutura subjacente enfrenta um dilema físico e econômico. Durante décadas, a lei do mercado foi clara: discos rígidos (HDDs) para capacidade bruta e custo baixo; memória flash (SSDs) para performance e custo alto. Essa fronteira, no entanto, está se dissolvendo mais rápido do que muitos CIOs e arquitetos de infraestrutura previam.

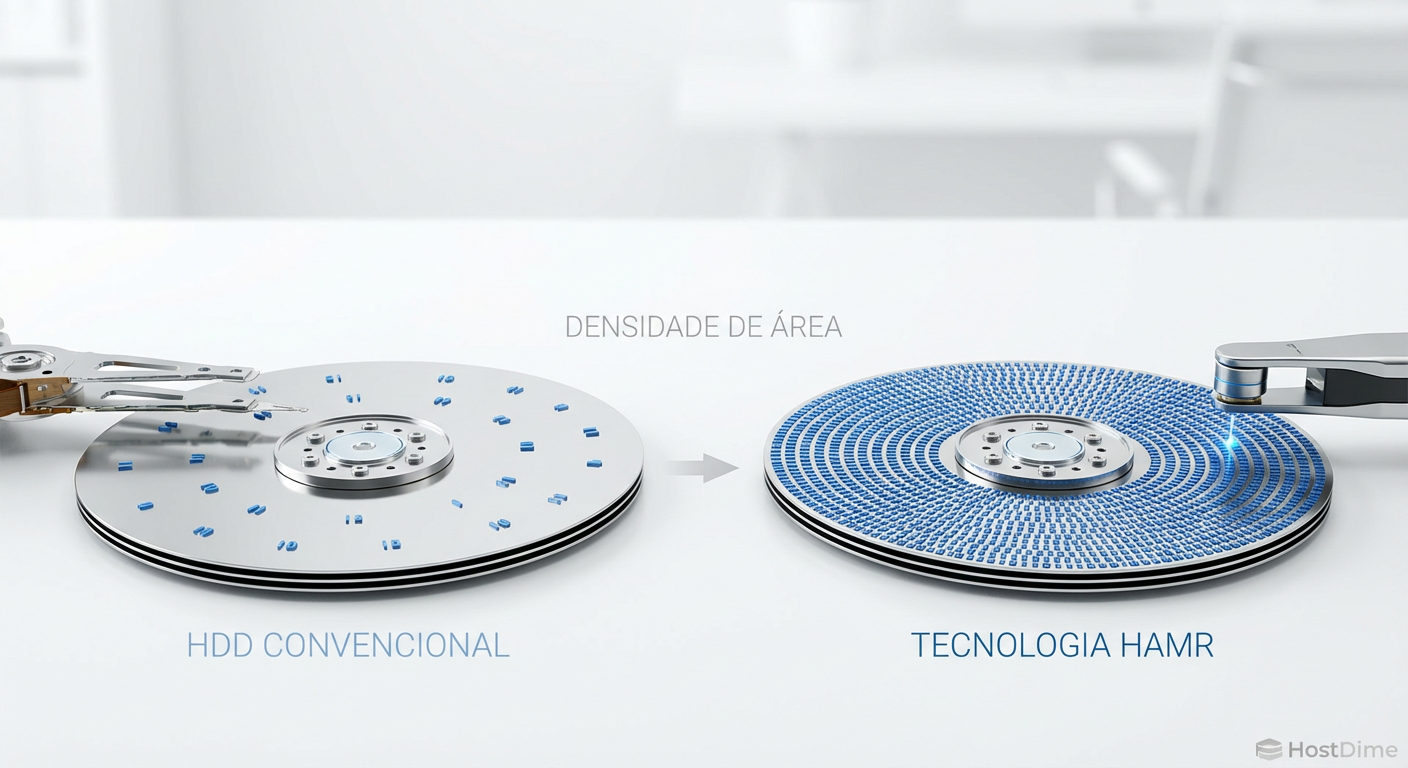

A indústria observa atentamente a corrida entre a engenharia mecânica extrema, representada pela tecnologia HAMR (Heat-Assisted Magnetic Recording), e a densidade vertical dos semicondutores, liderada pelo Flash QLC (Quad-Level Cell). Não se trata apenas de quem coloca mais terabytes em uma caixa de 3,5 polegadas, mas de qual tecnologia sobreviverá à matemática implacável do TCO (Total Cost of Ownership) nos datacenters modernos.

Resumo em 30 segundos

- O teto mecânico: A tecnologia HAMR é a última grande aposta dos fabricantes de HDDs para atingir 50TB+, mas a complexidade de engenharia atrasou os roadmaps, enquanto o Flash já entrega densidades superiores hoje.

- A inversão do TCO: Embora o custo de aquisição ($/TB) do HDD ainda seja menor, o consumo energético e a densidade por rack favorecem cada vez mais os SSDs QLC de alta capacidade (60TB+) em cenários de leitura intensiva.

- O gargalo de IOPS: Discos mecânicos gigantes sofrem com a diluição de performance (IOPS por TB), tornando os tempos de reconstrução de RAID e a latência de acesso riscos operacionais inaceitáveis para certas cargas de trabalho.

A promessa da plataforma Mozaic 3+ e o cronograma do HAMR

A Seagate, e em menor escala a Western Digital e a Toshiba, têm lutado contra os limites da superparamagnética. A resposta da indústria para manter a relevância do disco giratório é o HAMR. A plataforma Mozaic 3+ da Seagate, lançada comercialmente com unidades de 30TB+, representa um feito de engenharia notável: utilizar um laser nanoscópico para aquecer o prato do disco no momento exato da gravação, permitindo bits menores e mais estáveis.

O objetivo declarado é claro: atingir unidades de 50TB até meados de 2026 ou 2027. No entanto, a transição do laboratório para a produção em massa com rendimentos (yields) aceitáveis tem sido um desafio hercúleo. A complexidade térmica e a necessidade de novos materiais para os pratos e cabeças de gravação introduzem variáveis de falha que não existiam na era do PMR (Perpendicular Magnetic Recording).

Figura: A complexidade do HAMR: lasers integrados às cabeças de gravação permitem densidades superiores, mas elevam o custo de fabricação.

Figura: A complexidade do HAMR: lasers integrados às cabeças de gravação permitem densidades superiores, mas elevam o custo de fabricação.

Para os analistas de mercado, a questão não é se a tecnologia funciona, mas se ela chegará a tempo e ao preço certo. A Western Digital, por exemplo, adotou uma postura mais conservadora com o ePMR e o UltraSMR, espremendo a tecnologia atual até o limite antes de migrar totalmente para o HAMR. Essa divergência de estratégias sinaliza uma incerteza na indústria sobre a viabilidade de longo prazo da mecânica de precisão em escala de exabytes.

O paradoxo da densidade: SSDs de 61TB e o avanço do silício

Enquanto os fabricantes de HDDs celebram a chegada aos 30TB e prometem 50TB para o futuro, o mercado de semicondutores já ultrapassou essa marca no presente. A Solidigm (subsidiária da SK Hynix) e a Samsung já comercializam ou anunciaram SSDs com capacidades que variam de 61.44TB a 128TB em formatos como E1.S e U.2.

💡 Dica Pro: Ao avaliar SSDs de alta densidade (High-Density Flash), ignore o preconceito antigo sobre a durabilidade do QLC. Para cargas de trabalho de Read-Intensive (CDN, Data Lakes, AI Training Read), a resistência (DWPD) dos drives modernos é mais do que suficiente. O gargalo real é a rede, não a célula de memória.

O "paradoxo da densidade" reside no fato de que o silício, regido pela Lei de Moore (e agora pela empilhamento 3D NAND de 200+ camadas), escala verticalmente sem partes móveis. Um servidor 1U ou 2U equipado com drives QLC de 61TB pode substituir racks inteiros de armazenamento mecânico.

Isso cria uma pressão imensa sobre o roadmap dos HDDs. Se um SSD de 60TB já existe hoje, a promessa de um HDD de 50TB para daqui a dois anos perde o brilho da inovação e passa a competir exclusivamente pelo preço de aquisição (CapEx). E é aqui que a batalha se torna financeira.

A matemática cruel do TCO para hyperscalers

Historicamente, a métrica soberana era o "Dólar por Terabyte" ($/TB). Nessa métrica, o HDD ainda vence com folga, custando uma fração do preço do Flash QLC. No entanto, para os hyperscalers (AWS, Google, Microsoft) e grandes empresas, a equação mudou para o TCO total, onde a energia e o espaço físico (real estate) pesam tanto quanto o hardware.

Considere a seguinte dinâmica:

Consumo por TB: Um HDD de 30TB consome cerca de 8-10 Watts em operação. Um SSD de 61TB pode consumir 15-20 Watts, mas entrega o dobro da capacidade e milhares de vezes a performance. O consumo por Terabyte do SSD torna-se competitivo ou superior.

Densidade de Rack: Para armazenar 1 Petabyte com HDDs de 20TB, você precisa de 50 drives. Com SSDs de 61TB, você precisa de apenas 17 drives. Isso significa menos chassis, menos controladoras, menos fontes de alimentação e menos portas de switch.

Refrigeração: Menos calor gerado por TB armazenado reduz a carga nos sistemas de HVAC do datacenter.

Figura: O ponto de inflexão: O custo inicial do Flash é diluído pela economia operacional ao longo do ciclo de vida do hardware.

Figura: O ponto de inflexão: O custo inicial do Flash é diluído pela economia operacional ao longo do ciclo de vida do hardware.

Como vemos na projeção acima, existe um ponto de cruzamento. À medida que o custo da energia sobe e o preço da NAND cai, o "prêmio" pago pelo Flash se paga em menos tempo. Para datacenters limitados por fornecimento de energia (power-constrained) — uma realidade comum em zonas metropolitanas —, a densidade energética do Flash QLC é a única saída viável para expansão.

O gargalo invisível: performance por Terabyte

Um aspecto técnico frequentemente ignorado nas discussões de marketing é a "Performance por TB". Um HDD de 20TB tem, fisicamente, o mesmo mecanismo de atuação (ou muito similar) que um de 10TB. Isso significa que, ao dobrar a capacidade sem dobrar a velocidade do atuador, a densidade de IOPS (IOPS/TB) cai pela metade.

⚠️ Perigo: O fenômeno da "Capacidade Aprisionada" (Stranded Capacity) ocorre quando você tem espaço em disco, mas não consegue acessá-lo rápido o suficiente para atender à aplicação. Em HDDs de 30TB+, tempos de reconstrução de RAID podem levar dias ou semanas, deixando o array vulnerável a uma segunda falha catastrófica.

A tecnologia de atuador duplo (como o Mach.2 da Seagate) tenta mitigar isso, dobrando efetivamente a performance sequencial e aleatória. Contudo, isso adiciona custo e complexidade. O Flash, por natureza, escala performance linearmente com a capacidade devido ao paralelismo dos canais da controladora e dos chips NAND.

Em cenários de Big Data e IA, onde a latência de alimentação das GPUs é crítica, o HDD se torna um gargalo inaceitável. Não adianta ter 50TB de dados se a taxa de transferência não consegue saturar nem uma fração da largura de banda de rede de 400GbE ou 800GbE disponível nos servidores modernos.

A bifurcação do mercado e o nicho de sobrevivência

Diante desse cenário, não estamos prevendo a morte imediata do HDD, mas sim uma redefinição brutal de seu papel. O mercado de armazenamento está sofrendo uma bifurcação clara:

Performance & Nearline (Flash QLC/TLC): Todas as cargas de trabalho primárias, secundárias ativas, bancos de dados, virtualização e, crescentemente, data lakes de alto desempenho migrarão para All-Flash. A viabilidade do QLC de alta densidade canibaliza o mercado de HDDs de 10k e 15k RPM (já mortos) e agora ataca os HDDs Nearline SAS/SATA de entrada.

Cold Storage & Deep Archive (HDD & Tape): Onde o HDD de 50TB reinará? No armazenamento frio. Backups imutáveis, arquivos de conformidade regulatória, vigilância por vídeo de longa retenção e repositórios de conteúdo "write once, read never".

Neste nicho, o custo de aquisição ($/TB) ainda é rei. Se os dados não precisam ser acessados instantaneamente, o HDD de ultra-capacidade (e a fita LTO) continuam imbatíveis. A estratégia dos fabricantes de HDD, portanto, deve focar em reduzir o custo por gigabyte a qualquer preço, mesmo que a performance estagne.

Perspectiva Estratégica

Para os gestores de infraestrutura e investidores do setor, a recomendação é cautela com roadmaps de longo prazo baseados exclusivamente em mecânica. A "Batalha por Densidade" já foi vencida pelo silício em termos de capacidade física. A batalha que resta é puramente econômica.

Prevemos que até 2027, o conceito de "All-Flash Datacenter" deixará de ser um luxo para se tornar o padrão para qualquer dado que tenha probabilidade de ser lido mais de uma vez por mês. Os HDDs de 50TB encontrarão seu lugar, mas não como a espinha dorsal da internet ativa, e sim como a fundação silenciosa e econômica do vasto cemitério digital de dados frios. A consolidação de fornecedores de HDD é provável, enquanto o ecossistema de Flash deve continuar a se expandir e fragmentar com novas interfaces como CXL e formatos EDSFF. O futuro é híbrido, mas o equilíbrio de poder mudou irreversivelmente para o estado sólido.

Arthur Siqueira

Analista de Mercado de Storage

"Analiso o cenário macroeconômico do armazenamento corporativo. Meu foco está nos movimentos de consolidação, flutuações de market share e na saúde financeira que dita o futuro dos grandes players."