Como configurar um cluster Proxmox VE 9.1 com CXL e NVMe-oF

Aprenda a configurar o Proxmox VE 9.1 para utilizar expansão de memória via CXL 2.0 e armazenamento remoto de alta performance com NVMe-oF (TCP). Guia técnico passo a passo.

A convergência entre a memória volátil (RAM) e o armazenamento persistente (NVMe) atingiu um novo patamar com a introdução do CXL (Compute Express Link) e o amadurecimento do NVMe-oF (NVMe over Fabrics). Para administradores de sistemas e arquitetos de storage, o Proxmox VE se tornou o laboratório ideal para orquestrar essas tecnologias.

Neste guia, vamos configurar um ambiente onde o armazenamento remoto é acessado via NVMe/TCP com latência quase nativa, enquanto preparamos o sistema para utilizar expansores de memória CXL como uma camada de tiering transparente.

Resumo em 30 segundos

- NVMe-oF (TCP): Permite montar discos remotos usando a rede Ethernet padrão, com desempenho muito superior ao iSCSI.

- CXL (Compute Express Link): Uma tecnologia que conecta memória ao barramento PCIe, permitindo expandir a RAM do servidor além dos slots DIMM físicos.

- Tiering de Memória: O kernel do Linux move automaticamente dados "frios" da RAM rápida para a memória CXL (mais lenta, porém abundante), liberando recursos para cargas de trabalho críticas.

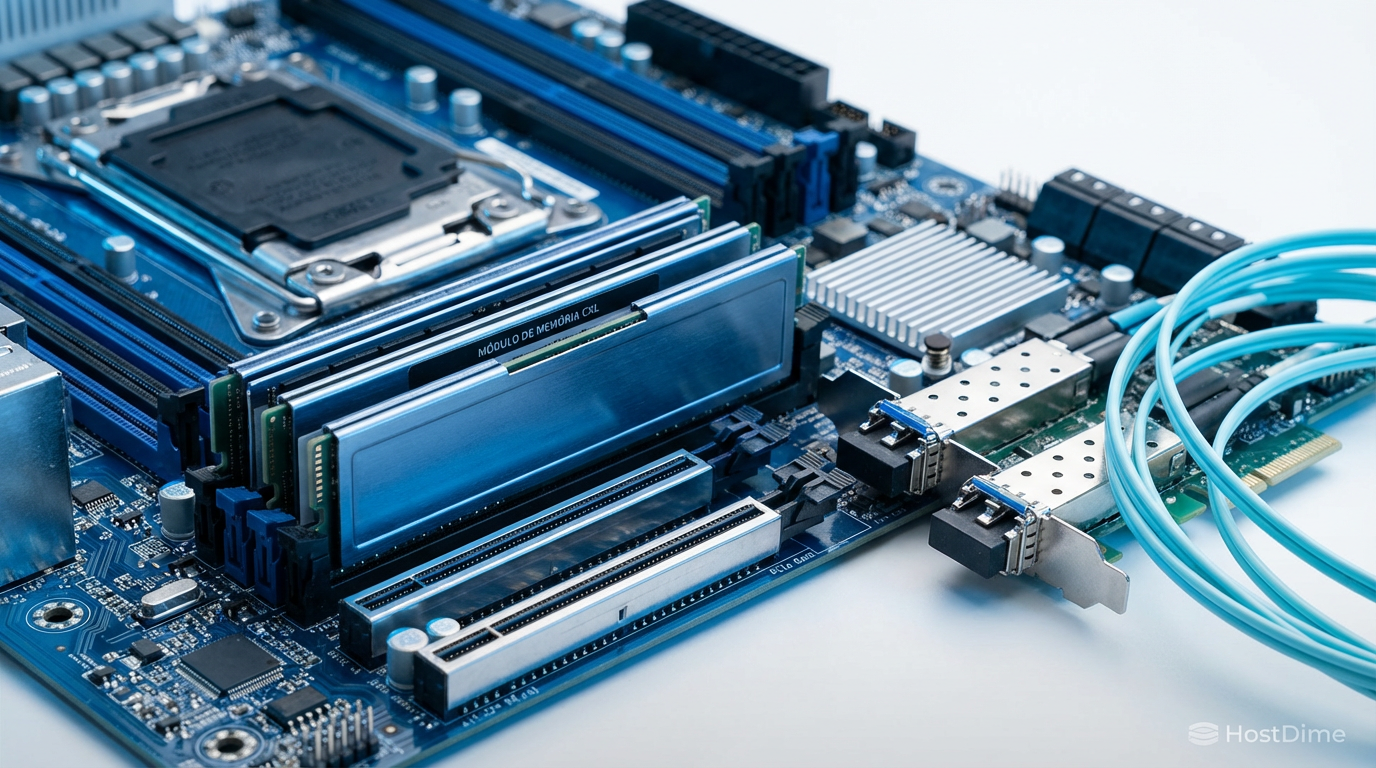

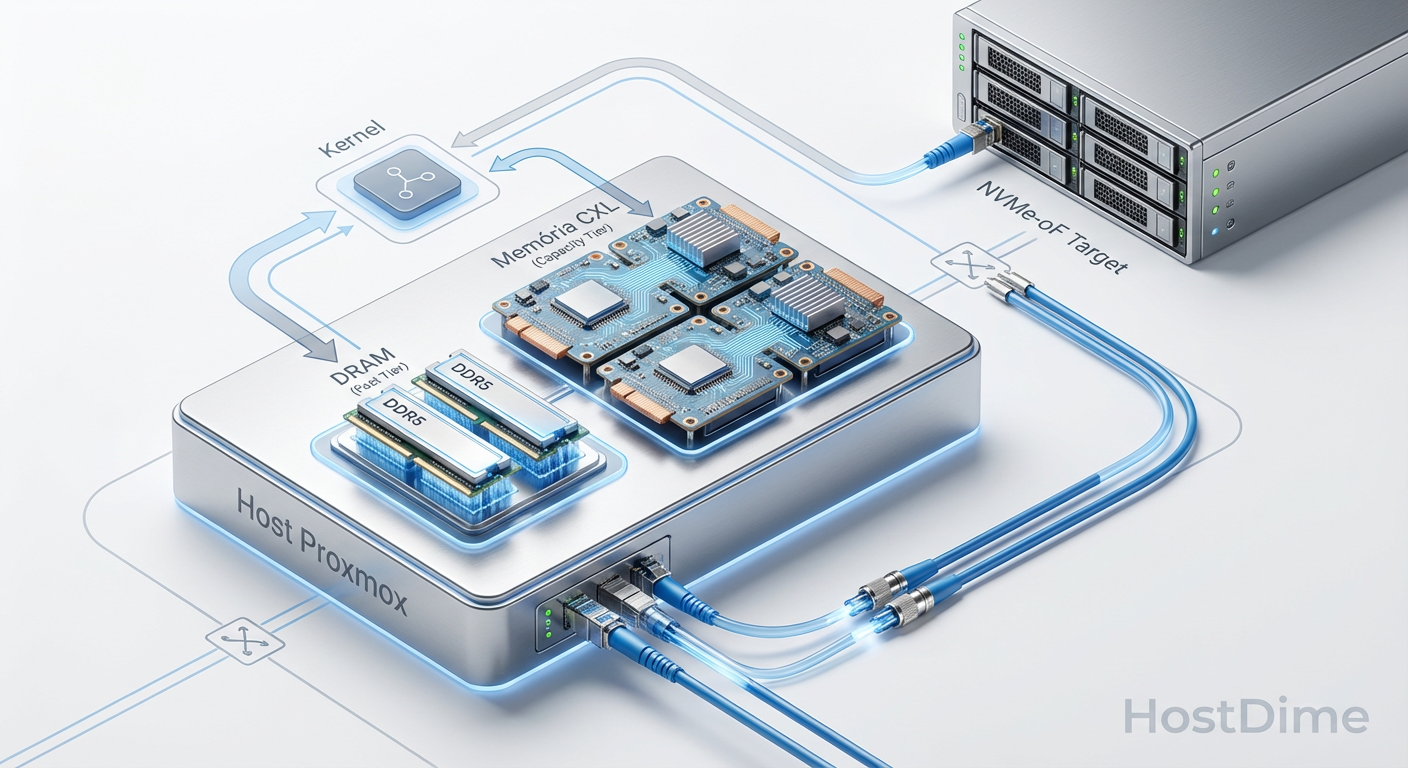

Fig. 1: Topologia de Tiering de Memória e Storage Remoto.

Fig. 1: Topologia de Tiering de Memória e Storage Remoto.

O objetivo: convergência de memória e armazenamento

Tradicionalmente, tratamos RAM e Disco como entidades distintas. O processador acessa a RAM via barramento de memória e o disco via PCIe/SATA. O CXL quebra essa barreira ao usar a interface PCIe 5.0 (ou superior) para transportar protocolos de memória com coerência de cache.

No contexto do Proxmox VE, isso significa que podemos ter um cluster onde:

O armazenamento em massa reside em um servidor de storage dedicado, entregue via NVMe-oF.

A memória do sistema é expandida via cartões CXL Type 3, criando um pool de memória hierárquico.

Pré-requisitos de hardware para CXL e malha NVMe

Para seguir este tutorial em um cenário de produção ou laboratório avançado, o hardware deve suportar as instruções necessárias.

Processador: Intel Sapphire Rapids (4ª Geração Xeon) ou AMD Genoa (EPYC 9004) e superiores. Estas são as primeiras gerações com suporte nativo a CXL 1.1/2.0.

Rede: Placas de rede (NICs) de 25GbE ou 100GbE. O protocolo NVMe/TCP é eficiente, mas exige largura de banda para justificar a substituição do armazenamento local.

Dispositivos CXL: Cartões de expansão de memória (ex: Samsung CXL Memory Expander ou Astera Labs).

Target NVMe-oF: Um servidor Linux ou storage array capaz de exportar namespaces NVMe via TCP.

💡 Dica Pro: Se você não possui hardware CXL físico (ainda raro e caro em 2026), você pode simular o comportamento de tiering NUMA usando QEMU/KVM para fins de aprendizado, criando nós NUMA virtuais com distâncias de latência diferentes.

Preparando a rede para transporte NVMe/TCP

O NVMe over TCP é a implementação mais acessível do NVMe-oF, pois não exige switches especiais (como no caso do RDMA/RoCE). No entanto, a configuração da rede é crítica para evitar perda de pacotes e retransmissões que destruiriam a latência.

Primeiro, isole o tráfego de storage em uma VLAN ou interface física dedicada.

1. Ajuste do MTU (Jumbo Frames) O NVMe/TCP beneficia-se enormemente de um MTU de 9000 bytes.

ip link show eth1

# Ajuste o MTU (temporário)

ip link set dev eth1 mtu 9000

# Para tornar persistente no Debian/Proxmox (/etc/network/interfaces)

auto eth1

iface eth1 inet static

address 192.168.10.50/24

mtu 9000

2. Otimização de filas e interrupções Garanta que sua placa de rede esteja distribuindo as filas de interrupção entre todos os núcleos da CPU para evitar gargalos em um único core.

# Instale o irqbalance se não estiver presente

apt update && apt install irqbalance

systemctl enable --now irqbalance

Conectando o storage remoto via nvme-cli

O Proxmox VE (baseado em Debian) utiliza o pacote nvme-cli para gerenciar conexões de fabric. Diferente do iSCSI, o NVMe-oF é extremamente leve no lado do iniciador (o servidor Proxmox).

1. Instalação das ferramentas

apt install nvme-cli

2. Carregando o módulo TCP O kernel precisa do módulo específico para transporte TCP.

modprobe nvme-tcp

echo "nvme-tcp" >> /etc/modules

3. Descoberta e Conexão

Suponha que seu storage (Target) esteja no IP 192.168.10.200.

# Descobrir targets disponíveis

nvme discover -t tcp -a 192.168.10.200 -s 4420

# Conectar a todos os targets descobertos

nvme connect-all

Verifique se o disco apareceu no sistema:

nvme list

A saída deve mostrar algo como /dev/nvme0n1 com o transporte listado como tcp.

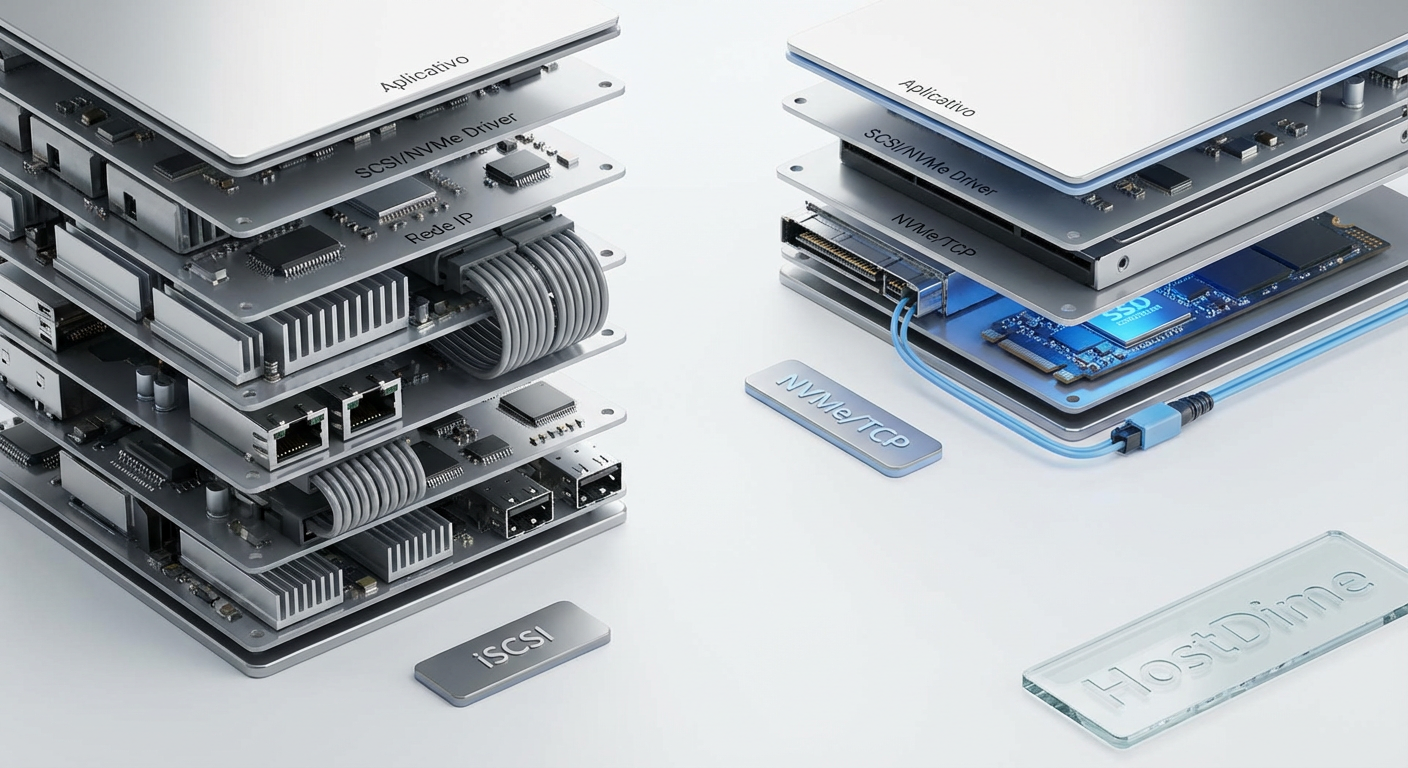

Fig. 3: Comparativo simplificado das pilhas de protocolo.

Fig. 3: Comparativo simplificado das pilhas de protocolo.

⚠️ Perigo: Nunca adicione o mesmo namespace NVMe a dois nós Proxmox simultaneamente sem usar um sistema de arquivos clusterizado (como GFS2 ou OCFS2) ou LVM com flag de cluster. O uso concorrente em ext4/xfs corromperá os dados instantaneamente.

Ativando o tiering de memória CXL no kernel

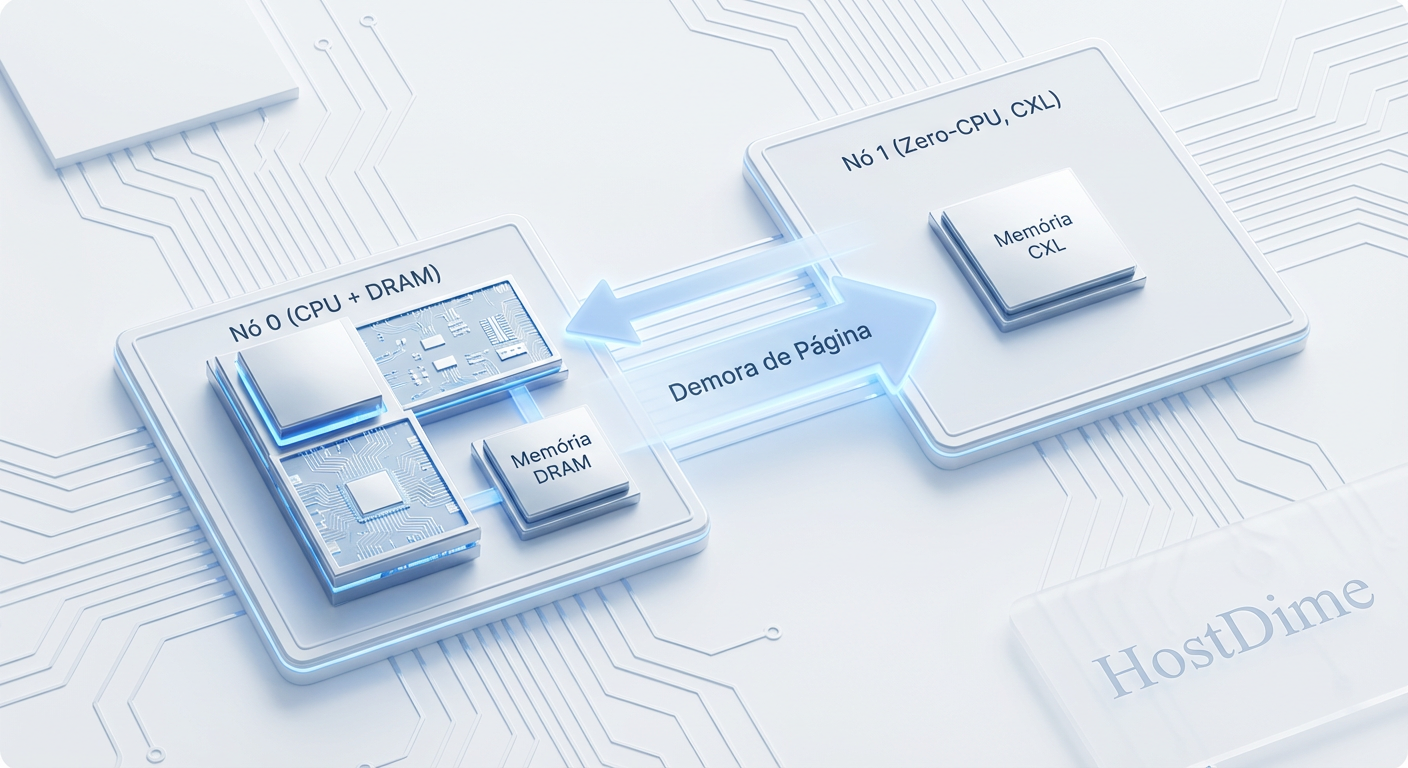

Aqui entramos na fronteira da tecnologia. O CXL permite que a memória conectada via PCIe seja vista pelo sistema operacional. No entanto, ela tem uma latência maior que a DRAM local. O Linux gerencia isso através do conceito de Tiered Memory (Memória em Camadas).

O objetivo é fazer o kernel "rebaixar" (demote) páginas de memória pouco usadas para o CXL e manter as páginas quentes na DRAM.

1. Verificação da Topologia NUMA Dispositivos CXL aparecem como nós NUMA sem CPUs (CPU-less nodes).

numactl -H

Se você tiver um dispositivo CXL instalado, verá um nó (ex: Node 2) com tamanho de memória (ex: 64GB) mas com lista de CPUs vazia.

2. Ativando o Auto-Tiering No Proxmox VE 9.1 (Kernel 6.x+), o recurso de Memory Tiering deve ser ativado explicitamente se não estiver por padrão.

Verifique o status atual:

cat /sys/kernel/mm/numa/demotion_enabled

Se o retorno for 0 (desativado), ative-o:

echo 1 > /sys/kernel/mm/numa/demotion_enabled

Para tornar persistente, você pode adicionar uma regra sysctl ou um script no boot, mas a maneira mais segura em sistemas modernos é via parâmetros do kernel no GRUB.

3. Configurando a política de promoção/rebaixamento O kernel usa um mecanismo LRU (Least Recently Used) para decidir o que mover. Você pode monitorar essa atividade.

Fig. 2: Fluxo de 'Page Demotion' entre DRAM e CXL.

Fig. 2: Fluxo de 'Page Demotion' entre DRAM e CXL.

Verificação de latência e topologia NUMA

Uma vez configurado, é vital garantir que o Proxmox esteja ciente das distâncias de latência para não alocar memória CXL para processos críticos por engano.

Use o comando numastat para ver se o rebaixamento está ocorrendo:

numastat -m

Procure por estatísticas de migração entre nós. Se o sistema estiver sob pressão de memória, você deverá ver o uso do nó CXL aumentar enquanto a DRAM principal permanece cheia com dados ativos.

Para testar o desempenho do disco NVMe-oF recém-adicionado:

# Teste de leitura aleatória 4k (simulando VM)

fio --name=random-read --ioengine=libaio --rw=randread --bs=4k --numjobs=4 --size=4G --runtime=60 --time_based --filename=/dev/nvme0n1

Compare os resultados (IOPS e Latência) com um disco local. Em uma rede 25GbE bem configurada, a sobrecarga do NVMe/TCP deve ser inferior a 10-15µs adicionais.

Diagnosticando falhas de conexão e gargalos PCIe

Mesmo seguindo o passo a passo, problemas de infraestrutura física podem surgir.

Sintoma: Latência alta no NVMe-oF Verifique se há "pausas" no fluxo TCP.

# Verifique retransmissões TCP

netstat -s | grep retransmited

Se este número estiver crescendo, você tem um problema de camada física (cabo ruim), MTU incompatível ou switch congestionado. O NVMe é implacável com perda de pacotes.

Sintoma: Memória CXL não detectada Muitas vezes, o BIOS do servidor precisa ser configurado para permitir o mapeamento de memória nativa via PCIe.

Reinicie o servidor e entre no BIOS/UEFI.

Procure por configurações como "CXL Type 3 Support" ou "PCIe Memory Mapping".

Certifique-se de que o IOMMU está ativado corretamente.

Sintoma: Proxmox trava ao conectar o target

Isso pode ocorrer se o hostnqn (identificador do host NVMe) não estiver autorizado no storage array. Verifique o arquivo:

cat /etc/nvme/hostnqn

Garanta que esta string esteja na lista de acesso (ACL) do seu storage server.

Recomendação de uso

A implementação de CXL e NVMe-oF no Proxmox VE representa o estado da arte em infraestrutura definida por software. No entanto, a complexidade adicionada exige cautela.

Recomendo fortemente o uso desta arquitetura para cargas de trabalho de banco de dados massivos ou virtualização de alta densidade, onde o custo da RAM tradicional é proibitivo. Para VMs genéricas ou containers leves, a complexidade do tiering de memória pode não justificar o ganho de capacidade. Monitore agressivamente as taxas de page demotion para garantir que suas aplicações críticas não estão sendo enviadas para a memória lenta indevidamente.

Perguntas Frequentes

1. O NVMe/TCP é mais rápido que o iSCSI? Sim, significativamente. O NVMe foi desenhado para mídia flash e suporta múltiplas filas (queues) paralelas, enquanto o iSCSI foi desenhado para a era dos discos rotativos e sofre com gargalos de serialização em SSDs modernos.

2. Posso usar CXL em processadores Intel Xeon antigos (Gen 1-3)? Não. O suporte a CXL exige controladores PCIe 5.0 e lógica específica integrada ao processador, presentes apenas a partir da 4ª Geração Xeon Scalable (Sapphire Rapids) e AMD EPYC 9004 (Genoa).

3. O que acontece se a rede do NVMe-oF cair? O sistema operacional tentará reconectar por um tempo definido (timeout). Se a conexão não voltar, o sistema de arquivos entrará em modo somente leitura ou causará erros de I/O nas VMs. É obrigatório usar caminhos redundantes (Multipath) em produção.

4. O Proxmox mostra a memória CXL na interface web?

Por padrão, o Proxmox soma toda a memória disponível (DRAM + CXL) no dashboard. Para ver a distinção, você deve usar ferramentas de linha de comando como numactl ou instalar plugins de monitoramento que leiam métricas NUMA detalhadas.

Magnus Vance

Engenheiro do Caos

"Quebro sistemas propositalmente porque a falha é inevitável. Transformo desastres simulados em vacinas para sua infraestrutura. Se não sobrevive ao meu caos, não merece estar em produção."