Crise dos Chips 2.0? Por que a IA disparou o preço do armazenamento em 2026

Análise de mercado: Entenda como a escassez de NAND e a priorização de memórias HBM para IA causaram a maior alta de preços de SSDs e DRAM da década em 2026.

Se você tentou orçar uma renovação de parque de servidores ou simplesmente buscou um SSD NVMe de alta capacidade para seu Home Lab nas primeiras semanas de janeiro de 2026, o choque foi inevitável. Os preços não apenas subiram; eles escalaram verticalmente. Diferente da crise logística de 2020, onde navios estavam parados e fábricas fechadas, o cenário atual é uma crise de alocação estratégica.

O mercado de armazenamento vive um momento de bifurcação histórica. De um lado, a demanda insaciável por infraestrutura de Inteligência Artificial Generativa; do outro, o resto do mercado de TI lutando por sobras de capacidade fabril. Para os analistas que acompanham os relatórios trimestrais da Samsung, SK Hynix e Micron, o movimento era previsível, mas a velocidade da execução surpreendeu até os mais pessimistas.

Resumo em 30 segundos

- O Efeito HBM: A fabricação de memórias HBM3e/HBM4 para chips de IA consome 3x mais capacidade de wafer do que memórias padrão, drenando a oferta global.

- Escassez Induzida: Fabricantes reduziram propositalmente a produção de NAND Flash convencional para forçar a alta de preços e recuperar margens de lucro perdidas em 2024.

- Previsão 2026/27: Não espere quedas de preço no curto prazo. A estabilização só deve ocorrer quando novas fábricas (Fabs) entrarem em operação no início de 2027.

A matemática cruel da fabricação de silício

Para entender por que seu SSD de 4TB custa hoje o que um de 8TB custaria em um mercado saudável, é preciso olhar para o chão de fábrica. A capacidade de produção de semicondutores é medida em wafers (discos de silício). A quantidade de wafers que uma fábrica pode processar é finita e extremamente cara para expandir.

Em 2026, a prioridade absoluta das "Big Three" (Samsung, SK Hynix e Micron) é a memória HBM (High Bandwidth Memory). Este tipo de memória é o combustível essencial para as GPUs da NVIDIA (como as arquiteturas Blackwell e Rubin) e aceleradores da AMD. O problema reside na complexidade física: produzir um chip HBM envolve empilhamento vertical (TSV - Through-Silicon Via) e processos de validação muito mais longos do que produzir um chip de memória DDR5 ou NAND Flash comum.

Figura: Comparativo visual da alocação de recursos em uma fábrica de semicondutores: a produção de HBM consome desproporcionalmente mais capacidade de wafer do que componentes padrão.

Figura: Comparativo visual da alocação de recursos em uma fábrica de semicondutores: a produção de HBM consome desproporcionalmente mais capacidade de wafer do que componentes padrão.

Ao desviar linhas de produção inteiras para HBM, cria-se um vácuo na oferta de DRAM padrão e, por tabela, afeta-se o ecossistema de NAND. A lógica é financeira: a margem de lucro em um módulo HBM para IA é exponencialmente maior do que em pentes de memória ou SSDs de consumo.

💡 Dica Pro: Se você gerencia um Data Center on-premise, pare de esperar "o preço baixar" para projetos críticos. A tendência para o Q3 e Q4 de 2026 é de manutenção de preços altos ou novas altas leves. Garanta estoque operacional agora.

O impacto no ecossistema de NAND e SSDs

Embora a HBM seja uma tecnologia de memória volátil (DRAM), o "efeito dominó" atinge diretamente o armazenamento persistente (NAND Flash). Com os lucros recordes vindos do setor de IA, os fabricantes não sentem pressão para inundar o mercado com chips NAND baratos para ganhar volume. Pelo contrário, a estratégia adotada é a de "Lucratividade sobre Market Share".

Isso resultou em uma oferta controlada de chips NAND 3D de alta camada (236+ layers). O foco agora são os Enterprise SSDs (eSSDs) de altíssima capacidade (30TB, 60TB e além) voltados para data lakes de treinamento de IA. O mercado de entrada e intermediário (SSDs M.2 NVMe de 1TB a 4TB) ficou em segundo plano, recebendo menos alocação de wafers.

A ascensão forçada do QLC

Uma consequência direta desse cenário em 2026 é a onipresença da tecnologia QLC (Quad-Level Cell). Para manter capacidades altas sem gastar muito silício, os fabricantes estão empurrando o QLC para segmentos onde antes reinava o TLC (Triple-Level Cell).

Para o consumidor final e entusiastas de Home Lab, isso significa que encontrar drives com alta durabilidade (TBW) e performance sustentada de escrita tornou-se mais caro e difícil. O mercado enterprise, por sua vez, está adotando o QLC em massa para substituir os últimos redutos de HDDs de 10k RPM, deixando os discos mecânicos restritos quase que exclusivamente ao cold storage e arquivamento massivo.

Tabela Comparativa: O cenário de armazenamento em 2026

Para contextualizar a mudança de foco da indústria, analisamos as diferenças entre o hardware focado em IA (onde está o investimento) e o hardware de infraestrutura geral (onde está a escassez).

| Característica | Storage de Infraestrutura Geral (Legado) | Storage Otimizado para IA (Foco Atual) |

|---|---|---|

| Tecnologia Principal | NAND TLC / DDR5 ECC | HBM3e / NAND QLC de Alta Densidade |

| Foco de Design | Custo-benefício, Latência Média | Largura de Banda Extrema, Densidade Massiva |

| Disponibilidade (2026) | Baixa (Escassez induzida) | Alta (Prioridade de fabricação) |

| Tendência de Preço | Alta de 15-25% ano a ano | Estável (devido a contratos de longo prazo) |

| Interface Típica | PCIe 4.0 / SATA | PCIe 5.0 / CXL 2.0 / NVLink |

| Cenário de Uso | Virtualização, File Server, Boot | Treinamento de LLMs, Vector Databases |

A estratégia silenciosa de Samsung e SK Hynix

Analistas de mercado observam uma disciplina inédita vinda da Coreia do Sul. Historicamente, Samsung e SK Hynix entravam em guerras de preços para destruir a concorrência. Em 2026, a postura é de cooperação tácita para manutenção de margens.

Após os prejuízos bilionários no ciclo de baixa de 2023, os CEOs dessas companhias aprenderam que controlar a oferta é mais seguro do que apostar na demanda elástica. Mesmo com as fábricas operando abaixo de 100% da capacidade total em certas linhas, o Average Selling Price (ASP) compensa.

⚠️ Perigo: Cuidado com SSDs de marcas desconhecidas ("white label") que inundaram o mercado em 2026. Com a escassez de NAND de primeira linha, muitas dessas marcas estão utilizando chips de "rejeito" (binned out) ou reciclados de data centers. A integridade dos seus dados vale mais que a economia de 15%.

O papel do CXL na mitigação de custos

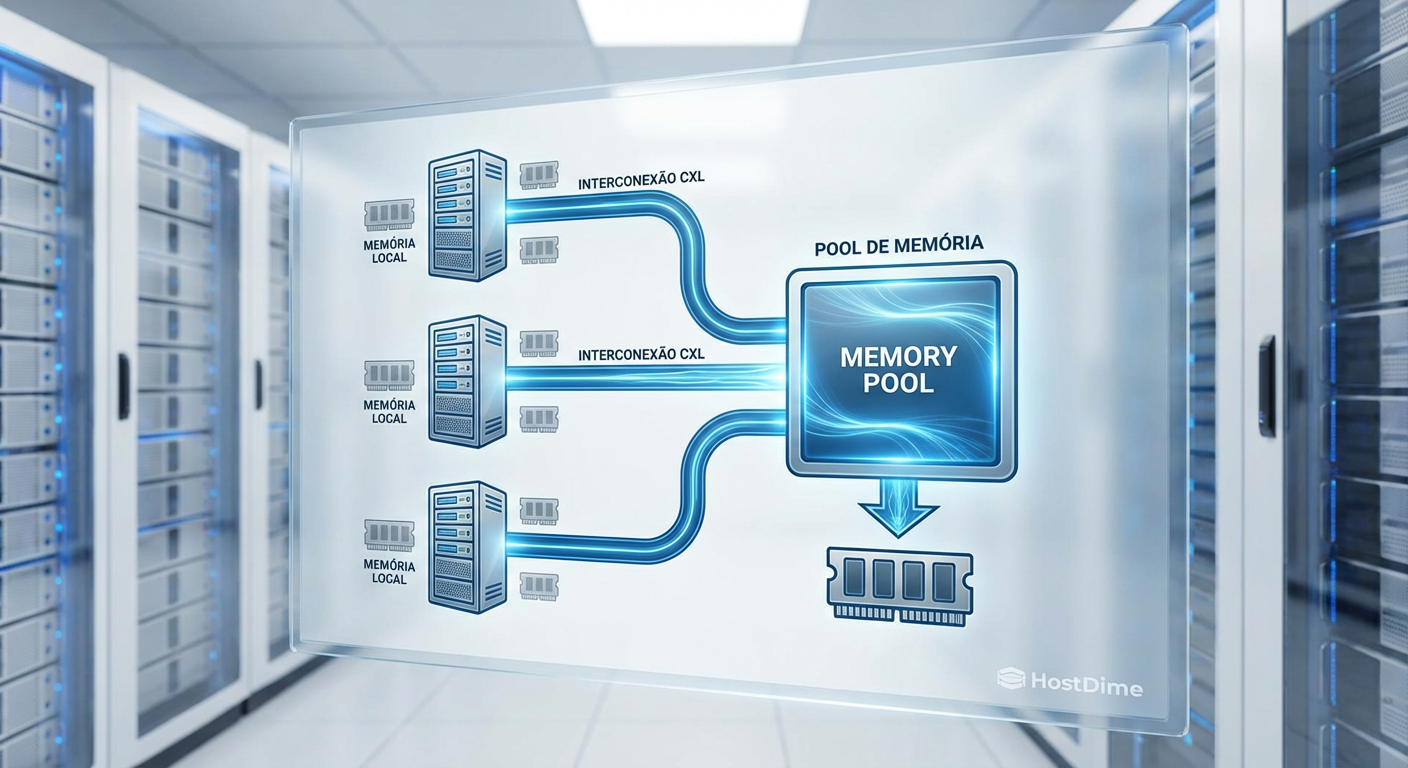

Se o hardware está caro, a arquitetura precisa ser mais inteligente. É aqui que o CXL (Compute Express Link) deixa de ser uma promessa de slide de PowerPoint e se torna a tábua de salvação dos arquitetos de soluções em 2026.

O CXL permite que servidores compartilhem pools de memória e armazenamento de forma desagregada. Antes, se você precisava de mais RAM ou armazenamento rápido em um servidor, tinha que comprar pentes caros e limitados aos slots da placa-mãe. Com o CXL, é possível conectar caixas de expansão de memória via barramento PCIe, acessando-as com latência próxima à da DRAM nativa.

Isso permite que empresas comprem menos memória "premium" por servidor e utilizem um pool compartilhado para picos de carga, otimizando o TCO (Total Cost of Ownership) em um momento de preços inflacionados.

Figura: Diagrama esquemático demonstrando a arquitetura CXL em um Data Center, onde múltiplos servidores acessam um pool compartilhado de memória, reduzindo a necessidade de superprovisionamento individual.

Figura: Diagrama esquemático demonstrando a arquitetura CXL em um Data Center, onde múltiplos servidores acessam um pool compartilhado de memória, reduzindo a necessidade de superprovisionamento individual.

O veredito do analista: Como navegar a tempestade

Não estamos diante de uma bolha passageira, mas de um reajuste estrutural de preços. A era do armazenamento "barato demais para ser verdade" acabou, sacrificada no altar da Inteligência Artificial. Para CIOs, gerentes de TI e entusiastas, a estratégia para o restante de 2026 deve ser defensiva.

A recomendação é evitar compras de pânico, mas antecipar ciclos de renovação que seriam feitos em 2027. A capacidade das novas fábricas nos EUA e Europa só aliviará a pressão de oferta daqui a 12 ou 18 meses. Até lá, a prioridade das linhas de produção continuará sendo onde o dinheiro está: na IA. Se o seu projeto depende de armazenamento de alta performance, considere tecnologias de tiering (camadas), movendo dados frios para HDDs de alta capacidade ou fita LTO, reservando o precioso flash apenas para o que é estritamente necessário.

Perguntas Frequentes (FAQ)

Por que o preço dos SSDs subiu tanto em 2026?

A alta deve-se à realocação estratégica das linhas de produção de wafers de silício. Fabricantes como Samsung e Micron desviaram a capacidade crítica de NAND Flash e DRAM padrão para produzir memórias HBM (High Bandwidth Memory) e SSDs focados em IA. Como esses produtos possuem margens de lucro muito superiores, gerou-se uma escassez artificial nos produtos de armazenamento convencionais.Quando o preço das memórias e SSDs vai baixar?

Analistas da IDC e Gartner preveem que a escassez estrutural durará até o início de 2027. Embora novas fábricas (Fabs) estejam sendo construídas, elas só entrarão em operação plena e com rendimento (yield) estável no final de 2026, mantendo os preços elevados no curto e médio prazo.O que é HBM e por que ela afeta o meu servidor?

HBM (High Bandwidth Memory) é a memória essencial para chips de IA (como os da NVIDIA). Sua fabricação é complexa e consome até 3x mais wafers de silício que a memória DDR5 comum. Como a capacidade global das fábricas é finita, produzir mais HBM significa necessariamente produzir menos memória RAM e Flash para servidores tradicionais, elevando o custo de todo o ecossistema de infraestrutura.

Arthur Siqueira

Analista de Mercado de Storage

"Analiso o cenário macroeconômico do armazenamento corporativo. Meu foco está nos movimentos de consolidação, flutuações de market share e na saúde financeira que dita o futuro dos grandes players."