CXL 3.1 transforma a memória RAM em uma rede compartilhada de alta velocidade

Adeus à memória ilhada: entenda como o protocolo CXL 3.1 e os novos memory fabrics permitem que servidores compartilhem RAM via PCIe 6.0, reduzindo custos em datacenters.

O gargalo mais caro do data center moderno não é mais o processador, mas sim a capacidade de alimentá-lo com dados. Enquanto CPUs e GPUs escalaram sua contagem de núcleos exponencialmente, a memória DRAM ficou para trás, presa a slots físicos limitados na placa-mãe. O padrão CXL 3.1 (Compute Express Link) chega para demolir essa barreira física, transformando a memória RAM de um componente estático em um recurso de rede dinâmico e compartilhável.

Resumo em 30 segundos

- Velocidade Dobrada: O CXL 3.1 opera sobre a interface PCIe 6.0, atingindo 64 GT/s, o dobro da geração anterior, permitindo que a memória externa tenha desempenho próximo ao da RAM local.

- Fim do Desperdício: A tecnologia resolve o problema da "memória ilhada" (stranded memory), permitindo que múltiplos servidores acessem um único pool de RAM conforme a demanda.

- Arquitetura de Switch: Diferente das versões anteriores, o 3.1 permite topologias complexas com switches, onde CPUs e GPUs acessam memória peer-to-peer sem intervenção do host principal.

O salto para 64 GT/s e a era da memória desagregada

A grande promessa do CXL sempre foi a coerência de cache: permitir que um dispositivo (como um acelerador ou expansor de memória) converse com a CPU falando a "mesma língua", mantendo os dados sincronizados. Com a especificação 3.1, baseada na camada física do PCIe 6.0, a largura de banda salta para 64 GT/s (Gigatransfers por segundo).

Isso é crítico porque, pela primeira vez, a latência e a vazão da "memória distante" (far memory) tornam-se viáveis para cargas de trabalho de missão crítica, como treinamento de IA e bancos de dados in-memory massivos. Não estamos mais falando apenas de um "cache lento", mas de uma extensão real da memória principal.

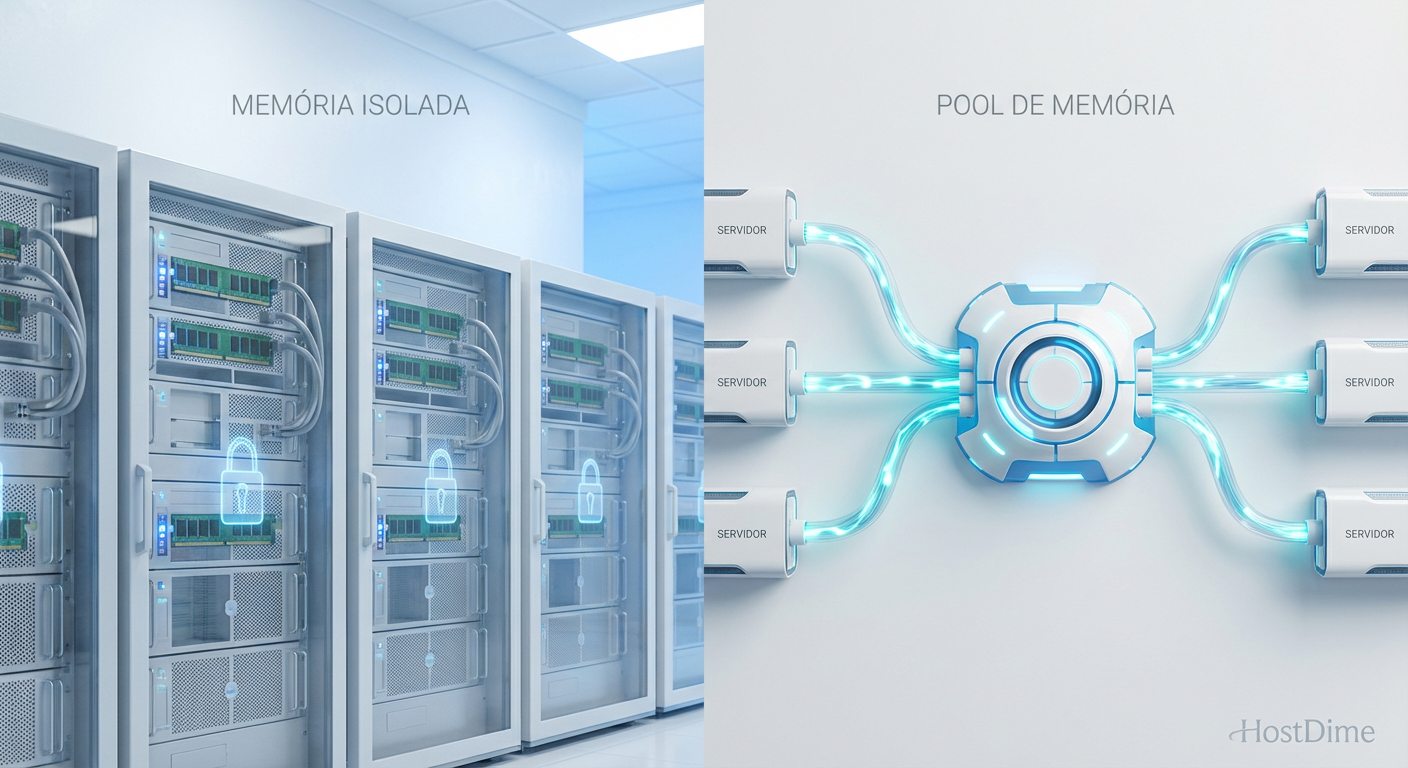

Figura: Comparativo visual: A rigidez dos servidores tradicionais versus a fluidez do pool de memória compartilhada via CXL.

Figura: Comparativo visual: A rigidez dos servidores tradicionais versus a fluidez do pool de memória compartilhada via CXL.

O fim da "Stranded Memory"

O maior vilão do TCO (Custo Total de Propriedade) em data centers hoje é a memória ilhada. Imagine um servidor com 1TB de RAM que está usando apenas 200GB. Os outros 800GB estão "presos" naquela máquina. Se o servidor vizinho estiver travando por falta de memória, ele não pode pegar emprestado o excedente do vizinho.

O CXL muda essa lógica de propriedade. Com o uso de pools de memória, a RAM sai de dentro do chassi do servidor e vai para gavetas dedicadas (semelhantes a storages JBOF, mas para memória).

💡 Dica Pro: Em ambientes virtualizados (VMware vSphere ou Proxmox), o CXL permite que você provisione memória para uma VM que excede a capacidade física do host onde ela está rodando, buscando recursos no pool via barramento.

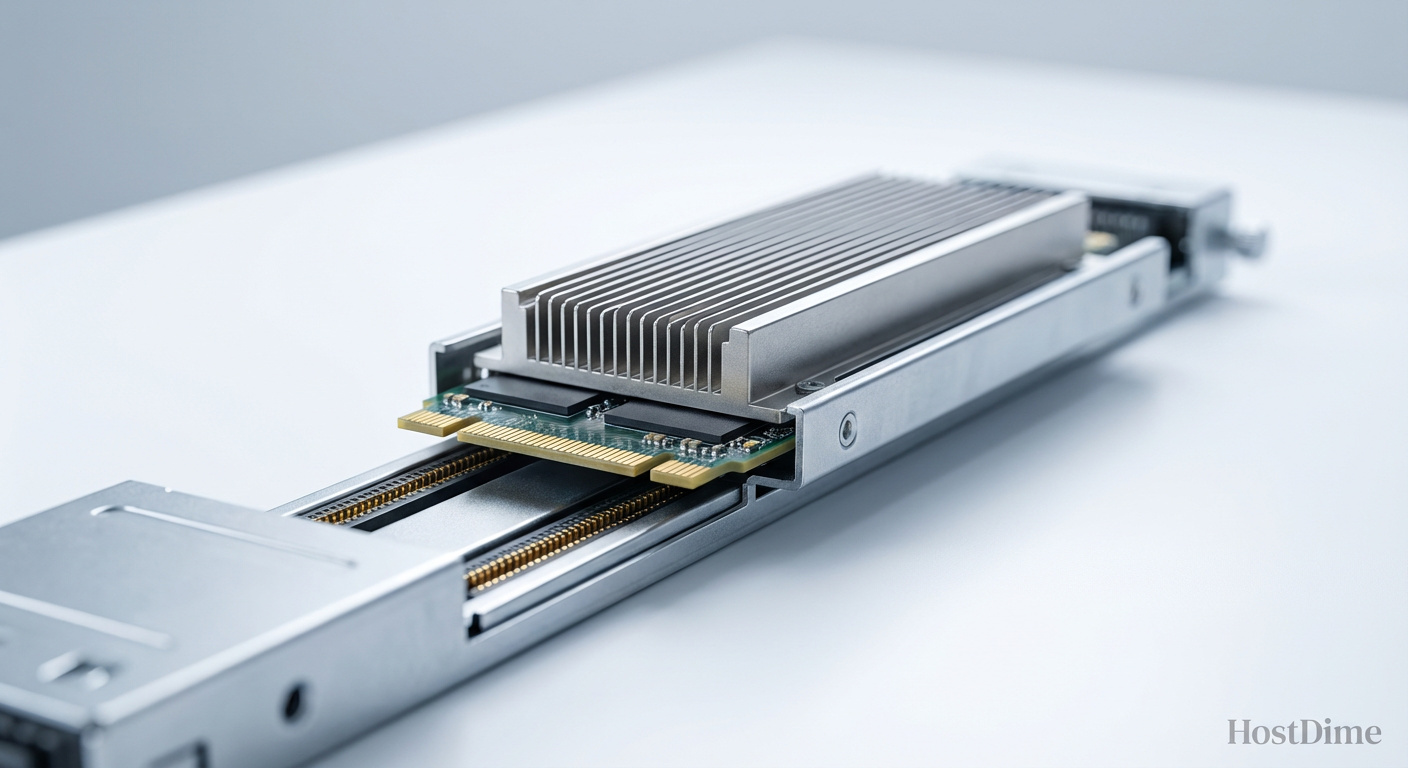

Módulos CMM-D e o novo formato da RAM

Esqueça os pentes DIMM tradicionais para essa aplicação. A indústria está padronizando o uso de módulos CMM-D (CXL Memory Module - DRAM). O mais curioso para profissionais de infraestrutura é que eles se parecem fisicamente com SSDs Enterprise.

Utilizando formatos como E1.S ou E3.S (da especificação EDSFF), esses módulos de memória são encaixados nos mesmos bays frontais que costumávamos usar para discos NVMe. Isso facilita a refrigeração e a manutenção a quente (hot-swap), algo impossível com a memória DDR5 tradicional soldada ou encaixada na placa-mãe.

Plataformas recentes, como os processadores Intel Xeon 6 (Sierra Forest e Granite Rapids), já trazem suporte nativo robusto para essas topologias, validando o ecossistema que antes era apenas teórico.

Switches de memória e segurança via TEE

O diferencial do CXL 3.1 em relação ao 2.0 é a capacidade de roteamento complexo. Introduz-se aqui o conceito de Global Fabric Attached Memory (GFAM). Um switch CXL pode conectar dezenas de hosts a centenas de módulos de memória.

Mais impressionante é a comunicação peer-to-peer. Uma GPU pode acessar dados diretamente de um módulo de memória CXL sem que a CPU principal precise intermediar a cópia dos dados. Isso reduz drasticamente a latência e libera ciclos de processamento.

⚠️ Perigo: Ao tirar a memória de dentro do servidor e passá-la por cabos e switches, a superfície de ataque aumenta. O CXL 3.1 implementa obrigatoriamente o IDE (Integrity and Data Encryption). Nunca implemente soluções CXL em produção sem garantir que o TEE (Trusted Execution Environment) esteja ativo para criptografar os dados em trânsito.

Comparativo: Onde o CXL se encaixa na hierarquia?

É vital entender que o CXL não substitui a memória DDR local, nem o SSD. Ele cria uma nova camada intermediária essencial.

| Característica | DDR5 Local (Near Memory) | CXL 3.1 (Far Memory) | SSD NVMe (Storage) |

|---|---|---|---|

| Latência | Baixíssima (< 100 ns) | Baixa (~170-250 ns) | Alta (> 10.000 ns) |

| Capacidade | Limitada pelos slots da CPU | Massiva (Petabytes via switch) | Massiva |

| Persistência | Volátil (apaga ao desligar) | Volátil (geralmente) | Persistente |

| Custo/GB | Altíssimo | Alto (mas otimizado pelo uso) | Baixo |

| Uso Ideal | Kernel, Hot Data, Cache L1/L2 | Bancos de dados in-memory, AI | Armazenamento de arquivos, Logs |

O futuro é a desagregação total

A chegada do CXL 3.1 sinaliza o fim do servidor como uma "caixa fechada". Estamos caminhando para a arquitetura Rack-Scale, onde compramos gavetas de CPU, gavetas de GPU e gavetas de Memória, conectando tudo via um backplane óptico ou de cobre de alta velocidade.

Para o profissional de storage e infraestrutura, a fronteira entre "armazenamento" e "memória" está desaparecendo. Gerenciar pools de RAM será, em breve, uma tarefa tão comum quanto gerenciar LUNs em um Storage Area Network (SAN). A recomendação é começar a planejar a infraestrutura futura considerando que a memória não será mais um recurso fixo, mas um serviço provisionável.

O que é CXL 3.1?

É a versão mais recente do protocolo Compute Express Link, que permite criar "tecidos de memória" (memory fabrics). Nela, múltiplos servidores podem acessar um pool compartilhado de RAM via barramento PCIe 6.0, com suporte a switches e topologias complexas.Qual a diferença entre CXL 2.0 e 3.1?

Enquanto o CXL 2.0 foca no pool básico de memória entre um host e dispositivos (ponto a ponto), o 3.1 introduz roteamento baseado em portas (PBR) e comunicação peer-to-peer real. Isso permite que dispositivos conversem entre si sem passar pela CPU e habilita arquiteturas de switch de grande escala.O CXL substitui a memória DDR5 local?

Não. O CXL atua como uma camada de "memória distante" (far memory). Ele oferece capacidade massivamente maior que a DDR5 local, com uma latência apenas ligeiramente superior, mas ainda ordens de magnitude mais rápida que um SSD NVMe.

Mariana Costa

Repórter de Tecnologia (Newsroom)

"Cubro o universo de TI corporativa com agilidade jornalística. Minha missão é traduzir o 'tech-speak' de datacenters e cloud em notícias diretas para sua tomada de decisão."