De NAS para Plataforma de Dados: Estratégias de Migração Escalável sem Refatoração Total

Descubra como evoluir do armazenamento NAS legado para uma plataforma de dados híbrida e escalável. Análise de TCO, trade-offs e estratégias de arquitetura enterprise.

A resposta curta para qualquer pergunta sobre modernização de infraestrutura é sempre a mesma: depende.

No entanto, quando falamos especificamente sobre a transição de armazenamentos legados baseados em rede (NAS) para plataformas de dados modernas, o "depende" geralmente gira em torno de uma variável crítica: o custo de refatoração da aplicação.

Como arquitetos, frequentemente nos deparamos com o dilema clássico. Temos aplicações monolíticas críticas, escritas há uma década, que dependem estritamente de chamadas de sistema de arquivos (POSIX) — open, read, write, lock, seek. O negócio exige a elasticidade e o custo reduzido do armazenamento de objetos em nuvem (Object Storage), mas a reescrita dessas aplicações para falar nativamente via APIs RESTful (como S3) é financeiramente inviável ou tecnicamente arriscada demais no curto prazo.

Este artigo explora como navegar por esse cenário, movendo-se de um gargalo de I/O local para uma arquitetura de dados global, sem a necessidade de um Big Bang de refatoração.

O Gargalo do "NAS Legado" no Crescimento Empresarial: Latência e Silos

O NAS (Network Attached Storage) serviu bem às empresas por décadas. Ele oferece simplicidade: um protocolo padrão (NFS ou SMB) e uma hierarquia de arquivos que humanos e máquinas entendem. Contudo, na era do Big Data e da computação distribuída, o NAS monolítico tornou-se um anti-padrão de escalabilidade.

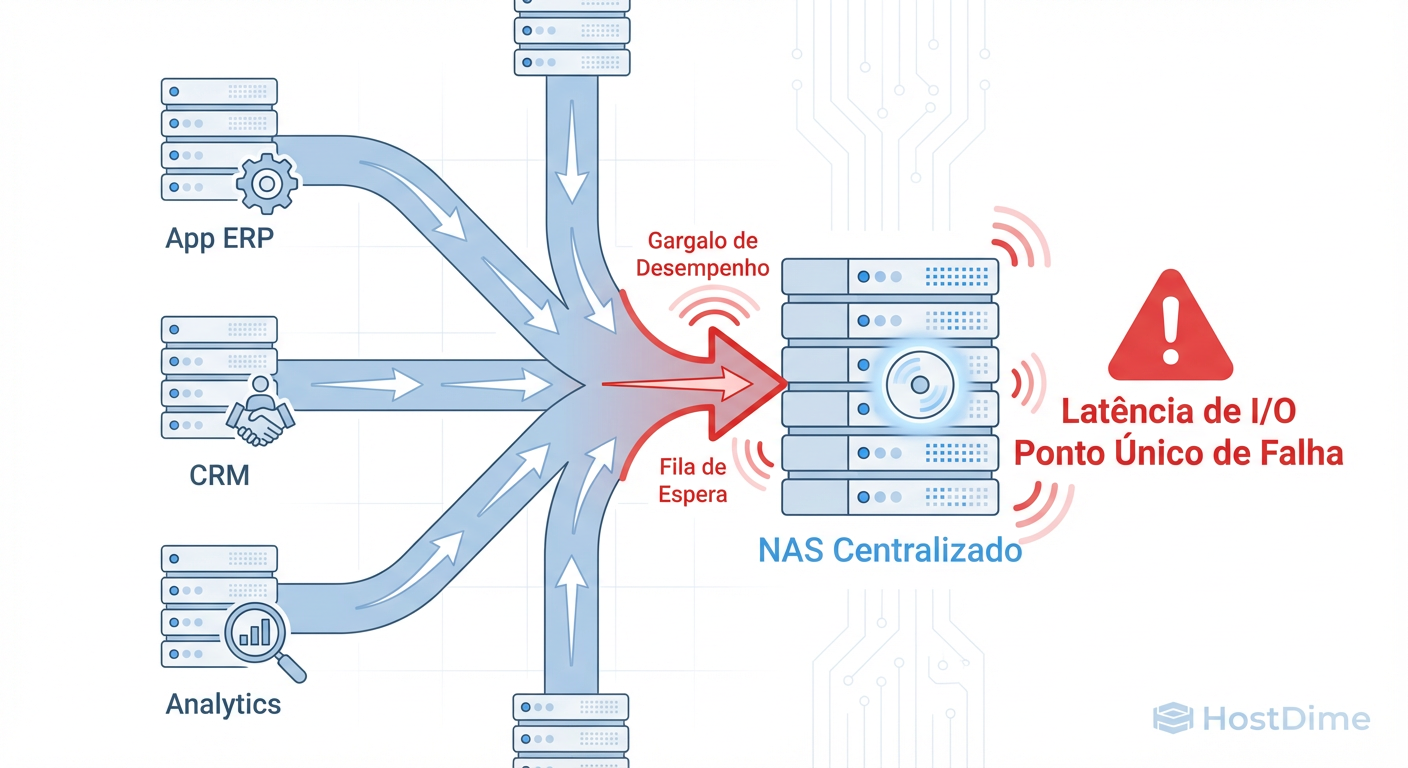

O problema central não é apenas a capacidade de disco, mas o acoplamento de I/O. Em um ambiente on-premise tradicional ou mesmo em um Lift & Shift ingênuo para a nuvem, o controlador do NAS é um ponto único de estrangulamento. À medida que você escala horizontalmente suas aplicações (adicionando mais nós de computação), todas elas competem pela mesma fila de I/O e largura de banda de rede do appliance de armazenamento.

Figura: Fig. 1: O gargalo de I/O e risco de disponibilidade em arquiteturas centradas puramente em NAS monolítico.

Figura: Fig. 1: O gargalo de I/O e risco de disponibilidade em arquiteturas centradas puramente em NAS monolítico.

Além da performance, enfrentamos o problema dos silos de dados. Dados presos em um NAS são difíceis de indexar, difíceis de analisar por ferramentas de Machine Learning modernas e caros para replicar geograficamente para fins de Disaster Recovery (DR). O TCO (Total Cost of Ownership) dispara à medida que você é forçado a comprar hardware de alta performance para armazenar dados que, em 80% dos casos, são "frios" (pouco acessados).

Opções Arquiteturais: Do Scale-up Físico ao Gateway Híbrido

Ao desenhar uma solução para sair desse cenário, temos três caminhos arquiteturais predominantes. Cada um possui um perfil de risco e retorno distinto.

1. Scale-up Tradicional (O Caminho da Menor Resistência)

A abordagem mais conservadora é simplesmente comprar um NAS maior e mais rápido (All-Flash Arrays).

Prós: Zero mudança na aplicação; performance previsível.

Contras: CapEx elevadíssimo; resolve o problema temporariamente; não habilita capacidades de nuvem (analytics, serverless); mantém o dado em silo.

2. Refatoração Nativa para Object Storage (O Caminho Idealista)

Reescrever a camada de persistência da aplicação para usar SDKs de nuvem (ex: AWS SDK, Azure Blob Storage Client).

Prós: Escalabilidade infinita; custo por GB baixíssimo; arquitetura stateless.

Contras: Custo de engenharia proibitivo para sistemas legados; risco alto de bugs de regressão; tempo de go-to-market lento.

3. Gateway de Armazenamento Híbrido (O Caminho Pragmático)

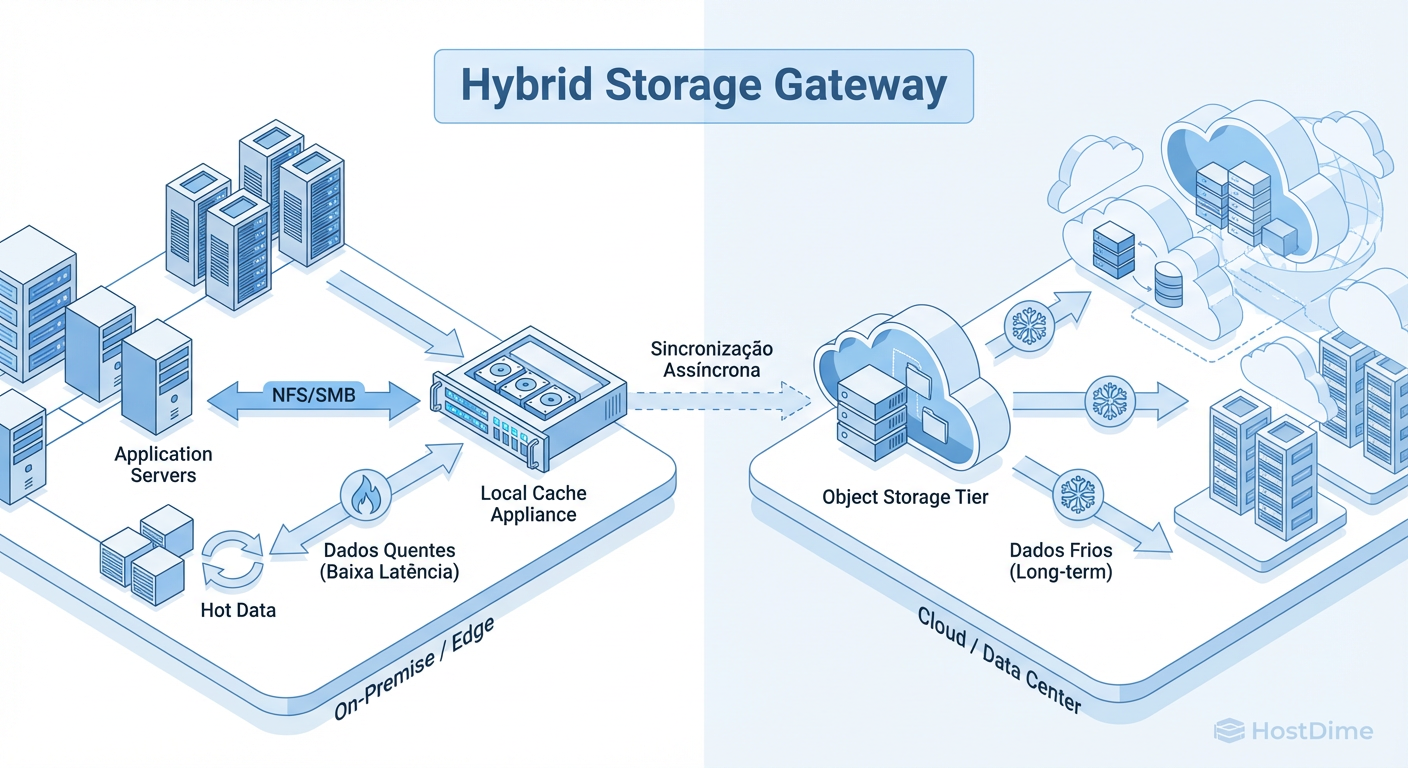

Utilizar um dispositivo (físico ou virtual) que atua como uma interface de protocolo. A aplicação "vê" um sistema de arquivos NFS/SMB local, mas o Gateway traduz essas chamadas para objetos e os armazena na nuvem, mantendo um cache local dos dados quentes.

Prós: Compatibilidade POSIX imediata; TCO reduzido via tiering automático; escalabilidade de backend infinita.

Contras: Introduz um componente de gerenciamento intermediário; latência no cache miss (primeiro acesso ao dado frio).

Para a maioria das empresas Enterprise que possuem dívida técnica, a Opção 3 é a única que equilibra a necessidade de modernização com a realidade orçamentária.

Análise de Trade-offs: Compatibilidade POSIX vs. Escalabilidade de Object Storage

Aqui reside o cerne técnico da decisão. Desenvolvedores acostumados com sistemas de arquivos locais muitas vezes subestimam a complexidade de migrar para Object Storage.

O padrão POSIX (Portable Operating System Interface) define regras estritas sobre como os arquivos são lidos e gravados. Ele garante consistência forte, suporte a byte-range locks e operações de metadados atômicas (como renomear diretórios). O Object Storage, por outro lado, foi desenhado para a web: ele é baseado em HTTP, geralmente oferece consistência eventual (embora provedores como AWS S3 agora ofereçam consistência forte) e trata arquivos como objetos imutáveis. Você não "edita" um objeto; você o substitui.

Ao adotar uma estratégia de migração, é vital entender o que se ganha e o que se perde.

Figura: Fig. 3: Matriz de Trade-offs. O Gateway oferece o equilíbrio ideal entre esforço de migração e benefícios de escalabilidade.

Figura: Fig. 3: Matriz de Trade-offs. O Gateway oferece o equilíbrio ideal entre esforço de migração e benefícios de escalabilidade.

A tabela acima ilustra por que a refatoração total é tão temida. Tentar emular comportamento POSIX (como locking de arquivos) em uma aplicação distribuída usando Object Storage é uma receita para condições de corrida e corrupção de dados, a menos que seja feito com extremo cuidado (ex: usando DynamoDB para controle de leases).

O Gateway Híbrido abstrai essa complexidade. Ele gerencia o locking e a consistência localmente ou no nível do cluster de gateways, permitindo que a aplicação continue operando como se estivesse em um disco local, enquanto o Gateway cuida da tradução assíncrona para a nuvem.

Decisão Recomendada: A Estratégia do "Estrangulamento" de Dados (Data Strangler Pattern)

Baseando-nos nos princípios de evolução arquitetural incremental, minha recomendação para cenários corporativos de grande escala é a adoção de uma Arquitetura de Gateway Híbrido como mecanismo para aplicar o Data Strangler Pattern.

Inspirado no padrão Strangler Fig de Martin Fowler — onde uma nova aplicação cresce ao redor da antiga até substituí-la — o Data Strangler permite que movamos o armazenamento para uma plataforma moderna sem que a aplicação perceba a mudança tectônica ocorrendo abaixo dela.

A Arquitetura Proposta

Nesta arquitetura, implementamos File Gateways (como AWS Storage Gateway ou soluções de parceiros como NetApp Cloud Volumes ONTAP ou CTERA) próximos à computação (seja on-premise ou na VPC).

Interface Local: O Gateway expõe montagens NFS/SMB padrão.

Cache Inteligente: O Gateway mantém os arquivos mais acessados (Hot Data) em disco local de alta performance (NVMe/SSD). Isso garante latência de milissegundos para as operações do dia a dia.

Backend Infinito: Os dados são gravados de forma assíncrona e durável em buckets de Object Storage (S3, Blob).

Metadados: O Gateway mantém a estrutura de diretórios e permissões (ACLs), projetando a ilusão de um sistema de arquivos completo, mesmo que os dados reais (o blob) já tenham sido movidos para camadas de arquivamento na nuvem.

Figura: Fig. 2: Arquitetura de Gateway Híbrido: Mantendo performance local (POSIX) enquanto escala a capacidade infinitamente no backend.

Figura: Fig. 2: Arquitetura de Gateway Híbrido: Mantendo performance local (POSIX) enquanto escala a capacidade infinitamente no backend.

Por que esta decisão vence?

Desacoplamento de Computação e Armazenamento: Diferente do NAS tradicional, onde você precisa escalar controladores para ter mais espaço, aqui o armazenamento escala infinitamente no S3, enquanto a performance (throughput/cache) escala adicionando recursos ao Gateway.

Redução Drástica de TCO: Políticas de ciclo de vida movem dados não acessados do cache local para a nuvem, e da nuvem quente (Standard) para camadas frias (Glacier/Archive). Você para de pagar preço de SSD para armazenar PDFs de 5 anos atrás.

Segurança e Durabilidade: O Object Storage oferece durabilidade de "onze noves" (99.999999999%), muito superior a qualquer RAID local, além de criptografia em repouso e em trânsito nativas.

Visão de Longo Prazo: Tiering Inteligente e Governança Multi-Cloud

A migração via Gateway não é o destino final; é o habilitador da plataforma de dados. Uma vez que seus dados residem em Object Storage (mesmo que acessados via protocolo de arquivo), você desbloqueia capacidades que o NAS nunca poderia oferecer.

O Fim dos Silos de Dados

Com os dados no Data Lake (via backend do Gateway), você pode acionar arquiteturas orientadas a eventos. Por exemplo, quando um arquivo PDF é salvo pelo sistema legado no drive mapeado Z:\, o Gateway o envia para o S3. Um evento S3:PutObject pode disparar uma função Lambda que lê esse objeto, extrai texto via OCR e insere os metadados em um banco de dados de busca (OpenSearch/Elasticsearch).

De repente, sua aplicação legada está alimentando um ecossistema de Analytics moderno sem que uma única linha de código do legado tenha sido alterada.

Governança e Tiering Automatizado

No longo prazo, a gestão manual de volumes desaparece. Utilizamos Intelligent Tiering para analisar padrões de acesso. Dados que não são tocados por 30 dias movem-se automaticamente para camadas de acesso infrequente, reduzindo o custo em até 40%. Dados de conformidade (retenção de 10 anos) vão para camadas de arquivamento profundo, custando centavos por TB.

Veredito Técnico

A migração de NAS para uma Plataforma de Dados não exige uma reescrita hercúlea "Big Bang". Ao utilizar Gateways Híbridos como uma camada de abstração, aplicamos o princípio de engenharia de dividir para conquistar: resolvemos o problema de armazenamento e custo primeiro, mantendo a estabilidade da aplicação.

Isso nos compra o tempo e o orçamento necessários para, eventualmente, refatorar as aplicações em seu próprio ritmo, ou talvez, descobrir que com a performance e escalabilidade resolvidas pelo Gateway, a refatoração nem seja mais necessária. Como Werner Vogels costuma dizer: "Undifferentiated heavy lifting" (trabalho pesado indiferenciado) deve ser delegado à plataforma. Gerenciar arrays de discos físicos em 2026 é exatamente isso.

Referências

Fowler, M. (2004). Strangler Fig Application. MartinFowler.com. Disponível em: martinfowler.com

Amazon Web Services. (2024). Hybrid Cloud Storage with AWS Storage Gateway. AWS Whitepaper.

Vogels, W. (2022). All Things Distributed: The importance of event-driven architectures.

IEEE. (2018). POSIX.1-2017 - IEEE Standard for Information Technology--Portable Operating System Interface (POSIX).

Fielding, R. T. (2000). Architectural Styles and the Design of Network-based Software Architectures (REST Dissertation). University of California, Irvine.

Julian Vance

Futurista de Tecnologia

"Exploro as fronteiras da infraestrutura, do armazenamento em DNA à computação quântica. Ajudo líderes a decodificar o horizonte tecnológico e construir o datacenter de 2035 hoje."