Dimensionamento de Special VDEVs no ZFS: A Matemática da Performance Híbrida

Guia avançado de planejamento de capacidade para ZFS Special VDEVs. Aprenda a calcular a proporção ideal de metadados, reduzir latência e otimizar TCO em pools híbridos.

Dimensionamento de Special VDEVs no ZFS: A Matemática da Performance Híbrida

A lei de Moore aplicou-se generosamente à densidade de área dos pratos magnéticos, mas falhou em acelerar a física newtoniana dos braços atuadores. Estamos diante de uma divergência assintótica: enquanto a capacidade dos discos rígidos (HDD) escala verticalmente, o IOPS por Terabyte (IOPS/TB) decai em uma curva inversa. Ao projetar sistemas de armazenamento ZFS na escala de Petabytes, confiar apenas no cache em RAM (ARC) ou em SSDs de leitura (L2ARC) não é mais suficiente para mitigar a latência estocástica dos discos mecânicos.

A introdução da Allocation Class (conhecida como Special VDEV) no OpenZFS alterou fundamentalmente a equação de desempenho. Não estamos mais limitados a um cache efêmero; agora possuímos uma camada de persistência dedicada para metadados e pequenos blocos. No entanto, dimensionar esse vdev não é uma arte, é um problema de teoria das filas e previsão de capacidade. Um erro de cálculo aqui não resulta apenas em desperdício de CAPEX, mas em um "precipício de performance" catastrófico quando o vdev transborda.

Resumo em 30 segundos

- Segregação Física: O Special VDEV isola metadados (ponteiros, atributos) e pequenos arquivos em flash, deixando os HDDs apenas para streaming sequencial de dados brutos.

- A Regra Quebrada dos 0,3%: A estimativa padrão de que metadados ocupam 0,3% da capacidade total é perigosa se você ativar o armazenamento de pequenos blocos (

special_small_blocks).- Risco de Falha Única: Se o Special VDEV falhar, todo o pool ZFS é perdido. A redundância aqui deve ser superior à do vdev de dados (ex: espelhamento triplo).

O paradoxo da densidade e a inflação do IOPS

Considere um pool ZFS composto por discos de 22 TB. A densidade de dados é massiva, mas a capacidade de buscar um bloco aleatório (seek time) permanece estagnada em torno de 100 a 150 IOPS por atuador. Quando o sistema de arquivos precisa percorrer árvores de metadados para localizar um arquivo, ele gera uma tempestade de I/O aleatório. Em um cenário puramente mecânico, isso satura os atuadores, elevando a latência de serviço a níveis inaceitáveis.

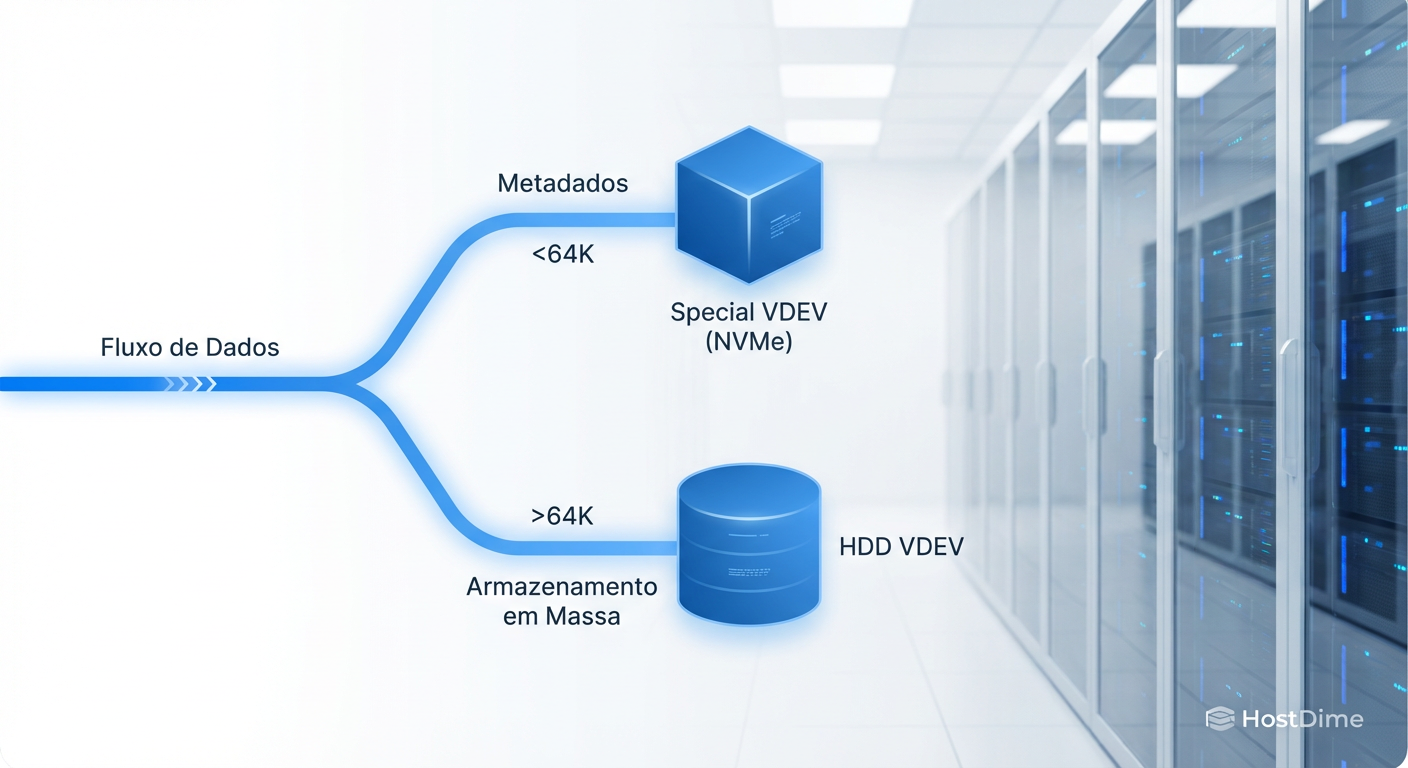

O Special VDEV resolve isso movendo a tabela de alocação e os metadados para mídia de estado sólido (NVMe ou SAS SSD). Isso transforma o perfil de acesso aos HDDs: em vez de "thrashing" (o braço do disco batendo freneticamente), os discos mecânicos passam a operar quase exclusivamente em gravações e leituras sequenciais, onde sua eficiência é máxima.

Fig. 1: Segregação física de I/O baseada na classe de alocação.

Fig. 1: Segregação física de I/O baseada na classe de alocação.

💡 Dica Pro: Para cargas de trabalho de virtualização (VMware/Proxmox sobre iSCSI ou NFS), o ganho de performance ao descarregar metadados é perceptível, mas o ganho real ocorre ao configurar o

special_small_blockspara cobrir o tamanho do bloco da volblocksize (ex: 4K ou 8K). Isso move todo o I/O aleatório das VMs para o flash.

A latência de cauda na travessia de metadados

Em sistemas distribuídos e armazenamento de alta performance, a métrica média é irrelevante. O que mata a experiência do usuário e quebra SLAs é a latência de cauda (o percentil 99 ou p99). No ZFS, operações de ls, find ou du em diretórios com milhões de arquivos exigem a leitura de blocos de diretório e dnodes.

Se esses metadados residem em HDDs, a latência é dominada pelo tempo de busca mecânica. Cada nível de indireção no ZFS (que é uma árvore de Merkle) adiciona uma penalidade de latência cumulativa. Ao mover esses dados para um Special VDEV baseado em NVMe, reduzimos a latência de acesso de milissegundos para microssegundos.

A modelagem aqui deve considerar a taxa de chegada de requisições de metadados ($\lambda$) versus a taxa de serviço do dispositivo ($\mu$). Dispositivos flash possuem um $\mu$ ordens de magnitude superior, mantendo o sistema longe do ponto de saturação onde as filas crescem exponencialmente.

Fig. 2: A 'Cauda Longa' do armazenamento: onde o IOPS custa mais caro que a capacidade.

Fig. 2: A 'Cauda Longa' do armazenamento: onde o IOPS custa mais caro que a capacidade.

A matemática dos 0,3% e a variável dos pequenos blocos

A literatura clássica do ZFS sugere uma regra de ouro: metadados ocupam aproximadamente 0,3% do espaço total do pool. Para um pool de 100 TB, seriam necessários 300 GB de Special VDEV.

No entanto, essa heurística falha miseravelmente em dois cenários comuns:

Alta contagem de arquivos: Se o tamanho médio do arquivo for minúsculo (ex: 10 KB), a proporção de metadados em relação aos dados sobe drasticamente.

Uso de

special_small_blocks: Esta é a variável crítica. Se configurarmos o ZFS para armazenar todos os arquivos menores que 32K no Special VDEV, não estamos mais armazenando apenas metadados; estamos criando um tiering híbrido de dados.

A fórmula de dimensionamento deve ser ajustada para:

$$Capacidade_{Special} = (Capacidade_{Total} \times R_{meta}) + \sum (Arquivos < T_{threshold})$$

Onde $R_{meta}$ é a razão de metadados (base 0,3%, ajustável por recordsize) e $T_{threshold}$ é o limite configurado em special_small_blocks.

⚠️ Perigo: Se o Special VDEV atingir 100% de ocupação, o ZFS começará a escrever novos metadados e pequenos blocos nos HDDs lentos. Isso cria uma degradação de performance não linear. O sistema não fica apenas "um pouco mais lento"; ele colide com um muro de latência, pois a estratégia de alocação se fragmenta entre mídias de velocidades opostas. Recomenda-se dimensionar o vdev para nunca ultrapassar 75% de ocupação.

Arquitetura de persistência: O imperativo do espelhamento triplo

Diferente do L2ARC (Cache de Leitura Nível 2), que pode falhar sem perda de dados (o sistema apenas lê do disco), o Special VDEV é parte integrante da estrutura do pool. Se você perder o Special VDEV, você perde o pool inteiro. Não há recuperação possível, pois os ponteiros que dizem onde os dados estão nos discos mecânicos residem agora no flash perdido.

Por isso, a redundância do Special VDEV deve ser igual ou superior à dos vdevs de dados.

Se seus dados estão em RAID-Z2 (tolerância a 2 falhas), um espelhamento simples (2-way mirror) para o Special VDEV é estatisticamente arriscado.

SSDs do mesmo lote comprados juntos tendem a falhar em momentos próximos devido ao desgaste de escrita uniforme (wear-leveling).

A recomendação matemática para disponibilidade de "cinco noves" (99,999%) neste cenário é o espelhamento triplo (3-way mirror). Embora custoso em termos de slots NVMe/SATA, é o seguro necessário contra a perda total de petabytes de dados.

Além disso, o uso de SSDs com Power Loss Protection (PLP) é mandatório. O ZFS depende de transações atômicas. SSDs de consumo (gamers) mentem para o sistema operacional sobre a confirmação de gravação para inflar benchmarks. Numa queda de energia, metadados em voo podem ser corrompidos. Em um Special VDEV, isso é fatal.

Fast Dedup e a vantagem competitiva do armazenamento híbrido

A deduplicação no ZFS sempre foi um recurso polarizador. Historicamente, exigia quantidades obscenas de RAM (aproximadamente 5 GB de RAM por TB de dados deduplicados) para manter a DDT (Dedup Table) na memória. Caso a DDT vazasse para o disco, a performance caía para níveis inutilizáveis.

Com o advento do Fast Dedup (recurso emergente no OpenZFS 2.3+), a lógica muda. O Fast Dedup permite que a Tabela de Deduplicação seja armazenada e consultada eficientemente no Special VDEV, sem a necessidade de residir inteiramente na RAM.

Isso altera o cálculo de ROI (Retorno sobre Investimento). Ao investir em Special VDEVs de alta resistência (DWPD alto) e baixa latência (como Intel Optane ou NVMe Enterprise), habilitamos a deduplicação em datasets que antes eram proibitivos. O custo do flash é amortizado pela economia massiva de espaço nos HDDs mecânicos.

Fig. 3: Otimização de CAPEX mantendo a performance de metadados próxima ao All-Flash.

Fig. 3: Otimização de CAPEX mantendo a performance de metadados próxima ao All-Flash.

Em um cenário de backup ou armazenamento de contêineres, onde a redundância de dados é alta, o Special VDEV não atua apenas como acelerador, mas como um multiplicador de capacidade lógica.

Previsão e Modelagem

O planejador de capacidade moderno não deve olhar para o armazenamento como um balde estático, mas como um sistema dinâmico de fluxos. A implementação de Special VDEVs é a resposta matemática para a latência intrínseca da física rotacional.

Não inicie uma implementação baseada em "instinto". Analise a distribuição atual de tamanho de arquivos (histogramas são seus amigos), calcule a taxa de crescimento de metadados e projete o Special VDEV com uma margem de segurança de 25% acima da demanda prevista para os próximos 3 anos. O custo do flash é alto, mas o custo da latência operacional em um pool de HDDs saturado é, invariavelmente, ordens de magnitude maior. Modele o crescimento, segregue o I/O e garanta que a persistência dos seus metadados seja tão robusta quanto a integridade dos seus dados.

Perguntas Frequentes

1. Posso adicionar um Special VDEV a um pool existente?

Sim, você pode adicionar um Special VDEV a um pool ZFS já em produção. No entanto, os metadados existentes nos HDDs não serão movidos automaticamente para o novo vdev. Apenas novos dados escritos (ou reescritos via zfs send/recv ou rebalanceamento) usarão o Special VDEV.

2. O que acontece se o Special VDEV encher?

Diferente do L2ARC, que apenas para de fazer cache, o Special VDEV é armazenamento primário. Se ele encher, o ZFS voltará a escrever metadados e pequenos blocos nos vdevs de dados (HDDs). Isso causará uma queda abrupta de performance e fragmentação, mas o sistema continuará funcionando. O perigo real é a dificuldade de esvaziá-lo depois.

3. Qual a diferença entre Special VDEV e L2ARC?

O L2ARC é um cache de leitura redundante; se falhar, nada acontece com os dados. Ele popula com base no uso (arquivos mais acessados). O Special VDEV é armazenamento persistente e autoritativo; ele armazena tipos específicos de dados (metadados, arquivos pequenos) baseados em regras, independentemente da frequência de acesso.

4. SSDs SATA são suficientes ou preciso de NVMe?

Para a maioria dos "Home Labs" e pequenas empresas, SSDs SATA Enterprise são suficientes para saturar a rede de 10GbE. No entanto, para ambientes Enterprise com All-Flash ou arranjos de HDDs massivos (60+ discos), a latência do protocolo NVMe é necessária para lidar com a profundidade de fila (Queue Depth) gerada por operações intensivas de metadados.

5. Posso remover um Special VDEV?

Geralmente, não. Em versões recentes do OpenZFS, existe suporte preliminar para remoção de vdevs de espelhamento (mirrors), o que permite evacuar os dados do Special VDEV de volta para os HDDs, desde que haja espaço e memória suficientes para o mapeamento. Contudo, é uma operação de alto risco e intensiva. O dimensionamento correto inicial é crucial.

Roberto Sato

Planejador de Capacidade

"Traduzo métricas de consumo em modelos de crescimento sustentável. Minha missão é antecipar gargalos e garantir que sua infraestrutura escale matematicamente antes de atingir o limite crítico."