Form Factors de Armazenamento: Do 3.5" ao EDSFF e o Fim do M.2 no Datacenter

Entenda a sopa de letrinhas física do storage (LFF, SFF, M.2, U.2, U.3, EDSFF). Descubra por que o formato E1.S é o futuro e como evitar gargalos térmicos em servidores.

Se você abriu um chassi de servidor 1U ou 2U recentemente, provavelmente notou que a paisagem interna mudou drasticamente. Onde antes víamos fileiras uniformes de gavetas de 3.5 polegadas ou o padrão 2.5 polegadas dominando a frente, agora temos uma "sopa de letrinhas" física e térmica. Estamos falando de dissipadores de calor que parecem radiadores de moto, cabos MCIO substituindo os velhos SAS e formatos que desafiam a geometria tradicional.

A transição do protocolo SAS/SATA para o NVMe não foi apenas uma mudança de velocidade lógica; foi um terremoto mecânico. O formato físico que serviu bem aos HDDs mecânicos por décadas tornou-se um gargalo térmico para o silício de alta performance. Se você ainda está projetando seus servidores de armazenamento baseados apenas em slots M.2 adaptados ou insistindo que o formato 2.5 polegadas (U.2) será eterno, você está construindo infraestrutura legada no dia zero.

Resumo em 30 segundos

- M.2 não é para Datacenter: A falta de Hot-Swap, a ausência de LEDs de status nativos e a incapacidade de dissipar 20W+ sem estrangular (throttling) tornam o M.2 inviável para servidores de alta densidade.

- Térmica dita o Formato: Com SSDs PCIe Gen5 ultrapassando 25W de TDP, o formato físico precisa agir como parte do sistema de refrigeração. O formato 2.5" tradicional bloqueia o fluxo de ar; o EDSFF (E1.S) o canaliza.

- O Futuro é a Régua (Ruler): O padrão EDSFF (Enterprise & Data Center Standard Form Factor) não é apenas uma mudança estética; é a engenharia necessária para densidade de Petabytes em 1U sem derreter a controladora.

O sintoma térmico e a confusão dos conectores físicos

Antigamente, a preocupação térmica no armazenamento era manter os discos rígidos abaixo de 40°C para evitar falhas mecânicas nos rolamentos. Hoje, estamos lidando com controladores NVMe que operam confortavelmente a 70°C, mas que entram em proteção térmica (throttling) agressiva ao atingir 80°C ou mais.

O problema é que a densidade energética aumentou. Um SSD NVMe PCIe Gen4 de alta performance consome cerca de 14W a 18W. A nova geração PCIe Gen5 salta para 25W ou mais. Coloque 24 desses drives na frente de um chassi 2U e você tem 600 Watts de calor gerado apenas pelo armazenamento, antes mesmo de o ar chegar às CPUs.

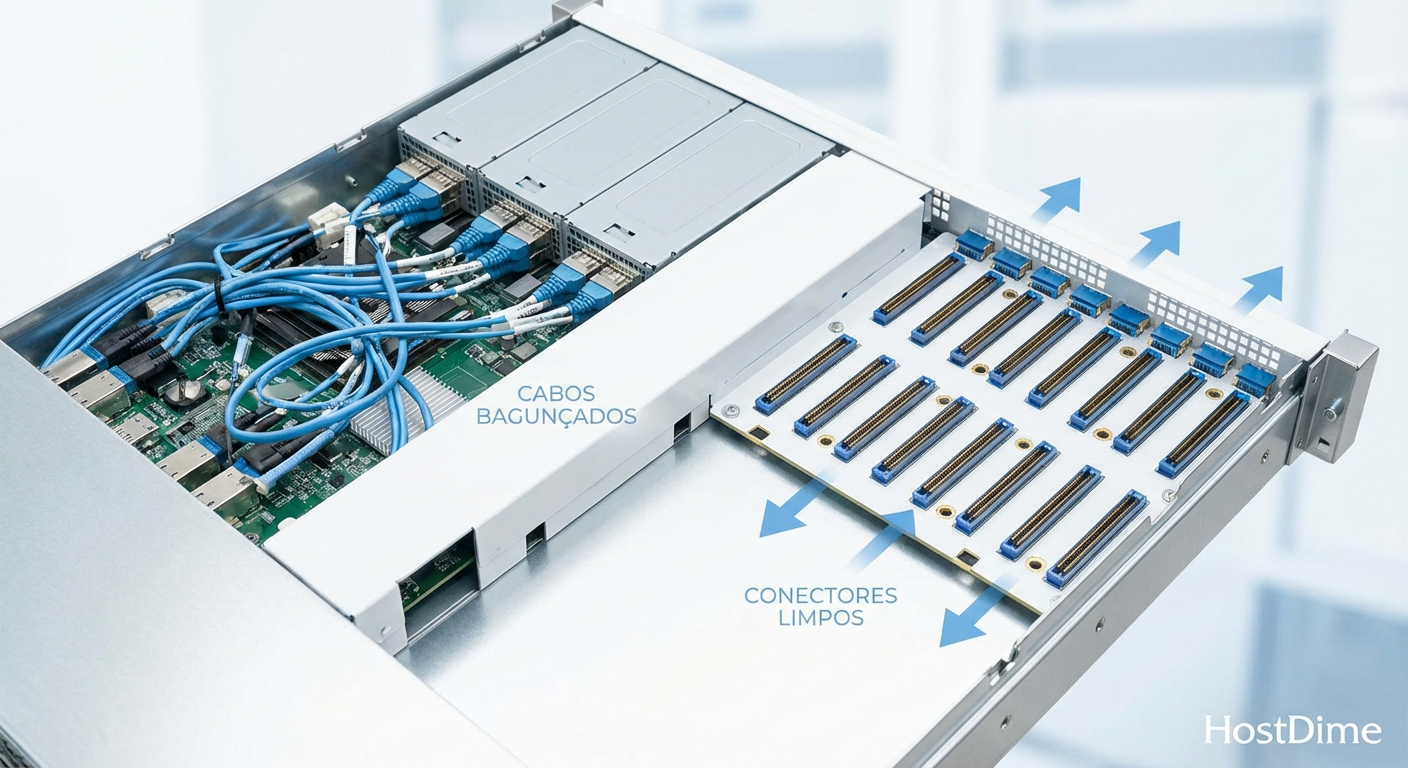

Isso criou uma crise de conectores. O velho conector SAS (SFF-8482) evoluiu para o U.2 (SFF-8639), que é robusto, mas volumoso. Tentativas de usar cabos internos para rotear esse sinal resultaram em pesadelos de gerenciamento de cabos com SlimSAS e, mais recentemente, MCIO (Mini Cool Edge IO), que são frágeis e propensos a desconexões se você olhar torto para eles durante uma manutenção.

Figura: Comparação visual: A complexidade do cabeamento MCIO vs a limpeza de um backplane EDSFF direto.

Figura: Comparação visual: A complexidade do cabeamento MCIO vs a limpeza de um backplane EDSFF direto.

A anatomia do problema: Geometria, pinagem e o limite do fluxo de ar

Para entender por que estamos abandonando formatos antigos, precisamos olhar para a física do fluxo de ar (Airflow).

O bloqueio do 2.5 polegadas (U.2)

O formato de 2.5 polegadas foi herdado dos HDDs de notebook. Ele é um "tijolo" retangular. Quando você empilha 10 ou 24 desses na frente de um servidor, você cria uma parede quase sólida. O ar precisa passar pelas frestas minúsculas entre os caddies (gavetas). Para resfriar componentes de 25W atrás dessa parede, as ventoinhas do chassi precisam girar a 10.000+ RPM, criando ruído ensurdecedor e desperdiçando energia (visto que ventoinhas seguem a lei do cubo para consumo de energia vs rotação).

A fragilidade do M.2

O M.2 (anteriormente NGFF) é fantástico para seu laptop ou workstation. No datacenter, ele é um pesadelo operacional.

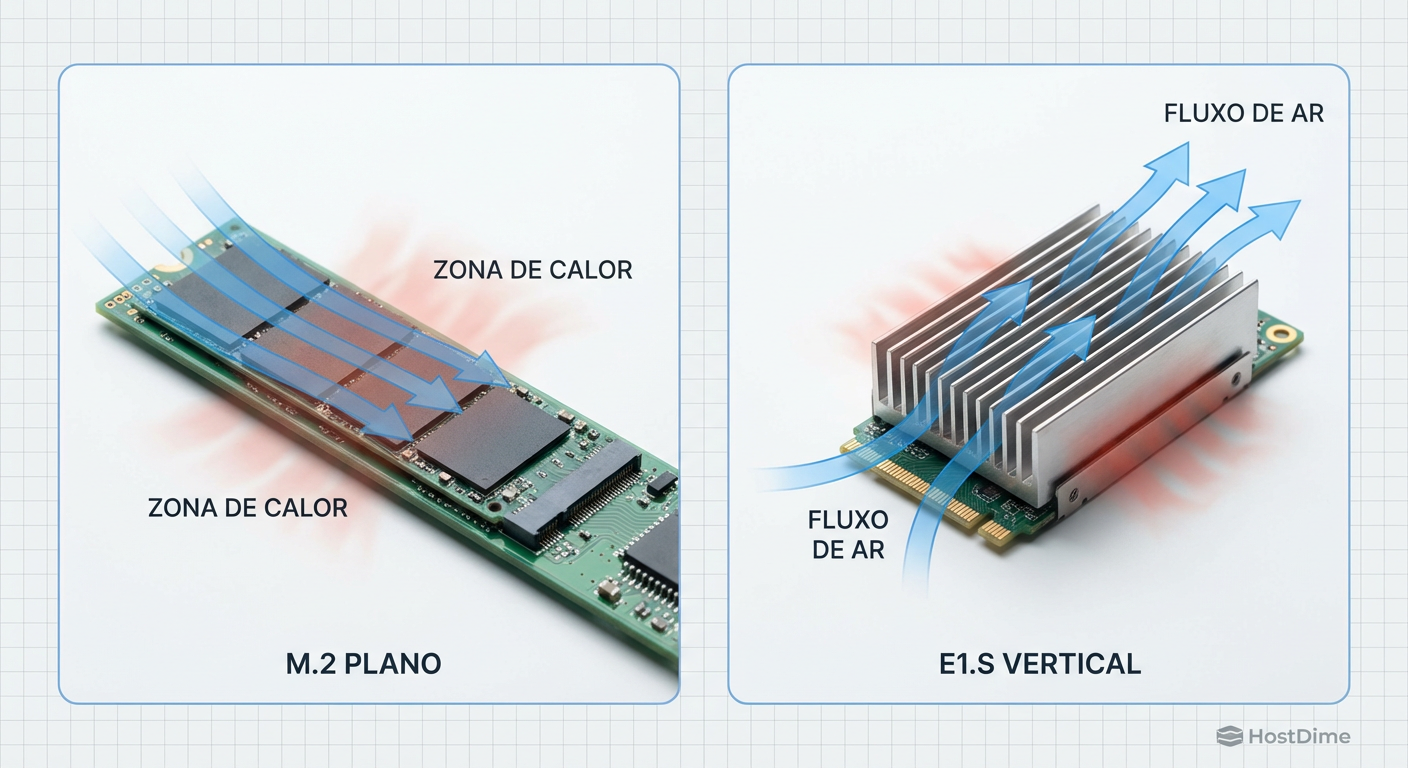

Montagem: Ele fica deitado na placa-mãe ou em risers. O ar passa por cima dele, mas raramente por baixo, criando pontos quentes no controlador.

Manutenção: Para trocar um disco com falha, você precisa desligar o servidor, abrir a tampa, desparafusar um dissipador minúsculo e lidar com um parafuso microscópico que adora cair dentro da fonte de alimentação. Não existe Hot-Swap real em M.2 nativo.

💡 Dica Pro: Se você vir um servidor "Enterprise" vendendo slots M.2 para armazenamento primário (não apenas boot), corra. É um design de consumidor glorificado. O custo operacional de substituir um drive (downtime) supera qualquer economia no custo do componente.

Tabela Comparativa: O Legado vs O Novo Padrão

| Característica | M.2 (2280/22110) | U.2 (2.5" SFF-8639) | EDSFF E1.S (Ruler) |

|---|---|---|---|

| Hot-Swap | Não (Nativo) | Sim | Sim |

| Dissipação Térmica | Baixa (Depende da MB) | Média (Case fechado) | Alta (Dissipador Integrado) |

| Capacidade Máxima (Atual) | ~8TB | ~30TB | ~30TB+ |

| Fluxo de Ar | Neutro/Ruim | Bloqueia fluxo | Otimiza/Canaliza |

| Sinalização (LEDs) | Inexistente | No Backplane | Integrado no Drive |

| Uso Ideal | Boot / Edge | Legado Enterprise | Datacenter Moderno |

A solução ingênua: Por que adaptadores M.2 em servidores são uma armadilha

É comum ver em Home Labs e até em pequenas empresas o uso de placas PCIe "Carrier" que bifurcam um slot x16 em quatro slots M.2 x4 (como as placas ASUS Hyper M.2). Embora funcione eletricamente, mecanicamente é desastroso para alta disponibilidade.

Além da falta de troca a quente, você perde a sinalização de banda lateral (Sideband Signals). Em um ambiente SAS/NVMe real, o backplane se comunica com a controladora para acender o LED de "Locate" (azul/branco) ou "Fault" (âmbar). Com adaptadores M.2, você não tem ideia física de qual disco falhou até remover a placa e ler o número de série no adesivo. Em um array ZFS com 20 discos, isso é roleta russa de dados.

Figura: Simulação de fluxo de ar (CFD): A estagnação térmica no M.2 horizontal vs a eficiência aerodinâmica do E1.S vertical.

Figura: Simulação de fluxo de ar (CFD): A estagnação térmica no M.2 horizontal vs a eficiência aerodinâmica do E1.S vertical.

A engenharia correta: A revolução EDSFF (E1.S e E3) e a evolução do U.3

A indústria (liderada por gigantes como Intel, Samsung, Meta e Microsoft através do OCP - Open Compute Project) criou o EDSFF (Enterprise & Data Center Standard Form Factor). A ideia não é adaptar discos de notebook, mas criar cartuchos de silício.

E1.S: A "Régua Curta" para 1U

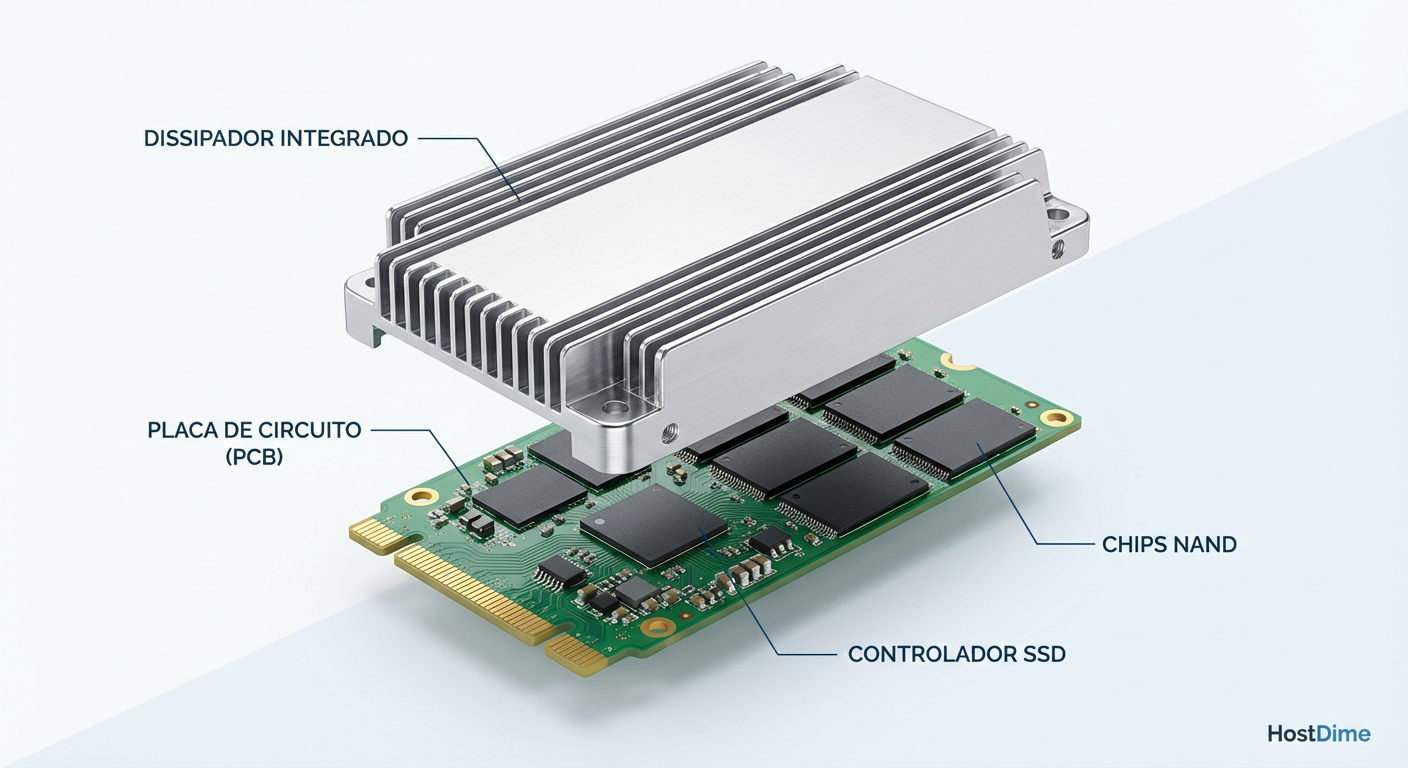

O formato E1.S é revolucionário porque o dissipador de calor faz parte da especificação do drive. Você não compra um SSD nu; você compra um cartucho de metal com aletas térmicas projetadas para alinhar com o fluxo de ar do chassi.

Vantagem: Permite colocar 32 drives em 1U (muito mais que os 10 drives U.2 tradicionais).

Refrigeração: O ar passa através dos drives, resfriando-os eficientemente sem bloquear o ar para as CPUs atrás.

E3: O sucessor do 2.5"

Para servidores 2U, o formato E3 (que parece um 2.5" mais alto e robusto) permite drives com TDPs ainda maiores (até 40W-70W), preparando o terreno para SSDs CXL e aceleradores de computação no futuro.

U.3: A ponte necessária

Enquanto o EDSFF é o futuro, o U.3 (SFF-TA-1001) é a transição inteligente. Fisicamente idêntico ao U.2, o U.3 simplifica a pinagem.

- Tri-mode: Um backplane U.3 pode aceitar drives SAS, SATA ou NVMe no mesmo slot, detectando automaticamente o protocolo. Isso reduz a complexidade de cabos e backplanes dedicados.

⚠️ Perigo: Cuidado com a compatibilidade U.2 vs U.3. Um drive U.3 geralmente funciona em um host U.2 (com adaptador), mas um drive U.2 antigo pode não funcionar em um host estritamente U.3 se o backplane não tiver a lógica de roteamento correta (embora a norma tente garantir retrocompatibilidade, a implementação dos fabricantes varia).

Figura: Vista explodida de um SSD E1.S: O silício é apenas metade do produto; a engenharia térmica do case é vital.

Figura: Vista explodida de um SSD E1.S: O silício é apenas metade do produto; a engenharia térmica do case é vital.

Validando a escolha: Densidade por rack e eficiência térmica (CFM)

Ao projetar um storage server hoje, a métrica não é mais apenas "Custo por TB", mas "TB por Watt" e "TB por Unidade de Rack (RU)".

Imagine um cenário de 1 Petabyte.

Com HDDs 3.5" (20TB): Você precisa de 50 discos. Isso ocupa cerca de 4U a 5U de espaço e pesa 40kg+.

Com SSDs U.2 (15TB): Você precisa de ~67 discos. Ocupa 3U (densidade padrão de 24 drives/2U).

Com SSDs E1.S (30TB): Você precisa de 34 discos. Isso cabe em um único servidor 1U, com sobra de espaço, e o fluxo de ar (CFM - Cubic Feet per Minute) necessário é menor do que no cenário U.2, pois os drives ajudam a laminar o fluxo de ar.

Essa densidade muda a economia do datacenter. Menos espaço de rack, menos energia gasta em ventoinhas lutando contra a pressão estática, e manutenção simplificada com mecanismos de trava robustos e LEDs claros.

Figura: Densidade Extrema: 32 drives E1.S em 1U vs 24 drives U.2 em 2U.

Figura: Densidade Extrema: 32 drives E1.S em 1U vs 24 drives U.2 em 2U.

Veredito Técnico

Estamos no fim da era dos formatos de "tamanho único". O M.2 deve ser banido de qualquer servidor de produção sério que não seja para o drive de boot do sistema operacional. O risco térmico e a inviabilidade de manutenção são altos demais.

Para armazenamento flash de alta performance, o EDSFF E1.S é o novo padrão ouro para densidade e térmica em 1U. Se você está comprando servidores novos (Gen5), exija suporte a EDSFF ou, no mínimo, backplanes U.3 para garantir flexibilidade futura.

O formato 3.5" (LFF) não vai a lugar nenhum — ele continua sendo imbatível para Cold Storage e Bulk Data onde o custo por TB reina supremo. Mas para qualquer coisa que exija IOPS e throughput, pare de lutar contra a física com formatos legados. Abrace a régua.

FAQ: Perguntas Frequentes

Posso usar um SSD U.2 em um backplane U.3 e vice-versa?

Depende da direção e da controladora. Discos U.3 são projetados para serem retrocompatíveis e geralmente funcionam em hosts U.2 (se o sistema suportar a detecção). Porém, discos U.2 antigos (Legacy) NÃO funcionam em hosts estritamente U.3 que esperam a pinagem consolidada, a menos que o backplane tenha lógica específica para remapear as linhas de dados e suportar o modo legado. Sempre verifique a HCL (Hardware Compatibility List) do fabricante.O formato 3.5 polegadas (LFF) morreu?

Não. Para armazenamento em massa (Bulk Storage) e Cold Data, o HDD de 3.5" ainda é rei absoluto em custo por TB. Com tecnologias como HAMR (Heat-Assisted Magnetic Recording), drives de 30TB+ mantêm esse form factor relevante para arquivamento e backup, enquanto o SSD domina a camada de performance.Qual a vantagem do formato E1.S (Ruler) sobre o M.2?

O E1.S foi desenhado nativamente para o datacenter, resolvendo todas as falhas do M.2. Ele possui dissipador de calor integrado (essencial para Gen5), suporta Hot-Swap (troca a quente) real com mecanismo de trava, e possui LEDs de status nativos. Além disso, seu formato vertical permite um fluxo de ar laminar muito superior em chassis 1U, ao contrário do M.2 que fica "sufocado" na placa-mãe.Referências & Leitura Complementar

SNIA SFF-TA-1006: Especificação técnica para o formato EDSFF E1.S.

SNIA SFF-TA-1001: Especificação para o conector universal U.3.

OCP Storage Workgroup: Documentação sobre perfis térmicos e mecânicos para Datacenters Hyperscale.

PCI-SIG: Especificações do barramento PCIe 5.0 e 6.0 e seus requisitos de integridade de sinal.

Carlos Ornelas

Mecânico de Datacenter

"Vivo nos corredores frios instalando racks e organizando cabeamento estruturado. Para mim, a nuvem é feita de metal, silício e ventoinhas que precisam girar sem parar."