HAMR, MAMR e a Sobrevivência dos HDDs: A Matemática do Storage em 2026

O HDD morreu? Não se você souber fazer as contas. Análise técnica sobre HAMR, densidade de 30TB+ e o trade-off crítico de IOPS/TB para arquiteturas de dados em 2026.

Há mais de uma década, analistas de mercado e fabricantes de Flash vêm prometendo a morte iminente do disco rígido mecânico. "Em 2020, o cruzamento de preço por gigabyte entre SSD e HDD tornará o disco obsoleto", diziam os gráficos extrapolados no Excel. Estamos caminhando para 2026 e, surpreendentemente, o HDD não apenas sobreviveu, como está prestes a dar seu maior salto evolutivo em vinte anos.

A realidade do datacenter enterprise ignora o hype. Ela é governada por uma métrica fria e implacável: TCO (Custo Total de Propriedade) aplicado à gravidade dos dados. Enquanto o SSD domina a performance, a humanidade gera dados mais rápido do que a indústria de semicondutores consegue fabricar NAND Flash a preços acessíveis. Para armazenar o "lago de dados" (Data Lake) e os backups imutáveis, a física magnética ainda é a rainha. Mas para chegar aos drives de 30TB, 50TB e futuramente 100TB, as regras da física tiveram que ser reescritas.

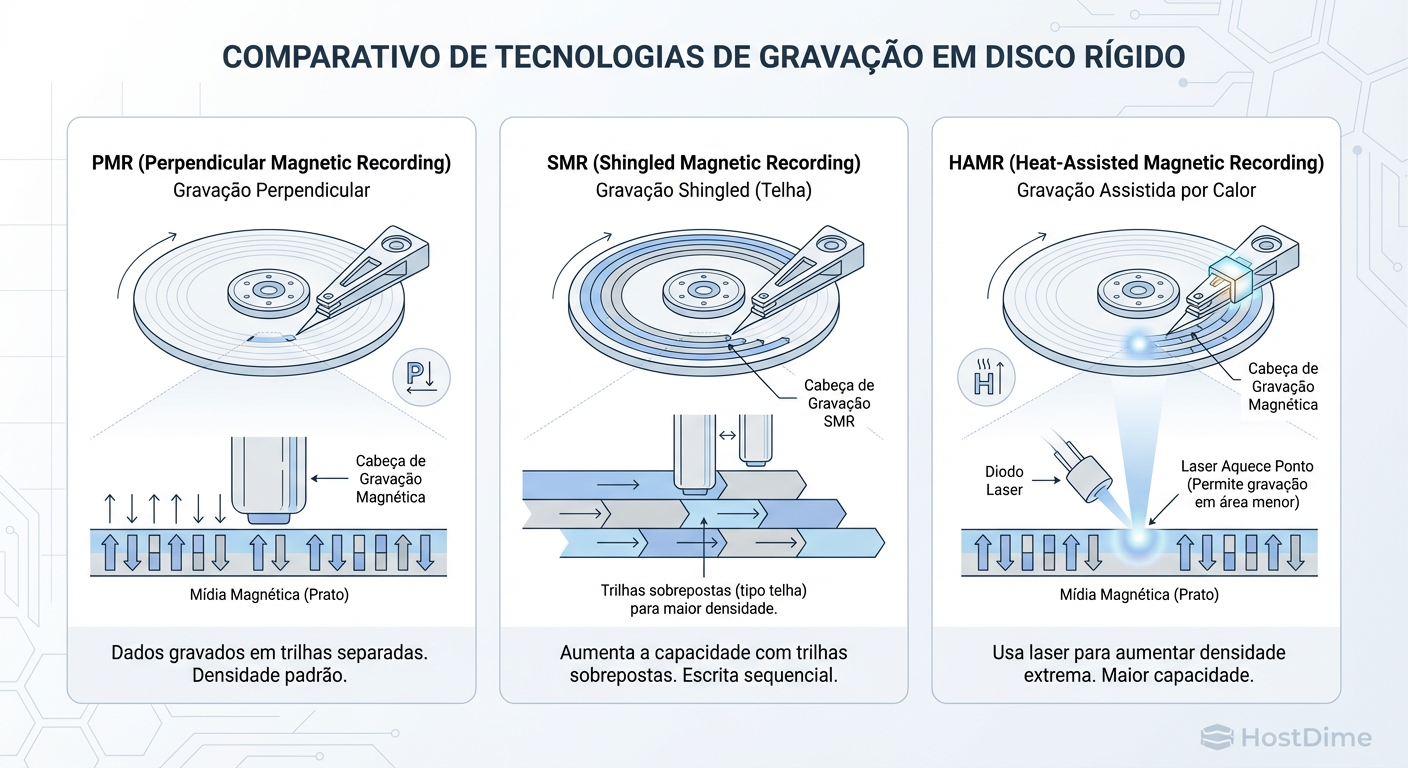

O que são HAMR e MAMR? HAMR (Heat-Assisted Magnetic Recording) e MAMR (Microwave-Assisted Magnetic Recording) são tecnologias de gravação que superam o limite superparamagnético dos HDDs convencionais. Elas permitem gravar bits menores e mais estáveis aquecendo o prato com um laser (HAMR) ou excitando-o com micro-ondas (MAMR) no momento exato da escrita, viabilizando densidades acima de 30TB por unidade.

A Falácia do "Flash Crossover" e o Custo do Ativo

O argumento de que o SSD mataria o HDD baseava-se na Lei de Moore aplicada à memória NAND. De fato, o SSD QLC (Quad-Level Cell) reduziu drasticamente os preços. No entanto, o HDD não ficou parado. A indústria de discos mecânicos respondeu com o aumento da densidade de área (areal density).

Para um arquiteto de soluções, a decisão entre All-Flash e Híbrido não é emocional, é aritmética. Em 2026, a projeção é que a diferença de custo por TB entre um SSD Enterprise QLC e um HDD Enterprise HAMR permaneça na casa de 5x a 7x.

Se você precisa armazenar 10 Petabytes de logs de conformidade que serão lidos raramente, a diferença de custo de capital (CapEx) é de milhões de dólares. O "Flash Crossover" é real para laptops e servidores de boot, mas para armazenamento em massa (Bulk Storage), o HDD mantém um fosso econômico defensável. O segredo não é substituir o HDD, mas saber exatamente onde ele parou de fazer sentido (latência) e onde ele é imbatível (capacidade).

A Física do HAMR: Gravando com Lasers sem Derreter o Drive

Para entender por que precisamos de lasers dentro de um disco rígido, precisamos entender o Trilema da Gravação Magnética.

Para aumentar a capacidade, precisamos diminuir o tamanho dos grãos magnéticos (os bits). Porém, se os grãos forem pequenos demais, eles se tornam termicamente instáveis e podem virar sozinhos (perda de dados). Para torná-los estáveis, precisamos usar materiais com alta coercividade (dureza magnética). Mas se o material for muito "duro", a cabeça de gravação não consegue gerar um campo magnético forte o suficiente para escrever os dados.

Figura: Evolução da Escrita Magnética: De trilhas largas ao aquecimento localizado do HAMR para superar o limite superparamagnético.

Figura: Evolução da Escrita Magnética: De trilhas largas ao aquecimento localizado do HAMR para superar o limite superparamagnético.

Aqui entra o HAMR. A cabeça de gravação possui um diodo laser microscópico.

Aquecimento: O laser aquece um ponto minúsculo do prato a 400°C+ em menos de um nanossegundo.

Escrita: O calor reduz temporariamente a coercividade do material, permitindo que a cabeça magnética grave o bit facilmente.

Resfriamento: O ponto esfria instantaneamente, "congelando" o bit em um estado superestável.

O MAMR segue uma lógica similar, mas usa um oscilador de torque de spin para gerar micro-ondas que facilitam a inversão magnética, sem o estresse térmico extremo do HAMR. A indústria parece estar convergindo para o HAMR como a solução de longo prazo para drives de 50TB+, enquanto o MAMR serviu como uma ponte tecnológica.

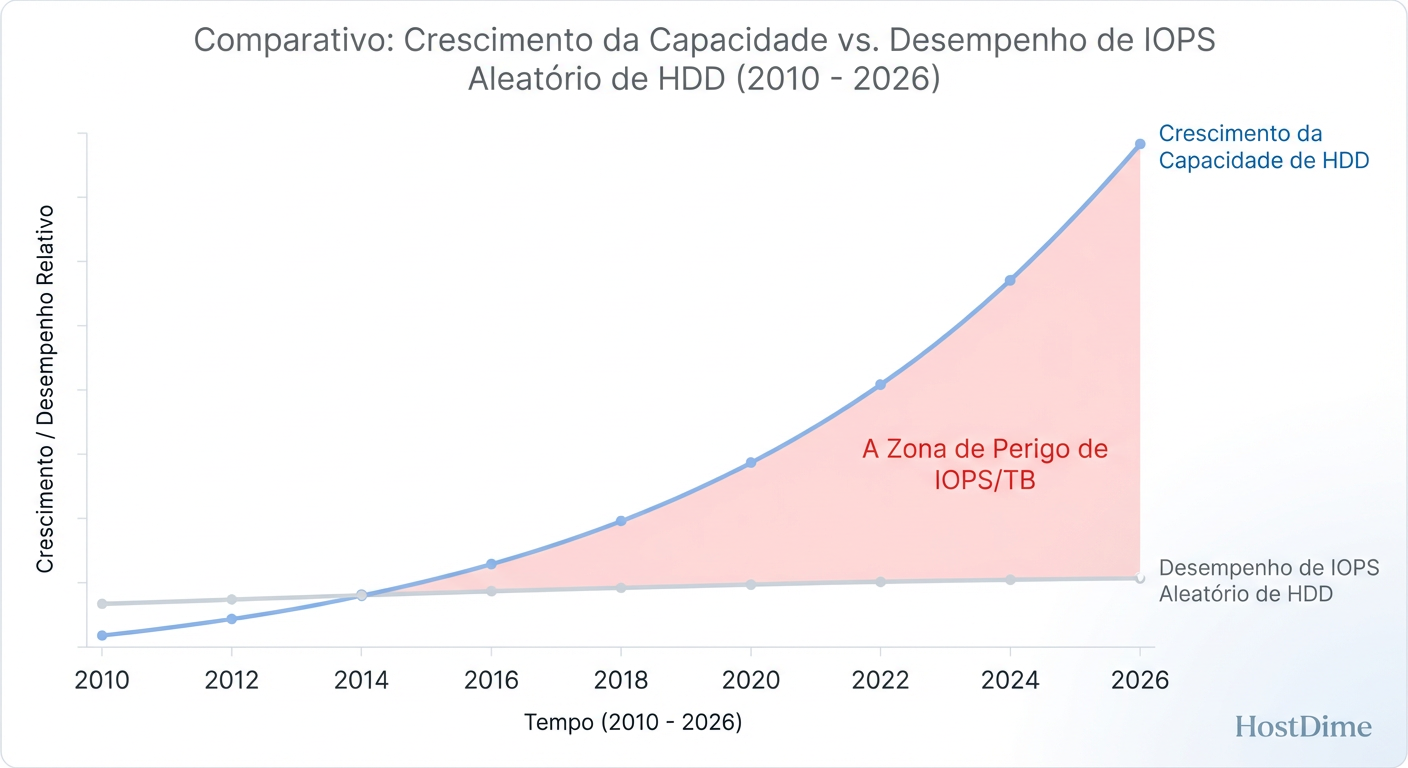

O Abismo do IOPS/TB em Drives de Alta Densidade

Aqui reside o maior risco para o arquiteto desatento. A capacidade dos discos explodiu, mas a velocidade mecânica estagnou. Um disco de 4TB gira a 7200 RPM. Um disco de 30TB HAMR também gira a 7200 RPM.

Isso cria o que chamo de Abismo do IOPS/TB.

HDD 4TB: ~80 IOPS aleatórios / 4 TB = 20 IOPS/TB

HDD 30TB: ~80 IOPS aleatórios / 30 TB = 2.6 IOPS/TB

A densidade de IOPS cai drasticamente. Se você encher um drive de 30TB com dados acessados aleatoriamente, a latência vai disparar para a estratosfera. O drive passará a maior parte do tempo buscando dados (seek time) e quase nenhum tempo transferindo dados.

Figura: O Abismo do IOPS/TB: Enquanto a capacidade explode com o HAMR, a física mecânica limita a performance, exigindo novas arquiteturas.

Figura: O Abismo do IOPS/TB: Enquanto a capacidade explode com o HAMR, a física mecânica limita a performance, exigindo novas arquiteturas.

Como medir esse gargalo:

Não confie na folha de especificações. Use o fio para simular a carga real em um disco de alta densidade e observe a latência sob carga (QD > 1).

# Exemplo de teste de estresse de IOPS aleatório (Cuidado: destrutivo se não usar filename)

fio --name=random-write --ioengine=libaio --rw=randwrite --bs=4k --numjobs=1 \

--size=10G --iodepth=32 --runtime=60 --time_based --filename=/dev/sdX

Se o seu workload exige mais de 5 IOPS por TB armazenado, o HDD sozinho não vai entregar. Você precisará de cache agressivo (ARC do ZFS, Tiering) ou terá que mover para Flash.

Atuadores Duplos: A Matemática da Vazão Sequencial

Para mitigar o problema de performance e, principalmente, permitir que o disco seja lido ou reconstruído em tempo hábil, surgiu a tecnologia de Dual Actuator (ex: Seagate Mach.2).

Imagine um disco rígido com dois braços independentes operando sobre o mesmo eixo de pratos. Metade das cabeças de leitura/gravação está em um braço, e a outra metade no outro.

O Resultado: O disco se apresenta ao sistema operacional como dois dispositivos lógicos (LUNs) ou um dispositivo com o dobro de throughput sequencial (~500 MB/s sustentados ao invés de 250 MB/s).

O Trade-off: O consumo de energia aumenta ligeiramente, mas o ganho de eficiência (IOPS/Watt) é enorme.

Sem atuadores duplos, encher ou ler um drive de 30TB a 250MB/s levaria cerca de 33 horas em condições ideais. Com atuadores duplos, reduzimos isso para ~16 horas. Em um ambiente de produção, essa janela de tempo é a diferença entre um SLA cumprido e uma falha crítica.

Rebuilds e Resilvering: O Pesadelo Estatístico do RAID

O aumento da densidade trouxe um efeito colateral aterrorizante para administradores de storage tradicionais: o tempo de reconstrução de RAID.

Em um RAID 5 (que você não deve usar), a perda de um disco exige a leitura de todos os outros discos para reconstruir a paridade.

Cenário: Array de discos de 30TB.

Risco: URE (Unrecoverable Read Error). A especificação padrão é de 1 erro a cada $10^{15}$ bits lidos.

Cálculo: Ao ler 30TB x (N-1) discos, a probabilidade matemática de encontrar um erro de leitura e falhar o rebuild é estatisticamente significativa.

A Nova Regra de Ouro: Para drives HAMR/MAMR acima de 20TB, RAID 5 está morto. Mesmo o RAID 6 tradicional torna-se arriscado devido ao tempo de exposição (dias em modo degradado).

A solução em 2026 é o uso mandatório de Erasure Coding (em Object Storage ou vSAN/Ceph) ou implementações de RAID declustered (como dRAID no ZFS), onde a reconstrução é distribuída entre todos os discos do cluster, não apenas um "hot spare". O objetivo é reduzir o tempo de rebuild de dias para horas, usando a largura de banda agregada de todo o rack.

Comparativo: Onde cada tecnologia se encaixa

| Característica | HDD Legado (CMR) | HDD Enterprise (HAMR + Dual Actuator) | SSD Enterprise (QLC) |

|---|---|---|---|

| Custo ($/TB) | Baixo | Muito Baixo (Melhor TCO para escala) | Médio/Alto |

| Capacidade Unidade | 4TB - 18TB | 30TB - 50TB+ | 15TB - 60TB+ |

| Performance (IOPS) | ~80 | ~160 (2x Atuadores) | 100,000+ |

| Throughput | ~250 MB/s | ~500 MB/s | 3,000+ MB/s |

| Caso de Uso | Legado, SMB | Cloud, Object Storage, Backup, Archive | DBs, Virtualização, Boot, Analytics |

| Risco Principal | Idade/Desgaste | Vibração, Calor, Tempo de Rebuild | Endurance (DWPD), Custo |

O Lugar do HDD em 2026: Estratégia "Flash-First, Capacity-Second"

O modelo mental para 2026 não é "Disco vs. Flash", mas sim uma hierarquia brutalmente eficiente.

Hot Data (Flash-First): Tudo o que exige latência sub-milissegundo vai para NVMe. Bancos de dados, metadados de sistemas de arquivos, logs ativos. Não há mais espaço para HDDs "rápidos" (10k/15k RPM estão extintos).

Warm/Cold Data (Capacity-Second): Aqui reinam os HDDs HAMR de 30TB+. Object Storage (S3 on-prem), repositórios de backup (Veeam/Commvault), vigilância e arquivamento médico.

O Veredito do Arquiteto: Não tenha medo da tecnologia HAMR; a física é sólida e foi testada por anos antes de chegar ao mercado de massa. Tenha medo de como você a implementa. Se você colocar um HDD de 30TB em um servidor antigo com controladora RAID genérica e esperar performance, vai falhar. Se você desenhar uma arquitetura de Object Storage distribuído, usando Erasure Coding e atuadores duplos, você terá o menor custo por TB possível, garantindo a viabilidade financeira do seu projeto na era dos Petabytes.

Referências & Leitura Complementar

Seagate Technology. "HAMR Technology: The Future of High-Capacity Storage". Whitepaper técnico sobre estabilidade térmica e gravação a laser.

Western Digital. "Energy-Assisted Magnetic Recording (EAMR) and MAMR". Explicação técnica sobre o uso de micro-ondas na gravação.

USENIX FAST '20. "The tail at store: a revelation from millions of hours of disk and SSD deployments". Análise de falhas e latência em escala.

Backblaze Drive Stats. Relatórios trimestrais de confiabilidade de HDDs em ambiente de produção real.

Silvio Zimmerman

Operador de Backup & DR

"Vivo sob o lema de que backup não existe, apenas restore bem-sucedido. Minha religião é a regra 3-2-1 e meu hobby é desconfiar da integridade dos seus dados."