Hardware para IA e LLMs no home lab: guia prático de GPUs e armazenamento

Aprenda a montar um servidor de IA local gastando pouco. Guia definitivo sobre Tesla P40, refrigeração impressa em 3D e por que o NVMe é vital para carregar seus modelos Llama 3.

Hardware para IA e LLMs no home lab: guia prático de GPUs e armazenamento

Rodar inteligência artificial em casa deixou de ser um sonho distante de quem tem racks de servidores corporativos e passou a ser uma realidade acessível e incrivelmente divertida. Se você, assim como eu, adora ver luzes piscando no rack e ventoinhas girando enquanto compila algo novo, o mundo dos LLMs (Large Language Models) locais é o próximo passo lógico para o seu laboratório. Mas cuidado: diferentemente de rodar um container Docker leve ou um servidor de arquivos Samba, a IA tem uma fome insaciável por hardware, especificamente memória e largura de banda.

A beleza de rodar modelos como Llama 3 ou Mixtral localmente é a privacidade total e a ausência de faturas mensais de API. No entanto, montar a infraestrutura para isso exige escolhas inteligentes. Não basta apenas espetar a placa de vídeo mais cara que você encontrar; o ecossistema de armazenamento e a forma como os dados trafegam do disco para a VRAM são fundamentais. Vamos mergulhar nas entranhas do hardware necessário, com aquele toque de "faça você mesmo" e economia que a gente gosta.

Resumo em 30 segundos

- VRAM é Rei: A quantidade de memória de vídeo (VRAM) dita o tamanho do modelo que você pode rodar. Mais GBs são melhores que um chip mais rápido com pouca memória.

- Armazenamento não é apenas depósito: O tempo de carregamento do modelo (loading time) depende drasticamente da velocidade do seu SSD NVMe. Discos mecânicos (HDD) tornam a experiência frustrante.

- Refrigeração é projeto: Placas de servidor usadas (como a Tesla P40) são baratas e têm muita VRAM, mas exigem adaptações de refrigeração (impressão 3D) para não derreterem em gabinetes comuns.

Figura: Bancada de home lab bagunçada com servidor aberto, ferramentas, peça impressa em 3D e monitor com código

Figura: Bancada de home lab bagunçada com servidor aberto, ferramentas, peça impressa em 3D e monitor com código

O objetivo de rodar inteligência artificial localmente

Por que gastar energia elétrica e tempo configurando isso? Além do fator aprendizado, rodar IA localmente elimina a latência de rede e garante que seus dados nunca saiam da sua infraestrutura. Para quem lida com documentos sensíveis ou quer integrar um assistente ao Home Assistant para automação residencial sem depender da nuvem, o processamento local é a única saída segura.

O desafio técnico aqui é equilibrar o custo com a performance. Servidores de inferência profissionais custam dezenas de milhares de dólares. Nosso objetivo é atingir 80% dessa capacidade gastando uma fração do valor, muitas vezes recorrendo ao mercado de usados e a soluções criativas de resfriamento.

A hierarquia de memória e o papel crucial do armazenamento NVMe

Muitos tutoriais focam apenas na GPU, mas esquecem de como os dados chegam até ela. Um modelo de linguagem grande é, essencialmente, um arquivo gigantesco (pesos do modelo) que precisa ser movido do armazenamento frio para a memória de acesso rápido.

Quando você inicia uma inferência, o sistema lê o arquivo do modelo (que pode ter de 4GB a mais de 100GB) do seu disco. Se você estiver usando um HDD mecânico tradicional, essa leitura pode levar minutos. É aqui que o armazenamento NVMe (Non-Volatile Memory Express) brilha.

💡 Dica Pro: Se o seu modelo não cabe totalmente na VRAM da GPU, o sistema pode usar a memória RAM do computador como "transbordo" (offloading). Nesse cenário, a velocidade com que os dados são trocados entre RAM e VRAM é crítica, mas a velocidade inicial de leitura do disco define o quão rápido você começa a conversar com o bot.

Veja a diferença prática no tempo de carregamento de um modelo de 70GB (ex: Llama-3-70B quantizado):

| Tipo de Armazenamento | Taxa de Leitura Real (Média) | Tempo Estimado de Carregamento | Custo por TB |

|---|---|---|---|

| HDD 7200RPM | ~150 MB/s | ~7 minutos e 46 segundos | Baixo |

| SSD SATA III | ~500 MB/s | ~2 minutos e 20 segundos | Médio |

| NVMe PCIe 3.0 | ~3.000 MB/s | ~23 segundos | Médio-Alto |

| NVMe PCIe 4.0 | ~7.000 MB/s | ~10 segundos | Alto |

Para um home lab focado em IA, recomendo fortemente dedicar um NVMe exclusivo para os modelos. Isso evita que o I/O do sistema operacional ou de outros containers interfira no carregamento dos pesos.

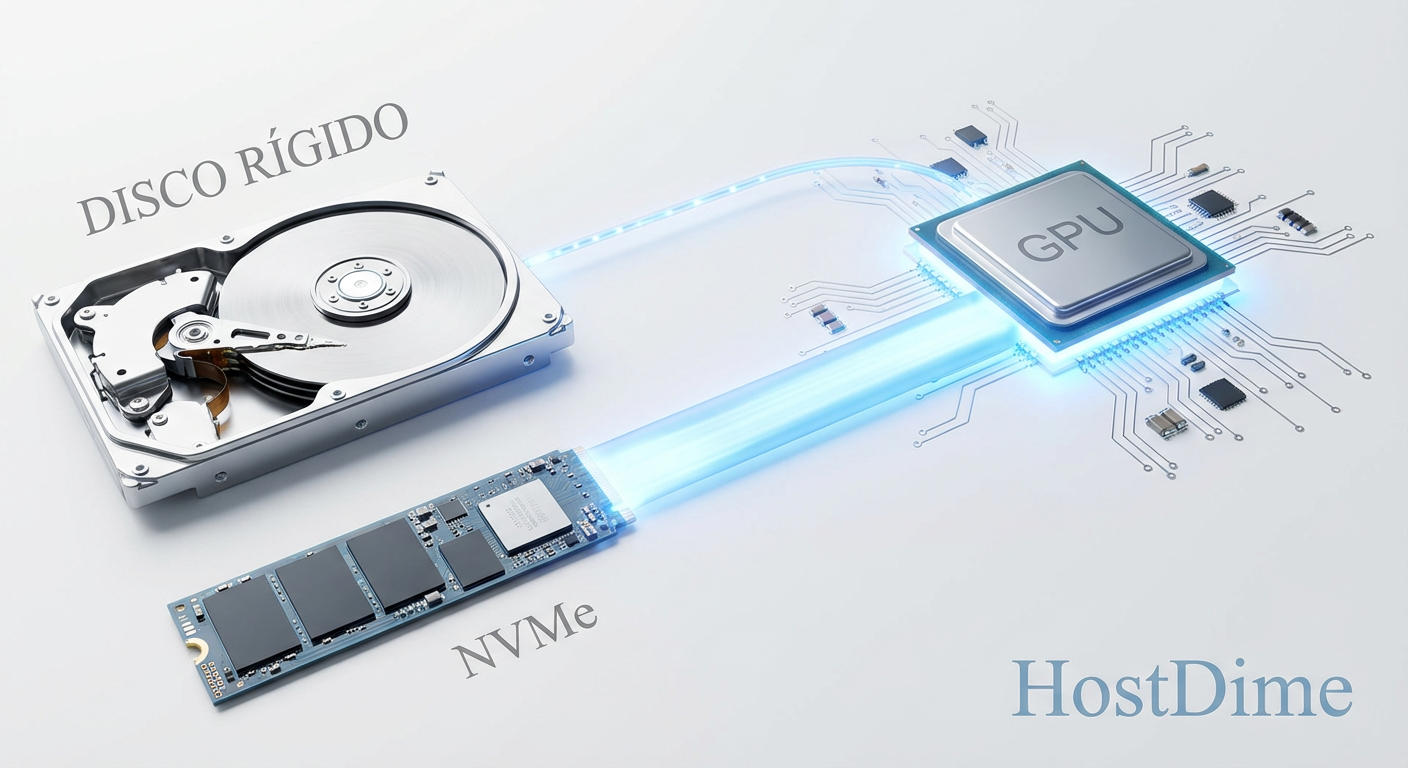

Figura: Diagrama comparativo mostrando o fluxo de dados lento de um HDD versus o fluxo rápido de um NVMe indo para a GPU

Figura: Diagrama comparativo mostrando o fluxo de dados lento de um HDD versus o fluxo rápido de um NVMe indo para a GPU

Escolhendo a GPU certa: VRAM barata versus largura de banda

Aqui entramos no território favorito dos entusiastas: garimpar hardware. Para LLMs, a regra de ouro é "VRAM acima de tudo". A velocidade de processamento (CUDA Cores) é secundária se o modelo não couber na memória. Se o modelo não couber, ele vai para a RAM do sistema (CPU), e a velocidade de resposta cai de "instantânea" para "uma palavra por segundo".

Temos dois caminhos principais:

Caminho do Consumidor (Gamer): Placas como a NVIDIA RTX 3060 (12GB) ou a RTX 4060 Ti (16GB). São fáceis de usar, têm ventoinhas próprias e saídas de vídeo. A RTX 3090 (24GB) é o "santo graal" do consumidor, mas ainda custa caro.

Caminho do Servidor (Enterprise Usado): Aqui brilha a NVIDIA Tesla P40. Lançada há anos, ela tem 24GB de VRAM e custa uma fração de uma RTX 3090. O problema? Ela não tem saídas de vídeo e, pior, não tem ventoinhas.

A Tesla P40 é baseada na arquitetura Pascal. Ela não é tão rápida quanto as placas modernas para treinamento, mas para inferência (apenas rodar o modelo), ela é um monstro de custo-benefício. O desafio é que ela foi feita para servidores com fluxo de ar violento. Se você colocá-la em um PC desktop sem modificações, ela superaquece e desliga em minutos.

Montagem prática: resfriando placas Tesla antigas com impressão 3D

Se você escolheu o caminho da Tesla P40 ou M40 para economizar, prepare sua impressora 3D. Essas placas dependem de pressão estática para empurrar o ar através das aletas do dissipador.

A solução clássica do "home labber" é imprimir um fan shroud (duto de ventilação). Você desenha ou baixa um modelo que se encaixa na traseira da placa e adapta uma ventoinha de 40mm ou, preferencialmente, um adaptador cônico para uma ventoinha de 120mm de alta pressão.

⚠️ Perigo: Não use ventoinhas de gabinete silenciosas comuns para resfriar uma Tesla P40. Você precisa de ventoinhas com alta pressão estática (como as usadas em radiadores) ou ventoinhas de servidor (blower) que giram a altas rotações. O ar precisa ser forçado com violência pelas aletas apertadas do dissipador.

Eu utilizo um design simples impresso em PETG (para aguentar o calor) que acopla uma ventoinha de 120mm na ponta da placa. O ruído aumenta, mas a temperatura da GPU cai de 90°C para estáveis 60°C durante a inferência pesada. É a gambiarra funcional que define o espírito do home lab.

Figura: Adaptador impresso em 3D laranja acoplado a uma placa de vídeo de servidor prateada com uma ventoinha preta presa na ponta

Figura: Adaptador impresso em 3D laranja acoplado a uma placa de vídeo de servidor prateada com uma ventoinha preta presa na ponta

O gargalo esquecido: barramento PCIe e carregamento

Outro ponto onde o armazenamento e a placa-mãe conversam é o barramento PCIe. Se você está usando múltiplas GPUs (por exemplo, duas Tesla P40 para ter 48GB de VRAM e rodar modelos gigantes), você precisa ficar atento às linhas PCIe (PCIe lanes).

Muitas placas-mãe de consumo limitam o segundo ou terceiro slot PCIe a velocidades x4 ou x1. Embora a inferência em si (o ato de gerar texto) não use muita largura de banda do PCIe depois que o modelo está carregado, o carregamento inicial e o offloading (quando parte do modelo fica na RAM e parte na VRAM) sofrem muito.

Se você usa llama.cpp e divide o modelo entre duas placas, os dados precisam trafegar de uma placa para a outra ou da CPU para as placas. Um slot PCIe x1 vai criar um gargalo severo, fazendo com que a geração de texto engasgue. Tente garantir pelo menos PCIe 3.0 x8 para cada placa se possível, ou aceite que a performance será limitada pela velocidade do barramento, não pelo poder da GPU.

Verificação de desempenho com llama-bench e monitoramento de I/O

Depois de montar o hardware, imprimir os dutos de ar e instalar os discos NVMe, como saber se está tudo funcionando como deveria? O "olhômetro" não é confiável.

A ferramenta llama-bench, que vem junto com o llama.cpp, é excelente para testar a velocidade de processamento (tokens por segundo). Mas para ver o impacto do armazenamento, eu recomendo monitorar o sistema operacional enquanto você carrega um modelo.

Use o btop ou htop no Linux. Observe a coluna de "I/O Wait" ou a atividade do disco.

Carregamento: Ao iniciar o modelo, seu NVMe deve bater picos de leitura de vários GB/s. Se estiver baixo, verifique se você não está limitado por um slot M.2 compartilhado com portas SATA.

Inferência: O uso da GPU deve ir a 100% (use o

nvtoppara monitorar placas NVIDIA). Se a GPU estiver oscilando (caindo para 0% e voltando), é sinal de que ela está esperando dados. Isso geralmente indica um gargalo no barramento PCIe ou no disco (se estiver usando swap, o que você deve evitar a todo custo).

Figura: Tela dividida mostrando nvtop com gráficos de GPU e btop com estatísticas de disco

Figura: Tela dividida mostrando nvtop com gráficos de GPU e btop com estatísticas de disco

Previsão para o futuro do Home Lab de IA

Estamos em um ponto de inflexão. O hardware de servidor usado (como as Teslas) ainda é o rei do custo-benefício para quem tem coragem de lidar com refrigeração e BIOS antigas. No entanto, a tendência é que vejamos mais NPUs (Unidades de Processamento Neural) integradas e o uso de memória unificada (como nos Macs da Apple) se tornando mais comum, embora ainda caro.

Por enquanto, a combinação de um host com muitas linhas PCIe, armazenamento NVMe Gen4 para carregamento instantâneo e GPUs antigas de datacenter com muita VRAM continua sendo a "fórmula mágica" para rodar inteligência artificial poderosa em casa sem vender um rim. Prepare sua impressora 3D, configure seu Linux e aproveite a revolução da IA direto do seu rack.

Perguntas Frequentes (FAQ)

Preciso de um SSD NVMe para rodar LLMs ou um SATA serve?

Para inferência pura, um SATA funciona, mas o tempo de carregamento do modelo (loading time) será drasticamente maior. Se você troca de modelos frequentemente ou usa 'offloading' para a RAM do sistema, um NVMe é obrigatório para evitar gargalos severos.Qual a GPU mais barata para começar com IA no home lab?

A NVIDIA RTX 3060 de 12GB é a rainha do custo-benefício para iniciantes. Para usuários avançados dispostos a fazer adaptações (gambiarras), a Tesla P40 de 24GB usada oferece o melhor custo por gigabyte de VRAM.Posso usar memória RAM normal em vez de VRAM da placa de vídeo?

Sim, via inferência na CPU (como no llama.cpp), mas é muito mais lento. A RAM do sistema serve melhor como um 'transbordo' para partes do modelo que não cabem na GPU, mas a performance cai drasticamente.Como resfriar uma placa Tesla P40 em um gabinete comum?

Como elas são passivas (feitas para servidores com fluxo de ar violento), você precisará imprimir em 3D um duto (shroud) e acoplar uma ventoinha de alta pressão estática na traseira da placa.

Roberto Esteves

Especialista em Segurança Defensiva

"Com 15 anos de experiência em Blue Team, foco no que realmente impede ataques: segmentação, imutabilidade e MFA. Sem teatro de segurança, apenas defesa real e robusta para infraestruturas críticas."