Investigando a latência de metadados: o guia definitivo de ZFS Special VDEVs

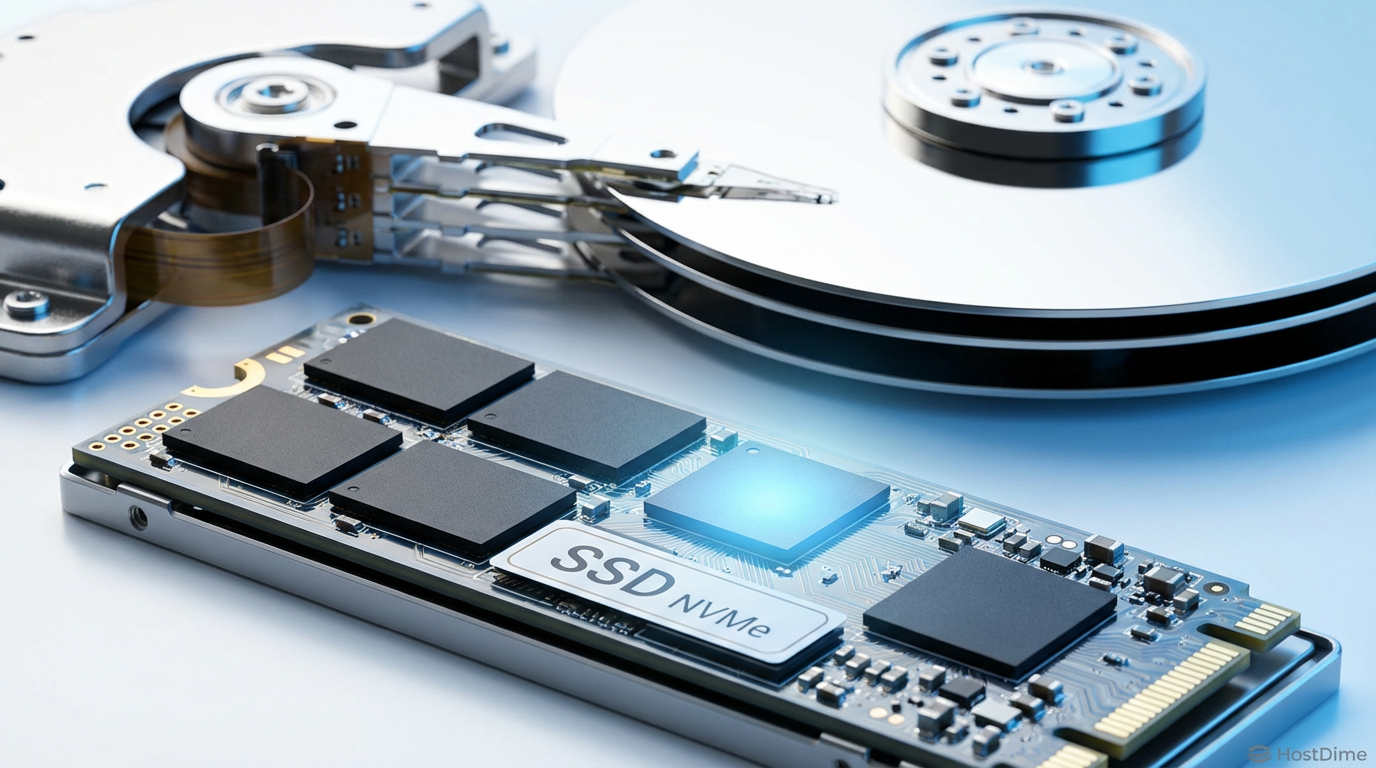

Seu array de discos está engasgando com 'ls -R'? Descubra como isolar metadados em NVMe usando Special VDEVs e elimine o gargalo físico dos HDDs rotacionais.

Você conhece a sensação. O cursor pisca no terminal. Você digitou ls -la /mnt/storage/backups há três segundos. O sistema não está sob carga de CPU. A rede está ociosa. Mas o prompt não retorna.

Para o observador casual, o sistema está "lento". Para o investigador forense de sistemas, isso é uma cena de crime onde a física dos discos mecânicos colidiu violentamente com a arquitetura de sistemas de arquivos modernos. O culpado quase sempre é a latência de I/O aleatório na busca por metadados.

Em pools de armazenamento de alta densidade, onde misturamos Terabytes de dados com milhões de arquivos, a latência rotacional não é apenas um incômodo; é uma barreira operacional. Vamos dissecar por que seus discos rígidos falham em entregar listagens de arquivos e como a implementação cirúrgica de Special Allocation Classes (Special VDEVs) no ZFS altera fundamentalmente a topologia do seu armazenamento.

Resumo em 30 segundos

- O Gargalo: Discos rígidos (HDDs) são excelentes em transferências sequenciais, mas fisicamente incapazes de lidar com as milhares de operações de busca (IOPS) aleatórias exigidas para ler metadados de milhões de arquivos.

- O Mito do Cache: O L2ARC (cache de leitura em SSD) ajuda, mas é volátil e reativo. Ele precisa ser "aquecido" e consome RAM para indexação, falhando em garantir performance determinística na escrita e leitura inicial.

- A Solução Definitiva: O ZFS Special VDEV não é cache; é uma camada de armazenamento primário dedicada. Ele isola fisicamente os metadados (e pequenos blocos) em flash (NVMe/SSD), deixando os HDDs fazerem apenas o que sabem: ler e gravar grandes arquivos sequencialmente.

A paralisia do 'ls -la' em pools de alta densidade

Quando você executa um comando simples de listagem ou uma busca com find, o sistema operacional não está lendo o conteúdo dos seus arquivos. Ele está lendo os inodes (no mundo ext4) ou dnodes e ponteiros de bloco (no mundo ZFS).

Em um pool ZFS composto exclusivamente por discos mecânicos (spinners), cada arquivo exige a leitura de sua árvore de metadados. O ZFS é um sistema de arquivos copy-on-write com uma árvore de Merkle. Para encontrar um dado, o sistema precisa percorrer ponteiros de blocos espalhados pelo disco.

Se você tem um diretório com 10.000 fotos, o cabeçote do disco precisa saltar fisicamente para ler os atributos (permissões, timestamp, tamanho, localização física) de cada um desses arquivos.

O custo invisível das operações de seek

Vamos à matemática forense. Um HDD moderno de 7200 RPM consegue realizar, em um cenário otimista, cerca de 80 a 120 IOPS (operações de entrada/saída por segundo) aleatórias.

Se listar aquele diretório exige 2.000 leituras de metadados de 4KB espalhados pelo prato magnético:

2000 operações / 100 IOPS = 20 segundos.

São 20 segundos de espera onde a taxa de transferência (throughput) é irrelevante. Você pode ter 10 GB/s de largura de banda disponível, mas a latência física do braço mecânico dita o ritmo. É aqui que a infraestrutura de storage tradicional colapsa sob o peso da própria complexidade.

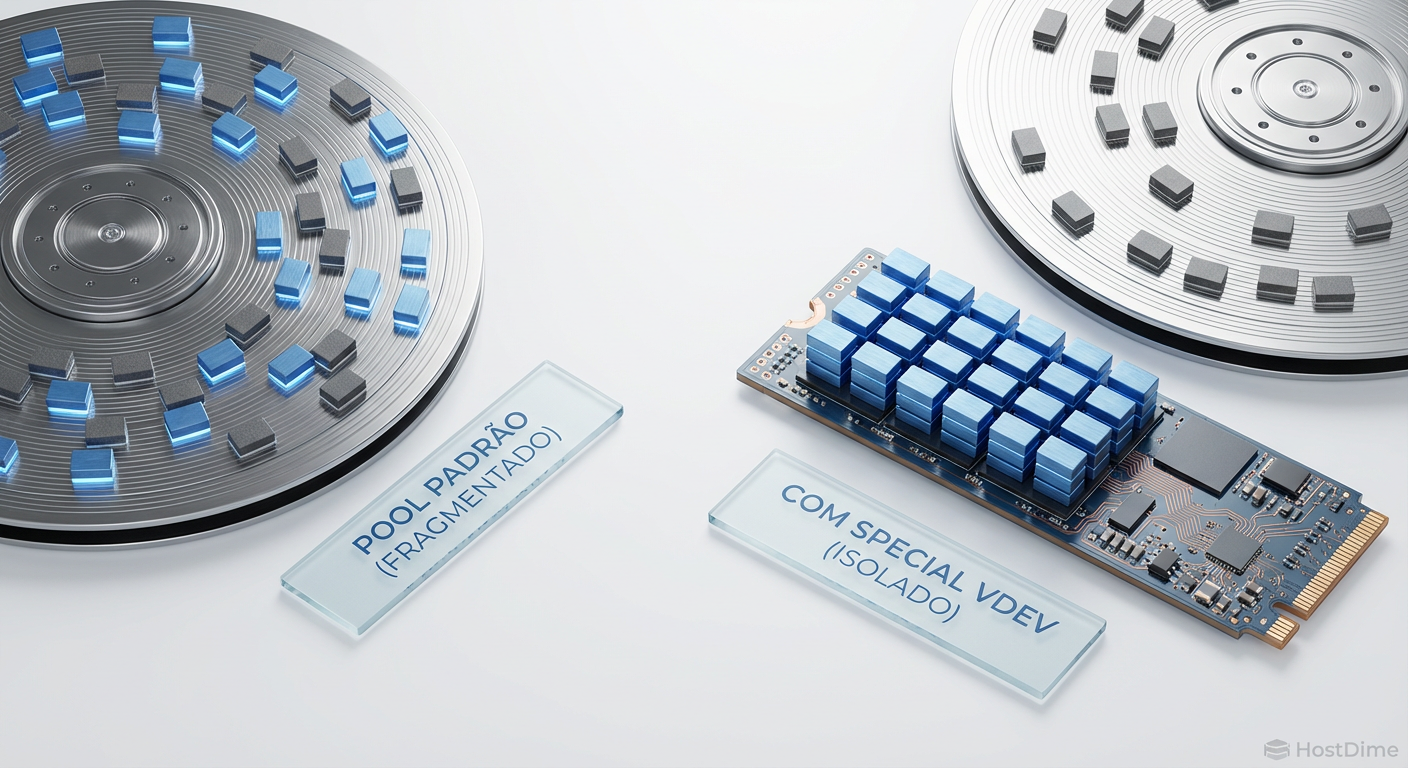

Fig. 1: A segregação física dos metadados elimina a penalidade de seek aleatório nos discos rotacionais.

Fig. 1: A segregação física dos metadados elimina a penalidade de seek aleatório nos discos rotacionais.

Por que o L2ARC não resolve o problema

Muitos administradores tentam resolver isso adicionando um SSD como L2ARC (Level 2 Adaptive Replacement Cache). Embora ajude, sob uma ótica estrita de engenharia de performance, é uma band-aid, não uma cura.

Aquecimento (Warm-up): O L2ARC começa vazio. Os dados só vão para lá depois de serem lidos do disco lento repetidas vezes. Se você reiniciar o servidor, dependendo da configuração, o cache esfria e a lentidão retorna.

Custo de RAM: Para indexar os dados que estão no L2ARC, o ZFS consome memória RAM do ARC principal. Em pools massivos, um L2ARC muito grande pode, ironicamente, reduzir a performance ao canibalizar a RAM disponível para metadados "quentes".

Natureza Probabilística: O cache é uma aposta. Você espera que o dado esteja lá. Em ambientes críticos, preferimos determinismo a probabilidade.

Arquitetando a classe de alocação especial

Introduzido no ZFS on Linux 0.8, o recurso de Special Allocation Class (comumente chamado de Special VDEV) permite criar uma tierização interna no pool. Diferente do cache, isso é armazenamento persistente.

Ao adicionar um VDEV especial, você instrui o ZFS a armazenar tipos específicos de dados exclusivamente nesse dispositivo. O padrão é armazenar apenas metadados (DDT - Dedup Table, dnodes, block pointers).

O resultado prático é a segregação física de cargas de trabalho:

NVMe/SSD (Special VDEV): Absorve 100% das operações de busca aleatória, atualizações de

atime, e manipulação de estrutura de arquivos.HDD (Data VDEVs): Ficam ociosos até que seja necessário ler ou escrever o payload (o conteúdo real do arquivo). Quando acionados, operam em modo sequencial, onde sua eficiência é máxima.

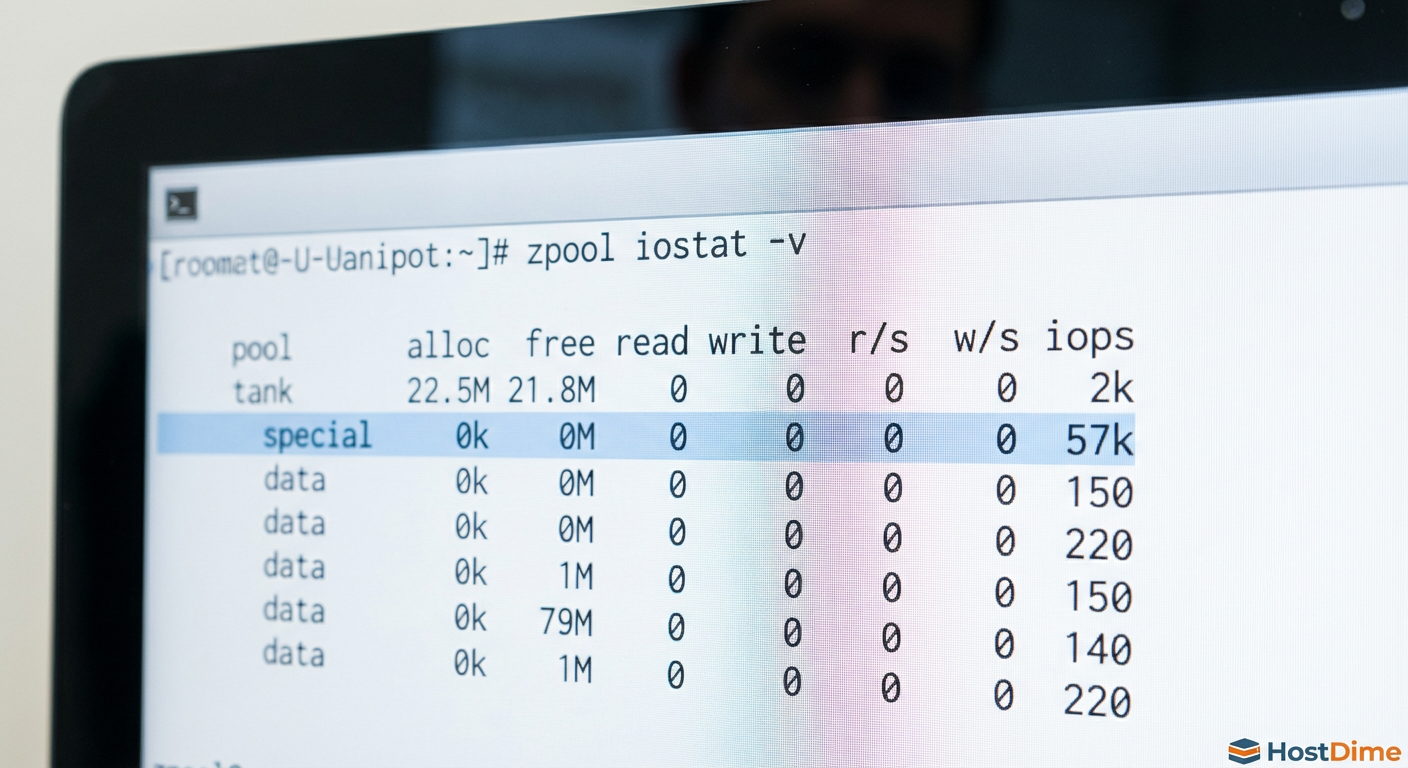

Fig. 2: Evidência forense: O Special VDEV absorvendo 99% das operações de I/O aleatórias enquanto os HDDs descansam.

Fig. 2: Evidência forense: O Special VDEV absorvendo 99% das operações de I/O aleatórias enquanto os HDDs descansam.

💡 Dica Pro: O Special VDEV também pode hospedar blocos de dados pequenos. Com a propriedade

special_small_blocks, você pode definir que qualquer arquivo menor que, por exemplo, 64K ou 128K seja gravado inteiramente no SSD. Isso elimina o problema de write amplification e fragmentação severa nos discos rotacionais.

O risco crítico: redundância é inegociável

Aqui entramos na análise de risco. Como investigador de falhas, já vi pools inteiros perdidos por negligência nesta etapa.

O Special VDEV contém os metadados do pool. Se você perder os metadados, você perde o pool. Não importa que seus HDDs de dados estejam intactos; sem o mapa (metadados) para ler os dados, eles são apenas lixo magnético aleatório.

Portanto, a regra de ouro da arquitetura de Special VDEVs é: A redundância do Special VDEV deve igualar ou superar a redundância do pool.

Se o seu pool é um Stripe (RAID 0) suicida: Um Special VDEV single é aceitável (mas imprudente).

Se o seu pool é Mirror ou RAID-Z1/Z2/Z3: O Special VDEV DEVE ser, no mínimo, um Mirror de 2 vias (RAID 1). Preferencialmente um Mirror de 3 vias para ambientes corporativos.

⚠️ Perigo: Nunca adicione um único SSD como Special VDEV em um pool com dados valiosos. A falha desse único componente de estado sólido destruirá petabytes de dados mecanicamente seguros.

Fig. 3: O Risco Crítico. Sem redundância (Mirror), a falha do flash significa a perda matemática de todo o Zpool.

Fig. 3: O Risco Crítico. Sem redundância (Mirror), a falha do flash significa a perda matemática de todo o Zpool.

Especificação de Hardware para Special VDEVs

Não use qualquer SSD de consumo que encontrou na gaveta. Metadados sofrem escritas constantes.

Endurance (DWPD): Procure drives com alta durabilidade. Metadados são pequenos, mas as escritas são frequentes.

PLP (Power Loss Protection): Obrigatório para garantir que as transações de metadados em voo sejam commitadas em caso de queda de energia, evitando corrupção do pool.

Interface: NVMe é preferível a SATA devido à latência de comando reduzida e filas paralelas, essenciais para lidar com milhares de operações de metadados simultâneas.

Métricas de validação: antes e depois

Como validamos se a cirurgia foi um sucesso? Não confiamos em sentimentos; confiamos em telemetria.

1. Latência de Operação (zpool iostat)

Antes da migração, execute zpool iostat -r 1. Observe as colunas de latência de leitura/escrita. Em HDDs sob carga de metadados, você verá picos de 50ms a 200ms.

Após a implementação, a latência de operações de metadados deve cair para a casa dos microssegundos (us) ou baixos milissegundos (1-2ms), dependendo do seu flash.

2. Distribuição de I/O

Utilize o comando:

zpool iostat -v 1

Observe o fluxo. Durante uma varredura de diretórios (find / -name "*.log"), você deve ver os HDDs principais com quase 0 IOPS, enquanto o Special VDEV (ex: mirror-1) absorve milhares de IOPS. Isso é a prova visual de que a carga mecânica foi removida.

3. Histogramas de Latência

Se o seu sistema suportar, use zpool iostat -l para ver histogramas de distribuição. O "long tail" (latência de cauda) deve desaparecer. Aquelas operações ocasionais de 500ms que causavam "engasgos" na aplicação deixarão de existir.

O veredito forense

A era de armazenar metadados em discos rotacionais acabou para qualquer aplicação que exija interatividade ou performance. A física dos braços mecânicos não consegue mais acompanhar a densidade dos dados modernos.

Ao implementar Special VDEVs, você não está apenas "acelerando" o storage; você está corrigindo uma ineficiência arquitetural. Você permite que cada mídia faça o que foi projetada para fazer: flash para operações atômicas e aleatórias, discos magnéticos para armazenamento denso e sequencial.

Se os seus logs mostram iowait alto durante listagens de arquivos e seus discos estão "crocitando" sem transferência de dados significativa, o diagnóstico é claro. A prescrição é flash dedicado para metadados. Apenas certifique-se de espelhar esses drives, ou a autópsia do seu sistema será trágica.

Perguntas Frequentes

P: Posso remover um Special VDEV se eu mudar de ideia? R: Apenas se todos os vdevs de nível superior do seu pool forem espelhos (mirrors). Se você usar RAID-Z, a remoção do Special VDEV não é possível nas versões atuais do OpenZFS. Você teria que destruir e recriar o pool. Planeje com cuidado.

P: Qual tamanho o Special VDEV deve ter?

R: Uma regra prática conservadora é 0.3% da capacidade do pool apenas para metadados. Se você planeja usar special_small_blocks para armazenar arquivos pequenos também, precisará calcular com base na distribuição dos seus dados (ex: 2% a 5%).

P: O que acontece se o Special VDEV encher? R: O ZFS é inteligente. Se o Special VDEV ficar cheio, os novos metadados "transbordam" de volta para os discos rotacionais (HDDs). A performance cairá para os dados novos, mas o sistema não para.

P: Special VDEV substitui o SLOG (ZIL)? R: Não. O SLOG é para escritas síncronas (segurança de dados em voo). O Special VDEV é para armazenamento de metadados (estrutura de arquivos). Eles resolvem problemas diferentes, embora ambos usem SSDs.

Referências & Leitura Complementar

OpenZFS Documentation: Allocation Classes (Special VDEVs). Disponível na documentação oficial do projeto OpenZFS.

Datasheets: Seagate Exos X Series & Micron 7450 NVMe SSD (para comparação de IOPS aleatórios vs sequenciais e especificações de DWPD).

RFC/Standards: NVM Express Base Specification (para entendimento de filas e latência em flash).

Leitura Técnica: "ZFS High-Performance Guide" - Focando na seção de tuning de

recordsizeeashiftpara alinhamento com mídia flash.

Bruno Albuquerque

Investigador Forense de Sistemas

"Não aceito 'falha aleatória'. Com precisão cirúrgica, mergulho em logs e timestamps para expor a causa raiz de qualquer incidente. Se deixou rastro digital, eu encontro."