Nvidia define storage como 'inexplorado': por que as ações de memória dispararam?

Jensen Huang alerta para o gargalo de armazenamento na IA durante a CES 2026. Entenda o impacto no mercado (Micron, SK Hynix) e a nova arquitetura BlueField-4.

A CES 2026 ficará marcada não pelos robôs humanoides ou telas transparentes, mas pelo momento em que Jensen Huang, CEO da Nvidia, apontou para um diagrama de arquitetura de servidor e circulou a camada de armazenamento. Ao classificar o subsistema de storage como "o território inexplorado da IA Agente", o executivo desencadeou uma reação em cadeia imediata nos mercados financeiros globais, impulsionando papéis de fabricantes de memória como Micron e SK Hynix a novas máximas históricas.

Para analistas de infraestrutura, a mensagem foi clara: o modelo de computação focado puramente em GPU e HBM (High Bandwidth Memory) atingiu um teto econômico e físico. A próxima fronteira da Inteligência Artificial não é apenas processar mais rápido, mas "lembrar" de mais coisas por mais tempo. E isso exige uma reinvenção completa de como concebemos o armazenamento de dados no data center.

Resumo em 30 segundos

- O Gargalo Mudou: A Nvidia admitiu que a memória HBM é cara e escassa demais para sustentar a "IA Agente", que exige contextos massivos (terabytes de dados ativos).

- Nova Arquitetura: Foi apresentada a plataforma ICMSP, que utiliza DPUs BlueField-4 para transformar SSDs NVMe em uma extensão direta da memória da GPU, contornando a CPU.

- Reação do Mercado: As ações de fabricantes de memória dispararam pois a demanda agora se expande além do HBM, criando um "superciclo" que inclui SSDs de classe enterprise e módulos CXL.

O alerta de Jensen Huang e o fim da "Amnésia Digital"

Durante os últimos três anos, a indústria focou obsessivamente no treinamento de modelos (LLMs). Em 2026, o foco virou totalmente para a inferência, especificamente para Agentes de IA autônomos. Diferente de um chatbot que esquece a conversa ao fechar a janela, um agente precisa manter um "estado de mundo" persistente. Ele precisa lembrar de e-mails de três meses atrás, logs de sistema da semana passada e diretrizes corporativas, tudo simultaneamente.

O problema exposto na keynote é matemático. Manter todo esse contexto em memória HBM4 (que custa centenas de dólares por gigabyte) é inviável para implantações em escala.

💡 Dica Pro: Em ambientes de IA, "Contexto" é sinônimo de custo. Se sua infraestrutura depende exclusivamente de VRAM para manter o contexto ativo, seu TCO (Custo Total de Propriedade) crescerá linearmente com a complexidade do modelo. A estratégia agora é tiering de contexto.

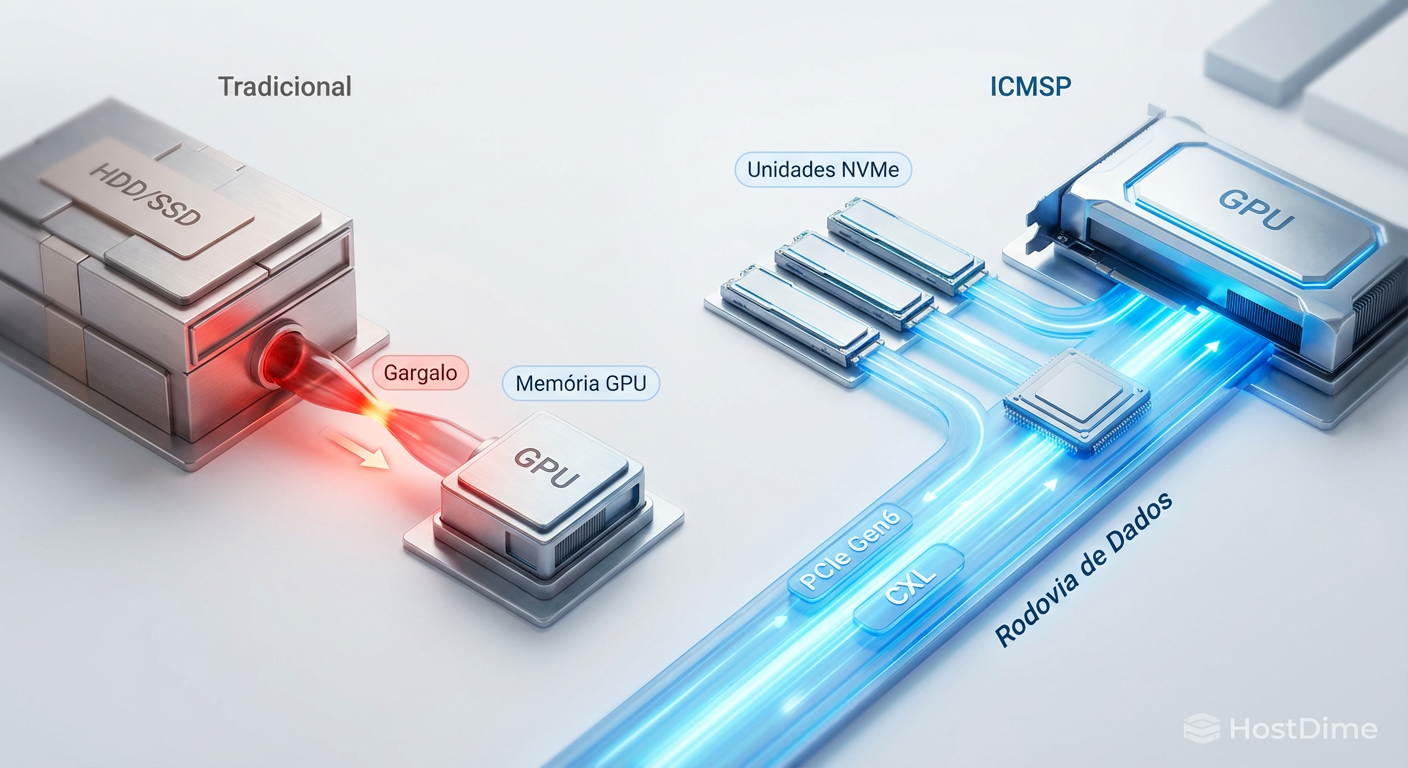

Figura: Comparação visual entre o gargalo tradicional de I/O e a nova arquitetura de fluxo direto proposta para IA Agente.

Figura: Comparação visual entre o gargalo tradicional de I/O e a nova arquitetura de fluxo direto proposta para IA Agente.

Por que a memória HBM não é suficiente

A memória HBM é a "Ferrari" do armazenamento: incrivelmente rápida, mas com pouco espaço no porta-malas. Com a chegada dos modelos de 100 trilhões de parâmetros e janelas de contexto infinitas, a indústria colidiu com a parede da capacidade.

A Nvidia não está abandonando a HBM. Pelo contrário, a demanda continua insaciável. No entanto, a empresa criou uma nova hierarquia de memória para lidar com o que chamam de "Cold Context" (Contexto Frio) e "Warm Context" (Contexto Morno). Dados que não são acessados a cada milissegundo, mas que precisam estar disponíveis em microssegundos, não devem ocupar espaço precioso na HBM.

Tabela Comparativa: A Nova Hierarquia de Dados para IA (2026)

| Camada | Tecnologia Principal | Latência Típica | Custo Relativo ($/GB) | Função na IA Agente |

|---|---|---|---|---|

| Hot Tier | HBM4 / HBM4e | < 10 ns | $$$$$ (Extremo) | Processamento de tensores imediato. |

| Warm Tier | DDR5 / CXL 3.0 | ~ 70-100 ns | $$$ (Alto) | Cache de curto prazo e instruções. |

| Context Tier | NVMe (ICMSP) | ~ 3-10 µs | $$ (Médio) | Memória expandida para histórico do agente (O novo foco). |

| Cold Tier | QLC SSD / HDD | > 100 µs | $ (Baixo) | Arquivamento e Datasets brutos. |

A grande novidade é a formalização do "Context Tier". É aqui que o armazenamento deixa de ser apenas "lugar de guardar arquivos" e vira memória ativa.

A arquitetura ICMSP e o papel crítico do BlueField-4

A sigla que dominou as conversas pós-keynote foi ICMSP (Inference Context Memory Storage Platform). Em termos simples, é a evolução agressiva do GPUDirect Storage.

Até 2025, mover dados do SSD para a GPU envolvia, muitas vezes, passar pela CPU e pela memória do sistema, criando latência e desperdiçando ciclos de processamento. A Nvidia resolveu isso delegando a tarefa para a DPU (Data Processing Unit).

O BlueField-4, lançado comercialmente agora em 2026, atua como um controlador de tráfego inteligente. Ele permite que a GPU acesse endereços de memória que, fisicamente, estão gravados em chips NAND Flash de SSDs NVMe. Para a GPU, é como se ela tivesse terabytes de memória RAM lenta, mas acessível diretamente via barramento PCIe Gen6 ou CXL.

⚠️ Perigo: Implementar ICMSP exige hardware validado. SSDs de consumo (mesmo os Gen5 topos de linha) não possuem a consistência de latência (QoS) necessária. Um pico de latência em um SSD gamer pode travar o raciocínio de um agente de IA em tempo real. O foco aqui é em drives Enterprise (E1.S, E3) com firmware otimizado para Zoned Namespaces (ZNS).

Figura: O papel da DPU BlueField-4 como ponte direta entre o armazenamento NVMe e a computação acelerada.

Figura: O papel da DPU BlueField-4 como ponte direta entre o armazenamento NVMe e a computação acelerada.

A corrida das ações: O 'Superciclo' de Memória

A reação do mercado financeiro foi lógica e imediata. Se a Nvidia diz que o armazenamento é o gargalo, quem fabrica os "tijolos" desse armazenamento vai lucrar.

Micron & SK Hynix: Estas empresas já surfavam a onda da HBM. Agora, ganham um segundo motor de crescimento: SSDs de alta performance para Data Center. A validação da Nvidia para o uso de NVMe como "memória de contexto" abre um TAM (Total Addressable Market) gigantesco que estava adormecido.

Samsung Electronics: Embora tenha enfrentado desafios de yield em 2024/2025, sua capacidade de produção massiva de NAND Flash a coloca em posição vantajosa para atender a demanda por volume.

Pure Storage & NetApp: Empresas que já focavam em All-Flash Arrays de baixa latência viram suas ações subirem moderadamente. A tese é que o armazenamento externo também precisará ser rápido o suficiente para alimentar os clusters de ICMSP.

O termo "Superciclo" voltou aos relatórios do Gartner e IDC. Diferente dos ciclos anteriores, impulsionados por smartphones ou PCs, este é impulsionado por CAPEX de infraestrutura crítica. Não é sobre vender mais unidades, é sobre vender unidades de maior valor agregado e densidade.

A convergência inevitável via CXL

Não podemos ignorar o CXL (Compute Express Link) nesta equação. A tecnologia, que amadureceu significativamente em 2025, é o cimento que une essa nova arquitetura.

O anúncio da Nvidia valida o CXL como o protocolo padrão para expansão de memória. Módulos de memória CXL (que usam DRAM mas se conectam via slot PCIe/EDSFF) e SSDs compatíveis com CXL estão prestes a se tornar onipresentes. Isso permite que servidores componham recursos de forma dinâmica: um servidor pode "emprestar" SSDs ou memória de outro chassi no mesmo rack para lidar com um pico de carga de inferência.

Para o gestor de TI ou entusiasta de Home Lab, isso sinaliza o fim da era em que CPU, RAM e Disco eram silos isolados. O futuro é um pool de recursos desmembrados.

Veredito Técnico

A definição de storage como "inexplorado" pela Nvidia não é apenas marketing; é um aviso de obsolescência para arquiteturas legadas. Para CIOs e arquitetos de infraestrutura, a mensagem é urgente: parem de projetar storage baseando-se apenas em capacidade ($/TB).

A métrica crítica para a era da IA Agente é IOPS por Watt e Latência de Cauda (Tail Latency). Se sua infraestrutura de armazenamento não consegue entregar dados diretamente para suas GPUs sem onerar a CPU, você construiu um museu, não um data center. A valorização das ações de memória é apenas o sintoma financeiro de uma mudança tectônica na engenharia computacional: o armazenamento finalmente subiu de cargo e virou memória.

FAQ: Perguntas Frequentes

Por que as ações da Micron e SK Hynix subiram após a fala da Nvidia?

O mercado reagiu à confirmação de que a IA de inferência (Agentes) exigirá volumes massivos de memória para lidar com "contextos longos". Isso cria uma demanda dupla: continua a necessidade de HBM, mas surge uma nova demanda crítica por SSDs NVMe de alta performance e módulos CXL para atuar como memória expandida, beneficiando diretamente os fabricantes desses componentes.O que é o Nvidia ICMSP anunciado na CES 2026?

ICMSP (Inference Context Memory Storage Platform) é uma arquitetura de referência que utiliza DPUs BlueField-4 para permitir que GPUs acessem dados (como Cache KV) diretamente em SSDs NVMe. Isso elimina a CPU do processo de transferência de dados, reduzindo a latência e permitindo que modelos de IA acessem terabytes de informação quase instantaneamente.Qual a diferença entre armazenamento tradicional e 'Context Memory'?

O armazenamento tradicional foca em capacidade, durabilidade e baixo custo por TB (persistência). A "Context Memory" foca em latência ultrabaixa e acesso aleatório massivo para alimentar GPUs em tempo real. Ela age funcionalmente como uma extensão lenta da memória RAM, e não apenas como um repositório de arquivos estáticos.

Arthur Siqueira

Analista de Mercado de Storage

"Analiso o cenário macroeconômico do armazenamento corporativo. Meu foco está nos movimentos de consolidação, flutuações de market share e na saúde financeira que dita o futuro dos grandes players."