O cheque de US$ 5 bilhões da Nvidia na Intel muda o jogo para o armazenamento

Nvidia confirma investimento estratégico na Intel. Entenda como essa união redefine servidores, acelera o CXL e impacta o futuro do armazenamento de dados no Data Center.

A notícia caiu como uma bomba no mercado financeiro na última semana, mas para quem vive dentro do datacenter, o som foi diferente. O investimento estratégico de US$ 5 bilhões da Nvidia na Intel não é apenas um resgate de um gigante em dificuldades ou uma jogada de diversificação de manufatura. É um sinal claro de que o gargalo da inteligência artificial deixou de ser o processamento e passou a ser o armazenamento e a movimentação de dados.

Jensen Huang não assinou esse cheque por caridade. Ele o fez porque as GPUs H100 e Blackwell estão famintas, e a infraestrutura atual de armazenamento x86 não consegue alimentá-las rápido o suficiente. Para o profissional de TI, do arquiteto de soluções enterprise ao entusiasta do homelab, isso valida uma mudança tectônica que estávamos esperando: a fusão definitiva entre memória e storage.

Resumo em 30 segundos

- O motivo real: A Nvidia precisa que a Intel sobreviva e inove na arquitetura x86 para garantir que os dados cheguem às GPUs sem latência, validando o padrão CXL.

- O impacto no rack: A distinção entre RAM e SSDs NVMe de alto desempenho vai desaparecer. Espere ver "pools de memória" compartilhados via hardware em breve.

- O futuro: Servidores deixarão de ter armazenamento local isolado para adotar arquiteturas desagregadas, onde terabytes de dados residem em um tier híbrido de velocidade extrema.

O acordo que sacudiu o Vale do Silício

Enquanto Wall Street discute margens e foundries, nós precisamos olhar para o barramento. A Intel, apesar de seus tropeços recentes na litografia, ainda é a guardiã do padrão PCIe e, mais importante, do CXL (Compute Express Link).

A Nvidia tem seu próprio ecossistema de interconexão proprietário, o NVLink, que é fantástico para fazer GPUs conversarem entre si. No entanto, essas GPUs ainda precisam buscar dados no "mundo real" — bancos de dados SQL, data lakes de objetos e sistemas de arquivos distribuídos que rodam em CPUs x86.

Se a Intel falhasse em entregar a próxima geração de controladores de I/O e pistas PCIe Gen6/Gen7, o roadmap da Nvidia encontraria um muro de tijolos. Este investimento garante que a "encanamento" dos servidores continue evoluindo para suportar a pressão da água que a Nvidia quer bombear.

Por que a Nvidia precisa da Intel (e dos seus dados)

O problema atual do armazenamento de alto desempenho é a "latência de cauda" e a largura de banda da memória. SSDs NVMe Gen5 são rápidos, chegando a 14 GB/s, mas comparados à largura de banda da memória HBM3e das GPUs, eles são lentos.

A Nvidia percebeu que não adianta ter um motor de Ferrari se o tanque de combustível (o storage) alimenta o motor através de um canudo de refrigerante.

💡 Dica Pro: Em ambientes de alta performance, pare de olhar apenas para IOPS. O novo rei métrico é a latência sob carga e a coerência de cache. É aqui que a parceria Intel-Nvidia vai atuar, otimizando o caminho direto do SSD para a VRAM da GPU (GPUDirect Storage) via plataformas Intel Xeon otimizadas.

O efeito imediato nos racks: aceleração do CXL

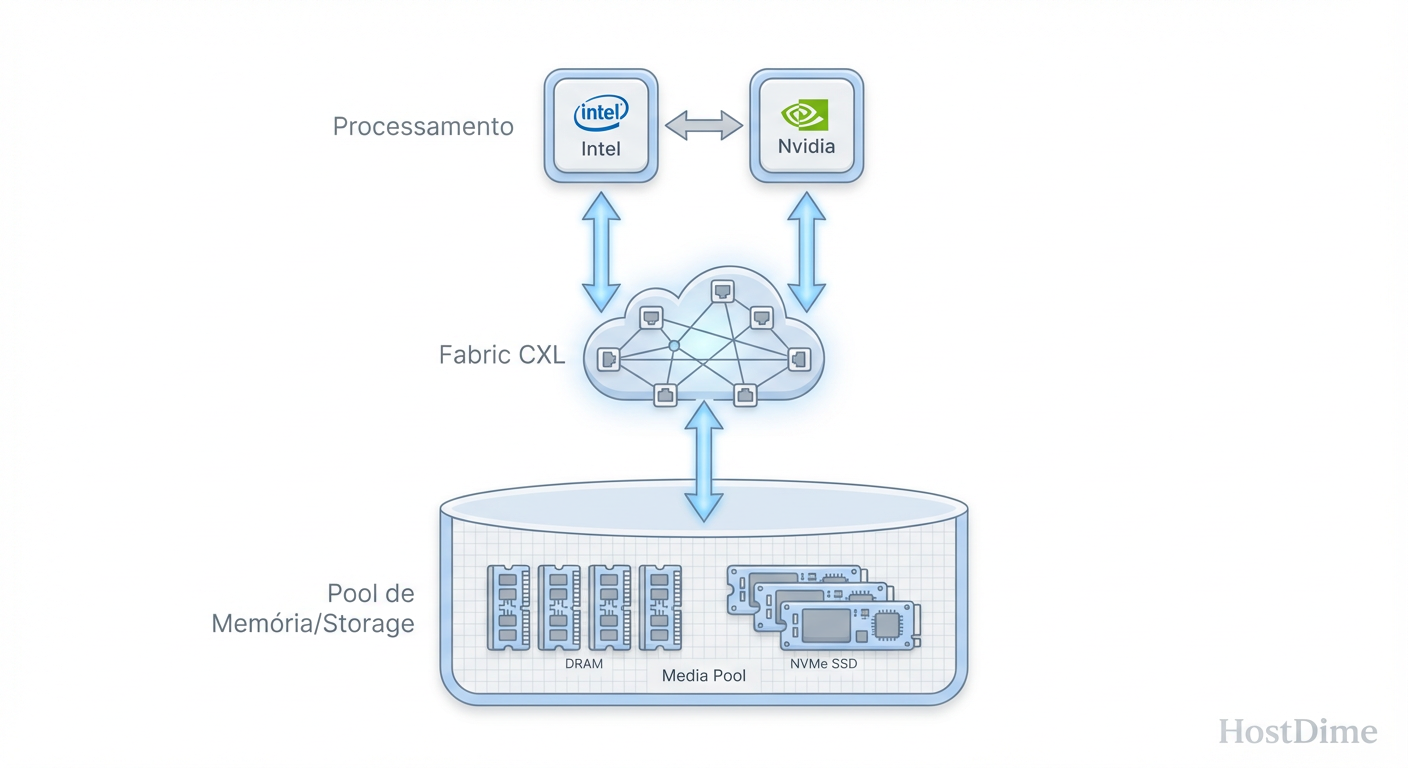

Aqui é onde a borracha encontra o asfalto para o administrador de sistemas. O CXL é um protocolo aberto construído sobre a interface física do PCIe que permite que a CPU e os aceleradores (como GPUs) compartilhem memória de forma coerente.

Com o dinheiro da Nvidia fluindo, a adoção do CXL deve acelerar drasticamente. Isso significa que, em vez de comprar um servidor com 24 slots de DIMM e 8 baias de NVMe, veremos racks onde a memória e o armazenamento são recursos fluidos.

Fig 1. O novo paradigma: Desagragação de memória e storage via CXL.

Fig 1. O novo paradigma: Desagragação de memória e storage via CXL.

Isso cria uma nova categoria de hardware que fica entre a RAM e o SSD: a Storage Class Memory (SCM) acessível via CXL. Dispositivos que têm a persistência do flash, mas velocidades próximas da DRAM.

Tabela: O salto geracional no acesso aos dados

| Característica | Arquitetura Atual (PCIe Gen4/5) | Nova Arquitetura (CXL 2.0/3.0) |

|---|---|---|

| Acesso à Memória | Isolado por CPU (NUMA local) | Compartilhado (Pool de Memória) |

| Latência de Storage | Alta (Protocolo NVMe overhead) | Baixa (Semântica de Memória) |

| Expansão | Limitada aos slots da placa-mãe | Expansível via gavetas CXL externas |

| Uso de Dados | Cópia do SSD para RAM para GPU | Acesso direto e coerente |

O fim do gargalo PCIe e a ascensão do 'Far Memory'

Para o mercado de armazenamento, isso valida o conceito de "Far Memory". Imagine um tier de armazenamento que é mais lento que a RAM DDR5 local, mas muito mais barato e com capacidades de petabytes, e muito mais rápido que um array All-Flash tradicional.

Isso muda como projetamos clusters de armazenamento, seja um TrueNAS em escala enterprise ou um Ceph cluster.

⚠️ Perigo: O hardware legado baseado em SATA e SAS está com os dias contados para cargas de trabalho de performance. Se você está planejando infraestrutura para os próximos 5 anos, investir pesado em controladores SAS tradicionais para aplicações de IA/Analytics pode ser um erro de CAPEX. O futuro é NVMe sobre tecidos (NVMe-oF) e CXL.

A Intel tem a tecnologia para fazer isso funcionar nos processadores Xeon, e a Nvidia tem a necessidade de consumir isso. O investimento garante que o desenvolvimento de controladores que suportam esse tráfego híbrido não pare por falta de verba em P&D.

O que esperar da próxima geração de servidores

O impacto físico nos servidores será visível. O formato M.2, que já é problemático termicamente em servidores, deve dar lugar definitivo aos formatos EDSFF (E1.S e E3). Esses "discos" são projetados para lidar com o calor gerado por controladores que agora precisam processar dados em velocidades de barramento de memória.

Veremos menos servidores de armazenamento "burros" (apenas discos e uma CPU fraca) e mais JBOFs (Just a Bunch of Flash) inteligentes conectados via CXL, que podem ser dinamicamente alocados para qualquer servidor no rack.

Se você gerencia um Data Center ou um Home Lab avançado, prepare-se. A próxima atualização de hardware não será sobre "mais terabytes por disco", mas sobre como conectar esses terabytes diretamente ao cérebro do sistema sem intermediários.

Previsão

O cheque da Nvidia não salvou apenas a Intel; ele salvou o roadmap de desempenho do armazenamento para a próxima década. Estamos caminhando para um futuro onde a linha entre "Memória RAM" e "Disco de Armazenamento" deixará de existir para o sistema operacional. Nos próximos 24 meses, espere ver as primeiras appliances de "Memory-Attached Storage" chegarem ao mercado mainstream, aposentando definitivamente a latência como a conhecemos.

Perguntas Frequentes

1. Isso significa que meus HDDs mecânicos morreram? Não. Para armazenamento frio (arquivamento, backups, mídia), o custo por TB do HDD ainda é imbatível. A revolução Nvidia/Intel afeta a camada de performance (Hot/Warm Data), onde os dados são processados ativamente.

2. O que é CXL e por que devo me importar? CXL (Compute Express Link) é uma tecnologia que usa o slot PCIe para conectar memória e processadores. Diferente do PCIe comum, ele mantém a coerência de cache. Para storage, isso permite criar SSDs que o computador enxerga quase como se fossem pentes de memória RAM extra.

3. Como isso afeta meu Home Lab ou servidor TrueNAS? A curto prazo, pouco. A tecnologia CXL e hardware Enterprise de ponta demoram cerca de 3 a 5 anos para "descer" ao mercado de usados ou prosumer. No entanto, espere que SSDs NVMe U.2 e E1.S fiquem mais comuns e baratos no mercado secundário à medida que as empresas migram para as novas arquiteturas.

4. A Nvidia vai fabricar SSDs? Improvável. O interesse da Nvidia é no caminho dos dados, não na mídia em si. Eles querem garantir que a Intel produza CPUs e placas-mãe capazes de trafegar dados rápido o suficiente para suas GPUs. Quem fabrica o NAND (Samsung, Micron, Kioxia) continua igual.

Mariana Costa

Repórter de Tecnologia (Newsroom)

"Cubro o universo de TI corporativa com agilidade jornalística. Minha missão é traduzir o 'tech-speak' de datacenters e cloud em notícias diretas para sua tomada de decisão."