O Fim da Amnésia Digital: Como o BlueField-4 Redefine o Armazenamento para IA

Análise visionária do NVIDIA BlueField-4 e a nova era da 'Inference Context Memory'. Descubra como o armazenamento de 800Gbps elimina o gargalo do Cache KV em IA Agentic.

Estamos testemunhando uma inversão fundamental na arquitetura de computação. Durante quarenta anos, o processador central (CPU) foi o regente soberano, e o armazenamento era apenas um armazém passivo de bits, aguardando ordens. Essa era acabou.

A ascensão dos Grandes Modelos de Linguagem (LLMs) e da IA Agêntica expôs uma falha crítica na nossa infraestrutura: a "amnésia digital". Modelos de IA são brilhantes, mas têm memória curta. Para torná-los capazes de lembrar conversas longas, contextos jurídicos inteiros ou históricos médicos de décadas, precisamos de uma nova camada de infraestrutura.

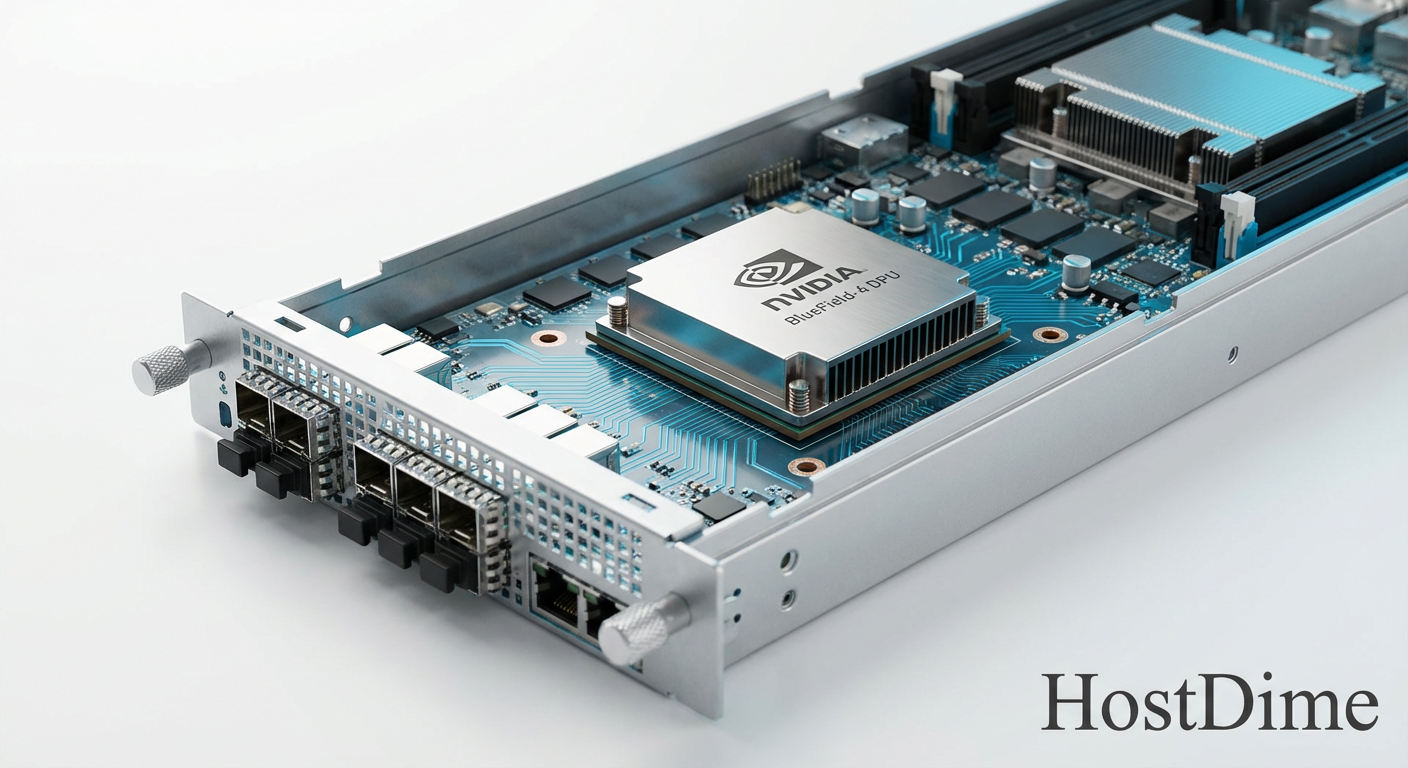

É aqui que entra o NVIDIA BlueField-4. Não olhe para ele como uma placa de rede. Ele é o prenúncio de uma era onde o armazenamento se torna computacional, inteligente e, crucialmente, independente da CPU x86.

Resumo em 30 segundos

- O Gargalo: A memória RAM dos servidores não comporta o "Cache KV" (memória de contexto) necessário para IAs avançadas, e os SSDs tradicionais são lentos demais para acessos aleatórios massivos.

- A Solução: O BlueField-4 atua como um "cérebro de armazenamento", movendo dados de SSDs NVMe diretamente para a GPU a 800 Gbps, ignorando completamente a CPU principal.

- O Futuro: A arquitetura de servidores está mudando de "Centrada na CPU" para "Centrada nos Dados", onde o armazenamento possui sua própria inteligência de processamento.

A emergência da memória de contexto como novo gargalo

Na computação clássica, o gargalo era o processamento. Na era da IA Generativa, o gargalo é a memória de contexto, tecnicamente conhecida como Cache KV (Key-Value).

Imagine que você está conversando com uma IA sobre um livro de 500 páginas. Cada palavra que você e a IA trocam precisa ser armazenada e acessada instantaneamente para que a próxima resposta faça sentido. Quando escalamos isso para milhões de usuários ou para agentes autônomos que precisam "lembrar" de semanas de operação, o Cache KV cresce para a casa dos Terabytes.

A DRAM (memória RAM) é rápida, mas custa cerca de US$ 100 por gigabyte em escala enterprise e é volátil. O armazenamento Flash (NVMe SSD) custa centavos por gigabyte, mas é ordens de magnitude mais lento. O abismo entre esses dois mundos é onde a performance da IA morre.

💡 Dica Pro: Em seus Home Labs ou servidores TrueNAS, você já sente isso ao tentar rodar modelos locais (como Llama-3) com contextos longos. Se o modelo não couber na VRAM da GPU ou na RAM do sistema, o "swap" para o disco mata a performance, reduzindo a geração de tokens para quase zero.

O BlueField-4 não é apenas sobre velocidade de rede; é sobre mascarar a latência do armazenamento para que os SSDs pareçam comportar-se como memória RAM estendida.

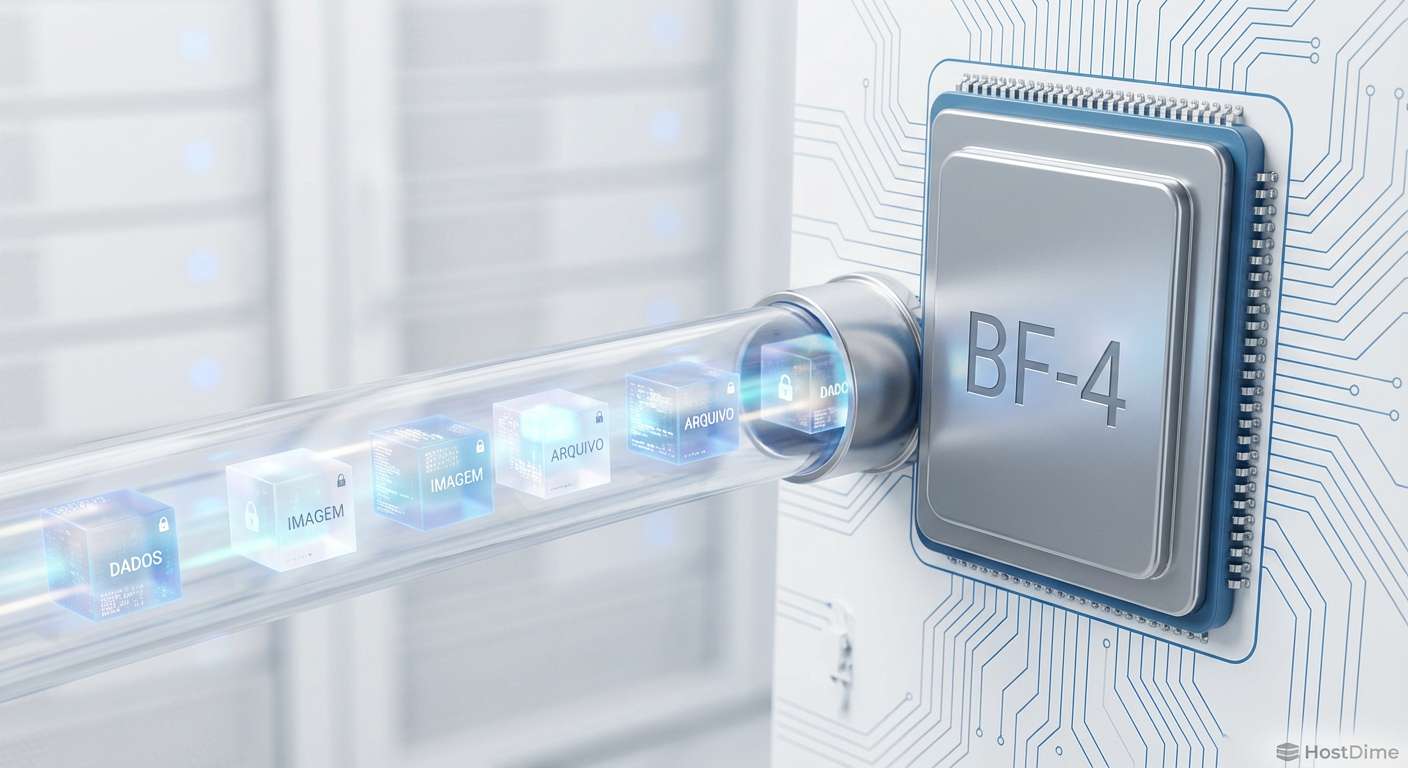

Figura: O fluxo de dados moderno: O BlueField-4 cria uma ponte direta entre o armazenamento NVMe e as GPUs, deixando a CPU x86 obsoleta para a movimentação de dados.

Figura: O fluxo de dados moderno: O BlueField-4 cria uma ponte direta entre o armazenamento NVMe e as GPUs, deixando a CPU x86 obsoleta para a movimentação de dados.

Anatomia do BlueField-4: Quando o controlador de disco vira um servidor

Para entender o salto geracional, precisamos olhar para o silício. O BlueField-4, previsto para consolidação total no mercado enterprise entre 2026 e 2027, dobra a aposta feita por seu antecessor. Não estamos mais falando de um "acelerador". Estamos falando de um computador completo em um slot PCIe.

Com conectividade de 800 Gbps (via Ethernet ou InfiniBand NDR), ele possui largura de banda suficiente para saturar arranjos inteiros de SSDs NVMe Gen5 ou os emergentes Gen6. Mas o segredo não é a velocidade do link, é o que acontece dentro do chip.

Ele integra dezenas de núcleos ARM Neoverse dedicados exclusivamente a gerenciar o tráfego de armazenamento. Isso significa que tarefas pesadas como Erasure Coding (substituto moderno do RAID), compressão LZ4/Zstd em tempo real e encriptação XTS-AES-512 são executadas no hardware da DPU, sem tocar na CPU do servidor.

Comparativo: A Evolução da DPU no Armazenamento

| Recurso | BlueField-3 (Estado da Arte 2024/25) | BlueField-4 (Próxima Geração) | Impacto no Storage |

|---|---|---|---|

| Throughput de Rede | 400 Gbps | 800 Gbps | Permite acesso remoto a NVMe (NVMe-oF) com velocidade de barramento local. |

| Processamento | 16 Cores ARM A78 | ~64 Cores ARM (Est.) | Capacidade de rodar um OS de storage completo (ex: Ceph/MinIO) na própria placa. |

| Memória | DDR5 Integrada | HBM ou DDR5 Otimizada | Cache massivo para tabelas de metadados de sistemas de arquivos distribuídos. |

| PCIe | Gen 5.0 | Gen 6.0 / CXL 3.0 | Coerência de memória real entre o disco e a GPU. |

O impacto de 800 Gbps na latência de cauda do Cache KV

A métrica que mata a experiência do usuário em IA não é a largura de banda média, é a latência de cauda (P99). É aquele momento em que o sistema "engasga" para buscar um dado antigo no disco.

Com 800 Gbps, o BlueField-4 permite que o armazenamento seja desagregado. Em vez de ter discos presos dentro do servidor de GPU (onde o espaço é físico e termicamente limitado), você pode ter um chassi JBOF (Just a Bunch of Flash) cheio de SSDs E1.S a metros de distância.

Graças a tecnologias como GPUDirect Storage (GDS), o BlueField-4 coordena a cópia dos dados do Cache KV armazenados nesses SSDs remotos diretamente para a memória HBM da GPU. O tempo de acesso cai de milissegundos (uma eternidade para a IA) para microssegundos.

⚠️ Perigo: Para arquitetos de infraestrutura, isso significa que a rede é o novo barramento de armazenamento. Se o seu switch ou cabeamento não suportar RDMA (RoCE v2) com controle de congestionamento perfeito, seus SSDs NVMe de última geração terão a performance de um HD SATA antigo.

Figura: A autoestrada de 800 Gbps: Onde a rede se funde com o barramento de armazenamento, exigindo precisão de microssegundos.

Figura: A autoestrada de 800 Gbps: Onde a rede se funde com o barramento de armazenamento, exigindo precisão de microssegundos.

A obsolescência da CPU x86 na orquestração de dados

Esta é a previsão mais controversa, mas inevitável: a CPU x86 (Intel Xeon/AMD EPYC) está se tornando um gerente de meio-nível caro e ineficiente para tarefas de I/O.

Em um servidor de armazenamento tradicional (como um TrueNAS Scale ou um nó Ceph), a CPU precisa:

Receber a interrupção da rede.

Ler o pacote.

Calcular onde o dado deve ser escrito.

Falar com o controlador NVMe.

Confirmar a gravação.

Esse "ping-pong" de dados consome ciclos preciosos e polui o cache L3 da CPU. Com o BlueField-4, a CPU x86 é contornada. A DPU fala a língua do NVMe (NVMe over Fabrics) e gerencia o sistema de arquivos. A CPU principal fica livre para o que ela faz de melhor: lógica de aplicação complexa, não movimentação de bits.

Estamos caminhando para um futuro onde o chassi de armazenamento não terá uma placa-mãe tradicional, mas sim um backplane PCIe onde DPUs e SSDs conversam diretamente.

O custo oculto da integração vertical no ecossistema DOCA

Nem tudo é utopia. A NVIDIA está construindo com o BlueField e seu framework de software, o DOCA, o que ela fez com as GPUs e o CUDA: um jardim murado (Walled Garden).

Para extrair o desempenho máximo do BlueField-4 em armazenamento, você não escreve drivers genéricos para Linux; você programa para o DOCA. Isso cria uma dependência profunda. Enquanto protocolos como NVMe são abertos, a inteligência de como gerenciar esses dados está sendo proprietarizada.

Para o entusiasta de Home Lab ou o pequeno provedor de nuvem, isso levanta uma barreira de entrada. O hardware é incrível, mas a complexidade de software para fazê-lo funcionar fora dos grandes datacenters (Hyperscalers) é imensa. Hoje, configurar um offload de NVMe-oF em uma DPU exige conhecimentos avançados que vão muito além de "criar um pool ZFS".

Veredito Técnico

O BlueField-4 não é apenas uma atualização de velocidade; é uma redefinição de papéis no datacenter. Para a IA continuar evoluindo e superando sua "amnésia digital", o armazenamento precisa deixar de ser um repositório estático e tornar-se um fluxo dinâmico de memória.

Se você trabalha com infraestrutura de dados, prepare-se: nos próximos 5 anos, a distinção entre "Rede" e "Armazenamento" desaparecerá. Tudo será um tecido de dados unificado, e a DPU será o tear que tece essa realidade. A CPU x86? Ela estará lá, mas talvez apenas assistindo.

Perguntas Frequentes (FAQ)

O que é exatamente o NVIDIA BlueField-4?

É a quarta geração de DPUs (Data Processing Units) da NVIDIA, projetada para ser o centro nervoso de servidores modernos. Mais do que uma placa de rede, ela integra uma CPU ARM massiva e conectividade de 800 Gbps, permitindo gerenciar todo o tráfego de armazenamento e segurança sem incomodar o processador principal do servidor.Por que o Cache KV é tão crítico para a IA atual?

O Cache KV (Key-Value) é a "memória de curto prazo" de um modelo de IA. Em sistemas de IA Agêntica, que precisam manter conversas longas e complexas, esse cache cresce exponencialmente. O BlueField-4 resolve o problema de armazenar e recuperar esses dados gigantescos rápido o suficiente para que a IA não "trave" enquanto pensa.Qual a diferença entre uma SuperNIC e uma DPU como a BlueField?

Pense na SuperNIC como um "cano" extremamente rápido e otimizado para evitar congestionamento em redes de IA. Já a DPU (como o BlueField-4) é um "computador no cano". Ela não só transporta dados, mas pode rodar sistemas operacionais, encriptar discos e gerenciar bancos de dados inteiros antes mesmo de os dados chegarem ao servidor.

Julian Vance

Futurista de Tecnologia

"Exploro as fronteiras da infraestrutura, do armazenamento em DNA à computação quântica. Ajudo líderes a decodificar o horizonte tecnológico e construir o datacenter de 2035 hoje."