OpenZFS 2.3 e a Nova Economia de Escala: RAIDZ Expansion e Fast Dedup

O fim do overprovisioning? Analisamos como o RAIDZ Expansion e o Fast Dedup do OpenZFS 2.3 alteram radicalmente o TCO e o planejamento de capacidade em storage enterprise e home labs.

O lançamento do OpenZFS 2.3 marca um ponto de inflexão na arquitetura de armazenamento definida por software. Durante mais de uma década, arquitetos de infraestrutura conviveram com duas verdades inconvenientes no ecossistema ZFS: a rigidez geométrica dos VDEVs e o custo proibitivo da memória RAM para deduplicação.

A nova versão ataca frontalmente esses débitos técnicos. Não se trata apenas de novas features, mas de uma mudança na matemática fundamental de como alocamos capital (CapEx) e gerenciamos o crescimento (OpEx) em storage servers. No entanto, como em qualquer sistema distribuído complexo, a "mágica" da expansão e da deduplicação rápida esconde trade-offs de latência e ciclos de CPU que precisam ser dissecados antes de serem implantados em produção.

Resumo em 30 segundos

- Fim do "Lock-in" de VDEV: O RAIDZ Expansion permite adicionar discos individuais a um grupo RAIDZ existente, eliminando a necessidade de comprar arrays inteiros para expandir capacidade.

- Deduplicação Viável: O "Fast Dedup" remove a dependência massiva de RAM (a antiga regra de 5GB/TB), movendo a tabela de deduplicação (DDT) para SSDs de forma eficiente.

- Custo de Reescrita: A expansão não redistribui dados antigos automaticamente; eles permanecem com a geometria antiga até serem reescritos, criando um cenário híbrido de performance.

A paralisia do planejamento de capacidade

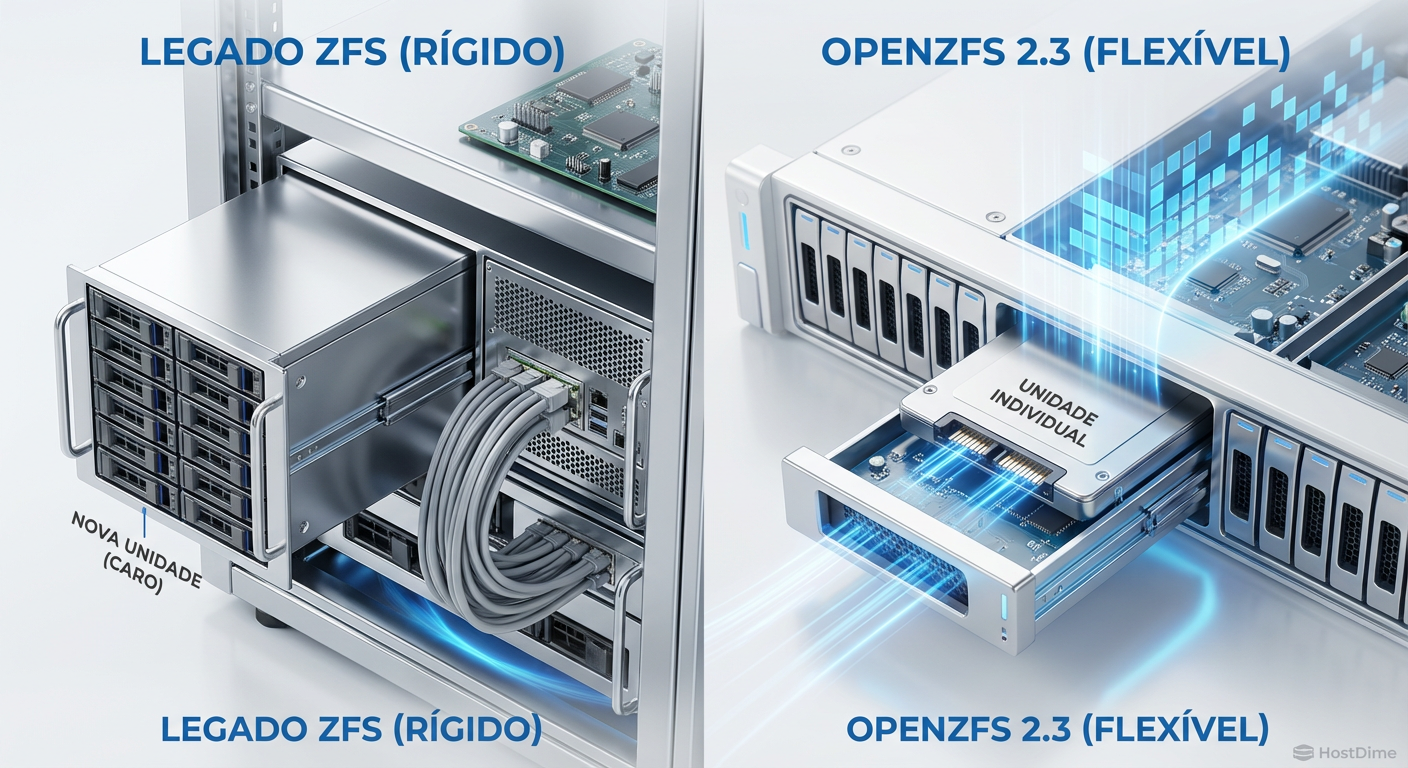

Historicamente, o ZFS impunha um dilema cruel no "Dia Zero" da infraestrutura. Se você criasse um pool com um RAIDZ2 de 6 discos, aquela geometria era imutável. Para expandir, você não podia simplesmente adicionar um sétimo disco; era necessário adicionar um novo VDEV inteiro (outros 6 discos, idealmente) ou substituir todos os discos existentes por maiores, um a um (o processo de resilvering).

Isso gerava o que chamo de "paralisia de provisionamento". Empresas compravam 24 ou 36 baias totalmente povoadas no dia um, superalocando capital para evitar a dor de cabeça da expansão futura.

Figura: Comparativo visual: A rigidez da expansão por VDEV versus a granularidade da nova expansão RAIDZ.

Figura: Comparativo visual: A rigidez da expansão por VDEV versus a granularidade da nova expansão RAIDZ.

Com o OpenZFS 2.3, essa barreira cai. A capacidade de anexar um disco a um grupo RAIDZ existente altera o TCO (Total Cost of Ownership) de projetos de long-term archive e home labs. Você pode começar com o mínimo viável e crescer conforme a demanda de dados, alinhando o gasto de hardware com a curva de receita ou utilidade.

A matemática da expansão e o mecanismo de reflow

É vital entender que o RAIDZ Expansion não é mágica; é uma redistribuição de paridade. Quando você adiciona um disco a um RAIDZ de 4 discos (transformando-o em 5), o ZFS não reescreve todos os terabytes de dados existentes instantaneamente. Fazer isso travaria o array por dias.

Em vez disso, o sistema opera em um estado de geometria mista:

Dados Antigos: Permanecem com a largura de stripe original (distribuídos em 4 discos).

Dados Novos: São gravados utilizando a nova largura (distribuídos em 5 discos).

💡 Dica Pro: Para unificar a performance e recuperar o espaço desperdiçado pela paridade antiga, você deve forçar uma reescrita dos dados. A maneira mais simples (embora custosa em IOPS) é executar um

zfs send | zfs recvpara si mesmo ou usar ferramentas de rebalanceamento, embora o próprio ciclo de vida dos dados (exclusão e nova gravação) resolva isso organicamente ao longo do tempo.

Tabela Comparativa: Expansão Tradicional vs. RAIDZ Expansion

| Característica | Adicionar Novo VDEV (Método Antigo) | RAIDZ Expansion (Novo Método) |

|---|---|---|

| Granularidade | Baixa (Requer múltiplos discos) | Alta (1 disco por vez) |

| Impacto na Redundância | Aumenta (Mais discos de paridade no total) | Mantém (Mesmo nível de paridade, ex: Z2) |

| Eficiência de Espaço | Estática (Perde-se % fixo para paridade) | Melhora (A proporção dados/paridade aumenta) |

| Performance de IOPS | Aumenta (Mais VDEVs = Mais IOPS) | Mantém/Leve Queda (Mesmo VDEV, mais cálculo) |

| Complexidade Operacional | Baixa (Instantâneo) | Média (Requer tempo de rebalanceamento/reflow) |

Fast Dedup: O fim da "Regra dos 5GB de RAM"

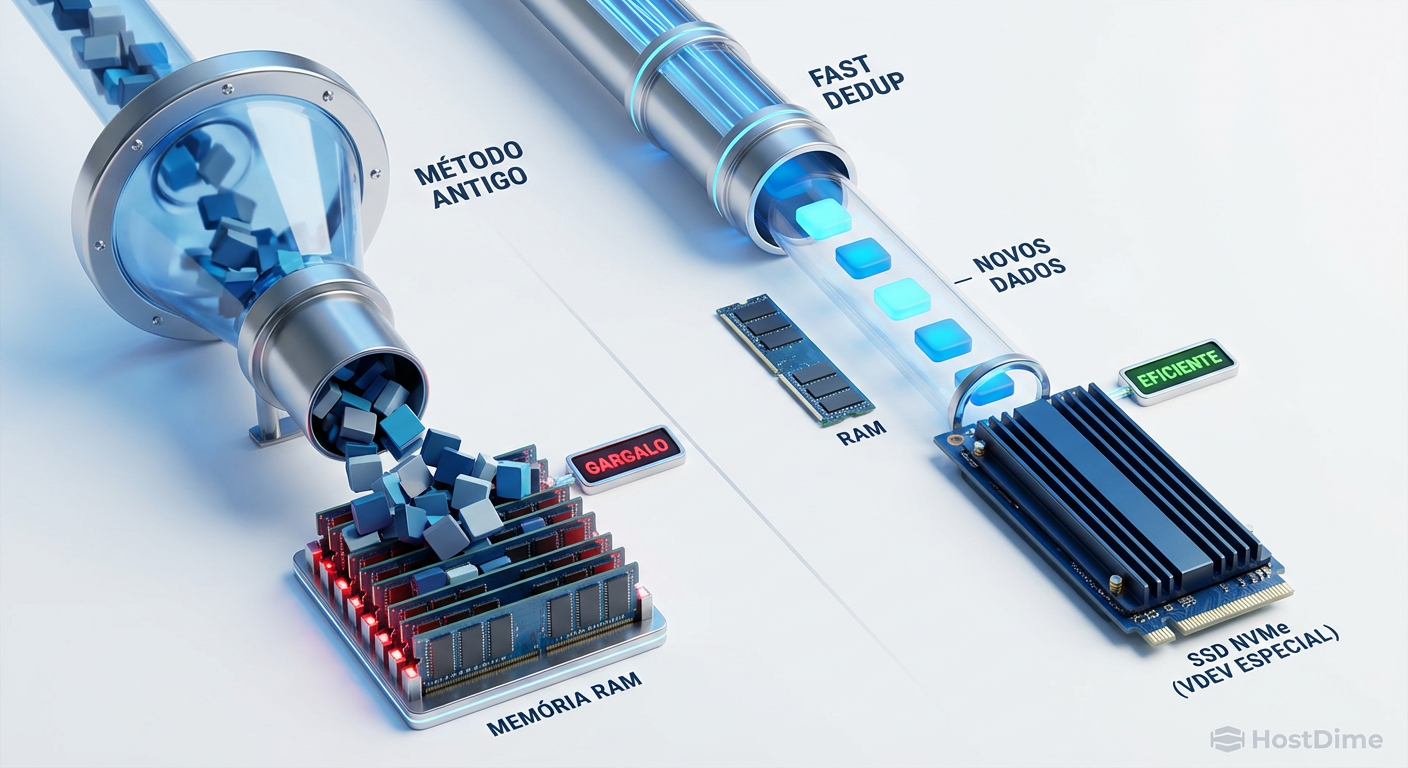

Se o RAIDZ Expansion resolve o problema do armazenamento bruto, o Fast Dedup resolve o problema da eficiência lógica. Durante anos, a resposta padrão de qualquer engenheiro de storage sênior para a pergunta "Devo ativar a deduplicação no ZFS?" era um sonoro NÃO.

O motivo era a Tabela de Deduplicação (DDT). No modelo antigo, se a DDT não coubesse inteiramente na RAM (ARC), cada gravação de bloco exigiria leituras aleatórias no disco para verificar a existência do hash. Isso resultava no temido "thrashing", onde a performance de um array NVMe caía para níveis de HDD USB 2.0. A regra prática era ter 1GB a 5GB de RAM para cada 1TB de dados deduplicados. Economicamente inviável.

Figura: A arquitetura Log-Structured do Fast Dedup permitindo o despejo eficiente de metadados para SSDs.

Figura: A arquitetura Log-Structured do Fast Dedup permitindo o despejo eficiente de metadados para SSDs.

O Fast Dedup (ou Dedup v2) introduz uma arquitetura baseada em logs e um gerenciamento de metadados otimizado. Agora, o ZFS pode despejar a DDT para discos rápidos (idealmente configurados como Special VDEVs em espelhos NVMe) sem destruir a latência de gravação.

Onde o Fast Dedup faz sentido hoje?

Apesar da melhoria, a deduplicação ainda consome CPU (cálculo de SHA-256 ou Edon-R). O uso indiscriminado continua sendo um erro. O cenário ideal mudou de "nunca use" para:

Ambientes de Virtualização (Proxmox/VMware): Onde centenas de VMs compartilham o mesmo OS base.

Servidores de Build/CI: Onde bibliotecas (node_modules, target folders) são repetidas infinitamente.

Backup Targets: Repositórios de snapshots brutos.

⚠️ Perigo: Não ative deduplicação em datasets com dados criptografados ou comprimidos previamente (como arquivos .zip ou vídeos). A entropia desses arquivos torna a deduplicação inútil, desperdiçando ciclos de CPU para economizar zero bytes.

O trade-off entre Ciclos de CPU e Armazenamento Bruto

Ao projetar soluções Enterprise, a decisão de usar essas novas features deve passar por uma análise de custo de oportunidade. O armazenamento (especialmente HDD mecânico) está barato. O custo por TB de um disco SAS de 20TB é historicamente baixo. Em contrapartida, núcleos de CPU de alta performance e pistas PCIe para NVMe (para suportar o Fast Dedup) são recursos finitos e caros.

A pergunta que você deve fazer não é "posso usar deduplicação?", mas sim: "O custo da CPU extra e dos SSDs para metadados é menor que o custo de simplesmente comprar mais HDDs?"

Para Home Labs e entusiastas, a equação inverte. O custo de energia (Watts) e o espaço físico no gabinete são os limitadores. Nesse cenário, maximizar a eficiência de cada TB com RAIDZ Expansion e Dedup (para economizar slots de disco) é uma estratégia vencedora.

Figura: O equilíbrio delicado entre o custo computacional (CPU/RAM) e o custo de armazenamento bruto (HDD).

Figura: O equilíbrio delicado entre o custo computacional (CPU/RAM) e o custo de armazenamento bruto (HDD).

Veredito Técnico

O OpenZFS 2.3 remove as algemas arquiteturais que limitavam a adoção do ZFS em cenários de crescimento orgânico e orçamentos apertados. O RAIDZ Expansion é a feature que democratiza o ZFS para pequenas e médias empresas que não podem comprar racks inteiros de uma vez. O Fast Dedup transforma a deduplicação de uma armadilha perigosa em uma ferramenta tática viável.

No entanto, a complexidade não desapareceu; ela apenas se moveu. A complexidade de hardware (comprar muitos discos) tornou-se complexidade de software (gerenciar reflows, monitorar overhead de CPU). Para o arquiteto sênior, a recomendação é cautela: teste o comportamento de expansão em ambiente de staging e valide se o seu workload realmente se beneficia da deduplicação antes de ativá-la globalmente.

FAQ: Perguntas Frequentes

O RAIDZ Expansion reescreve todos os dados antigos automaticamente?

Não. O OpenZFS 2.3 utiliza um mecanismo de 'reflow' sob demanda. Os dados antigos permanecem com a largura de stripe original até serem reescritos, enquanto novos dados utilizam a nova largura do array. Isso evita um impacto massivo de IOPS imediato, mas cria uma geometria mista no disco.O Fast Dedup elimina a necessidade de muita memória RAM?

Depende. O Fast Dedup reduz drasticamente a penalidade de performance e o 'bloqueio' da RAM ao usar uma abordagem baseada em logs (log-structured) e melhor gerenciamento de metadados, permitindo que o DDT (Deduplication Table) seja despejado para SSDs rápidos (Special VDEVs) sem matar a performance do pool. A regra antiga de '5GB de RAM por TB de Dedup' torna-se obsoleta, mas a RAM ainda é benéfica para cache (ARC).Posso converter um RAIDZ1 para RAIDZ2 com a expansão?

Não. A funcionalidade de expansão permite adicionar discos para aumentar a largura do stripe (ex: 4 discos para 5 discos), mas não permite alterar o nível de paridade (ex: adicionar um segundo disco de paridade a um grupo existente). A redundância original é mantida.Referências & Leitura Complementar

OpenZFS GitHub Repository - Pull Request #15374 (RAIDZ Expansion Implementation details).

OpenZFS Developer Summit 2024 - Apresentações técnicas sobre a arquitetura do Fast Dedup e benchmarks de performance.

SNIA (Storage Networking Industry Association) - Definições de arquitetura Log-Structured e impacto em mídia NAND.

FreeBSD Foundation - Relatórios de implementação do OpenZFS 2.3 no kernel do FreeBSD.

Otávio Henriques

Arquiteto de Soluções Enterprise

"Com duas décadas desenhando infraestruturas críticas, olho além do hype. Foco em TCO, resiliência e trade-offs, pois na arquitetura corporativa a resposta correta quase sempre é 'depende'."