OpenZFS 2.3: O Fim da Rigidez com RAIDZ Expansion e Fast Dedup

Análise técnica do OpenZFS 2.3. Descubra como o RAIDZ Expansion e o Fast Dedup mudam a economia do armazenamento self-hosted. Guia completo de engenharia.

Se você já teve que explicar para o seu cônjuge ou para o departamento financeiro por que precisa comprar seis discos rígidos de uma vez só para aumentar o armazenamento em apenas alguns Terabytes, você conhece a dor do ZFS. Durante anos, a arquitetura do ZFS foi sinônimo de integridade de dados absoluta, mas também de uma rigidez orçamentária brutal.

Nós, entusiastas de homelab e operadores de infraestrutura self-hosted, sempre olhamos com inveja para soluções como Unraid ou Synology SHR, que permitem adicionar "apenas mais um disco". O ZFS exigia a criação de um novo vdev inteiro ou a substituição de todos os discos por maiores, um por um. Era seguro, era rápido, mas era caro.

Com a chegada do OpenZFS 2.3, essa era de inflexibilidade está chegando ao fim. Estamos falando da implementação oficial do RAIDZ Expansion e do tão aguardado Fast Dedup. Vamos mergulhar no que isso significa para o seu rack, para a sua carteira e para a performance do seu pool.

Resumo em 30 segundos

- RAIDZ Expansion: Agora é possível adicionar um único disco a um vdev RAIDZ (1, 2 ou 3) existente, sem precisar recriar o pool.

- Fast Dedup: A deduplicação deixa de ser um "assassino de RAM". Novos algoritmos permitem que a Tabela de Deduplicação (DDT) seja gerenciada de forma eficiente em SSDs (Special VDEVs) sem destruir a performance de escrita.

- Custo vs. Performance: A expansão não reescreve dados antigos imediatamente, o que gera uma leve ineficiência de espaço até que os dados sejam rotacionados, mas economiza horas (ou dias) de resilvering.

O dilema do upgrade e a armadilha da memória

Historicamente, o ZFS operava sob uma premissa de imutabilidade estrutural no nível do vdev. Se você criasse um RAIDZ2 com 6 discos, aquela largura de distribuição (stripe width) era gravada na pedra. Para expandir, você tinha duas opções dolorosas:

Adicionar outro vdev: Comprar mais 6 discos e adicioná-los ao pool. Isso dobrava o consumo de energia e exigia um chassi maior.

Substituir e resilverar: Trocar cada um dos 6 discos por um maior (ex: de 4TB para 8TB), esperando o resilver (reconstrução) de cada um. Um processo que podia levar uma semana inteira de estresse nos discos.

Além disso, tínhamos o "monstro" da Deduplicação. A regra de ouro da comunidade sempre foi: não use dedup. A menos que você tivesse 5GB de RAM para cada 1TB de dados deduplicados, a performance de escrita cairia para níveis de disquete assim que a Tabela de Deduplicação (DDT) não coubesse mais na RAM e fosse para o disco.

O OpenZFS 2.3 ataca esses dois problemas fundamentais não com mágica, mas com engenharia de sistemas de arquivos extremamente inteligente.

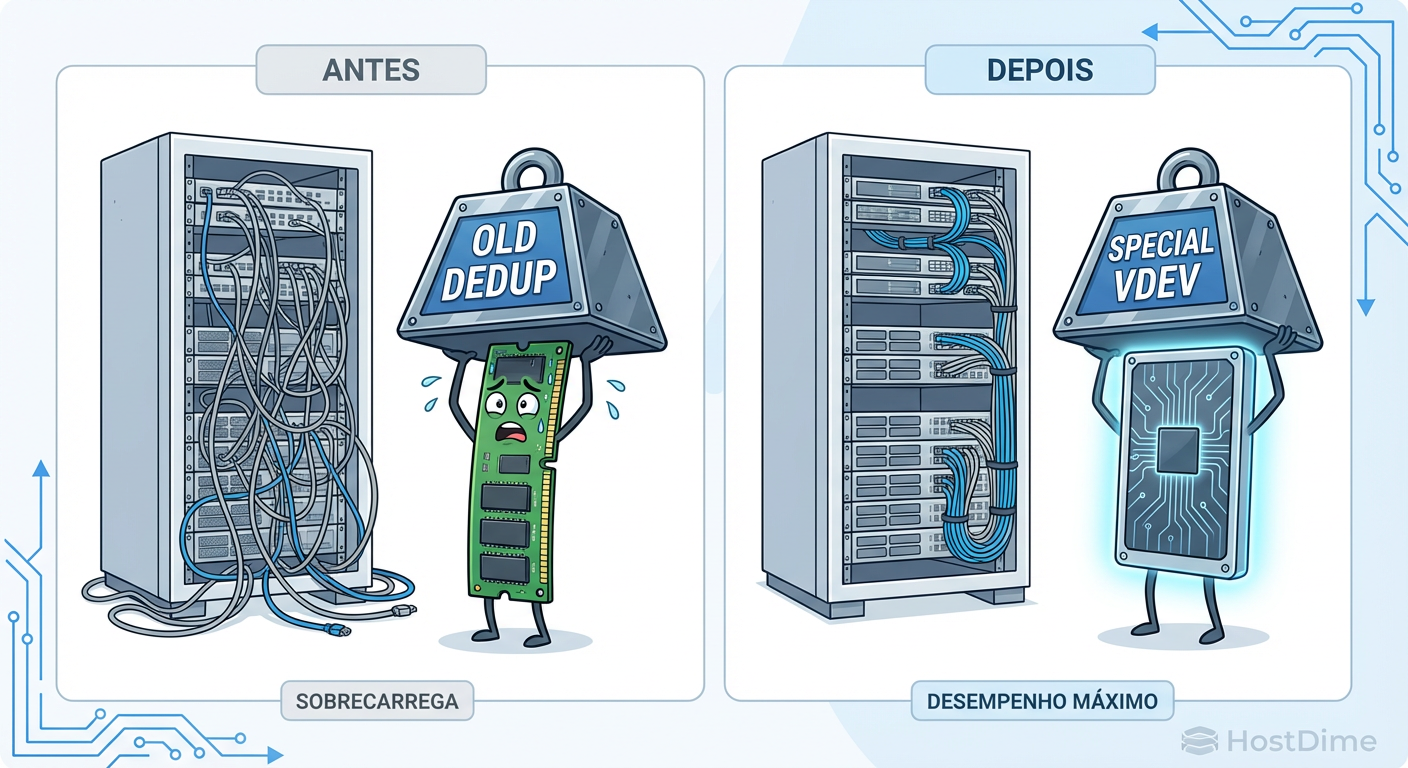

Figura: Comparação visual entre o peso da Deduplicação antiga na RAM e a nova eficiência com Fast Dedup e Special VDEVs.

Figura: Comparação visual entre o peso da Deduplicação antiga na RAM e a nova eficiência com Fast Dedup e Special VDEVs.

A mecânica de reflow do RAIDZ Expansion

A funcionalidade de expansão do RAIDZ foi, por muito tempo, o "Santo Graal" do desenvolvimento do ZFS. Financiada em grande parte pela FreeBSD Foundation e desenvolvida pelo lendário Matt Ahrens, ela funciona de uma maneira diferente do que muitos imaginam.

Quando você adiciona um disco a um grupo RAIDZ existente, o ZFS não redistribui (restripe) todos os dados antigos imediatamente. Fazer isso exigiria ler e reescrever cada bloco do pool, o que seria perigoso e demorado.

Como funciona o "Reflow" lógico

Em vez disso, o ZFS adota uma abordagem híbrida. O espaço do novo disco torna-se imediatamente disponível para novas escritas.

Dados Antigos: Permanecem com a largura de distribuição original. Se você tinha um RAIDZ1 de 3 discos (2 dados + 1 paridade), os dados antigos continuam ocupando essa proporção, apenas "espalhados" logicamente.

Dados Novos: Usam a nova largura de distribuição. O mesmo RAIDZ1 agora com 4 discos passará a gravar na proporção 3 dados + 1 paridade para novos arquivos.

💡 Dica Pro: Para recuperar a eficiência total de espaço após uma expansão, você precisará reescrever os dados antigos. Muitos administradores usam scripts simples que copiam e renomeiam arquivos em background para forçar esse "reflow" para o novo layout.

A matemática do desperdício temporário

Existe um custo oculto aqui. Como os dados antigos não mudam sua proporção de paridade, você não ganha eficiência de paridade retroativa.

Imagine um RAIDZ2 de 4 discos (50% de eficiência). Se você expandir para 10 discos (80% de eficiência), os dados antigos continuarão ocupando o espaço como se estivessem no layout de 50% de eficiência. Apenas os novos dados aproveitarão os 80%. O espaço "ganho" no novo disco é usado, mas a paridade dos dados velhos continua "gorda".

Figura: Diagrama técnico ilustrando como os blocos de dados antigos mantêm o layout original enquanto novos dados aproveitam a densidade do novo disco no RAIDZ Expansion.

Figura: Diagrama técnico ilustrando como os blocos de dados antigos mantêm o layout original enquanto novos dados aproveitam a densidade do novo disco no RAIDZ Expansion.

Fast Dedup: O fim da tabela DDT gigante

A deduplicação no ZFS funciona comparando o hash (checksum) de cada novo bloco gravado com todos os blocos já existentes. Se o hash bater, ele apenas aponta para o bloco existente em vez de gravar um novo.

O problema é que essa tabela de hashes (DDT) é gigantesca e precisa de acesso aleatório rapidíssimo. Em HDDs mecânicos, buscar na DDT é a morte da performance.

O que muda no OpenZFS 2.3

O "Fast Dedup" (frequentemente discutido no contexto de melhorias de alocação e Dedup v2) introduz mudanças estruturais:

Log-based DDT: Em vez de atualizações aleatórias constantes na tabela, as mudanças são agrupadas e gravadas sequencialmente.

Prefetch Inteligente: O sistema prevê melhor quais partes da tabela serão necessárias.

Special VDEVs: Embora já existissem, a integração com o novo algoritmo torna o uso de SSDs/NVMe dedicados para metadados e DDT muito mais eficiente.

Agora, se a sua DDT "vazar" da RAM para um SSD (configurado como Special VDEV), o impacto na performance é mínimo, ao contrário do travamento total que ocorria antes. Isso viabiliza a deduplicação para backups de VMs e contêineres em homelabs sem precisar de 512GB de RAM.

⚠️ Perigo: Mesmo com Fast Dedup, nunca ative a deduplicação em um pool sem vdevs de metadados rápidos (NVMe/SSD). Em HDDs puros, a performance de leitura aleatória ainda sofrerá.

Tabela Comparativa: O Cenário de Expansão

Para situar onde o OpenZFS 2.3 se encaixa no mercado de armazenamento definido por software, veja esta comparação direta:

| Característica | ZFS Tradicional (Pré-2.3) | OpenZFS 2.3 (RAIDZ Expansion) | Unraid / Synology SHR |

|---|---|---|---|

| Adição de Discos | Apenas em pares (Mirrors) ou novos VDEVs inteiros | Um disco por vez em RAIDZ existente | Um disco por vez (qualquer tamanho) |

| Rebalanceamento | N/A (Manual via zfs send/recv) | Automático para novos dados (Reflow manual opcional) | Automático (lento, via paridade) |

| Integridade de Dados | Checksum e Auto-cura total | Checksum e Auto-cura total | Limitada (depende do sistema de arquivos subjacente) |

| Performance | Altíssima (Striping largo) | Alta (Mantém striping) | Média/Baixa (Limitada à velocidade de um disco único + paridade) |

| Uso de RAM | Alto (ARC) | Alto (ARC) | Baixo |

| Complexidade | Alta | Média | Baixa |

Impacto real na performance e operação

No dia a dia de um operador de homelab, essas mudanças alteram o planejamento de hardware.

O comando mágico

A sintaxe é surpreendentemente simples. Se você tem um pool chamado tank e um vdev raidz1-0, o comando é:

zpool attach tank raidz1-0 /dev/disk/by-id/novo-disco-nvme

O sistema iniciará o processo de expansão. O pool permanece online e acessível. A performance de escrita pode degradar ligeiramente durante o processo devido à movimentação de metadados, mas é perfeitamente utilizável para streaming de mídia ou file server.

Onde a porca torce o rabo (Caveats)

Nem tudo são flores. Existem limitações técnicas que você deve respeitar:

Não é reversível: Assim como adicionar um vdev, você não pode remover esse disco depois de expandido (exceto em configurações de Mirror, mas estamos falando de RAIDZ).

Overhead de CPU: O cálculo de paridade para os dados antigos durante leituras torna-se ligeiramente mais complexo matematicamente, pois o ZFS precisa entender o mapeamento antigo vs. novo. Em CPUs modernas (últimos 5-8 anos), isso é imperceptível.

Fragmentação: A expansão contínua pode aumentar a fragmentação do pool ao longo dos anos. Manter o pool abaixo de 80% de ocupação continua sendo uma regra de ouro.

Figura: Fotografia macro de um terminal exibindo o status de expansão do zpool com barra de progresso e luzes de servidor ao fundo.

Figura: Fotografia macro de um terminal exibindo o status de expansão do zpool com barra de progresso e luzes de servidor ao fundo.

O Veredito do Operador

O OpenZFS 2.3 remove a maior barreira de entrada para usuários domésticos e pequenas empresas. A capacidade de começar com 3 ou 4 discos e crescer conforme a necessidade alinha o ZFS com a realidade econômica de quem não tem orçamento de Enterprise.

Para nós, que montamos servidores em gabinetes reaproveitados ou chassis Supermicro usados, o RAIDZ Expansion é a funcionalidade da década. Já o Fast Dedup é uma ferramenta de nicho que finalmente se tornou utilizável, permitindo economias massivas de espaço em pools de virtualização (Proxmox/XCP-ng) sem vender um rim para comprar RAM.

A recomendação é clara: se você está planejando um novo NAS, planeje sua topologia pensando nessas funcionalidades. Mas lembre-se, em storage, "novo" significa "teste antes de confiar seus dados críticos".

Referências & Leitura Complementar

OpenZFS GitHub Pull Request #15022: A implementação técnica do RAIDZ Expansion.

Matt Ahrens Talk (OpenZFS Developer Summit): "RAIDZ Expansion: How it works and how to use it".

J.R. Oldroyd (Fast Dedup): Documentação sobre as melhorias na tabela DDT e alocação.

FAQ: Perguntas Frequentes

O RAIDZ Expansion reescreve todos os dados antigos automaticamente?

Não imediatamente. O OpenZFS usa um processo inteligente onde mantém a largura de distribuição (stride) antiga para os dados que já existiam. A nova largura, que aproveita o disco extra, é usada apenas para novos dados gravados ou dados antigos que forem modificados/reescritos. Isso economiza muito tempo, mas deixa uma pequena ineficiência de espaço até que você force uma reescrita.O Fast Dedup elimina a necessidade de muita RAM?

Ele reduz drasticamente a dependência crítica, mas não elimina a necessidade de hardware decente. A grande mudança é o uso de armazenamento de metadados baseados em log e melhor gerenciamento de despejo. Isso permite que a tabela de dedup (DDT) seja jogada para SSDs rápidos (Special VDEV) sem matar a performance de escrita, algo que antes era inviável.Posso expandir um RAIDZ2 de 6 discos para 7 discos com o pool online?

Sim. Com o OpenZFS 2.3, você usa o comando `zpool attach` para adicionar um disco ao vdev RAIDZ existente. O sistema iniciará o processo de expansão em background, mantendo o pool online e seus arquivos acessíveis durante todo o processo.

Marcos Lopes

Operador Open Source (Self-Hosted)

"Troco licenças proprietárias por soluções open source robustas, ciente de que a economia financeira custa suor na manutenção. Defensor da soberania de dados e da força da comunidade."