ZFS Special VDEV: Transformando HDDs Lentos em Armazenamento Híbrido de Alta Performance

Descubra como a classe de alocação 'special' do ZFS elimina o gargalo de IOPS em pools mecânicos. Guia de engenharia para sizing, riscos e configuração de pools híbridos.

Todo mundo que já montou um servidor de arquivos em casa conhece a sensação. Você compra discos rígidos enormes, configura um RAIDZ2 para ter redundância, enche o pool com terabytes de filmes, fotos e backups. A taxa de transferência sequencial é linda, saturando sua rede de 10GbE. Mas então você abre uma pasta com dez mil fotos ou tenta indexar uma biblioteca no Plex.

O sistema engasga. O barulho das cabeças de leitura dos HDDs parece uma britadeira. O Explorador de Arquivos do Windows fica com aquela barra verde carregando infinitamente.

Bem-vindo ao gargalo de IOPS dos discos mecânicos. Se você acha que a solução é "jogar mais RAM" ou adicionar um SSD de cache L2ARC, tenho más notícias: você provavelmente está desperdiçando dinheiro. A verdadeira revolução no ZFS moderno (OpenZFS 0.8+) chama-se Special VDEV. Vamos dissecar como essa funcionalidade permite construir um sistema de armazenamento híbrido real, onde a latência do flash encontra a capacidade do disco giratório.

Resumo em 30 segundos

- O Problema: HDDs são ótimos para ler arquivos grandes contínuos, mas terríveis para ler milhares de pequenos metadados (permissões, locais de arquivos) espalhados pelo disco.

- A Solução: O "Special VDEV" não é cache; é um armazenamento dedicado. Ele move fisicamente todos os metadados (e arquivos pequenos opcionais) para SSDs, deixando os HDDs apenas para dados brutos.

- O Risco: Ao contrário do cache L2ARC, se o seu Special VDEV falhar sem redundância, você perde o pool inteiro. Espelhamento (Mirror) é obrigatório.

O pesadelo da latência em diretórios densos

Para entender por que seu array de discos de 100TB parece lento, precisamos separar duas métricas que o marketing adora confundir: Throughput (largura de banda) e Latência (tempo de resposta).

Um disco rígido moderno de 7200 RPM consegue ler sequencialmente a 200-250 MB/s. Se você colocar 8 deles em um vdev, você tem uma largura de banda massiva. Porém, quando você navega por diretórios, compila código ou roda bancos de dados, você não está lendo um fluxo contínuo. Você está fazendo milhares de pequenas perguntas ao sistema de arquivos: "Onde começa este arquivo?", "Quem é o dono?", "Qual a data de modificação?".

Essas perguntas são os metadados. No ZFS, cada bloco de dados tem um ponteiro, checksums e atributos associados. Em um pool convencional, esses metadados estão misturados com os dados nos pratos magnéticos.

A física das agulhas mecânicas contra operações de metadados

Aqui entra a física implacável. Para ler um metadado, o braço mecânico do HDD precisa se mover fisicamente até a trilha correta (seek time) e esperar o disco girar até o setor certo (rotational latency).

Um HDD de 7200 RPM é limitado pela física a realizar cerca de 80 a 120 IOPS (Operações de Entrada/Saída por Segundo). Não importa se é um disco Enterprise de R$ 3.000,00 ou um disco shucked de um case externo; a física é a mesma.

Se você abre uma pasta com 5.000 fotos, o sistema operacional pode precisar ler metadados de todas elas para gerar as miniaturas. Se seus discos entregam 100 IOPS, essa operação vai levar 50 segundos. Durante esse tempo, seus discos estão "ocupados", mas a transferência de dados em MB/s é ridícula, quase zero. É o pior cenário possível para "spinning rust" (ferrugem giratória, nosso apelido carinhoso para HDDs).

Por que adicionar L2ARC e mais RAM não resolve o problema raiz

A resposta padrão em fóruns antigos era: "Adicione mais RAM para o ARC ou coloque um SSD como L2ARC". Eu mesmo já dei esse conselho no passado, mas ele é incompleto para o cenário de hoje.

ARC (RAM): É volátil e finito. Se você tem 64GB de RAM, ótimo. Mas se você tem 40TB de dados e milhões de arquivos, a RAM nunca vai segurar todos os metadados. Assim que você acessar algo que não está na RAM, voltamos à velocidade do HDD.

L2ARC (Read Cache): O problema do L2ARC é que ele precisa ser "aquecido". Os dados só vão para o cache depois de serem lidos lentamente do disco pelo menos uma vez (ou frequentemente, dependendo da configuração). Além disso, o L2ARC consome RAM para indexar a si mesmo. Em muitos casos, adicionar um L2ARC grande em um sistema com pouca RAM na verdade piora a performance.

O Special VDEV é diferente. Ele não é cache. Ele é tiering (camada). Os metadados são gravados diretamente no SSD e vivem lá permanentemente. A primeira leitura já é rápida.

Engenharia da solução: implementando a classe de alocação especial

A "Allocation Class" especial permite que você diga ao ZFS: "Eu quero que este tipo específico de dado viva neste grupo de discos rápidos".

Ao adicionar um vdev especial, o ZFS desvia automaticamente todas as gravações de metadados para ele. Isso inclui:

Mapas de espaço livre.

Tabelas de deduplicação (DDT) - embora você deva evitar deduplicação a todo custo, a menos que saiba exatamente o que está fazendo.

Atributos de arquivos.

Ponteiros de blocos indiretos.

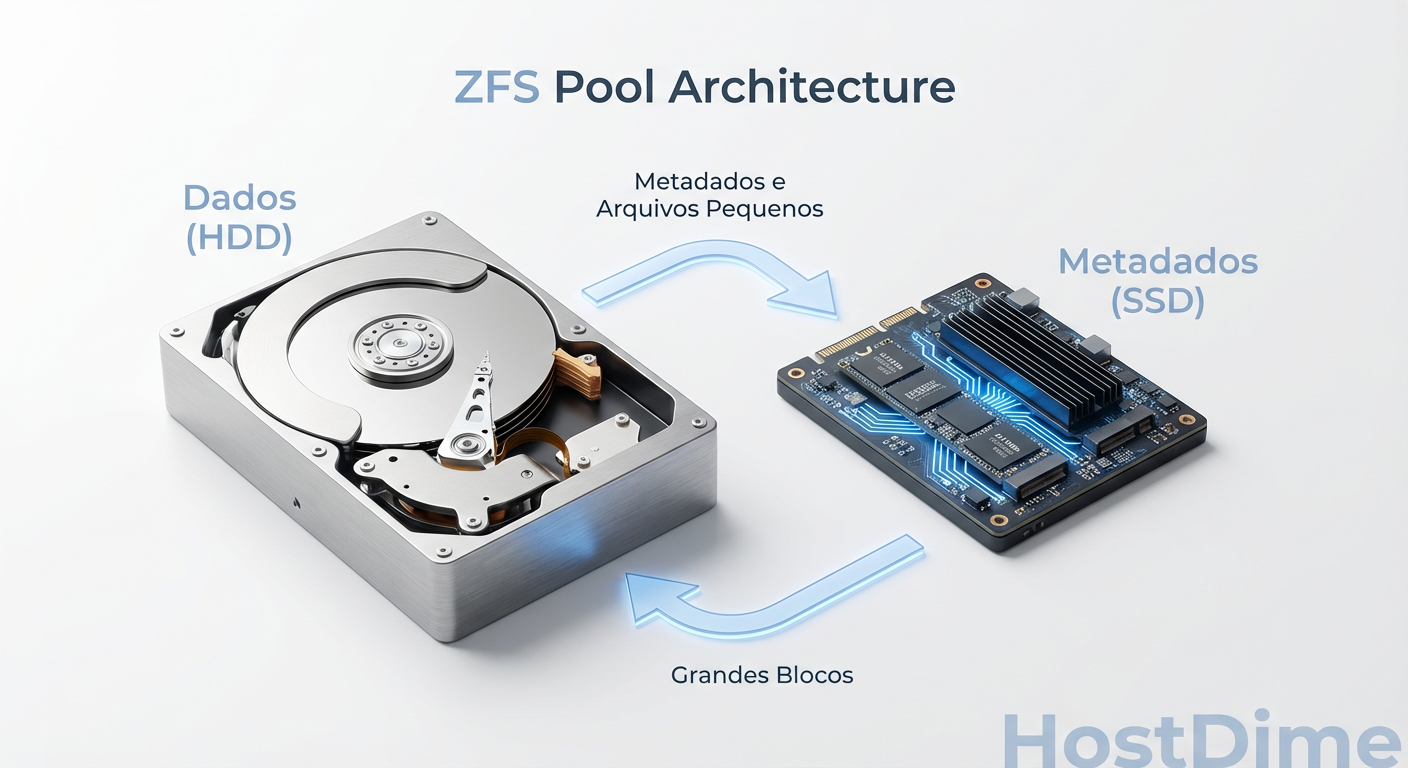

Fig 1. A segregação física de dados: o tráfego aleatório (IOPS) é desviado para o flash, liberando os HDDs para throughput sequencial.

Fig 1. A segregação física de dados: o tráfego aleatório (IOPS) é desviado para o flash, liberando os HDDs para throughput sequencial.

O resultado prático é que seus HDDs ficam livres para fazer o que fazem de melhor: ler e gravar grandes sequências de dados. O ruído de "seek" dos HDDs diminui drasticamente porque eles não precisam mais ficar pulando para buscar metadados.

Implementação prática

Para criar um Special VDEV, você precisa de um par de SSDs (explico a redundância abaixo). O comando é simples, mas poderoso:

zpool add tank special mirror /dev/disk/by-id/nvme-SSD1 /dev/disk/by-id/nvme-SSD2

💡 Dica Pro: Se você usa NVMe, verifique se o tamanho do setor lógico está alinhado (ashift=12 geralmente). Discos flash modernos odeiam desalinhamento tanto quanto HDDs.

A matemática crítica de risco e redundância para vdevs especiais

Aqui é onde a "porca torce o rabo". Preciso ser extremamente claro, como se estivesse segurando seu ombro antes de você pular de um penhasco.

O Special VDEV é parte integrante do seu pool.

Se você perder seu dispositivo de cache (L2ARC), o ZFS apenas o descarta e continua funcionando sem cache. Sem problemas. Se você perder seu dispositivo de log (SLOG), você pode perder alguns segundos de dados que estavam na memória, mas o pool sobrevive. Se você perder o Special VDEV, você perde todo o pool.

Não há recuperação. Os metadados dizem onde os dados estão. Sem o mapa, os dados nos HDDs são lixo digital inacessível.

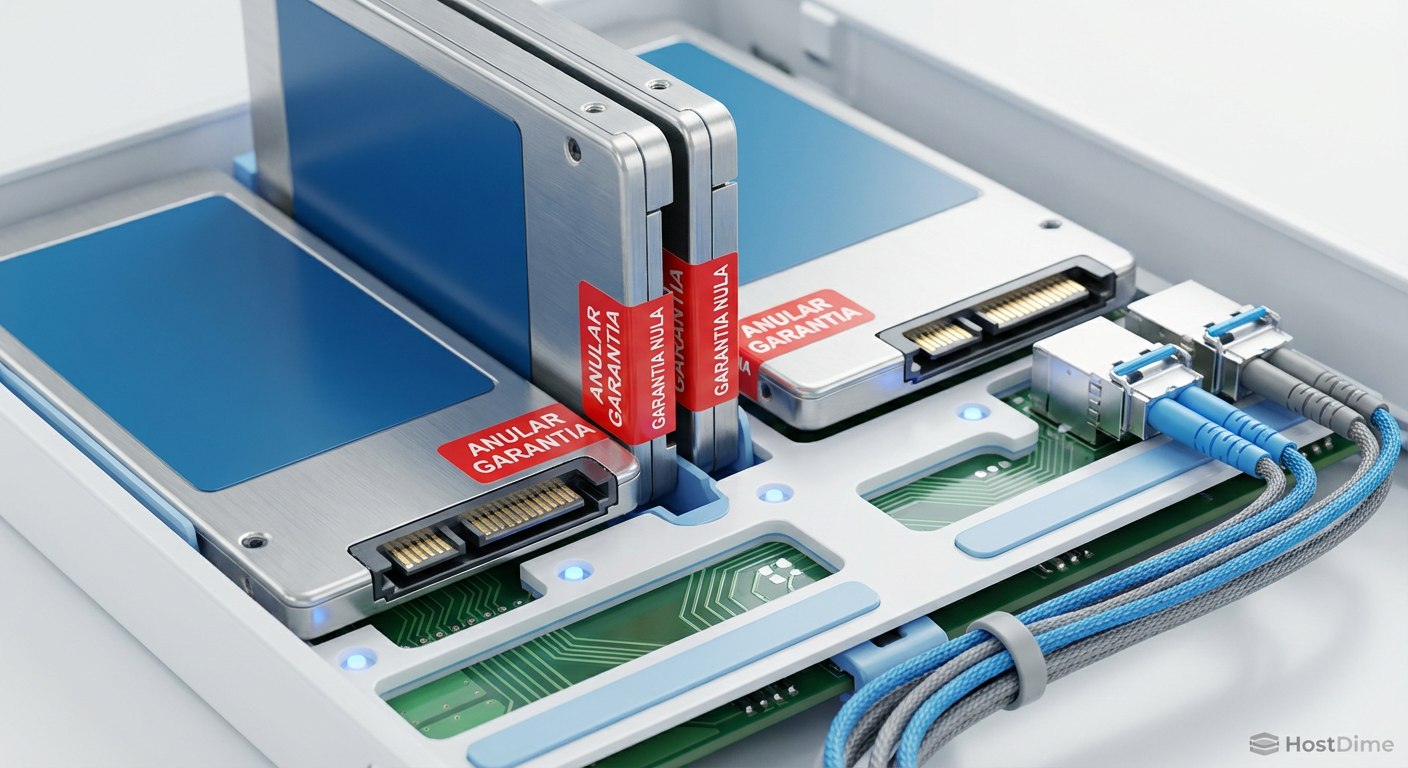

Fig 3. Redundância não é opcional: usar um único SSD para metadados é a maneira mais rápida de perder um pool de 100TB.

Fig 3. Redundância não é opcional: usar um único SSD para metadados é a maneira mais rápida de perder um pool de 100TB.

Portanto, a regra de ouro do homelabber responsável é: A redundância do Special VDEV deve igualar ou exceder a redundância dos seus dados.

Se você tem um pool de HDDs em RAIDZ1 (arriscado), o Special VDEV deve ser pelo menos um Mirror de 2 vias.

Se você tem um pool RAIDZ2 ou RAIDZ3 (seguro), eu recomendo fortemente um Mirror de 3 vias para o Special VDEV, ou usar SSDs de classe Enterprise com alta durabilidade (DWPD).

Nunca, jamais, adicione um único SSD como Special VDEV em um pool com dados importantes. É um ponto único de falha garantido.

Estratégia avançada: pools híbridos com o parâmetro small_blocks

Aqui é onde a mágica acontece e onde justificamos o título de "Alta Performance". Além de metadados, o ZFS permite configurar um limiar de tamanho de bloco (special_small_blocks). Qualquer arquivo ou bloco de dados menor que esse tamanho será gravado fisicamente no SSD, não no HDD.

Pense no seu uso diário. Você tem ISOs de 4GB (grandes) e arquivos de texto, scripts, thumbnails e logs de 4KB a 100KB (pequenos).

Se definirmos zfs set special_small_blocks=64K tank/dataset, o ZFS fará o seguinte:

Arquivo de filme (10GB) -> Vai para os HDDs.

Arquivo de texto (20KB) -> Vai para o SSD Special VDEV.

Isso transforma efetivamente seu array em um armazenamento híbrido. O "lixo" pequeno que fragmenta e mata a performance dos HDDs é absorvido pelo flash. Os HDDs só recebem as cargas de trabalho sequenciais onde eles brilham.

⚠️ Perigo: Cuidado com o dimensionamento. Se você ativar

small_blockspara 128K ou maior, você vai encher seus SSDs muito rápido. Monitore o uso comzpool list -v. Uma vez cheio o Special VDEV, os dados "transbordam" de volta para os HDDs, perdendo o benefício de performance, mas mantendo a integridade.

Validação empírica: interpretando o zpool iostat antes e depois

Não acredite apenas na minha palavra. O terminal não mente. A ferramenta zpool iostat é sua melhor amiga para validar esse investimento.

Antes de implementar, rode zpool iostat -v 1 durante uma carga pesada de listagem de arquivos ou compilação. Você verá os HDDs com IOPS altos e largura de banda baixa.

Após implementar o Special VDEV e mover os dados (sim, você precisa reescrever os dados existentes para que eles se movam para o SSD, o ZFS não move dados antigos automaticamente), o cenário muda drasticamente.

Fig 2. O 'zpool iostat' não mente: note como a carga de IOPS (operações por segundo) é absorvida quase inteiramente pelo vdev especial.

Fig 2. O 'zpool iostat' não mente: note como a carga de IOPS (operações por segundo) é absorvida quase inteiramente pelo vdev especial.

Você verá algo lindo:

Vdevs de HDD: IOPS próximos de zero em repouso, ou IOPS baixos com MB/s altíssimos durante transferências de arquivos grandes.

Vdev Especial: Milhares de IOPS, absorvendo toda a "pancada" aleatória.

Essa segregação de tráfego é o que faz um servidor doméstico parecer um storage enterprise de meio milhão de reais. A latência de navegação em pastas via SMB ou NFS cai de segundos para milissegundos. A "sensação" de uso é de estar trabalhando em um SSD local.

Alerta final: não é para todos

Implementar um Special VDEV é um caminho sem volta em muitos casos (embora o ZFS permita remoção de vdevs mirrors em versões recentes, é um processo estressante que move tudo de volta para os HDDs).

Recomendo isso se:

Você tem slots NVMe ou SATA livres.

Você entende o custo de comprar SSDs em pares para redundância.

Seu fluxo de trabalho envolve muitos arquivos pequenos ou navegação constante em diretórios grandes.

Se o seu servidor é apenas um destino de backup que você acessa uma vez por mês, guarde seu dinheiro. Mas se você usa seu storage ativamente, roda VMs, containers ou edita mídia diretamente da rede, essa é a melhor atualização de hardware que você pode fazer, superando até mesmo upgrades de CPU.

Prepare seus backups, verifique seus slots PCIe e boa sorte no upgrade. O silêncio dos seus HDDs agradecerá.

Referências & Leitura Complementar

Para quem quiser mergulhar nos detalhes técnicos e validar as afirmações:

OpenZFS Documentation - Allocation Classes: Detalhes oficiais sobre a implementação e flags.

Man Page zpool(8): Consulte a seção sobre

specialvdevs.Ars Technica ZFS Series: Artigos históricos de Jim Salter sobre a evolução do ZFS (2020 em diante).

Level1Techs Forums: Threads comunitárias sobre "Metadata VDEV sizing" e experiências reais de falhas.

Perguntas Frequentes

P: Qual tamanho meu Special VDEV deve ter?

R: Uma regra prática da comunidade é 0.3% da capacidade total do pool apenas para metadados. Se você planeja usar small_blocks, precisa calcular o volume de dados pequenos que possui. Um par de SSDs de 500GB ou 1TB geralmente sobra para pools domésticos de até 100TB, permitindo uso agressivo de blocos pequenos.

P: Posso usar SSDs de consumidor (ex: Samsung EVO, Kingston NV2)? R: Pode, mas com ressalvas. Metadados sofrem muitas escritas pequenas. SSDs sem DRAM cache ou com baixo TBW (Terabytes Written) podem falhar prematuramente. SSDs "Pro" ou, idealmente, Enterprise usados (Intel série DC, Samsung PM) com proteção contra perda de energia (PLP) são preferíveis, embora PLP seja menos crítico aqui do que em SLOGs.

P: O que acontece se meu Special VDEV encher? R: O ZFS é inteligente. Se o vdev especial encher, os novos metadados e blocos pequenos serão gravados nos HDDs normais. O sistema não para, apenas fica mais lento (volta à performance original) para os novos dados.

P: Preciso reformatar meu pool para adicionar isso?

R: Não. Você pode adicionar a um pool existente. Porém, os dados que já estão nos HDDs não serão movidos magicamente para o SSD. Você precisará usar o zfs send | zfs recv para reescrever os datasets ou ferramentas de rebalanceamento (que ainda são experimentais/complexas) para ver o benefício nos arquivos antigos.

Marcos Lopes

Operador Open Source (Self-Hosted)

"Troco licenças proprietárias por soluções open source robustas, ciente de que a economia financeira custa suor na manutenção. Defensor da soberania de dados e da força da comunidade."