Compressao Impacto Em CPU E Latencia

A compressão de dados é uma faca de dois gumes. Por um lado, reduz o espaço de armazenamento e a largura de banda de transmissão, diminuindo custos e melhorando...

Compressao Impacto Em CPU E Latencia

A compressão de dados é uma faca de dois gumes. Por um lado, reduz o espaço de armazenamento e a largura de banda de transmissão, diminuindo custos e melhorando a eficiência. Por outro, introduz sobrecarga de CPU e latência, afetando o desempenho das aplicações. A escolha do algoritmo de compressão ideal é um delicado ato de balanceamento, e ignorar essa realidade pode levar a gargalos inesperados em produção.

Por que a compressão se tornou onipresente?

Em um mundo onde dados são gerados em volumes exponenciais, a compressão se tornou indispensável. Imagine o custo de armazenar petabytes de logs não compactados, ou a lentidão de transferir arquivos enormes através de redes congestionadas. A compressão alivia esses problemas, permitindo que mais dados sejam armazenados no mesmo espaço físico e que sejam transmitidos mais rapidamente. No entanto, essa economia tem um preço: o tempo de CPU gasto para comprimir e descomprimir os dados.

Como a compressão realmente funciona (nos mínimos detalhes)

A compressão de dados, em sua essência, busca padrões e redundâncias nos dados para representá-los de forma mais eficiente. Existem duas categorias principais de algoritmos de compressão:

- Lossless (sem perdas): Preserva todos os dados originais. Ideal para arquivos importantes onde a integridade é crucial, como documentos, código-fonte e imagens médicas. Exemplos: Gzip, Zstd, Lempel-Ziv (LZ77, LZ78), Deflate.

- Lossy (com perdas): Descarta informações consideradas menos importantes. Adequado para dados onde alguma degradação é aceitável, como imagens, áudio e vídeo. Exemplos: JPEG, MP3, H.264.

Vamos nos concentrar nos algoritmos lossless, que são mais relevantes para a maioria das aplicações de infraestrutura.

O processo de compressão lossless geralmente envolve as seguintes etapas:

- Modelagem: Análise dos dados para identificar padrões e redundâncias.

- Codificação: Representação dos dados com base nos padrões identificados, utilizando códigos mais curtos para padrões frequentes e códigos mais longos para padrões raros.

- Empacotamento: Organização dos dados codificados em um formato compacto para armazenamento ou transmissão.

A descompressão é o processo inverso, que restaura os dados originais a partir da representação compactada.

A matemática por trás da compressão (exemplo simplificado):

Considere a string "AAAAABBBCC". Uma forma simples de comprimi-la seria representar as repetições: "5A3B2C". Este é um exemplo rudimentar de Run-Length Encoding (RLE). Algoritmos mais sofisticados usam técnicas como a codificação de Huffman, que atribui códigos de comprimento variável aos símbolos com base em sua frequência.

O impacto na CPU: um mergulho profundo

Cada etapa do processo de compressão e descompressão consome ciclos de CPU. A modelagem, em particular, pode ser computacionalmente intensiva, especialmente para algoritmos complexos como Zstd. A codificação e o empacotamento também exigem poder de processamento, embora geralmente em menor grau.

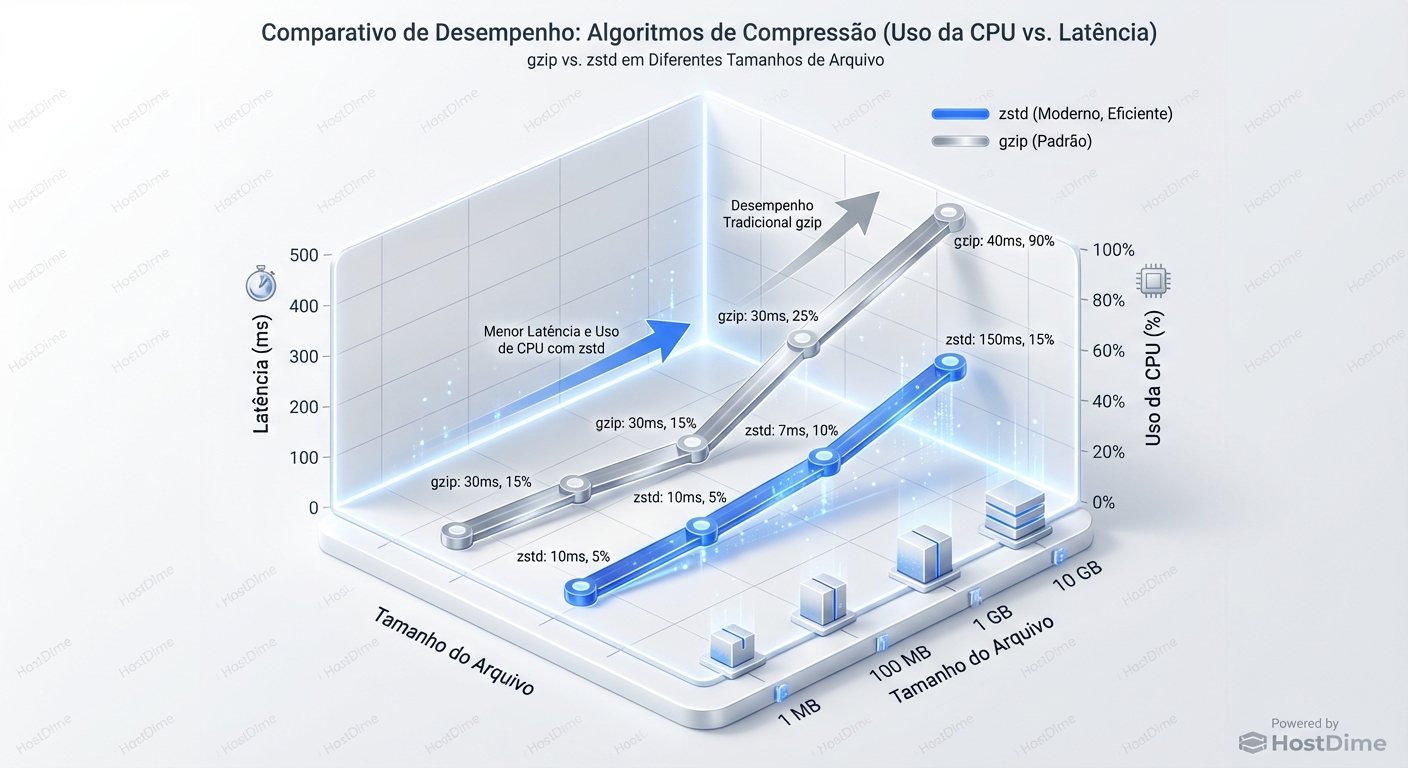

A escolha do algoritmo de compressão afeta diretamente o uso da CPU. Algoritmos mais eficientes em termos de compressão (ou seja, que reduzem mais o tamanho dos dados) tendem a ser mais exigentes em termos de CPU.

A latência: o inimigo silencioso

A compressão e descompressão introduzem latência, ou seja, um atraso no processamento dos dados. Essa latência pode ser insignificante para arquivos grandes processados em lote, mas pode ser crítica para aplicações sensíveis ao tempo, como bancos de dados e sistemas de mensagens.

A latência é afetada por vários fatores, incluindo:

- O algoritmo de compressão: Algoritmos mais complexos tendem a ter maior latência.

- O tamanho dos dados: Arquivos maiores exigem mais tempo para comprimir e descomprimir.

- A capacidade da CPU: CPUs mais lentas levarão mais tempo para processar a compressão.

- A carga do sistema: Se a CPU estiver ocupada com outras tarefas, a compressão será mais lenta.

Escolhendo o algoritmo certo: um ato de equilíbrio

A escolha do algoritmo de compressão ideal depende dos requisitos específicos da aplicação. Não existe uma solução única para todos os casos.

Considerações importantes:

- Taxa de compressão: Quanto os dados são reduzidos em tamanho.

- Velocidade de compressão/descompressão: Quanto tempo leva para comprimir e descomprimir os dados.

- Uso de CPU: Quanto poder de processamento é necessário.

- Latência: O atraso introduzido pela compressão.

- Requisitos de memória: A quantidade de memória necessária para o algoritmo de compressão.

Casos de uso e armadilhas:

Bancos de dados:

- Benefício: Redução do espaço de armazenamento, especialmente para colunas de texto grandes.

- Armadilha: A compressão excessiva pode aumentar a latência das consultas, especialmente se a CPU estiver sobrecarregada.

- Recomendação: Use algoritmos de compressão rápidos como LZ4 ou Zstd com níveis de compressão baixos. Avalie o impacto na latência das consultas antes de implementar em produção.

Logs:

- Benefício: Redução drástica do espaço de armazenamento, facilitando a análise e o arquivamento.

- Armadilha: A descompressão de logs para análise pode consumir muitos recursos da CPU, especialmente se os logs forem acessados com frequência.

- Recomendação: Use algoritmos de compressão eficientes como Zstd ou Gzip. Considere o uso de ferramentas de análise de logs que suportem a descompressão em tempo real.

Transferência de arquivos:

- Benefício: Redução do tempo de transferência e do consumo de largura de banda.

- Armadilha: A compressão e descompressão podem adicionar latência, especialmente para arquivos pequenos.

- Recomendação: Use algoritmos de compressão rápidos como LZ4 ou Zstd. Considere o uso de protocolos de transferência que suportem compressão em tempo real, como SSH com compressão habilitada.

Sistemas de Mensagens (Kafka, RabbitMQ):

- Benefício: Redução do tamanho das mensagens, aumentando a taxa de transferência e reduzindo o consumo de largura de banda.

- Armadilha: A compressão e descompressão podem adicionar latência, afetando o desempenho do sistema.

- Recomendação: Use algoritmos de compressão rápidos e com baixa sobrecarga de CPU, como LZ4 ou Snappy. Monitore a latência das mensagens e ajuste o nível de compressão conforme necessário.

Ferramentas de diagnóstico: olhando sob o capô

Para diagnosticar problemas relacionados à compressão, você precisa monitorar o uso da CPU, a latência e o desempenho do disco. Aqui estão algumas ferramentas úteis:

top/htop: Monitore o uso da CPU por processo. Procure por processos que consomem muita CPU durante a compressão ou descompressão.topiostat: Monitore o desempenho do disco. Procure por alta utilização do disco durante a compressão ou descompressão.iostat -x 1vmstat: Monitore a utilização da memória virtual. Procure por alta utilização da memória durante a compressão ou descompressão.vmstat 1perf: Ferramenta de análise de desempenho mais avançada. Permite identificar gargalos específicos no código de compressão.perf record -g -p <pid> perf reportMonitoramento específico da aplicação: Muitas aplicações fornecem métricas específicas relacionadas à compressão, como a taxa de compressão, o tempo de compressão/descompressão e o uso da CPU. Use essas métricas para monitorar o desempenho da compressão e identificar possíveis problemas.

Exemplo prático: Compressão com Zstd no Linux

Zstd (Zstandard) é um algoritmo de compressão moderno que oferece um bom equilíbrio entre taxa de compressão e velocidade.

Compressão:

time zstd arquivo.txt -o arquivo.txt.zstDescompressão:

time zstd -d arquivo.txt.zst -o arquivo.txtNíveis de compressão: Zstd suporta vários níveis de compressão, de

-1(mais rápido, menor compressão) a19(mais lento, maior compressão). O nível padrão é3.zstd -1 arquivo.txt -o arquivo.txt.zst.fast # Compressão rápida zstd -19 arquivo.txt -o arquivo.txt.zst.best # Compressão máxima

Experimente diferentes níveis de compressão e meça o impacto na CPU e na latência para encontrar o ponto ideal para sua aplicação.

Sinais de Saúde:

- Uso de CPU dentro dos limites aceitáveis durante a compressão e descompressão.

- Latência da aplicação não afetada pela compressão.

- Taxa de compressão consistente com os requisitos de armazenamento.

- Desempenho do disco dentro dos limites esperados.

Sinais de Perigo:

- Picos de uso da CPU durante a compressão e descompressão.

- Aumento da latência da aplicação após a implementação da compressão.

- Taxa de compressão abaixo do esperado.

- Alta utilização do disco durante a compressão e descompressão.

- Erros relacionados à compressão ou descompressão nos logs da aplicação.

Veredito: Compressão com responsabilidade

A compressão é uma ferramenta poderosa, mas deve ser usada com cautela. Não existe uma bala de prata. A escolha do algoritmo de compressão e o nível de compressão devem ser cuidadosamente considerados, levando em conta os requisitos específicos da aplicação e os recursos disponíveis. Monitore o desempenho da compressão e ajuste as configurações conforme necessário para garantir que a compressão esteja realmente melhorando o desempenho do sistema, e não o prejudicando.

Não trate compressão como uma otimização "plug and play". Avalie, monitore e adapte. Sua infra agradecerá.

Kenji Tanaka

Especialista em Performance de I/O

Obscecado por latência zero. Analisa traces de kernel e otimiza drivers de storage para bancos de dados de alta frequência.