NVMe/TCP vs RoCE vs Fibre Channel: O Guia Forense de Escolha para NVMe-oF

Pare de adivinhar sua infraestrutura de storage. Analisamos os trade-offs reais de latência, complexidade de rede e custo entre NVMe/TCP, RoCE v2 e FC-NVMe.

Você chega na cena do crime: um cluster de banco de dados crítico está engasgando. O armazenamento é All-Flash NVMe de última geração, a rede é de 100GbE, mas a latência de gravação está disparando aleatoriamente. O fornecedor de storage culpa a rede. O time de redes culpa o storage. Ninguém olha para o protocolo de transporte.

Como investigador forense de sistemas, você sabe que velocidade bruta não é nada sem controle. A transição de SATA/SAS para NVMe não foi apenas uma atualização de velocidade; foi uma mudança de paradigma que expôs a rede como o novo gargalo. Escolher entre NVMe/TCP, RoCE (RDMA) ou Fibre Channel não é uma questão de gosto—é uma análise de evidências sobre onde você quer pagar o preço: no hardware, na complexidade de configuração ou na latência da CPU.

Vamos dissecar essas opções, isolar as variáveis e entender qual protocolo vai manter seus dados vivos e qual vai causar uma parada cardíaca na sua infraestrutura.

O que é NVMe-oF? NVMe over Fabrics (NVMe-oF) é a especificação que estende o conjunto de comandos NVMe de alto desempenho através de redes de dados (Ethernet, Fibre Channel, InfiniBand), eliminando a tradução para SCSI. Ele permite que um host acesse o armazenamento remoto com latências quase idênticas ao armazenamento local (Direct Attached Storage), mantendo o paralelismo massivo nativo dos SSDs modernos.

O Fim da Era SCSI: Entendendo o Paralelismo do NVMe-oF

Para entender o crime, precisamos entender a vítima. Durante décadas, vivemos sob a ditadura do SCSI (Small Computer System Interface). O iSCSI serviu bem aos HDDs giratórios, mas aplicar iSCSI em SSDs NVMe é como colocar um motor de Ferrari em um trator agrícola.

O problema raiz é a fila de comandos. O SCSI foi desenhado para lidar com uma única fila de comandos (Single Queue) com profundidade limitada. O NVMe foi desenhado para SSDs que operam em paralelo, suportando até 64.000 filas, cada uma com 64.000 comandos.

Quando você usa NVMe-oF, você não está apenas enviando dados mais rápido; você está removendo o "tradutor" SCSI do caminho. A questão forense é: como transportamos esses comandos NVMe pela rede sem perder esse paralelismo? É aqui que os caminhos se dividem.

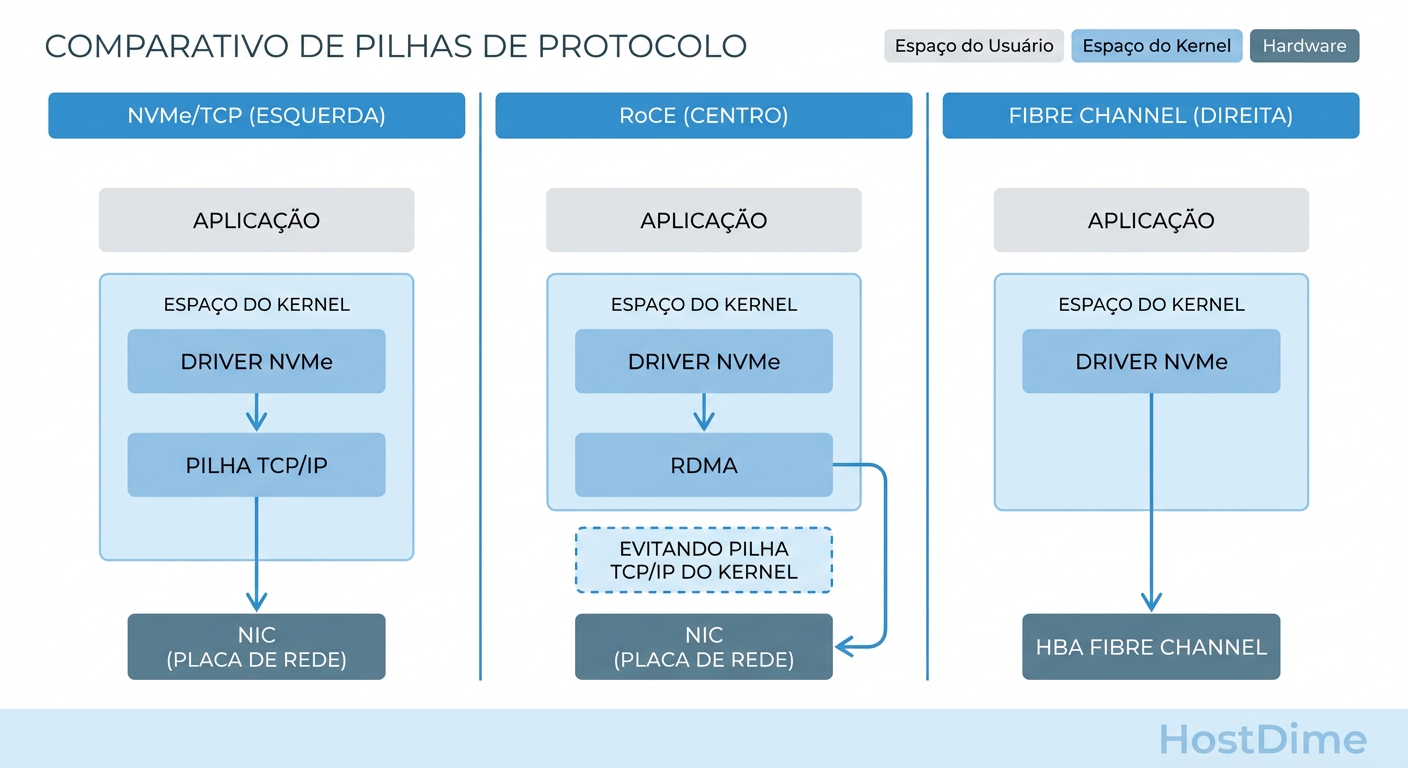

Figura: Comparativo de Pilhas de Protocolo NVMe-oF: Note como o RoCE (centro) evita a pilha TCP/IP do kernel, enquanto o NVMe/TCP (esquerda) utiliza a infraestrutura padrão.

Figura: Comparativo de Pilhas de Protocolo NVMe-oF: Note como o RoCE (centro) evita a pilha TCP/IP do kernel, enquanto o NVMe/TCP (esquerda) utiliza a infraestrutura padrão.

FC-NVMe: O Preço da Confiabilidade (e por que bancos ainda pagam)

Se você entrar em um datacenter de um grande banco ou seguradora, verá luzes amarelas (fibra monomodo) ou laranjas/aquas (multimodo) piscando em switches Brocade ou Cisco MDS. Isso é Fibre Channel (FC).

O FC-NVMe (NVMe sobre Fibre Channel) é a escolha conservadora. E "conservador" aqui é um elogio. O Fibre Channel foi projetado desde o dia zero para ser um protocolo de armazenamento. Ele não "perde" pacotes; ele gerencia congestionamento nativamente através de um sistema de buffer-to-buffer credits. Se o destino não pode receber o quadro, a fonte não envia. Ponto.

A Evidência:

Vantagem: Coexistência. Você pode rodar tráfego SCSI legado (FCP) e NVMe na mesma fibra e nos mesmos switches (Gen 5 ou superior). É a transição mais suave para ambientes legados.

O Custo: É literalmente o custo. Switches FC são caros, HBAs são caras e você precisa de uma equipe dedicada que entenda de zonning e fabric services.

Veredito: Se você já tem uma SAN FC massiva e orçamento não é problema, o FC-NVMe é a prova de balas. Mas se você está construindo do zero (Greenfield), o custo por porta é difícil de justificar.

RoCE v2 e a Armadilha da "Ethernet Sem Perdas" (Lossless Ethernet)

Aqui é onde a maioria dos administradores comete o erro fatal. O RoCE (RDMA over Converged Ethernet) promete o santo graal: latência de memória (microssegundos de um dígito) sobre cabos Ethernet "baratos", ignorando a CPU do host.

O RoCE v2 utiliza UDP e permite que o hardware (NIC) grave dados diretamente na memória da aplicação remota. É incrivelmente rápido. Mas o RDMA tem uma fraqueza crítica: ele odeia perda de pacotes. Se um pacote cai, o desempenho despenca porque o hardware precisa esperar retransmissões complexas.

Para evitar isso, o RoCE exige uma "Lossless Ethernet". Isso é alcançado configurando PFC (Priority Flow Control) e ECN (Explicit Congestion Notification) nos switches.

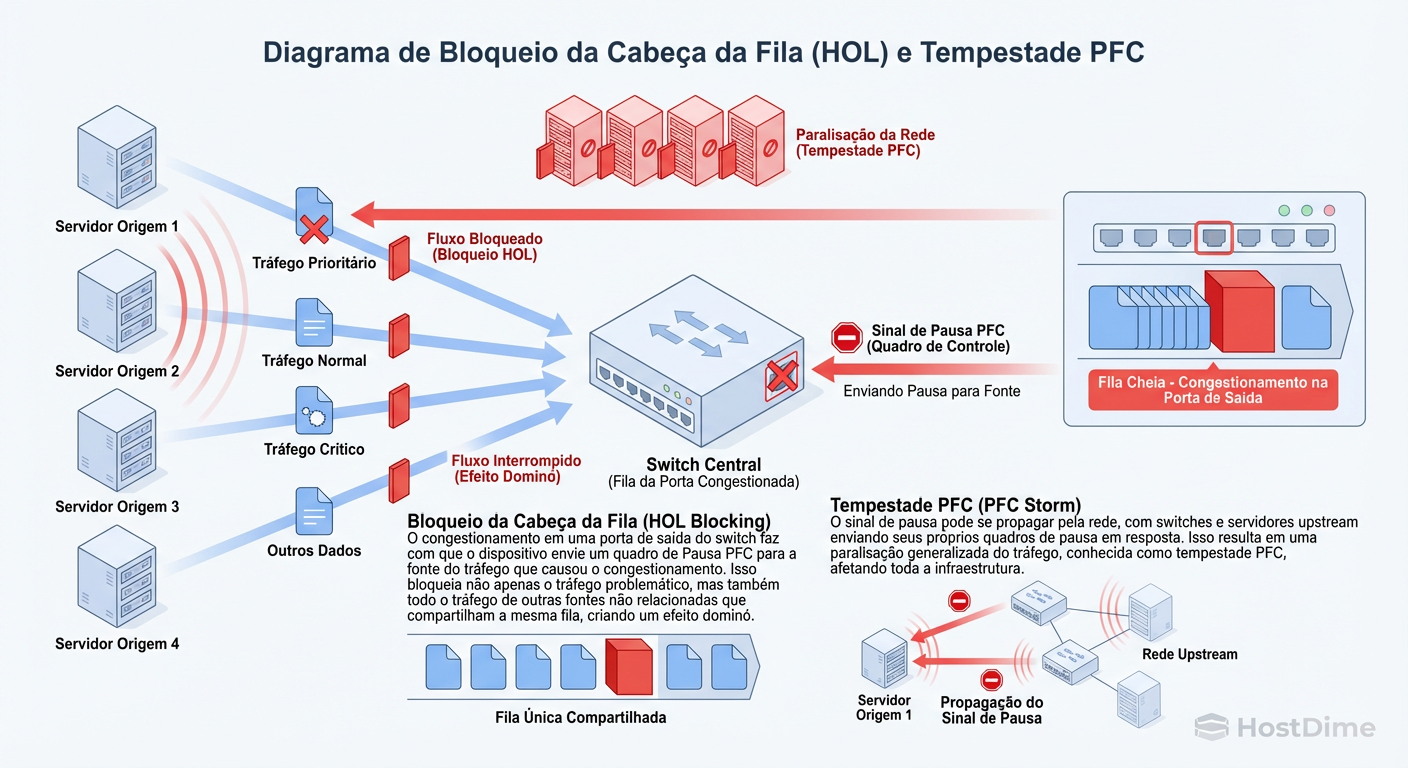

Onde o crime acontece: A Tempestade de PFC

O PFC funciona enviando um comando de "PAUSE" quando um buffer enche. O problema? Se um switch mal configurado ou uma NIC lenta começar a enviar PAUSE frames loucamente, isso pode se propagar pela rede (Backpressure), paralisando tráfego que não tinha nada a ver com o problema original.

Figura: O Perigo do PFC (Priority Flow Control) em RoCE: Como um switch mal configurado pode paralisar o tráfego de storage em cascata.

Figura: O Perigo do PFC (Priority Flow Control) em RoCE: Como um switch mal configurado pode paralisar o tráfego de storage em cascata.

Callout de Risco Forense:

Atenção: Implementar RoCE v2 sem um arquiteto de rede sênior é suicídio operacional. Se você não monitorar os contadores de PFC Storm nos seus switches, seu storage vai parar aleatoriamente e os logs do servidor não mostrarão nada, pois o bloqueio está na camada 2 da rede.

NVMe/TCP: Por que a Complexidade Zero está Vencendo a Latência Baixa

Enquanto o RoCE luta com configurações de switch complexas, o NVMe/TCP surgiu como o pragmático do grupo. Ele encapsula comandos NVMe dentro de datagramas TCP padrão.

A Tese: O TCP é o protocolo mais testado, otimizado e robusto da história da computação. Ele lida com perda de pacotes, reordenação e congestionamento nativamente.

O Contra-argumento: "Mas o TCP tem overhead de CPU!" Sim, tem. Mas olhe para as evidências modernas:

As CPUs têm núcleos sobrando.

SmartNICs e DPUs podem fazer offload de TCP.

A latência adicional do NVMe/TCP em relação ao RoCE é frequentemente medida em 10-20 microssegundos. Para 95% das aplicações (incluindo bancos de dados SQL padrão), isso é irrelevante.

O NVMe/TCP roda na sua infraestrutura de rede existente. Sem PFC. Sem switches especiais. Sem cabeamento proprietário. É a vitória da simplicidade operacional sobre a perfeição teórica.

Análise de Trade-offs: O Comparativo Forense

Não acredite no marketing. A escolha depende do que você pode "pagar" em termos de dinheiro, risco e complexidade.

| Característica | Fibre Channel (FC-NVMe) | RoCE v2 (NVMe/RDMA) | NVMe/TCP |

|---|---|---|---|

| Custo de Hardware | $$$$ (Alto - Switches/HBAs dedicados) | $$$ (Médio - NICs RDMA e Switches DCB) | $$ (Baixo - Ethernet Padrão) |

| Complexidade de Rede | Média (Requer conhecimento de SAN) | Extrema (Requer Lossless Ethernet/PFC) | Baixa (TCP/IP Padrão) |

| Dependência de CPU | Baixa (Offload em HBA) | Mínima (Bypass de Kernel) | Média/Alta (Depende da NIC) |

| Latência Típica | Baixa | Ultra-Baixa | Baixa (Levemente superior ao RoCE) |

| Risco Operacional | Baixo (Tecnologia madura) | Alto (Risco de Head-of-Line Blocking) | Baixo (Resiliente a perdas) |

| Caso de Uso Ideal | Bancos/Enterprise com legado FC | HPC, AI/ML Training | Cloud, Virtualização Geral, Edge |

Como Medir Gargalos de Rede em NVMe-oF (Ferramentas e Métricas)

Você suspeita que a rede é o problema. Como provar? Um "ping" não serve aqui. Você precisa olhar para os contadores de erro específicos do protocolo.

1. Investigando RoCE (A busca por Pause Frames)

Se você usa RoCE, seu inimigo é o congestionamento silencioso. Vá ao terminal do switch ou use ethtool no host Linux.

# No Host Linux: Verifique se sua NIC está recebendo ou enviando Pause Frames

ethtool -S eth0 | grep -i pause

# Saída esperada (exemplo de problema):

# rx_pause_frames: 54021 <-- ALERTA: O switch está mandando a NIC parar.

# tx_pause_frames: 0

Se rx_pause_frames está incrementando, sua rede está engarrafada e o mecanismo "Lossless" está parando o fluxo. Isso mata a latência.

2. Investigando NVMe/TCP (Retransmissões)

No TCP, a latência vem de retransmissões ou janelas TCP fechando.

# Verifique retransmissões TCP globais ou específicas da interface

netstat -s | grep -i retrans

# Use o ss para ver estatísticas de sockets NVMe específicos

ss -ti state established '( dport = :4420 )'

# Procure por "retrans" ou RTT (Round Trip Time) alto na saída.

3. Verificando a conexão NVMe

Independentemente do transporte, verifique como o subsistema NVMe do Linux vê a conexão.

nvme list-subsys

# Verifique o estado "Live". Se estiver "Connecting" ou "Reconnecting",

# você tem uma falha de link físico ou timeout de transporte.

Veredito Pragmático: Qual Protocolo Escolher para seu Workload

A decisão final não deve ser baseada em "qual é o mais rápido", mas em "qual eu consigo operar às 3 da manhã quando tudo quebrar".

Escolha NVMe/TCP se: Você quer implantar NVMe-oF em escala, em uma infraestrutura de rede Ethernet existente (Leaf-Spine padrão), e não tem uma equipe de engenharia de rede dedicada para ajustar QoS e PFC. É a escolha padrão para VMware vSphere 7.0+ e ambientes Kubernetes on-premise. A penalidade de latência é imperceptível para a maioria das cargas de trabalho empresariais.

Escolha RoCE v2 se: Você está construindo um cluster de High Performance Computing (HPC), treinamento de IA ou um banco de dados Oracle Exadata onde cada microssegundo conta. Condição: Você deve comprar switches que suportem DCB/PFC robusto e estar disposto a configurar a rede como uma "Fabric" dedicada, isolada do tráfego de usuários.

Escolha FC-NVMe se: Você é um banco, seguradora ou hospital com investimento massivo em Fibre Channel. Não jogue fora seus switches Brocade Gen6/7. Apenas atualize o firmware e os arrays. A confiabilidade do FC ainda é imbatível para ambientes de missão crítica que não toleram nem a possibilidade de uma retransmissão TCP.

Conclusão Forense: O NVMe/TCP está commoditizando o armazenamento de alto desempenho da mesma forma que o iSCSI fez há 15 anos, mas sem a penalidade de desempenho. Para a maioria, ele é o "suficientemente bom" que na verdade é excelente. O RoCE é a Fórmula 1: ganha corridas, mas exige uma equipe de pit stop perfeita. Escolha sua batalha.

Referências & Leitura Complementar

NVM Express Base Specification 2.0: Detalhes sobre a arquitetura de filas e comandos.

RFC 793 (TCP) & RFC 894 (IP over Ethernet): Fundamentos do transporte para NVMe/TCP.

InfiniBand Trade Association (IBTA) RoCEv2 Spec: Especificação técnica do encapsulamento UDP para RDMA.

NVMe over Fabrics (NVMe-oF) Specification 1.1: O documento que define os bindings para TCP, FC e RDMA.

Thomas 'Raid0' Wright

High-Performance Computing Researcher

Trabalha com supercomputadores. Para ele, velocidade é tudo, e redundância é problema do software.