O Fim da Era HDD e a Ascensão do Computational Storage: Realidade ou Hype para 2030?

Análise técnica sobre a paridade de custo SSD/HDD, o declínio dos discos mecânicos e como o Computational Storage resolverá o gargalo da CPU na próxima década.

Se você trabalha com infraestrutura há mais de 15 anos, já ouviu a frase "A Fita Magnética (Tape) morreu" pelo menos uma dúzia de vezes. Spoiler: a fita não morreu, ela apenas se mudou para o porão frio do archival profundo. Agora, a indústria aponta o dedo para o Hard Disk Drive (HDD).

A promessa é sedutora: um mundo All-Flash onde a latência é medida em microssegundos e partes móveis são coisas de museu. Mas, como sysadmin veterano, meu trabalho não é acreditar em PowerPoints de vendas, é garantir que os dados estejam íntegros e o orçamento não exploda. A transição para o Flash total e a chegada do Computational Storage são tendências reais, mas o caminho até 2030 é pavimentado por gargalos físicos e armadilhas de licenciamento que precisamos dissecar friamente.

Vamos cortar o hype e olhar para a engenharia.

O QUE É A TRANSIÇÃO PARA COMPUTATIONAL STORAGE? A transição da Era HDD para o Computational Storage não é apenas uma troca de mídia magnética por silício, mas uma mudança arquitetural onde o processamento de dados ocorre no próprio dispositivo de armazenamento (in-situ). Isso elimina a movimentação desnecessária de dados pelo barramento PCIe, reduzindo drasticamente a latência e o TCO, transformando HDDs mecânicos em nichos de arquivamento frio ("novo tape") até o final da década.

A Falácia do Preço por Gigabyte: CapEx vs TCO Real em Flash

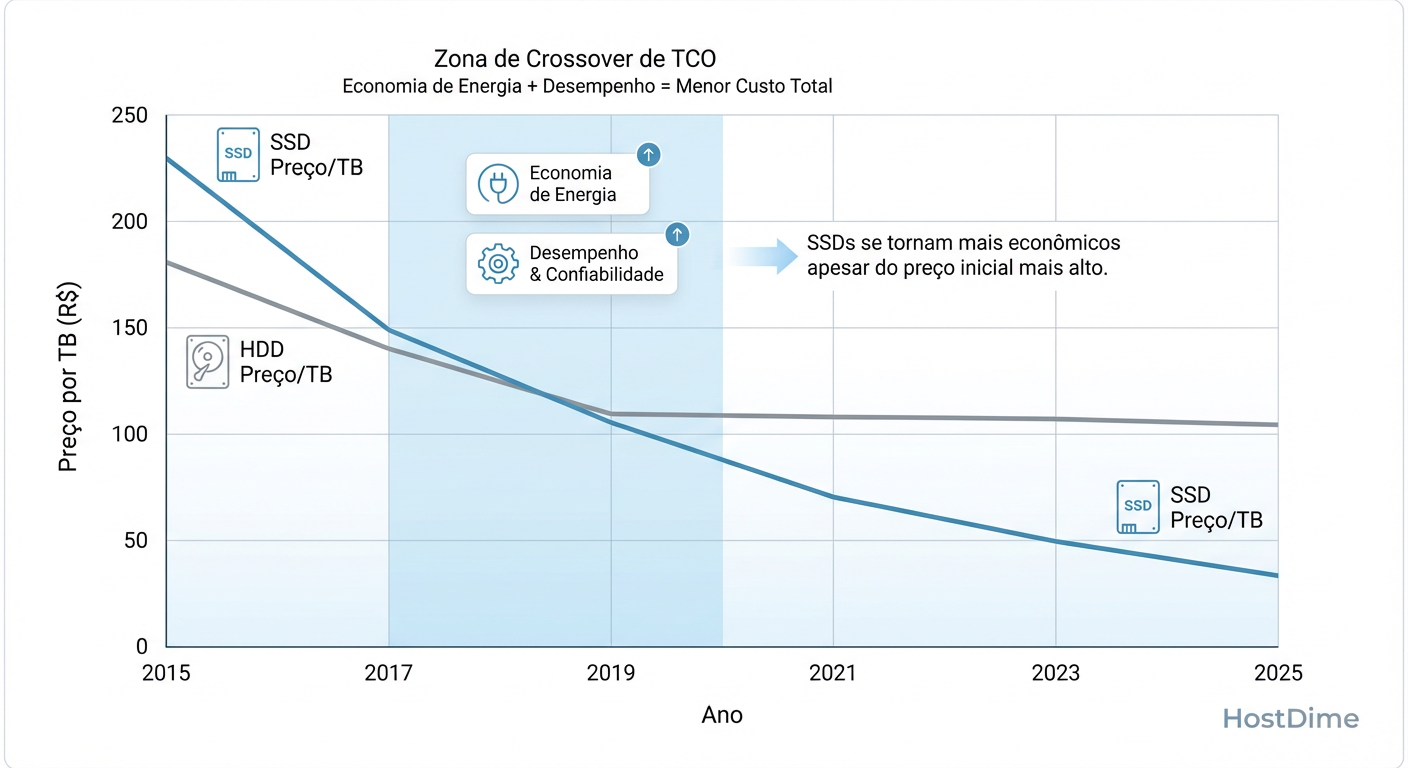

O primeiro erro do admin júnior é abrir a planilha do fornecedor e olhar apenas a coluna "Custo por TB". Se você fizer isso, o HDD mecânico ainda vence e vencerá por alguns anos. Mas operar um datacenter não é comprar peças no varejo; é gerenciar espaço, energia e falhas.

O custo real do armazenamento é definido pelo TCO (Total Cost of Ownership). Um HDD de 20TB consome, em média, 7-9 Watts para girar pratos a 7200 RPM, gerando calor que exige ar condicionado (mais Watts). Um SSD QLC (Quad-Level Cell) de alta densidade pode consumir mais em pico de escrita, mas em idle e em leituras, a eficiência energética por IOPS é ordens de magnitude superior.

Figura: Gráfico de Paridade SSD vs HDD: A Zona de TCO inverte a lógica econômica antes mesmo da paridade de preço bruto.

Figura: Gráfico de Paridade SSD vs HDD: A Zona de TCO inverte a lógica econômica antes mesmo da paridade de preço bruto.

Como o gráfico acima ilustra, existe um ponto de inflexão — a "Zona de TCO". Mesmo que o SSD custe 2x mais caro na compra (CapEx), se ele permite que você consolide 4 racks de HDDs em meio rack de Flash, economizando milhares de dólares em energia e portas de switch por ano, o HDD já perdeu a guerra econômica.

O Checklist do Ceticismo Econômico

Antes de assinar a compra de um novo storage array híbrido ou HDD-only, meça:

Densidade de Rack: Quantos PB cabem em 4U? O Flash já ultrapassou o HDD aqui.

Custo de Reconstrução (Rebuild): Quanto tempo leva para reconstruir um HDD de 22TB em RAID 6? Dias. E o desempenho do array cai. Em Flash, são horas ou minutos. Tempo é risco.

W/TB (Watts por Terabyte): Essa é a métrica que vai demitir ou promover gerentes de DC em 2030.

A Física da Densidade de Área em HDDs vs a Verticalização 3D NAND

Por que o HDD está perdendo fôlego? Física simples. Para aumentar a capacidade de um HDD, precisamos espremer mais bits no mesmo prato magnético (Densidade de Área). Estamos atingindo o limite do superparamagnetismo. Tecnologias como HAMR (Heat-Assisted Magnetic Recording) usam lasers para aquecer o disco momentaneamente para gravar dados. É uma engenharia fascinante, mas complexa e cara.

Do outro lado, temos a Lei de Moore aplicada ao Flash: 3D NAND. O SSD parou de tentar encolher os transistores horizontalmente e começou a construir arranha-céus. Passamos de 64 camadas para 176, 232 e já falamos em mais de 500 camadas.

A escalabilidade do silício é vertical. A do HDD é mecânica e bidimensional. É uma luta injusta a longo prazo. O HDD não consegue acompanhar a curva de densidade sem aumentar a complexidade mecânica (e o risco de falha).

O Novo Gargalo de I/O: Quando a CPU não aguenta a Movimentação de Dados

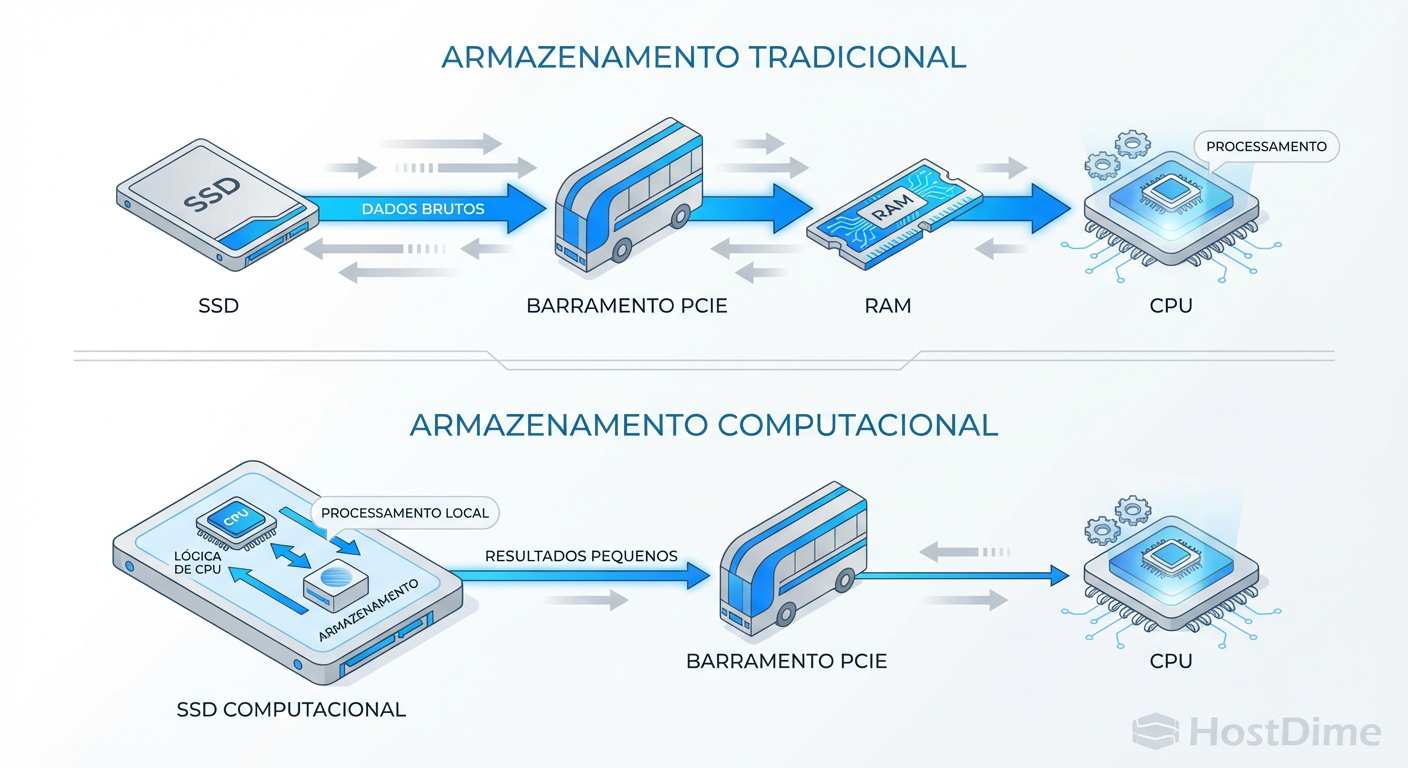

Aqui entramos no problema que o Computational Storage promete resolver. No modelo clássico, se você quer procurar a string "ERROR" em um log de 10TB, o processo é:

CPU solicita leitura ao SSD.

SSD envia 10TB de dados pelo barramento PCIe.

Memória RAM armazena buffers.

CPU processa o

grep.CPU descarta 99.99% dos dados e fica com a linha do erro.

Isso é movimentação de dados inútil. Com a velocidade dos SSDs NVMe Gen4 e Gen5, o gargalo não é mais o disco. O gargalo é a CPU, que gasta ciclos preciosos apenas gerenciando interrupções e copiando memória.

Callout de Risco: Em servidores modernos de banco de dados, é comum ver CPUs a 100% de uso onde 40% é

iowaitou kernel overhead lidando com a pilha de rede/storage, não processando SQL.

Computational Storage na Prática: Trazendo o grep para dentro do SSD

O conceito de Computational Storage (CSD - Computational Storage Drives) é simples: coloque uma CPU (ARM ou RISC-V) ou um FPGA direto na controladora do SSD.

Em vez de puxar os dados para a CPU principal (Host), o Host envia o código (ou a função) para o SSD. O SSD executa o filtro localmente e devolve apenas o resultado (alguns KBs).

Figura: Arquitetura de Computational Storage: Reduzindo a latência e o tráfego no barramento PCIe processando dados in-situ.

Figura: Arquitetura de Computational Storage: Reduzindo a latência e o tráfego no barramento PCIe processando dados in-situ.

Onde isso brilha?

Compressão/Descompressão Transparente: O SSD grava comprimido sem a CPU principal saber.

Database Filter Pushdown: Bancos de dados analíticos (OLAP) pedem ao SSD: "Me dê apenas as linhas onde

ano > 2023". O tráfego no barramento cai drasticamente.Encoding de Vídeo: O SSD transcodifica o arquivo enquanto ele está sendo lido.

Na prática, não estamos rodando comandos bash soltos, mas usando APIs estendidas do NVMe. Um exemplo hipotético de como a indústria está tentando padronizar isso via NVMe Computational Storage Standard:

# CENÁRIO HIPOTÉTICO (Conceitual)

# Em vez de ler o arquivo todo:

# cat /mnt/nvme0/bigdata.log | grep "CRITICAL"

# Enviamos a operação para o namespace computacional:

nvme-cli computational-op --namespace-id=1 --op=filter --pattern="CRITICAL" --input-lba=0 --len=100GB

Riscos de Vendor Lock-in e Complexidade de Drivers em CSDs

Aqui entra o meu ceticismo. A ideia é linda, a execução é um campo minado.

O Pesadelo da Depuração: Se o seu

grepfalha na CPU, você tem logs do kernel, dmesg, strace. Se o código falha dentro do firmware fechado de um SSD proprietário, boa sorte. Como você monitora a RAM interna do SSD?Vendor Lock-in: Hoje, se um SSD Samsung morre, eu troco por um Micron. Se eu escrevi minha aplicação dependendo de uma função de filtragem FPGA específica do modelo X da Vendor Y, eu estou preso a eles para sempre.

Segurança: Estamos dando capacidade de execução de código para o firmware do disco. A superfície de ataque aumenta. Um malware persistente no firmware do SSD que filtra dados bancários antes de o SO vê-los? Plausível.

Tabela Comparativa: Onde estamos pisando

| Característica | HDD Enterprise (Helium) | SSD NVMe Padrão | Computational Storage (CSD) |

|---|---|---|---|

| Custo/GB (Raw) | Baixo (Vencedor Atual) | Médio | Alto (Premium) |

| Custo/IOPS | Péssimo | Excelente | Excelente |

| Gargalo Principal | Mecânico (Seek Time) | Barramento PCIe / CPU | Complexidade de Software |

| Uso de CPU Host | Baixo (p/ IOPS baixos) | Alto (Polling/Interrupts) | Mínimo (Offloading) |

| Padronização | Total (SATA/SAS) | Total (NVMe) | Em desenvolvimento (SNIA/NVMe) |

| Risco Operacional | Falha Mecânica | Desgaste de Célula | Bugs de Firmware/API proprietária |

O Cenário 2030: O HDD como o novo "Tape" e o Flash como padrão universal

Olhando para a próxima década, a tendência é clara, mas não binária. O HDD não vai desaparecer, mas sua função vai mudar radicalmente.

Tier 0 e Tier 1 (Produção/Quente): Será 100% Flash (NVMe). Não faz sentido econômico ou de performance ter HDDs aqui.

Tier 2 (Warm): Flash QLC/PLC de alta densidade. O Computational Storage encontrará seu nicho aqui, processando grandes data lakes analíticos.

Tier 3 (Cold/Archive): HDDs de alta capacidade (30TB+ com SMR/HAMR). Eles serão ligados apenas para gravação sequencial e leitura ocasional. Eles se tornarão o "Tape Online".

Tier 4 (Deep Archive): Fita LTO (Sim, ela continua viva pelo custo imbatível de energia zero em repouso).

Conclusão Pragmática: Não corra para implementar Computational Storage amanhã a menos que você seja um Hyperscaler (Google/Meta) com engenheiros capazes de escrever drivers de firmware. Para o resto de nós mortais: foque em migrar cargas de trabalho ativas para All-Flash para reduzir TCO de energia e licenças, e trate o HDD como um repositório de backup barato, lento e confiável. A revolução está vindo, mas deixe os early adopters sangrarem primeiro.

Referências & Leitura Complementar

SNIA (Storage Networking Industry Association): Computational Storage Architecture and Programming Model (Versão 0.8 rev). Define os padrões para evitar o caos proprietário.

NVM Express Base Specification 2.0: Seção sobre Zoned Namespaces (ZNS) e Key Value Command Sets. A base técnica para entender como o NVMe evoluiu além de simples blocos.

OCP (Open Compute Project): NVMe Cloud SSD Specification. O que os grandes players (Meta/Microsoft) exigem dos fabricantes de SSD.

Backblaze Drive Stats: Relatórios trimestrais de falhas de HDD. A única fonte pública confiável de durabilidade de HDDs em escala real.

Dr. Marcus 'Bitrot' Silva

Engenheiro Sênior de Armazenamento

20 anos recuperando RAIDs quebrados. Especialista em ZFS e sistemas de arquivos distribuídos. Já viu mais falhas de disco do que gostaria.