Paridade Distribuida Como RAID 56 Escreve De Verdade

Seu chefe acabou de propor migrar o banco de dados para um RAID 5 para "economizar". Prepare-se para o desastre. RAID 5 e 6, apesar de suas vantagens em capacid...

Paridade Distribuida Como RAID 56 Escreve De Verdade

Seu chefe acabou de propor migrar o banco de dados para um RAID 5 para "economizar". Prepare-se para o desastre. RAID 5 e 6, apesar de suas vantagens em capacidade utilizável, escondem complexidades que podem detonar a performance e a confiabilidade, especialmente em cargas de escrita intensas e discos de alta capacidade. Entenda como a paridade é calculada e escrita, e você verá porque RAID 5/6 não é a solução mágica que parece.

A Dança dos Bits: Como a Paridade Funciona

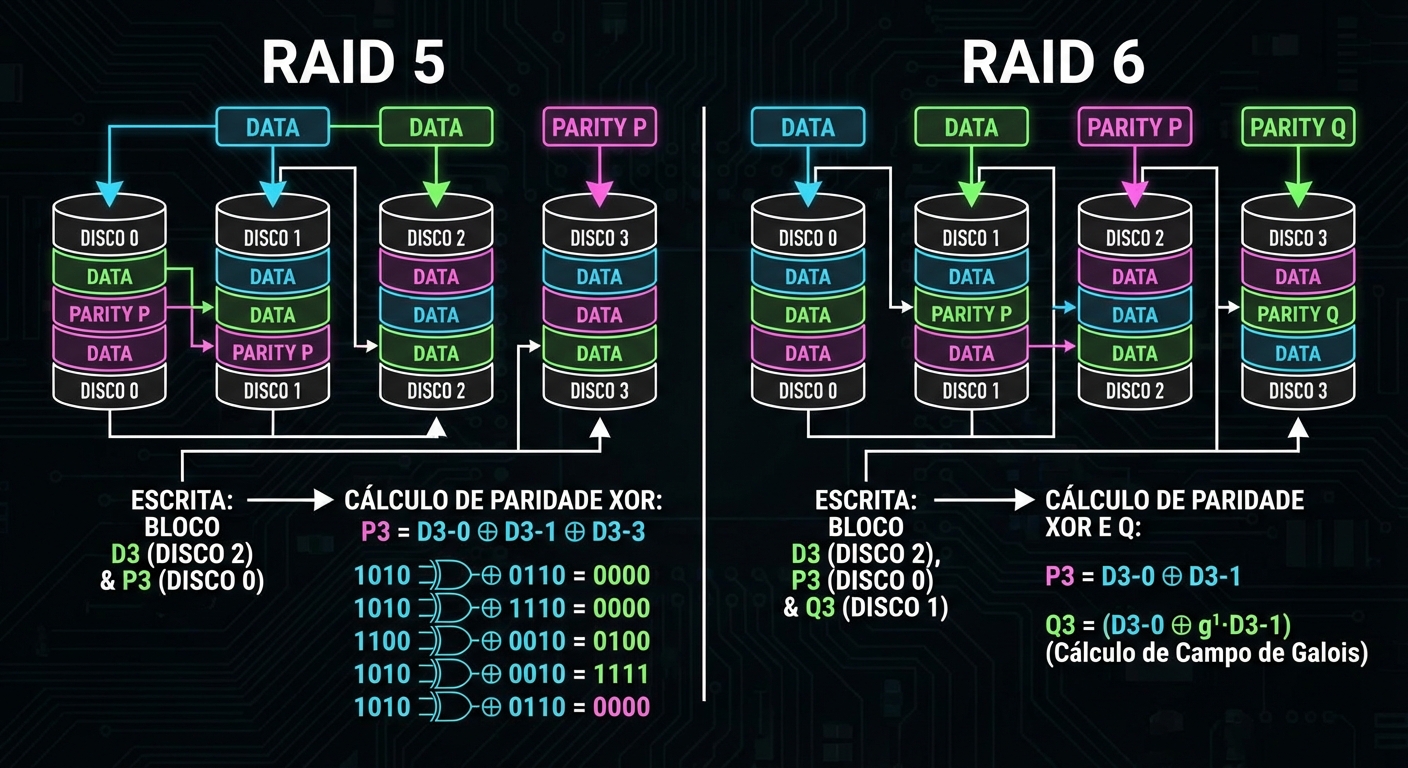

RAID 5 e 6 protegem contra perda de dados através de paridade. A paridade é um cálculo (XOR, para ser exato) sobre os dados em todos os discos do array. No RAID 5, a paridade é armazenada distribuída entre os discos. No RAID 6, são duas paridades, permitindo a falha de dois discos simultaneamente.

Imagine que você tem três discos (A, B, C) em um RAID 5. Você quer escrever um bloco de dados "D" no disco A. O controlador RAID calcula a paridade "P" como P = B XOR C XOR D. Esse valor de paridade "P" é então escrito em um dos outros discos (digamos, o disco C).

O problema surge quando você precisa reescrever o bloco "D".

O Inferno da Reescrita: Read-Modify-Write

Para reescrever o bloco "D" no nosso exemplo RAID 5, o controlador precisa:

- Ler o bloco "B".

- Ler o bloco "C" (que contém a paridade "P").

- Calcular a nova paridade "P_novo = B XOR C XOR D_novo".

- Escrever o novo bloco "D_novo".

- Escrever a nova paridade "P_novo" no disco C.

Isso é conhecido como o ciclo "Read-Modify-Write". Para cada escrita sua aplicação está gerando quatro operações de I/O no disco. Esse efeito é conhecido como write penalty.

Warning: A write penalty significa que o RAID 5/6 nunca vai atingir a performance de escrita que você espera, especialmente em workloads com muitas escritas aleatórias.

Visualizando o Gargalo: O Que Acontece no Silício

Pense no controlador RAID como um maestro regendo uma orquestra de discos. Cada "instrumento" (disco) tem um tempo de resposta. Quando você precisa fazer um "Read-Modify-Write", o maestro tem que esperar todos os instrumentos tocarem suas notas antes de poder conduzir a próxima parte da música.

Controladores RAID mais modernos tentam mitigar isso com cache (tanto leitura quanto escrita), mas o cache é finito e, em caso de falta de energia, dados no cache de escrita podem ser perdidos (a menos que haja uma unidade de backup de bateria - BBU).

Quando a Paridade Te Salva (e Quando Te Afoga)

RAID 5/6 pode ser útil em cenários específicos:

- Arquivamento de dados frios: Dados que são raramente modificados, mas precisam de redundância básica.

- Leitura intensiva: RAID 5/6 tem boa performance de leitura (já que a leitura é feita diretamente dos discos de dados).

- Orçamento apertado: RAID 5/6 oferece uma boa relação custo/capacidade se a performance não for crítica.

Mas RAID 5/6 é péssimo para:

- Bancos de dados: A carga de escrita intensa e aleatória vai estrangular o desempenho.

- Virtualização: VMs geram muita escrita aleatória, exacerbando o problema da paridade.

- Discos grandes: O tempo de reconstrução de um RAID 5 com discos de 10TB+ pode levar dias, aumentando drasticamente a janela de vulnerabilidade. Além disso, a probabilidade de um URE (Unrecoverable Read Error) durante a reconstrução aumenta exponencialmente com a capacidade do disco, tornando a reconstrução um jogo de azar.

Note: UREs são erros de leitura que o disco não consegue corrigir internamente. Em um RAID 5, um único URE durante a reconstrução significa perda de dados.

Diagnóstico: A Verdade Está nos Números

Para diagnosticar problemas de performance em um RAID 5/6, use estas ferramentas:

iostat -xz 1: Monitore%util(utilização do disco),await(tempo médio de espera por I/O),r/s(leituras por segundo) ew/s(escritas por segundo). Se você vir alta utilização e tempos de espera altos, o RAID está sobrecarregado.smartctl -a /dev/sda: Verifique os atributos SMART dos discos, especialmente erros de leitura/escrita e setores realocados. Isso pode indicar falhas iminentes.cat /proc/mdstat: Veja o status do array RAID, incluindo o progresso de reconstruções.

Sinais de Saúde:

- Baixa utilização do disco em períodos de pico de carga.

- Tempos de espera (await) consistentes e baixos.

- Nenhum erro relatado nos atributos SMART.

Sinais de Perigo:

- Utilização do disco consistentemente acima de 80%.

- Tempos de espera (await) altos (acima de 20ms).

- Erros de leitura/escrita ou setores realocados nos atributos SMART.

- Reconstruções demorando mais do que o esperado.

O Veredito Final: Fuja do RAID 5 (e Pense Bem no RAID 6)

RAID 5 é uma armadilha em potencial. A economia inicial em capacidade é rapidamente anulada pela péssima performance de escrita e pelo risco aumentado de perda de dados durante a reconstrução. RAID 6 é um pouco melhor, mas ainda sofre dos mesmos problemas de write penalty.

Se você precisa de performance e confiabilidade, considere RAID 10 (striping de espelhos) ou ZFS. Eles oferecem melhor performance de escrita e mecanismos de proteção de dados mais robustos. Não caia na armadilha da "economia" do RAID 5/6. O custo da perda de dados é sempre maior.

Elena Kovacs

Arquiteta de Cloud Infrastructure

Focada em NVMe-oF e storage definido por software. Projeta clusters de petabytes para grandes provedores de nuvem.