QLC em Archival de IA: Física do Bit Rot, Retenção e Riscos Reais

Análise técnica sobre a viabilidade de SSDs QLC para armazenamento de longo prazo em IA. Entenda a física da retenção de dados, read disturb e por que o 'custo por TB' pode enganar.

O mercado de armazenamento vive um momento de euforia perigosa com a adoção de SSDs QLC (Quad-Level Cell) para cargas de trabalho de Inteligência Artificial. A promessa é sedutora: densidade próxima à de HDDs com latências de NVMe. Para engenheiros que precisam alimentar clusters de GPUs famintos por dados, parece a solução perfeita para o "Warm Tier" ou até mesmo para o arquivamento de datasets massivos.

No entanto, a física do estado sólido não negocia com orçamentos de TI. Quando tratamos de dados estáticos de longo prazo (Archival) ou dados lidos repetidamente (Training Sets), o QLC apresenta comportamentos de degradação de sinal e latência de cauda que são frequentemente ignorados nas folhas de especificações de marketing. Não estamos falando apenas de velocidade, mas da integridade fundamental do bit gravado.

O risco do QLC em Archival de IA reside na drástica redução da margem de ruído elétrico necessária para distinguir os 16 estados de tensão de uma célula. Sem mecanismos agressivos de Scrubbing e Erasure Coding, a retenção de dados (Data Retention) degrada-se rapidamente sem energia, e o fenômeno de Read Disturb pode corromper datasets durante épicos de treinamento intensivo.

A Física do QLC e as Margens de Tensão

Para entender por que o QLC é frágil, precisamos descer ao nível do transistor de porta flutuante (floating-gate) ou charge trap. Em um SSD, não gravamos "zeros e uns" diretamente; injetamos elétrons em uma armadilha isolada para alterar a tensão de limiar ($V_{th}$) da célula.

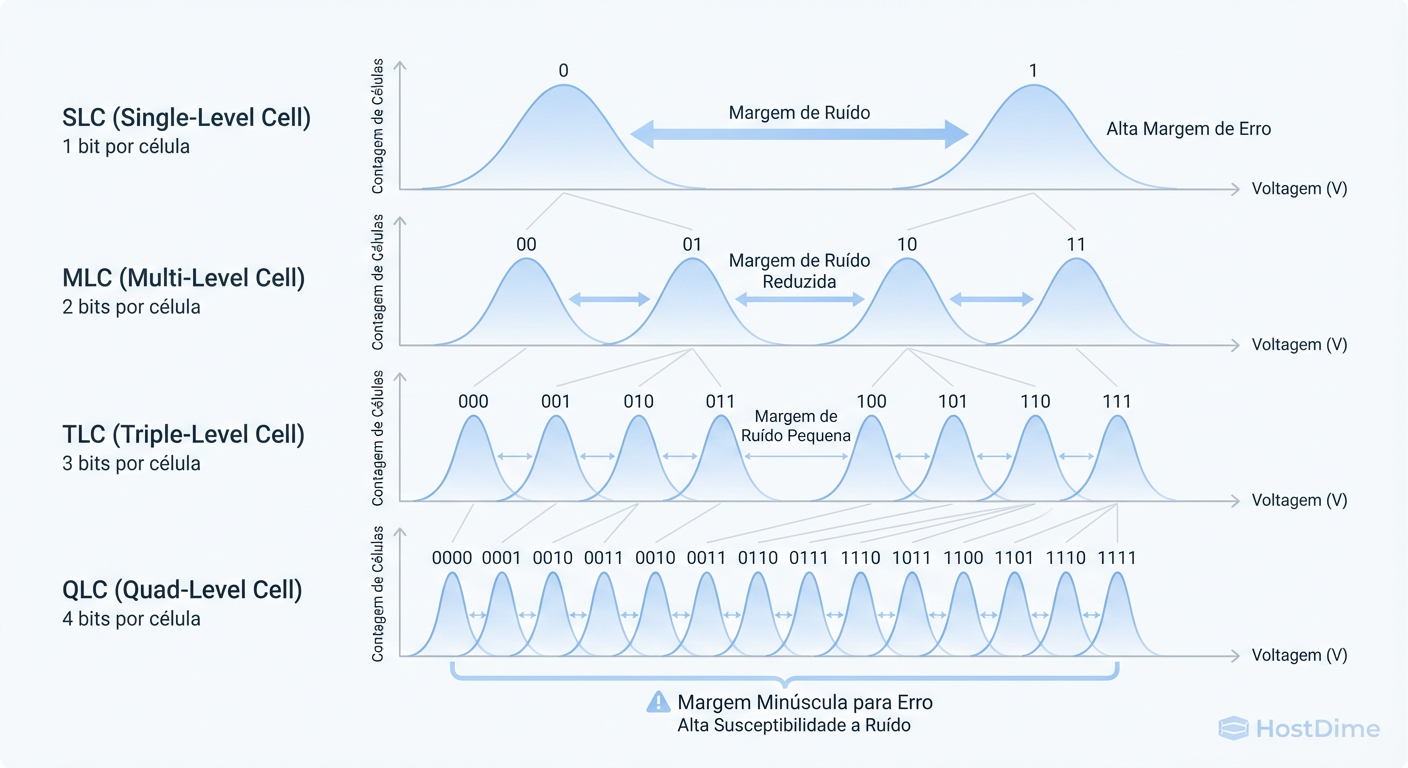

No SLC (Single-Level Cell), temos apenas dois estados: carregado ou descarregado. A margem de erro é enorme. Você pode perder muitos elétrons (vazamento de carga) e o controlador ainda saberá que aquilo é um "1".

No QLC, precisamos armazenar 4 bits por célula. Isso exige 16 níveis distintos de tensão dentro do mesmo envelope físico de voltagem.

Figura: Figura 1: A redução drástica da margem de ruído (Noise Margin) do SLC para o QLC. Menos espaço para erro significa maior suscetibilidade a Bit Rot.

Figura: Figura 1: A redução drástica da margem de ruído (Noise Margin) do SLC para o QLC. Menos espaço para erro significa maior suscetibilidade a Bit Rot.

Como a Figura 1 ilustra, a "janela" de tensão para cada estado no QLC é minúscula. Isso cria um problema duplo de engenharia:

Precisão na Escrita: O controlador precisa ser cirúrgico ao injetar elétrons. Isso leva tempo (aumentando a latência de programação).

Sensibilidade na Leitura: Qualquer vazamento mínimo de elétrons ao longo do tempo (Bit Rot) faz com que a tensão da célula cruze o limiar para o estado vizinho, corrompendo o dado.

Em datasets de IA, onde um bit flip no cabeçalho de um arquivo Parquet ou em um tensor de pesos pode invalidar horas de treinamento ou inferência, essa margem de erro reduzida não é apenas um detalhe técnico; é um vetor de falha silenciosa.

Tabela Comparativa: A Realidade dos Bits

| Característica | SLC (Single) | TLC (Triple) | QLC (Quad) | Impacto em IA |

|---|---|---|---|---|

| Bits por Célula | 1 | 3 | 4 | Aumento de densidade. |

| Estados de Tensão | 2 | 8 | 16 | Complexidade exponencial de leitura/escrita. |

| Endurance (P/E Cycles) | ~100.000 | ~3.000 | ~100 - 1.000 | Vida útil curta para re-treinamentos constantes. |

| Tempo de Programação (tPROG) | ~200µs | ~500µs | ~2.000+µs | Latência de ingestão muito maior. |

| Risco de Bit Rot | Baixíssimo | Moderado | Alto | Exige paridade robusta (ZFS/RAID6). |

O Mito do Cold Storage em Flash e a Retenção JEDEC

Existe uma crença perigosa de que SSDs são mídias de "gravar e esquecer". Para QLC, isso é falso. Diferente de fitas magnéticas ou discos ópticos, o flash perde carga. A especificação JEDEC (JESD218) define os padrões de retenção, mas as letras miúdas são cruciais.

A retenção de dados em SSDs é inversamente proporcional ao desgaste (P/E cycles consumidos) e dependente da temperatura.

A Regra: Um SSD QLC no fim da vida útil (perto do limite de TBW), desligado e armazenado a 30°C, pode reter dados por apenas 3 meses antes que a taxa de erro de bits (UBER) exceda a capacidade do ECC corrigir.

O Cenário IA: Você treina um modelo, arquiva o dataset de 500TB em arrays QLC e desliga os nós para economizar energia (Cold Storage). Seis meses depois, ao tentar revalidar o modelo, você encontra corrupção silenciosa.

Se o seu plano de Archival envolve deixar SSDs QLC sem energia por longos períodos, você não tem um backup; você tem um capacitor descarregando lentamente.

Read Disturb e a Ameaça nos Épicos de Treinamento

A carga de trabalho de IA é peculiar: ela é Read-Intensive de uma maneira patológica. Durante o treinamento, o mesmo dataset é lido centenas de vezes (épicos).

Aqui entra o Read Disturb. Para ler uma página em um bloco NAND, o controlador aplica uma tensão de passagem ($V_{pass}$) nas páginas adjacentes não selecionadas. Em QLC, devido às margens de tensão estreitas que discutimos (Figura 1), essa tensão de passagem pode, inadvertidamente, injetar elétrons nas células vizinhas.

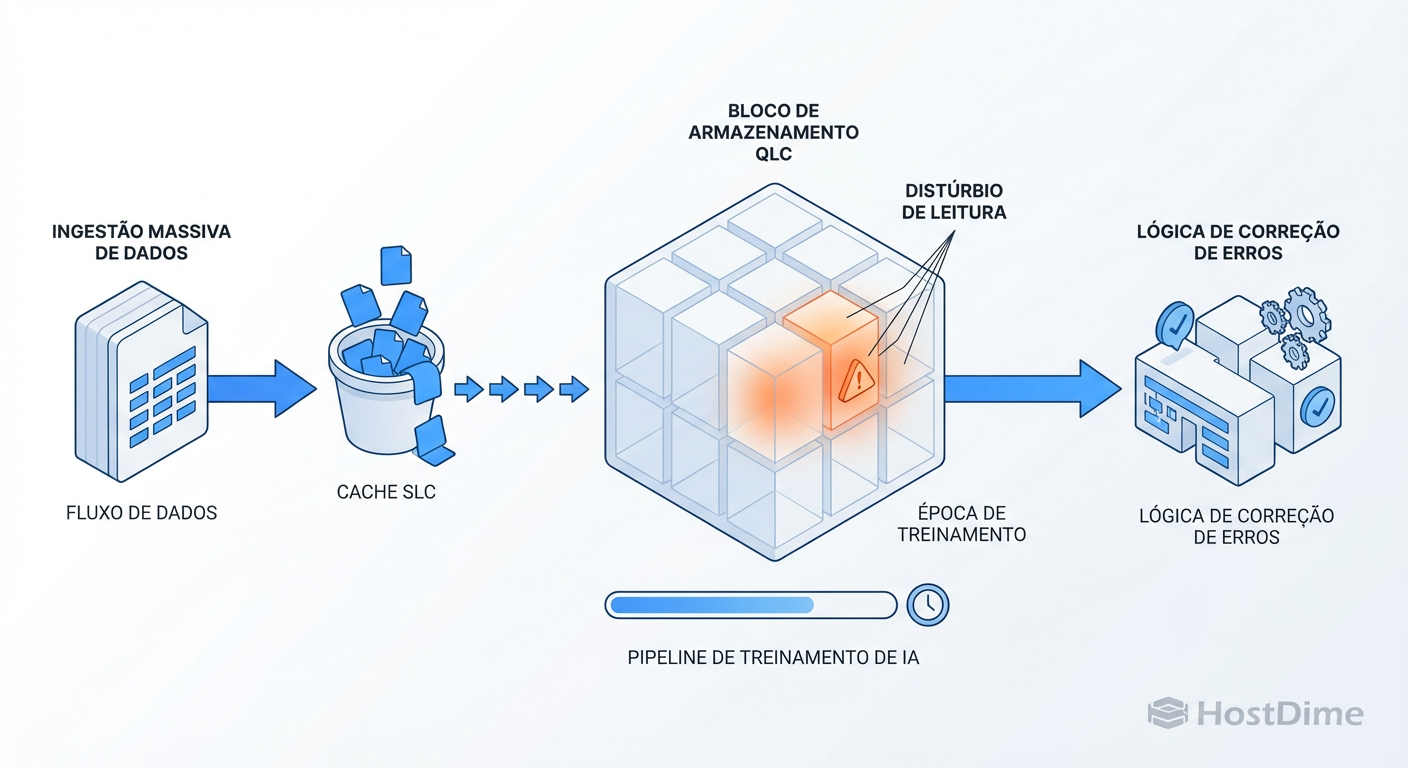

Figura: Figura 2: O ciclo de vida do dado de IA no QLC. O risco de 'Write Cliff' na ingestão e 'Read Disturb' durante as leituras repetitivas do treinamento.

Figura: Figura 2: O ciclo de vida do dado de IA no QLC. O risco de 'Write Cliff' na ingestão e 'Read Disturb' durante as leituras repetitivas do treinamento.

Como mostrado na Figura 2, o ciclo de vida do dado em IA no QLC é hostil:

Ingestão: Escrita sequencial massiva.

Treinamento: Leituras repetitivas em alta profundidade de fila (Queue Depth).

Risco: As células vizinhas sofrem estresse elétrico sem nunca serem reescritas. Isso causa "soft errors".

O controlador do SSD tenta mitigar isso movendo dados (Read Reclaim), mas isso consome ciclos de P/E e aumenta a latência imprevisivelmente, causando stuttering no fornecimento de dados para a GPU.

O Abismo da Escrita na Ingestão de Datasets

Todo SSD QLC moderno usa uma parte da capacidade como cache pSLC (Pseudo-SLC). Ele trata células QLC como SLC (1 bit) para absorver escritas rapidamente. O problema na IA é o volume. Datasets de treinamento (ex: Common Crawl, ImageNet, vídeos 4K) são massivos e sequenciais.

Quando o cache pSLC enche, o drive cai no "Abismo da Escrita" (Write Cliff). O controlador precisa:

Escrever diretamente em QLC (lento e preciso).

Ou pior: compactar o cache pSLC em QLC em tempo real para liberar espaço (Folding).

Neste ponto, um drive NVMe que prometia 3.000 MB/s pode cair para 80 MB/s ou 160 MB/s — mais lento que um HDD mecânico moderno. Se o seu pipeline de ingestão não prevê isso, suas GPUs de $30.000 ficarão ociosas esperando I/O.

Como medir o Write Cliff

Não confie no hdparm. Para ver o abismo, você precisa saturar o cache. Use o fio para escrever um volume maior que o cache estimado (geralmente 10-20% do disco livre).

# Teste de escrita sequencial sustentada para estourar o cache SLC.

fio --name=qlc_cliff_test \

--filename=/mnt/qlc_storage/testfile.dat \

--size=500G \

--rw=write \

--bs=1M \

--direct=1 \

--ioengine=libaio \

--iodepth=32 \

--runtime=1200 \

--time_based \

--group_reporting

Monitore o throughput em tempo real (via iostat -dx 1). Você verá uma queda abrupta e sustentada após alguns minutos. Esse é o desempenho real do seu arquivamento.

Mitigação Obrigatória: ZFS e Scrubbing em QLC

Dado que a física do QLC joga contra a integridade a longo prazo, confiar cegamente no controlador do disco é negligência. A mitigação deve ocorrer na camada de software. O sistema de arquivos deve ser ciente da podridão de bits.

1. Redundância não é opcional

Em arrays QLC para IA, RAIDZ2 (paridade dupla) é o mínimo aceitável. RAIDZ1 ou Espelhamento (Mirror) são arriscados porque, durante a reconstrução de um disco falho (que será lenta devido à escrita QLC), a probabilidade de encontrar um erro de leitura (URE) em outro disco QLC é estatisticamente alta.

2. Scrubbing Agressivo

O Scrubbing (varredura) lê os dados e verifica checksums. Em HDDs, fazemos mensalmente. Em QLC com dados estáticos, a frequência deve aumentar para combater o voltage drift. Se os dados são "frios" (WORM - Write Once Read Many), o controlador do SSD não os toca frequentemente. O ZFS força essa leitura, permitindo que o controlador detecte células fracas e faça o remapeamento.

3. Tuning de Recordsize para IA

Para evitar a amplificação de escrita (Write Amplification) que destrói o QLC, alinhe o recordsize do ZFS com o tamanho dos seus arquivos de dataset.

Para arquivos grandes (TFRecords, vídeos): Use

1M.Isso reduz a sobrecarga de metadados e melhora a eficiência do pSLC cache.

# Exemplo de criação de dataset otimizado para QLC Archival

zfs create -o recordsize=1M \

-o compression=lz4 \

-o atime=off \

-o primarycache=metadata \

tank/ai_archival

# Verifique o status de erros físicos nos dispositivos

smartctl -a /dev/nvme0n1 | grep "Media and Data Integrity Errors"

Veredito Técnico Operacional

O QLC tem seu lugar na IA: ele é excelente para Data Lakes de leitura intensiva onde o custo por TB é crítico e o desempenho de HDD é inaceitável. Porém, tratá-lo como "Cold Storage" passivo é um erro.

O modelo mental correto para QLC é: "Mídia volátil que requer manutenção ativa".

Se você vai usar QLC para arquivamento:

Mantenha os servidores ligados.

Configure Scrubbing frequente.

Nunca encha o drive acima de 80% (para manter o pSLC saudável).

Entenda que a performance de ingestão cairá drasticamente após o estouro do cache.

Sem essas precauções, seu dataset de treinamento não é um ativo; é uma responsabilidade estatística esperando para falhar.

Referências & Leitura Complementar

JEDEC JESD218: Solid-State Drive (SSD) Requirements and Endurance Test Method. (Define os padrões de retenção vs. temperatura).

Micron Technical Note TN-29-17: NAND Flash Reliability Mechanisms (Explicação detalhada sobre Read Disturb e Program Disturb).

USENIX FAST '16: "Flash Reliability in Production: The Expected and the Unexpected" (Estudo de campo sobre falhas reais em datacenters).

OpenZFS Documentation: Tuning ZFS for Flash Storage.

Marta G. Oliveira

DevOps Engineer & Storage Nerd

Automatiza provisionamento de storage com Terraform e Ansible. Defensora do 'Infrastructure as Code' para storage.