RAID 50 e RAID 60: Arquitetura, Performance e a Matemática do Risco

Entenda quando o RAID aninhado (Nested) salva seu storage. Análise técnica de RAID 50 vs 60: penalidade de escrita, domínios de falha e trade-offs reais de capacidade.

A escalabilidade linear é o maior mito do armazenamento de dados. Quando um administrador júnior olha para uma controladora e pensa: "Se 8 discos em RAID 5 são bons, 24 discos serão três vezes melhores", ele está caminhando para um precipício estatístico.

O armazenamento não escala apenas adicionando eixos (spindles). Há um limite físico e matemático onde a paridade tradicional se torna um passivo operacional, transformando o tempo de reconstrução (rebuild) de um incômodo em um evento de indisponibilidade catastrófica. É aqui que entram as arquiteturas aninhadas (nested RAID).

RAID 50 e RAID 60 são níveis de RAID aninhados que combinam o striping em nível de bloco (RAID 0) sobre múltiplos sub-arrays de paridade (RAID 5 ou 6). Essa arquitetura segmenta o armazenamento para equilibrar a densidade de dados com maior desempenho de escrita aleatória e domínios de falha isolados, mitigando os riscos de arrays monolíticos.

O Problema dos Arrays Largos e a Falha do RAID 5 e 6 em Escala

Para entender a necessidade do aninhamento, precisamos primeiro dissecar a falha dos arrays "largos" (wide arrays). Imagine um RAID 6 constituído por 24 discos rígidos mecânicos (HDDs) de 10TB.

O gargalo do cálculo de paridade: Embora controladoras modernas tenham ASICs dedicados, calcular paridade dupla (P+Q) através de 22 discos de dados para cada operação de escrita introduz latência.

A matemática do Rebuild: Se um disco falha nesse array de 24 discos, a controladora precisa ler os 23 discos restantes inteiros para reconstruir o dado perdido. Com discos de 10TB, estamos falando de ler 230TB de dados. A uma velocidade média sustentada de 150MB/s (otimista para um array em uso), esse rebuild pode levar dias.

URE (Unrecoverable Read Error): A probabilidade de encontrar um setor defeituoso durante a leitura de 230TB é estatisticamente alta. Se isso ocorrer durante um rebuild de RAID 5, o array morre. No RAID 6, você perde a redundância restante.

Engenheiros de performance não confiam na sorte; nós confiamos na redução da superfície de ataque. É necessário quebrar o array gigante em pedaços gerenciáveis.

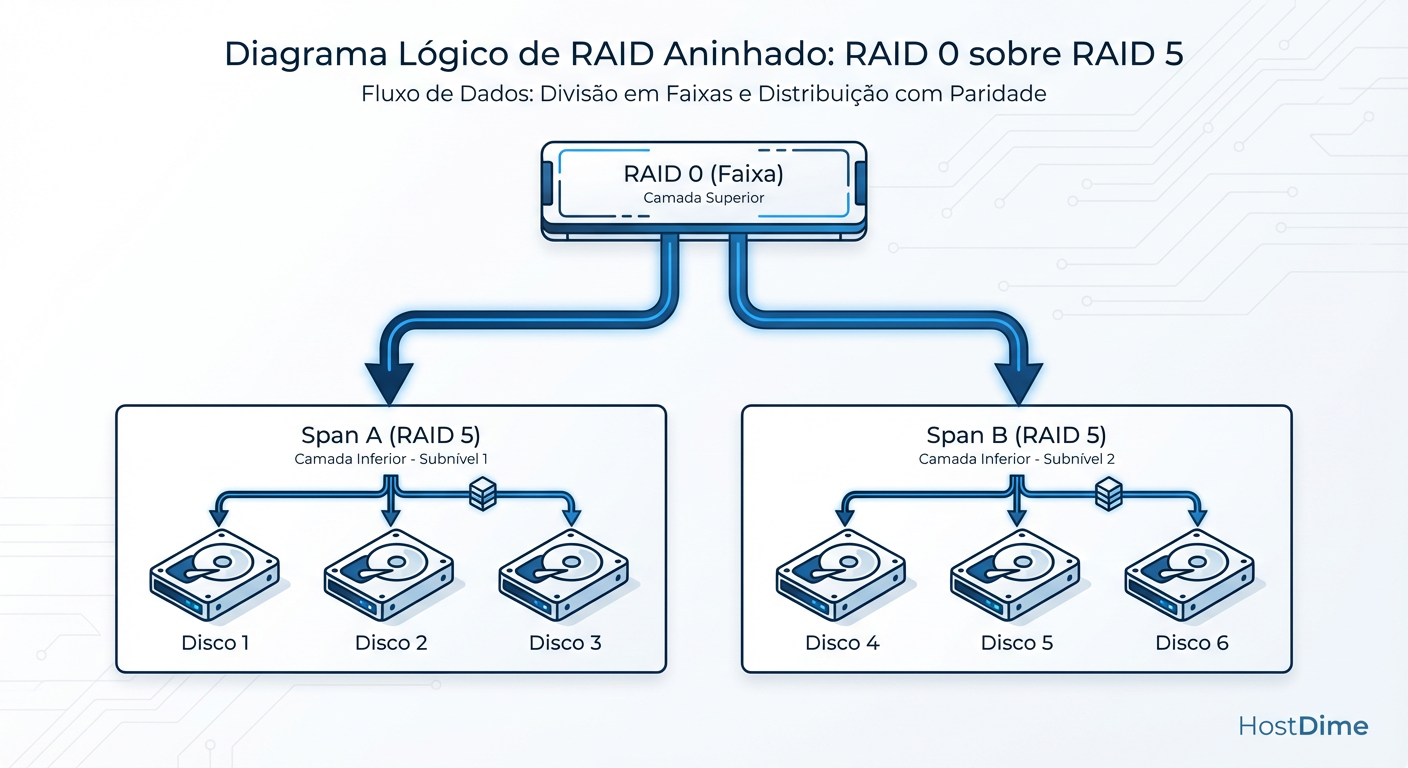

Arquitetura Lógica do RAID 50 e 60: Entendendo Spans e Sub-arrays

O RAID 50 não é um nível novo de mágica; é uma estratégia de "dividir e conquistar". Ele pega o conceito de RAID 0 (Striping) e o aplica não sobre discos individuais, mas sobre grupos de discos, chamados de Spans (ou "legs").

Camada Inferior (RAID 5/6): Você cria múltiplos arrays pequenos (ex: 3 arrays de 8 discos cada). Cada um desses grupos cuida de sua própria paridade.

Camada Superior (RAID 0): A controladora faz o striping dos dados através desses 3 arrays como se fossem 3 discos gigantes.

Figura: Arquitetura Lógica do RAID 50: O desempenho do Stripe (RAID 0) em cima da paridade distribuída (RAID 5).

Figura: Arquitetura Lógica do RAID 50: O desempenho do Stripe (RAID 0) em cima da paridade distribuída (RAID 5).

Ao fazer isso, alteramos fundamentalmente a física do sistema. Se você grava um arquivo grande, ele é fatiado e enviado para todos os spans simultaneamente. A paridade é calculada e gravada isoladamente dentro de cada span.

Cálculo de IOPS e a Penalidade de Escrita no RAID 50/60

A métrica que separa o amador do engenheiro é o entendimento da Write Penalty (Penalidade de Escrita).

Em um RAID 5 puro, cada operação de escrita aleatória (random write) gera 4 operações de I/O no disco (Read Data, Read Parity, Write New Data, Write New Parity). Em RAID 6, são 6 operações. Isso destrói a performance de bancos de dados.

O RAID 50 melhora isso através do paralelismo dos spans.

A Matemática do Desempenho

Considere um array de 12 discos.

Cenário A (RAID 5 Monolítico): 11 discos de dados + 1 paridade.

Cenário B (RAID 50 - 3 Spans de 4 discos): 9 discos de dados efetivos + 3 paridade.

Embora o Cenário A tenha mais capacidade, o Cenário B vence em IOPS de escrita. Por quê? Porque temos 3 "motores" de paridade trabalhando em paralelo. O throughput de escrita escala com o número de spans.

Performance Teórica de Escrita (Write IOPS):

IOPS_RAID50 = (Total_Discos / Discos_por_Span) * (IOPS_Disco / Penalidade_RAID5)

Se tivermos 12 discos SAS 15k (aprox. 180 IOPS nativos) configurados em 3 spans de 4 discos:

Cada span processa suas escritas independentemente.

A penalidade de 4x (Read-Modify-Write) é diluída entre os spans.

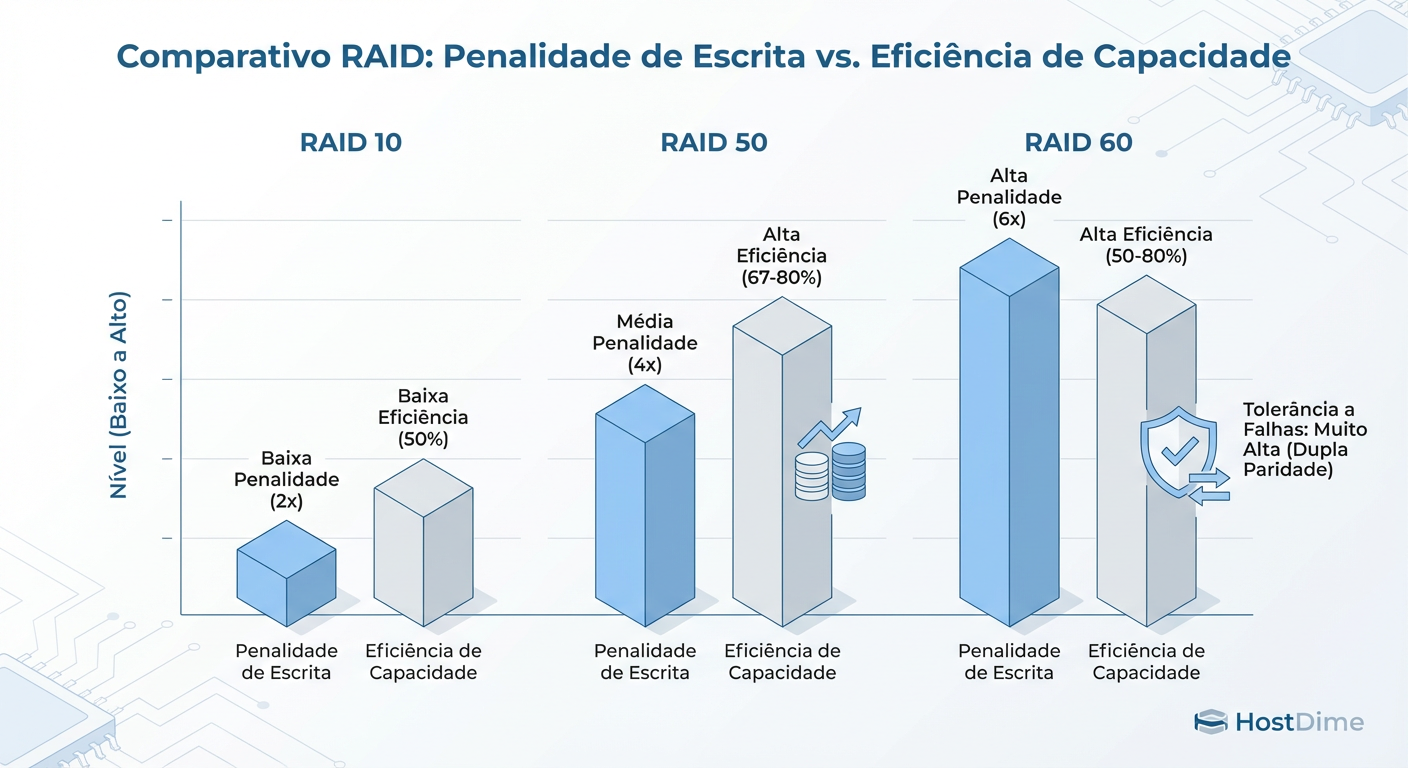

Isso coloca o RAID 50 e 60 num ponto ideal de custo-benefício, como ilustrado abaixo:

Figura: Comparativo de Trade-offs: O RAID 50/60 ocupa o meio-termo crítico entre a velocidade do RAID 10 e a economia de espaço do RAID 5/6 simples.

Figura: Comparativo de Trade-offs: O RAID 50/60 ocupa o meio-termo crítico entre a velocidade do RAID 10 e a economia de espaço do RAID 5/6 simples.

A Matemática do Risco no RAID 50/60 e Domínios de Falha

Aqui reside a maior confusão conceitual. "RAID 50 é mais seguro que RAID 5?". A resposta científica é: Depende de onde a falha ocorre.

Vamos analisar os Domínios de Falha:

RAID 60 (2 Spans de 8 discos): Você pode perder até 2 discos em cada span sem perder dados. Teoricamente, você poderia perder 4 discos (2 no Span A, 2 no Span B) e o array sobreviveria.

O Risco do RAID 50: Se você perder 2 discos no mesmo span, todo o RAID 50 falha. O RAID 0 no topo não tem tolerância a falhas; se uma "perna" quebra, o corpo cai.

No entanto, o Tempo de Rebuild é o fator de segurança real. Ao usar RAID 50, se um disco falha, apenas o span afetado precisa ser reconstruído. Em vez de ler os outros 23 discos do exemplo anterior, a controladora lê apenas os discos daquele span específico (ex: 7 discos). Isso reduz o tempo de vulnerabilidade (Window of Exposure) drasticamente, diminuindo a probabilidade estatística de uma segunda falha ocorrer durante a reconstrução.

RAID 50 vs RAID 10: Comparativo de Custo por TB e Performance

A decisão entre RAID 10 (Espelhamento + Striping) e RAID 50 é a batalha clássica entre "Performance Pura" e "Eficiência de Capacidade".

| Característica | RAID 10 | RAID 50 | RAID 60 |

|---|---|---|---|

| Eficiência de Espaço | 50% (Péssimo) | 67% - 94% (Depende do tamanho do span) | 50% - 88% |

| Penalidade de Escrita | 2x (Baixa) | 4x (Média) | 6x (Alta) |

| Velocidade de Rebuild | Altíssima (Cópia simples) | Média (Cálculo de XOR no span) | Média/Lenta (Cálculo P+Q) |

| Tolerância a Falhas | 1 disco por espelho | 1 disco por span | 2 discos por span |

| Custo por TB Útil | Alto | Baixo/Médio | Médio |

| Caso de Uso Ideal | DBs Transacionais (OLTP), VM Boot | File Servers, Media Streaming, Backup | Arquivamento, Backup Crítico |

Callout de Risco: Jamais utilize RAID 50 para cargas de trabalho de escrita aleatória intensa (como SQL Server logs ou ZIL/SLOG). A penalidade de paridade, mesmo mitigada pelos spans, induzirá latência inaceitável comparada ao RAID 10.

Abordagem Moderna: ZFS Striped VDEVs vs RAID de Hardware

No ecossistema moderno (Linux/BSD), o RAID de hardware está morrendo. O ZFS implementa o conceito de RAID 50/60 de forma nativa através de Striped VDEVs.

No ZFS, você não cria um "RAID 50" explicitamente. Você cria um Pool (que é equivalente ao RAID 0) e adiciona múltiplos VDEVs RAIDZ (que são equivalentes ao RAID 5).

Exemplo Prático de Topologia ZFS

Para criar o equivalente lógico a um RAID 60 com 12 discos (2 grupos de 6 discos em RAIDZ2):

# NÃO FAÇA ISSO (Um vdev gigante de 12 discos - Performance ruim e rebuild lento)

zpool create tank raidz2 /dev/sda /dev/sdb ... /dev/sdl

# FAÇA ISSO (Equivalente ao RAID 60 - Melhor IOPS e segurança)

zpool create tank \

raidz2 /dev/sda /dev/sdb /dev/sdc /dev/sdd /dev/sde /dev/sdf \

raidz2 /dev/sdg /dev/sdh /dev/sdi /dev/sdj /dev/sdk /dev/sdl

Nesta configuração, o ZFS distribui as escritas entre os dois VDEVs raidz2. Se um VDEV falhar (perda de 3 discos no mesmo grupo), o pool inteiro é perdido, mantendo a mesma lógica de risco do RAID de hardware, mas com as vantagens de checksumming e self-healing do ZFS.

Veredito Operacional: Quando utilizar RAID 50 ou 60 em Produção

Como engenheiro, sua decisão deve ser baseada em IOPS/GB e MTTDL (Mean Time To Data Loss).

Use RAID 50 quando:

Você precisa de mais de 6-8 discos de capacidade em um único volume.

A carga de leitura é predominante (70% Read / 30% Write).

Você precisa de throughput sequencial alto (ex: streaming de vídeo, repositórios de Veeam).

O orçamento não permite a perda de 50% de capacidade do RAID 10.

Use RAID 60 quando:

Os discos são muito grandes (>10TB), tornando o tempo de rebuild perigosamente longo.

O armazenamento é para "Cold Data" ou arquivamento onde a integridade é mais importante que a velocidade de escrita.

Você está usando drives SATA de alta capacidade (que possuem taxas de erro URE piores que SAS).

Evite ambos se:

Sua aplicação é sensível à latência de milissegundos (Use All-Flash RAID 10 ou RAID 5/6 em NVMe onde a velocidade do meio compensa a penalidade matemática).

Você não tem um backup testado. RAID não é backup; RAID 50/60 apenas mantém o sistema ligado enquanto você reza para o rebuild terminar.

Referências & Leitura Complementar

Patterson, D., et al. (1988). "A Case for Redundant Arrays of Inexpensive Disks (RAID)". University of California, Berkeley.

SNIA (Storage Networking Industry Association). "DDF - Disk Data Format Standard". Explica a estrutura de metadados em arrays RAID.

BAARF (Battle Against Any Raid Five). Artigos históricos sobre os riscos matemáticos de paridade única em discos modernos.

Oracle/OpenZFS Documentation. "ZFS Pool Concepts and VDEV Topology".

Thomas 'Raid0' Wright

High-Performance Computing Researcher

Trabalha com supercomputadores. Para ele, velocidade é tudo, e redundância é problema do software.