RAID Controllers NVMe Nativo em 2025: Análise Técnica (Broadcom vs Microchip)

Hardware RAID para NVMe ainda faz sentido em 2025? Analisamos os controladores Tri-Mode da Broadcom e Microchip, latência, IOPS e quando abandonar o Software RAID.

Há uma década, decretamos a morte das controladoras RAID. Com a ascensão do ZFS, Ceph e Storage Spaces Direct, a ideia de esconder a geometria física dos discos atrás de uma camada de abstração proprietária parecia obsoleta. No entanto, em 2025, o mercado de controladoras RAID não apenas sobreviveu, como evoluiu para lidar com o protocolo que deveria tê-las matado: o NVMe.

Como arquitetos, precisamos ser honestos: o Software RAID venceu a guerra da escalabilidade horizontal e da integridade de dados (bit rot protection). Mas o Hardware RAID ainda detém trincheiras específicas onde a simplicidade operacional e o suporte de legacy OS (como VMware ESXi standalone e Windows Server bare-metal) são inegociáveis. A questão não é mais "qual é melhor", mas sim "qual trade-off você está disposto a aceitar no seu budget de latência".

O que é uma Controladora RAID NVMe Tri-Mode? É um dispositivo de interface de armazenamento (HBA ou RAID) capaz de operar simultaneamente protocolos SAS, SATA e NVMe através da mesma interface física SerDes e conector (geralmente U.2/U.3), abstraindo a complexidade de gerenciamento do barramento PCIe da CPU principal. Em 2025, seu principal objetivo é permitir redundância de boot e gestão de hot-swap em servidores densos sem consumir ciclos de CPU do host para cálculos de paridade.

O Paradoxo do RAID NVMe: Hardware vs. Barramento Gen5

A premissa fundamental do NVMe (Non-Volatile Memory Express) foi remover o intermediário. O protocolo foi desenhado para conectar a memória flash diretamente às lanes PCIe da CPU, eliminando a pilha SCSI/SAS que criava latência.

Ao introduzir uma controladora RAID de Hardware (RoC - RAID on Chip) em 2025, estamos, por definição, reintroduzindo um intermediário. Isso cria um paradoxo arquitetural: compramos drives NVMe Gen5 capazes de 14 GB/s e latências de microssegundos, e então colocamos um "pedágio" na frente deles.

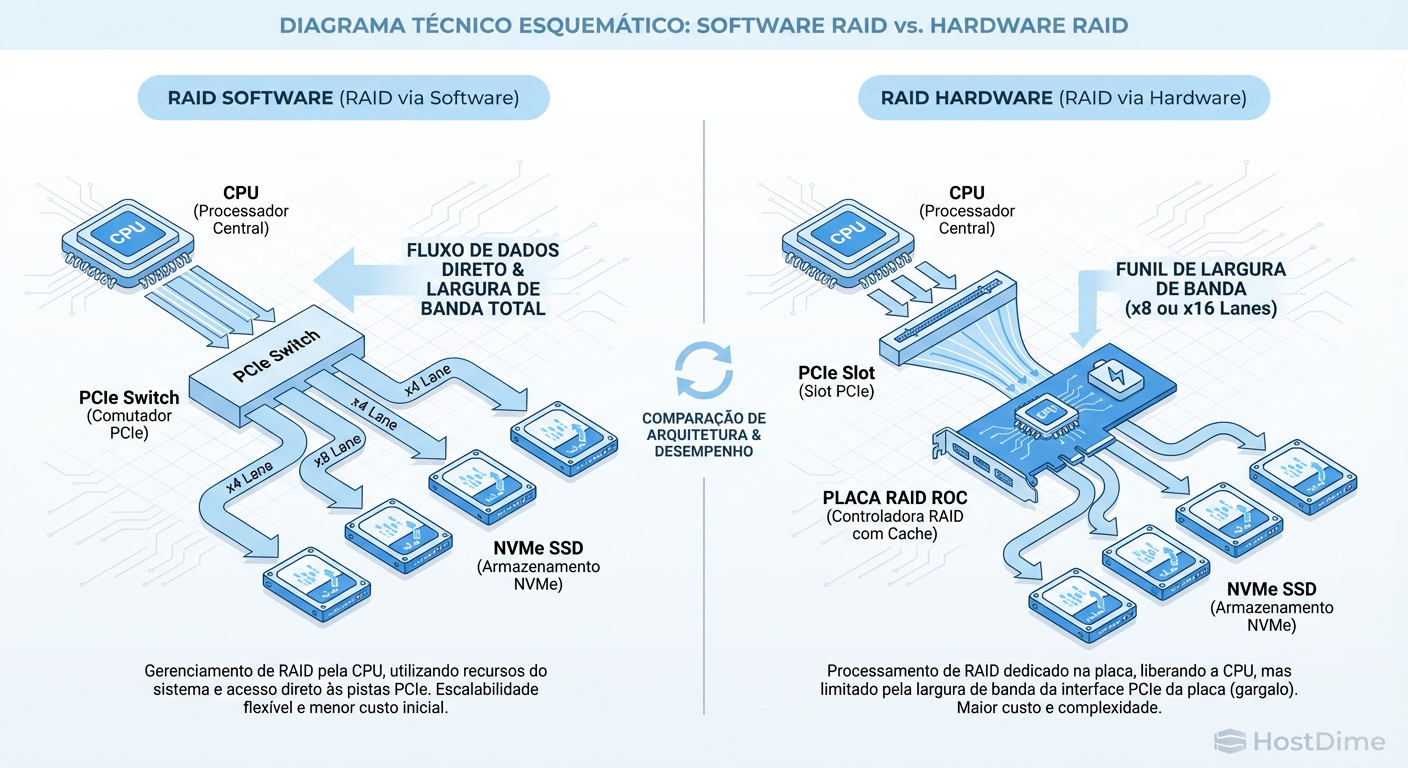

Figura: O Gargalo do Barramento: Comparação de fluxo de dados entre Software RAID direto e Hardware RAID Tri-Mode.

Figura: O Gargalo do Barramento: Comparação de fluxo de dados entre Software RAID direto e Hardware RAID Tri-Mode.

A imagem acima ilustra o problema físico. No cenário de Software RAID, o caminho é limpo: CPU -> PCIe Switch -> Drive. No cenário de Hardware RAID, o sinal precisa ser processado pelo silício da Broadcom ou Microchip, armazenado em cache (DRAM da controladora), calculado (XOR para RAID 5/6) e então despachado.

O barramento PCIe Gen5 (32 GT/s por lane) tenta mitigar isso oferecendo uma largura de banda tão massiva que o throughput raramente é o gargalo. O problema real, que muitos datasheets escondem, é a latência na operação de I/O pequena (4K random write).

Arquitetura Tri-Mode Explicada: O Silício Híbrido

A grande inovação que mantém a Broadcom e a Microchip relevantes é a arquitetura Tri-Mode. Antigamente, você precisava de controladoras separadas para SAS e para NVMe (ou usava retimers PCIe burros).

Hoje, o silício utiliza blocos SerDes (Serializer/Deserializer) agnósticos. A controladora negocia o protocolo no momento do handshake:

SATA: Tunela o comando AHCI.

SAS: Tunela o comando SCSI.

NVMe: Tunela o comando NVMe encapsulado ou, em modos mais modernos, faz a tradução direta.

Para o arquiteto de soluções, isso simplifica o Bill of Materials (BOM). Um único backplane com conectores U.3 pode aceitar HDDs rotacionais de 22TB para cold storage ou SSDs NVMe para caching, todos geridos pela mesma controladora 9600 ou Ultra 3200.

Tabela Comparativa: Broadcom vs. Microchip em 2025

Abaixo, comparamos as duas famílias dominantes no mercado Enterprise atual para implementações x86.

| Característica | Broadcom (LSI) MegaRAID 9600/9700 Series | Microchip Adaptec SmartRAID Ultra 3200 | Software RAID (ZFS/mdraid) |

|---|---|---|---|

| Arquitetura | RoC com núcleos ARM de alta frequência. Foco em IOPS bruto. | FPGA/ASIC híbrido. Foco em flexibilidade e caching (maxCrypto). | CPU do Host (Xeon/EPYC). |

| Interface Host | PCIe Gen5 x16 (nos modelos topo de linha). | PCIe Gen4 x16 / Gen5 x8. | Direto ao PCIe Root Complex. |

| Cache Protection | CacheVault (Supercap + Flash). Padrão da indústria. | ASCM (Active SCM) ou Zero-Maintenance Cache Protection. | RAM do sistema (volátil sem NVDIMM/PLP). |

| Gestão NVMe | Excelente suporte a U.3. Drivers maduros no ESXi. | Forte em criptografia em repouso (Controller Based Encryption). | Nativa do Kernel. Sem overhead de driver proprietário. |

| Custo (TCO) | Alto (Hardware + Licenças de features avançadas). | Médio/Alto. | Zero (Custo de CPU é negligenciável hoje). |

| Latência (QD1) | Adiciona ~5-10µs (microssegundos). | Adiciona ~5-12µs. | Adiciona ~1-3µs (overhead de software). |

Análise de Latência: O Custo da Abstração

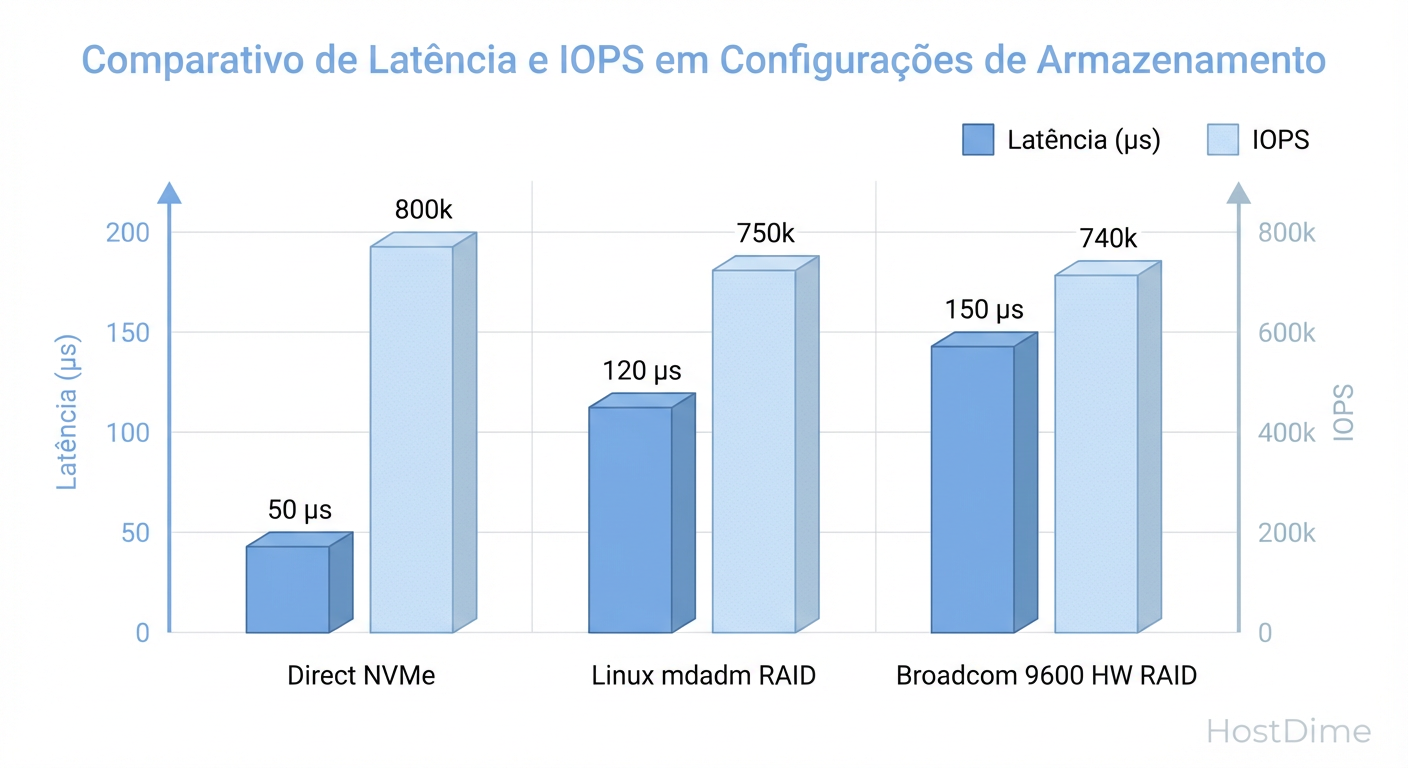

Aqui é onde separamos o marketing da engenharia. Se um vendedor lhe disser que a controladora RAID "acelera" o NVMe, ele está mentindo ou falando de um cenário muito específico (RAID 5/6 com write-back cache habilitado em cargas sequenciais).

Em leituras aleatórias (Random Read 4K), nenhuma controladora de hardware é mais rápida que o caminho direto.

Figura: Custo da Abstração: Impacto na latência e IOPS ao introduzir uma controladora hardware em 2025.

Figura: Custo da Abstração: Impacto na latência e IOPS ao introduzir uma controladora hardware em 2025.

Como medir a "Taxa de Latência"

Não confie no IOPS máximo do datasheet. O teste real para decidir se você precisa de Hardware RAID ou Passthrough (HBA) é medir a latência em Queue Depth 1 (QD1).

Se você estiver em um ambiente Linux com acesso aos discos (mesmo que em JBOD atrás da controladora), use o fio para verificar o overhead:

# Teste de Latência de Leitura Aleatória (QD1)

# Execute isso em um disco NVMe direto (ex: /dev/nvme0n1)

# E depois em um volume virtual da controladora (ex: /dev/sda)

fio --name=latency_test \

--ioengine=libaio \

--rw=randread \

--bs=4k \

--direct=1 \

--numjobs=1 \

--iodepth=1 \

--runtime=60 \

--filename=/dev/device_path

O que esperar:

NVMe Nativo: ~80-100 µs (dependendo do drive).

Atrás da Controladora (RAID 1/10): ~120-150 µs.

Esse delta de 50 µs parece pouco, mas em bancos de dados transacionais de alta frequência, ele se acumula.

Cenários de Uso Obrigatório para Hardware RAID

Se o Software RAID é superior em integridade e performance pura, por que a Dell, HPE e Lenovo ainda vendem milhões de controladoras Broadcom 9600?

1. VMware ESXi (Non-vSAN)

O VMware ESXi é notoriamente ruim em lidar com Software RAID para datastores locais. Se você tem um servidor standalone (Branch Office, Edge) e precisa de redundância local para suas VMs, você não pode usar ZFS ou mdraid. Você precisa que o hardware apresente um único volume lógico protegido ao hypervisor. Aqui, a controladora Broadcom é rainha.

2. Boot Redundante (OS Mirror)

Configurar RAID 1 via software no bootloader (GRUB/EFI) é possível, mas propenso a falhas humanas durante a substituição de discos. Controladoras dedicadas de boot (como a BOSS card da Dell, baseada em chips Marvell ou Broadcom de baixo custo) garantem que, se um M.2 falhar, o servidor continua bootando sem intervenção manual no BIOS.

3. Windows Server Bare-Metal

Embora o "Storage Spaces" exista, a cultura de administração Windows ainda favorece fortemente o Hardware RAID. A capacidade de trocar um disco em falha e ver a luzinha piscar (LED management via SGPIO) sem abrir o PowerShell é um valor operacional tangível para equipes de suporte de campo nível 1.

Veredito de Arquitetura: HBA vs. RAID Hardware

A decisão final em 2025 não é sobre velocidade, é sobre onde reside a inteligência do armazenamento.

Escolha Modo HBA / Passthrough (Broadcom 9600-16i ou similar em IT Mode) se:

Você usa SDS (Software Defined Storage): ZFS (TrueNAS), Ceph, MinIO ou VMware vSAN.

Você precisa de proteção contra Bit Rot (checksumming de dados e metadados).

Seu foco é latência mínima absoluta.

Você quer evitar Vendor Lock-in no formato dos dados (discos de uma controladora PERC não são legíveis nativamente em uma SmartRAID).

Escolha Hardware RAID (Modo IR / RoC) se:

O sistema operacional não gerencia redundância nativamente de forma robusta (ESXi Standalone, Windows legado).

Você precisa de Write Cache protegido por bateria para absorver picos de escrita em bancos de dados legados que não foram otimizados para flash.

Sua equipe de operações exige o modelo mental de "Trocar disco -> Rebuild automático" sem interação via CLI.

Resumo do Arquiteto: Em 2025, para NVMe, o Hardware RAID é uma ferramenta de conveniência operacional, não de performance. Use-o para resolver problemas de compatibilidade de OS e boot, mas evite-o se estiver construindo clusters de armazenamento modernos e escaláveis.

Referências & Leitura Complementar

Broadcom Tech Docs: MegaRAID 9600 Series Tri-Mode Storage Adapters User Guide (12Gb/s SAS/SATA/PCIe Gen 4.0 NVMe).

Microchip Whitepapers: Adaptec SmartRAID Ultra 3200 Series: Maximizing NVMe Performance with Hardware RAID.

SNIA Standards: Universal Backplane Management (UBM) Specification v1.0.

NVMe Spec: NVM Express Base Specification Revision 2.0 (NVMe over PCIe).

Julia M. Santos

Enterprise Storage Consultant

Consultora para Fortune 500. Traduz 'economês' para 'técniquês' e ajuda empresas a não gastarem milhões em SANs desnecessárias.