RAID Hardware vs. Software na Era NVMe: A Morte da Controladora Dedicada em 2026?

Descubra por que controladoras RAID Hardware tornaram-se o maior gargalo para SSDs NVMe. Análise técnica de latência, PCIe lanes e por que o Software RAID (ZFS/mdadm) vence em 2026.

Se você trabalha com infraestrutura há mais de uma década, a imagem de uma placa controladora RAID (seja uma PERC da Dell, uma Smart Array da HPE ou uma MegaRAID da Broadcom) é quase reconfortante. Ela era o "adulto na sala", responsável por garantir que, quando um disco mecânico falhasse, o servidor não parasse. Havia uma bateria física, um cache de memória dedicado e um processador proprietário para fazer cálculos de paridade (XOR).

Mas estamos caminhando para 2026. O disco mecânico giratório foi relegado ao arquivamento frio, e o protocolo NVMe tomou conta do data center. Nesse novo cenário, aquela placa controladora confiável deixou de ser o adulto na sala e se tornou o porteiro idoso tentando controlar uma multidão em um show de rock.

Vamos desconstruir o porquê da arquitetura de armazenamento estar mudando radicalmente e por que insistir em RAID via Hardware para SSDs NVMe modernos é, na maioria dos casos, um erro de cálculo arquitetural e financeiro.

O RAID via Software na era NVMe supera o RAID via Hardware porque elimina o gargalo físico do barramento PCIe da controladora dedicada. Enquanto o RAID Hardware afunila todo o tráfego de múltiplos SSDs de alta velocidade (Gen4/Gen5) em um único slot x8 ou x16, o RAID Software (ZFS, MDRAID, vSAN) permite que a CPU acesse cada drive diretamente através de suas próprias lanes PCIe, garantindo paralelismo real, menor latência e integridade de dados ponta a ponta.

A Inversão do Gargalo: Quando o disco superou a controladora

O modelo mental tradicional de armazenamento assumia uma verdade absoluta: a CPU é rápida e o disco é lento. Portanto, colocávamos um computador dedicado (a placa RAID) na frente dos discos para gerenciar a fila e não incomodar a CPU principal.

Com a chegada do NVMe, essa verdade foi invertida. Um único SSD NVMe Enterprise moderno consegue saturar barramentos que, antigamente, serviam a um array inteiro de 24 HDDs SAS.

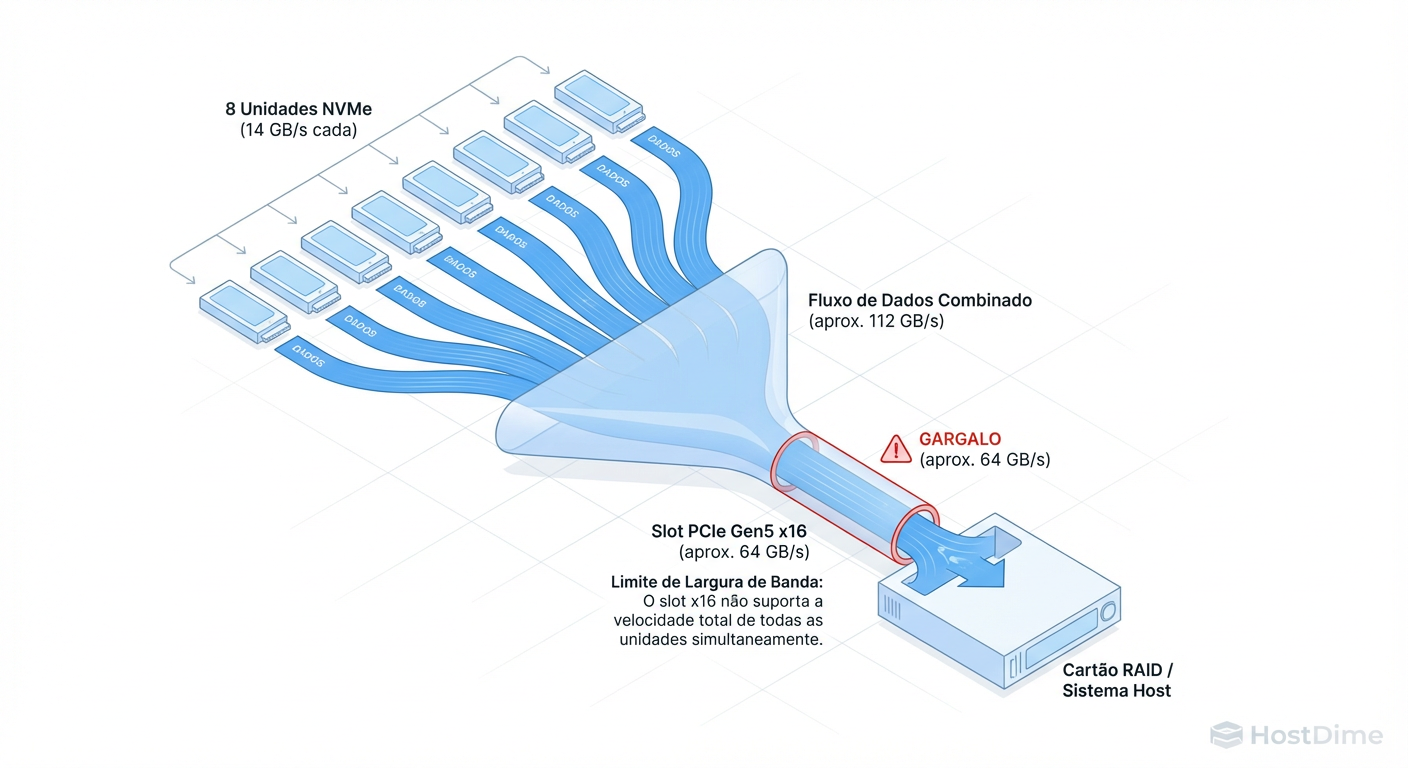

Figura: O Gargalo Físico: 8 drives NVMe Gen5 excedem drasticamente a largura de banda de qualquer controladora RAID comercial.

Figura: O Gargalo Físico: 8 drives NVMe Gen5 excedem drasticamente a largura de banda de qualquer controladora RAID comercial.

Ao inserir uma controladora RAID física entre a CPU e seus SSDs NVMe, você está introduzindo um "homem no meio" (Man-in-the-Middle) desnecessário. O problema não é apenas a largura de banda (throughput), mas a latência. O protocolo NVMe foi desenhado para ser massivamente paralelo e direto. O RAID Hardware, por design, serializa e centraliza operações que deveriam ser paralelas.

Matemática de Lanes PCIe no Cenário NVMe

Vamos ser brutais com a matemática. Não há opinião aqui, apenas física de barramento.

Suponha que você esteja desenhando um servidor de banco de dados para 2025/2026 com as seguintes especificações:

Drives: 8x SSDs NVMe PCIe Gen5.

Performance por Drive: ~14 GB/s de leitura sequencial (teórico).

Total Potencial: ~112 GB/s de throughput bruto.

Se você conectar esses drives a uma controladora RAID "Top de Linha" atual, ela provavelmente será conectada ao slot PCIe do servidor via x16 lanes (Gen5).

Um slot PCIe Gen5 x16 tem um teto teórico de ~63 GB/s (unidirecional).

O Cálculo do Desperdício

Ao usar a controladora:

Seus drives podem entregar 112 GB/s.

Sua controladora só consegue passar 63 GB/s para a CPU.

Resultado: Você jogou fora quase 45% da performance pela qual pagou caro nos SSDs.

Em uma configuração de Software RAID (ou HBA Passthrough/Tri-mode), cada drive NVMe se conecta a 4 lanes PCIe dedicadas diretamente à CPU (ou via switches PCIe transparentes). A CPU vê a largura de banda total agregada. O gargalo deixa de ser o slot da controladora e passa a ser a capacidade da CPU de processar interrupções — um problema muito mais fácil de gerenciar.

A Ilusão do Offload de CPU e o Custo do XOR

O argumento de venda clássico dos fabricantes de controladoras é: "Não gaste sua preciosa CPU Intel Xeon/AMD EPYC calculando paridade RAID 5 ou 6. Deixe nosso chip fazer isso."

Isso era verdade em 2010. Hoje, é uma falácia de custo de oportunidade.

As CPUs modernas possuem conjuntos de instruções (como AVX-512) que trituram cálculos de XOR (usados na paridade RAID) com um custo computacional irrisório. O verdadeiro custo em Storage de alta performance não é o cálculo matemático, é a troca de contexto e a latência de interrupção.

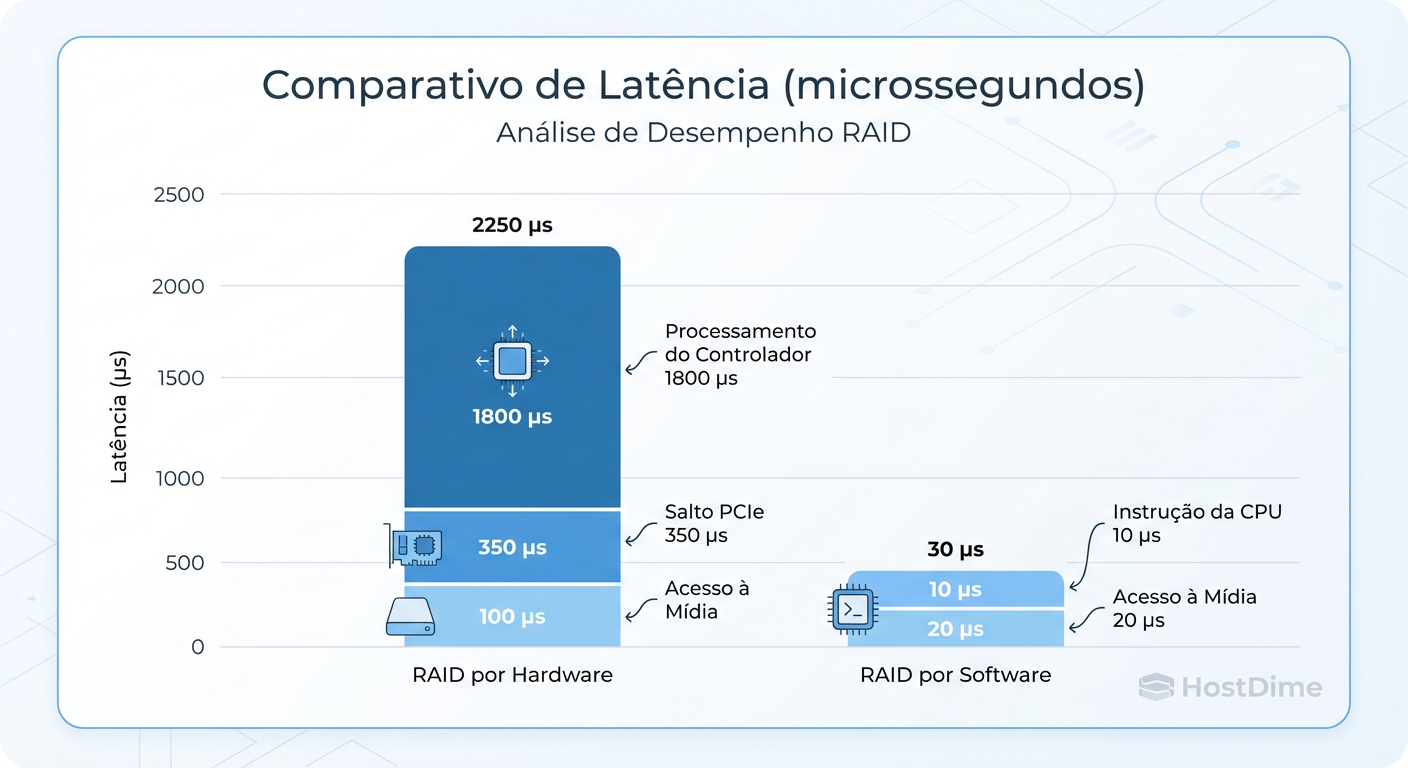

Figura: Latência em µs: O caminho longo da controladora vs. o caminho direto do Software RAID.

Figura: Latência em µs: O caminho longo da controladora vs. o caminho direto do Software RAID.

Quando você usa RAID via Hardware, o ciclo é:

O SO envia o comando SCSI/NVMe para o driver da controladora.

A controladora processa, coloca em cache, calcula paridade.

A controladora grava no disco.

A controladora envia uma interrupção de volta confirmando.

Esse caminho adiciona microssegundos preciosos. Em um HDD de 10ms, adicionar 50µs (microssegundos) é irrelevante. Em um SSD NVMe de 80µs, adicionar 50µs é um aumento de latência de mais de 60%.

Exemplo Prático: Verificando a topologia

Em um sistema Linux, você pode verificar se seus dispositivos NVMe estão "atrás" de uma controladora ou direto na CPU. Se você vir seus discos como dispositivos genéricos SCSI (/dev/sda) em vez de namespaces NVMe (/dev/nvme0n1), você está perdendo performance.

# Os dispositivos NVMe aparecem diretamente no barramento PCIe

lspci -vvv | grep Non-Volatile

# Se o resultado for apenas uma linha "MegaRAID" ou "Smart Array",

# você está operando no modo legado e ocultando a performance real.

Segurança de Dados: Cache com Bateria (BBWC) vs. PLP

"Mas e se a energia cair? O cache da controladora tem bateria!"

Este é o último bastião do medo que mantém o RAID Hardware vivo. Historicamente, a controladora usava RAM para absorver escritas aleatórias e organizá-las (coalescing) antes de gravar nos discos lentos. Se a luz acabasse, a bateria segurava os dados na RAM.

No mundo NVMe Enterprise, essa função foi descentralizada. SSDs de classe Enterprise (não os de consumo que você compra para seu PC gamer) possuem PLP (Power Loss Protection). Eles têm seus próprios capacitores de tântalo integrados no PCB do drive.

Tabela Comparativa: Proteção de Dados em Falha de Energia

| Característica | RAID Hardware (BBWC) | SSD Enterprise com PLP (Software RAID) |

|---|---|---|

| Local do Cache | Memória RAM na placa controladora | DRAM interna dentro de cada SSD |

| Proteção de Energia | Bateria de Íon-Lítio (dura ~48h-72h) | Capacitores no SSD (esvaziam o cache para NAND em ms) |

| Ponto Único de Falha | Sim. Se a controladora morrer, o cache fica preso nela. | Não. Cada drive protege seus próprios dados em voo. |

| Custo de Manutenção | Troca periódica de bateria/supercap. | Zero. Integrado ao MTBF do drive. |

| Eficiência de Escrita | Limitada pela RAM da controladora (ex: 4GB/8GB). | Escala com o número de drives (cada drive traz seu cache). |

Em 2026, confiar em uma única bateria proprietária em uma placa PCIe é menos seguro do que confiar em capacitores de grau industrial distribuídos em 12 ou 24 drives independentes.

O Fator ZFS e Filesystems Modernos

O problema mais grave do RAID Hardware, sob a ótica de um arquiteto de dados, é que ele cega o Sistema Operacional.

O RAID Hardware apresenta ao SO um volume lógico "perfeito". Se um bit for corrompido silenciosamente no disco (bit rot) e a controladora não detectar, ela entregará lixo ao SO como se fosse dado válido.

Sistemas de arquivos modernos como ZFS (e Btrfs ou ReFS com Integrity Streams) operam sob o princípio de "End-to-End Data Integrity". Eles precisam de acesso direto físico ao disco para:

Checksumming: Verificar cada bloco lido contra um hash criptográfico.

Self-Healing: Se o ZFS detecta um bloco corrompido no espelho A, ele lê do espelho B e corrige o A automaticamente.

Se houver uma controladora RAID no meio fazendo abstração, o ZFS não consegue saber qual disco físico falhou ou corrigir setores individuais com precisão cirúrgica. Você transforma um sistema de arquivos inteligente em um sistema "burro" que confia cegamente no hardware.

Callout de Risco: Jamais configure ZFS em cima de um volume lógico de RAID Hardware (ex: RAID 5 na controladora e zpool single disk em cima). Você perde a autocorreção e cria um pesadelo de performance devido ao conflito de caches (Double Caching).

Veredito 2026: Onde o Hardware RAID ainda sobrevive?

Diante das evidências de TCO (Custo Total de Propriedade), performance e integridade de dados, a controladora dedicada está morta? Quase.

Como arquiteto, "depende" é a resposta, mas o escopo do "depende" diminuiu drasticamente.

Onde usar Software RAID (ZFS, vSAN, MDRAID, Storage Spaces Direct):

Virtualização e HCI: VMware vSAN, Nutanix, Proxmox (ZFS/Ceph).

Banco de Dados de Alta Performance: Onde latência de NVMe é crítica.

Object Storage: MinIO, Ceph.

Servidores de Arquivos Modernos: TrueNAS, Linux fileservers.

Os Cenários de Borda para Hardware RAID (Legacy & Boot):

Boot Drives (OS Mirror): Para espelhar dois SSDs M.2 baratos onde fica o sistema operacional (ex: ESXi boot), uma controladora simples (BOSS card da Dell, por exemplo) é excelente. Ela abstrai a complexidade do boot e deixa o SO ver apenas um disco.

Sistemas Operacionais Legados: Se você é obrigado a rodar um Windows Server antigo bare metal que não suporta Storage Spaces bem, ou sistemas proprietários que exigem driver de controladora para suporte.

Conformidade Rígida/burocrática: Alguns contratos de suporte legados exigem "RAID Hardware" explicitamente por falta de atualização dos termos técnicos.

Conclusão: Para qualquer carga de trabalho nova desenhada para a era NVMe, a controladora RAID dedicada se tornou um gargalo caro. Em 2026, a inteligência do armazenamento pertence ao Software, e a velocidade pertence ao barramento PCIe direto. Planeje sua arquitetura removendo intermediários, não adicionando-os.

Referências & Leitura Complementar

NVM Express Base Specification 2.0: Detalhes sobre o paralelismo de filas e latência do protocolo NVMe vs SCSI.

OpenZFS Documentation: "Hardware RAID controllers" section - Explicação detalhada sobre por que o ZFS requer acesso direto ao disco (JBOD/HBA).

Intel® Virtual RAID on CPU (Intel® VROC): Whitepapers técnicos demonstrando a eficiência do manuseio de RAID NVMe diretamente nas lanes PCIe da CPU.

SNIA (Storage Networking Industry Association): "The decline of Hardware RAID in the age of Flash" - Artigos e apresentações sobre tendências de arquitetura de armazenamento.

Marta G. Oliveira

DevOps Engineer & Storage Nerd

Automatiza provisionamento de storage com Terraform e Ansible. Defensora do 'Infrastructure as Code' para storage.