Read-ahead e Write Buffering: Quando Ajudam e Quando Atrapalham

A performance de I/O é frequentemente o gargalo em sistemas de computação. Discos mecânicos (HDDs) são inerentemente lentos em comparação com a memória RAM e a ...

Read-ahead e Write Buffering: Quando Ajudam e Quando Atrapalham

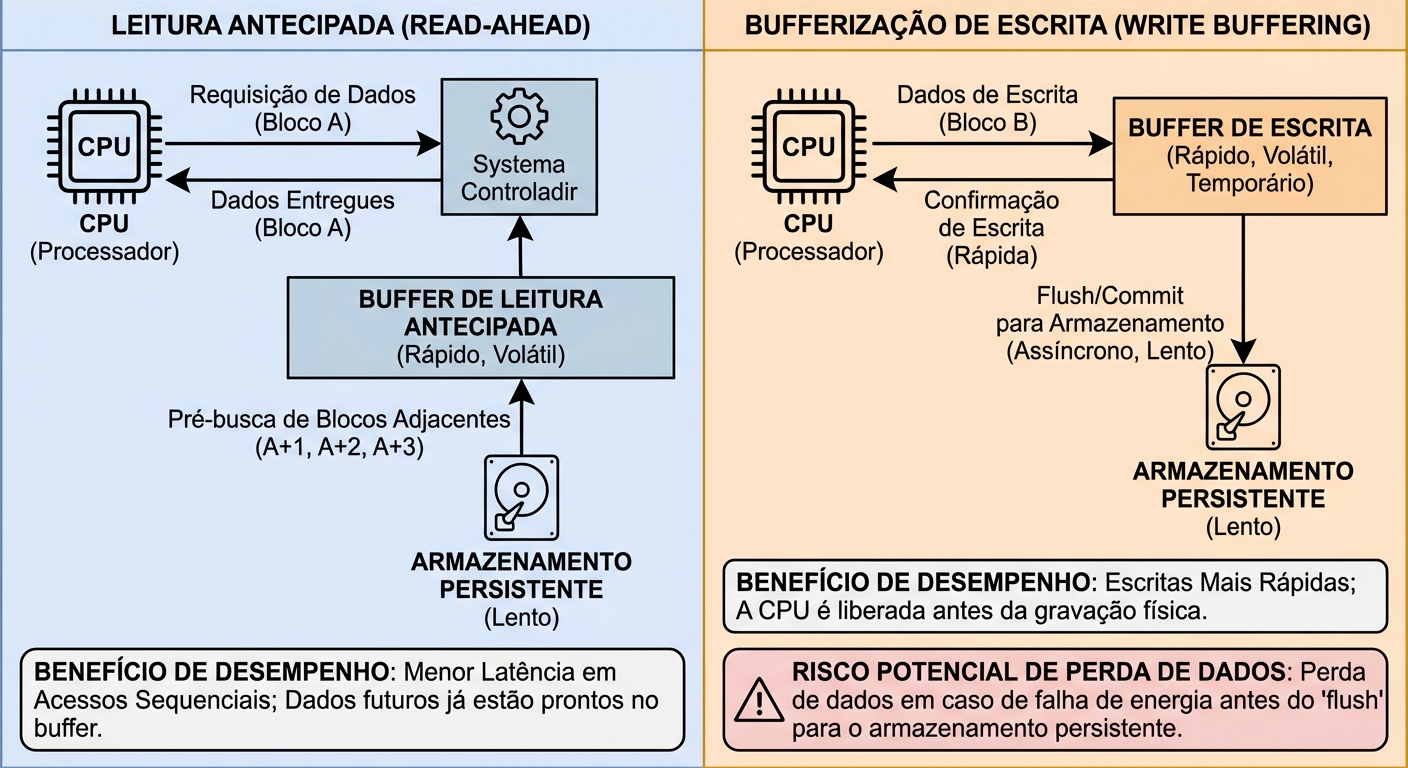

A performance de I/O é frequentemente o gargalo em sistemas de computação. Discos mecânicos (HDDs) são inerentemente lentos em comparação com a memória RAM e a CPU. Mesmo SSDs, apesar de muito mais rápidos, ainda têm latências significativamente maiores que a memória. Para mitigar essa diferença de velocidade, técnicas de caching como read-ahead (leitura antecipada) e write buffering (buffer de escrita) são amplamente utilizadas. Este artigo explora esses mecanismos em profundidade, seus benefícios, riscos e como otimizá-los para diferentes cargas de trabalho.

O Problema da Performance de I/O

Imagine o seguinte cenário: um servidor web recebendo múltiplas requisições simultâneas para arquivos armazenados em disco. Cada requisição de leitura (read) do disco leva um tempo considerável para ser completada. Sem otimizações, o servidor ficaria esperando por cada leitura, resultando em alta latência e baixa taxa de transferência. Similarmente, operações de escrita (write) diretamente no disco podem ser lentas, especialmente em HDDs, onde a cabeça de leitura/escrita precisa se mover fisicamente para a posição correta no disco.

É aí que entram as técnicas de caching. Caching, em sua essência, é armazenar dados em um local mais rápido (a cache) para que acessos futuros a esses dados sejam mais rápidos. Read-ahead e write buffering são formas específicas de caching projetadas para otimizar operações de leitura e escrita, respectivamente.

Read-ahead (Leitura Antecipada)

Read-ahead é uma técnica que tenta prever quais dados serão necessários no futuro e os carrega na cache antes que sejam explicitamente requisitados. A ideia central é que, se um processo está lendo um arquivo sequencialmente, é provável que ele continue lendo os blocos subsequentes.

Como Funciona:

Detecção de Acesso Sequencial: O sistema operacional (ou a controladora do disco) monitora os padrões de acesso a disco. Se ele detectar uma sequência de leituras consecutivas de blocos adjacentes, ele assume que um acesso sequencial está ocorrendo.

Leitura Preditiva: Com base nessa detecção, o sistema começa a ler blocos adicionais além do bloco requisitado, armazenando-os na cache. Por exemplo, se o processo requisitar o bloco 10, o sistema pode ler os blocos 11, 12 e 13 também.

Armazenamento em Cache: Os blocos lidos antecipadamente são armazenados em uma área de cache, geralmente na memória RAM.

Acesso Rápido: Se o processo requisitar um dos blocos que já foram lidos antecipadamente, o dado é servido diretamente da cache, sem a necessidade de acessar o disco.

Quando Ajuda:

- Leitura Sequencial: Read-ahead brilha em cargas de trabalho com leituras sequenciais, como streaming de vídeo, leitura de arquivos grandes e backups. Nesses casos, a predição é altamente precisa, e a maioria dos dados lidos antecipadamente é realmente utilizada.

Quando Atrapalha:

- Leitura Aleatória: Em cargas de trabalho com leituras aleatórias, como bancos de dados com muitos acessos não sequenciais, read-ahead pode ser prejudicial. A predição se torna inútil, e o sistema acaba lendo dados desnecessários, ocupando espaço na cache e consumindo largura de banda de I/O que poderia ser usada para leituras realmente necessárias. Isso pode levar a um fenômeno chamado "cache thrashing", onde a cache está constantemente sendo preenchida e esvaziada com dados inúteis.

- Overhead: Mesmo em leituras sequenciais, um read-ahead muito agressivo pode trazer overhead. Se o sistema lê muito à frente, pode acabar lendo dados que nunca serão usados antes que a cache precise ser reutilizada.

Write Buffering (Buffer de Escrita)

Write buffering é uma técnica que armazena temporariamente os dados a serem escritos em disco em uma área de cache (geralmente na RAM) antes de realmente gravá-los no disco. Isso permite que o processo de escrita retorne mais rapidamente, melhorando a performance geral do sistema.

Como Funciona:

Escrita na Cache: Quando um processo solicita a escrita de dados, os dados são primeiramente armazenados em um buffer na memória RAM.

Confirmação Imediata: O sistema notifica o processo que a escrita foi completada, mesmo que os dados ainda não tenham sido gravados no disco.

Escrita Assíncrona: Em um momento posterior, o sistema grava os dados do buffer para o disco. Essa escrita é feita de forma assíncrona, ou seja, em segundo plano, sem bloquear o processo principal.

Tipos de Write Buffering:

Existem duas estratégias principais de write buffering:

Write-through: Os dados são escritos tanto na cache quanto no disco simultaneamente. Isso garante que os dados estejam sempre consistentes no disco, mas a performance é limitada pela velocidade de escrita do disco.

Write-back: Os dados são escritos apenas na cache inicialmente. A escrita para o disco é adiada para um momento posterior. Isso oferece melhor performance, pois as escritas são muito mais rápidas (a velocidade da RAM), mas apresenta o risco de perda de dados em caso de falha do sistema antes que os dados sejam gravados no disco.

Riscos:

O principal risco do write buffering, especialmente com a estratégia write-back, é a perda de dados. Se o sistema falhar (por exemplo, uma queda de energia) antes que os dados no buffer sejam gravados no disco, esses dados serão perdidos.

Benefícios:

- Melhora da Performance: Write buffering pode melhorar significativamente a performance de escrita, especialmente em aplicações que realizam muitas escritas pequenas.

- Redução da Latência: Ao retornar imediatamente após a escrita na cache, write buffering reduz a latência percebida pelas aplicações.

- Agrupamento de Escritas: Write buffering permite que múltiplas escritas pequenas sejam agrupadas em uma única escrita maior, o que pode melhorar a eficiência do disco.

Implicações em Sistemas RAID

Controladoras RAID (Redundant Array of Independent Disks) frequentemente utilizam read-ahead e write buffering para melhorar a performance. Em particular, o write buffering é crucial para RAID 5 e RAID 6, onde a escrita de paridade envolve múltiplas operações de leitura e escrita.

Proteção de Cache:

Para mitigar o risco de perda de dados associado ao write buffering, controladoras RAID de alta performance geralmente utilizam uma BBU (Battery Backup Unit) ou um supercapacitor. Esses dispositivos fornecem energia para a controladora em caso de falha de energia, permitindo que os dados no buffer sejam gravados no disco antes que a controladora seja desligada.

Sem uma BBU ou supercapacitor, o write buffering em RAID pode ser extremamente perigoso, especialmente em ambientes de produção. A perda de dados pode levar a corrupção de dados, indisponibilidade do sistema e perda financeira.

Linux e Configuração

No Linux, read-ahead e write buffering podem ser configurados através de diversos parâmetros do kernel e utilitários.

Read-ahead:

O tamanho do read-ahead pode ser ajustado usando o comando blockdev --setra. Por exemplo, para definir o read-ahead para 256 setores (128KB) no dispositivo /dev/sda:

blockdev --setra 256 /dev/sda

Para verificar o valor atual do read-ahead:

blockdev --getra /dev/sda

Write Buffering:

O comportamento do write buffering é controlado por parâmetros do kernel como vm.dirty_ratio e vm.dirty_background_ratio. Esses parâmetros definem a porcentagem da memória RAM que pode ser usada para armazenar dados sujos (dados que foram modificados mas ainda não foram gravados no disco).

vm.dirty_ratio: A porcentagem máxima da memória RAM que pode conter dados sujos. Quando esse limite é atingido, o sistema começa a escrever os dados sujos no disco de forma mais agressiva.vm.dirty_background_ratio: A porcentagem da memória RAM que, quando atingida, faz com que o sistema comece a escrever os dados sujos no disco em segundo plano.

Esses parâmetros podem ser configurados no arquivo /etc/sysctl.conf ou através do comando sysctl. Por exemplo, para definir vm.dirty_ratio para 20% e vm.dirty_background_ratio para 10%:

sysctl -w vm.dirty_ratio=20

sysctl -w vm.dirty_background_ratio=10

Para tornar as alterações permanentes, adicione as seguintes linhas ao /etc/sysctl.conf:

vm.dirty_ratio = 20

vm.dirty_background_ratio = 10

Trade-offs e Monitoramento

A otimização de read-ahead e write buffering envolve um delicado balanço entre performance e durabilidade/consistência dos dados. Aumentar o read-ahead e o write buffering pode melhorar a performance, mas também aumenta o risco de perda de dados e pode levar a problemas de performance em cargas de trabalho específicas.

Monitoramento:

É fundamental monitorar o desempenho do sistema para identificar gargalos de I/O e ajustar os parâmetros de read-ahead e write buffering de acordo. Ferramentas como iostat, vmstat e iotop podem fornecer informações valiosas sobre a atividade de I/O do sistema.

iostat: Fornece estatísticas detalhadas sobre a utilização do disco, incluindo taxa de transferência, tempo de resposta e utilização da CPU.vmstat: Fornece informações sobre a utilização da memória virtual, incluindo a quantidade de memória livre, a quantidade de memória swap utilizada e a taxa de paginação.iotop: Exibe a atividade de I/O em tempo real, permitindo identificar quais processos estão consumindo mais recursos de I/O.

O Que Levar Disso

Read-ahead e write buffering são técnicas poderosas que podem melhorar significativamente a performance de I/O, mas também apresentam riscos e trade-offs. A chave para otimizar essas técnicas é entender as características da carga de trabalho e ajustar os parâmetros de acordo.

Cargas de trabalho sequenciais: Read-ahead é altamente benéfico. Aumente o tamanho do read-ahead para maximizar a taxa de transferência.

Cargas de trabalho aleatórias: Read-ahead pode ser prejudicial. Reduza ou desative o read-ahead para evitar cache thrashing.

Write buffering: Use com cautela, especialmente em ambientes de produção. Garanta que a controladora RAID tenha uma BBU ou supercapacitor para proteger os dados em caso de falha de energia. Monitore a utilização da memória e ajuste os parâmetros

vm.dirty_ratioevm.dirty_background_ratiopara evitar que o sistema fique sem memória.

A arte de balancear cache e risco é fundamental para garantir a performance e a confiabilidade do sistema. Uma compreensão profunda dos mecanismos de read-ahead e write buffering, juntamente com o monitoramento contínuo e o ajuste fino dos parâmetros, é essencial para qualquer sysadmin, SRE ou engenheiro de infraestrutura que busca otimizar o desempenho de I/O.

Priya Patel

Data Center Operations Lead

Gerencia milhares de discos físicos. Sabe exatamente qual modelo de HDD vibra mais e qual SSD morre primeiro.