Read Cache Vs Write Cache

Imagine um servidor de banco de dados sem cache. Cada consulta, por mais simples que seja, exigiria uma busca no disco, esperando milissegundos preciosos. Em um...

Read Cache Vs Write Cache

O Cenário do Cache: A Ponte Entre a Velocidade e a Lentidão

Imagine um servidor de banco de dados sem cache. Cada consulta, por mais simples que seja, exigiria uma busca no disco, esperando milissegundos preciosos. Em um sistema com alta demanda, isso se traduziria em lentidão excruciante e gargalos de desempenho.

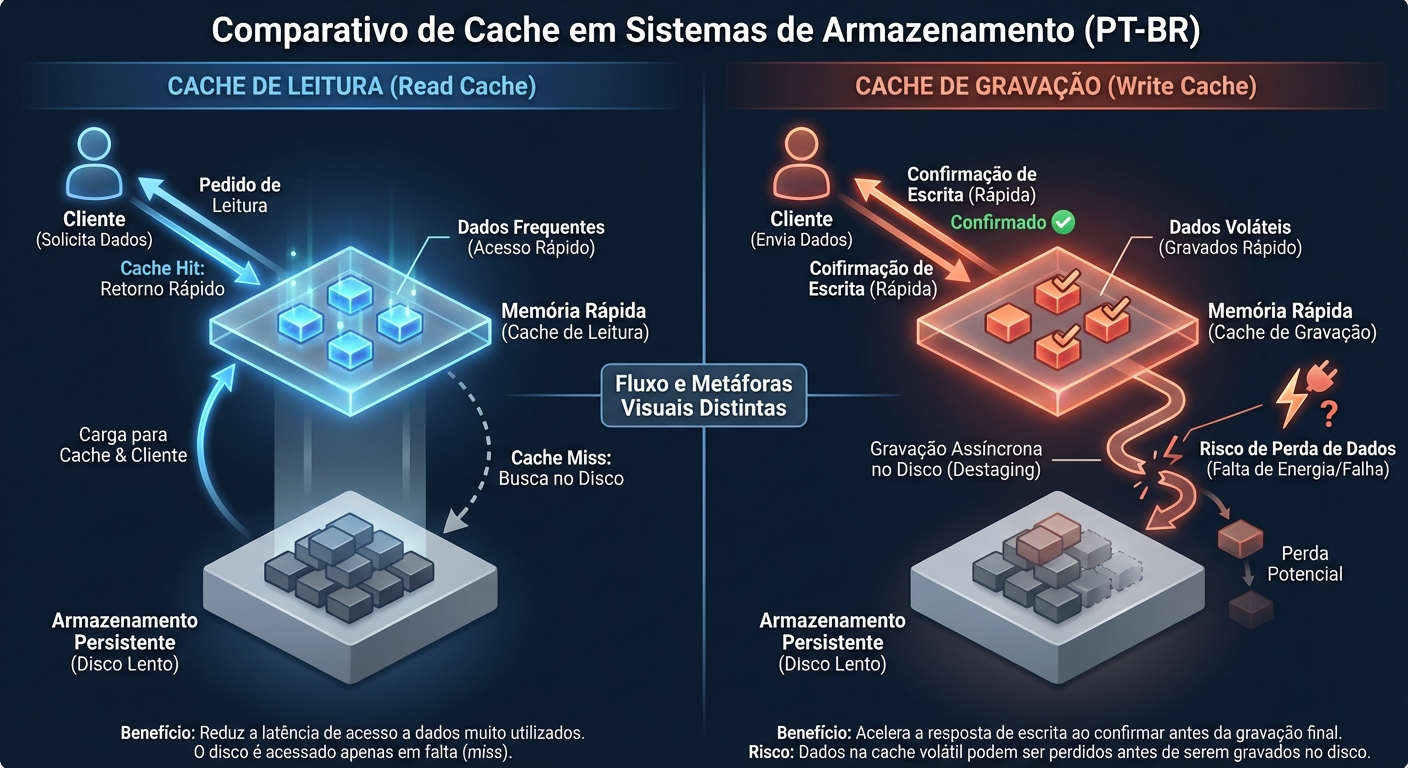

O cache atua como uma ponte, armazenando temporariamente os dados mais acessados em uma camada de memória mais rápida. Ao invés de buscar os dados no disco, o sistema primeiro verifica o cache. Se os dados estiverem lá (um "cache hit"), a resposta é instantânea. Se não estiverem (um "cache miss"), os dados são buscados no disco e, em seguida, copiados para o cache para acessos futuros.

A eficiência do cache depende de vários fatores, incluindo o algoritmo de substituição (qual dado é removido quando o cache está cheio) e a proporção de "cache hits" versus "cache misses". Um bom cache pode reduzir drasticamente a latência e aumentar a taxa de transferência de dados.

Cache de Leitura (Read Cache): Acelerando o Acesso aos Dados

O cache de leitura, também conhecido como read cache, armazena cópias dos dados que foram recentemente lidos do armazenamento. A ideia é simples: se os dados forem solicitados novamente em breve, eles poderão ser servidos diretamente da memória, sem a necessidade de acessar o disco.

Como Funciona:

- Requisição de Leitura: Uma aplicação solicita dados do sistema de armazenamento.

- Verificação do Cache: O sistema verifica se os dados solicitados estão presentes no read cache.

- Cache Hit: Se os dados estão no cache, eles são retornados imediatamente para a aplicação.

- Cache Miss: Se os dados não estão no cache, eles são lidos do disco, enviados para a aplicação e também copiados para o read cache.

- Algoritmos de Substituição: Quando o cache está cheio, um algoritmo de substituição decide quais dados serão removidos para dar lugar aos novos.

Algoritmos de Substituição Comuns:

- LRU (Least Recently Used): Remove os dados que não foram acessados há mais tempo. É um algoritmo popular e geralmente eficaz.

- LFU (Least Frequently Used): Remove os dados que foram acessados com menos frequência. Pode ser útil para dados que são raramente acessados, mas mantém no cache dados que, embora acessados no passado, não são mais relevantes.

- FIFO (First-In, First-Out): Remove os dados que foram adicionados primeiro ao cache. Simples de implementar, mas geralmente menos eficaz que LRU ou LFU.

- MRU (Most Recently Used): Remove os dados acessados mais recentemente. Pode parecer contra-intuitivo, mas funciona bem em situações onde os dados acessados recentemente são menos propensos a serem acessados novamente.

Tipos de Read Cache:

- RAM: A opção mais rápida, oferecendo latência extremamente baixa. Ideal para dados acessados com muita frequência (hot data).

- SSD/NVMe: Mais lento que a RAM, mas ainda significativamente mais rápido que HDDs. Pode ser usado como uma camada intermediária entre a RAM e o disco.

- Disco Rígido (HDD): Embora menos comum, alguns sistemas usam HDDs como read cache para outros HDDs, buscando otimizar o acesso a dados sequenciais.

Quando o Read Cache Ajuda:

- Hot Data: Dados que são acessados repetidamente em um curto período de tempo. Bancos de dados, servidores web e sistemas de arquivos se beneficiam enormemente do read cache.

- Padrões de Acesso Predictíveis: Se o sistema consegue prever quais dados serão solicitados em breve, ele pode pré-carregá-los no cache (prefetching), aumentando a taxa de "cache hits".

Quando o Read Cache é Inútil:

- Cold Data: Dados que são raramente acessados. Armazená-los no cache desperdiça espaço e pode até mesmo diminuir o desempenho, pois eles competem com dados mais relevantes.

- Acessos Aleatórios: Se os dados são acessados de forma aleatória e não repetitiva, a taxa de "cache hits" será baixa e o cache terá pouco impacto.

- Cache Size Limitado: Se o tamanho do cache é muito pequeno em relação ao tamanho do conjunto de dados, ele pode rapidamente ficar cheio e ineficaz.

Cache de Escrita (Write Cache): Acelerando a Gravação e Agrupando Operações

O cache de escrita, ou write cache, armazena temporariamente os dados que estão sendo escritos no armazenamento. Isso permite que o sistema responda rapidamente às solicitações de escrita, mesmo que a operação de gravação física no disco seja mais lenta.

Como Funciona:

- Requisição de Escrita: Uma aplicação solicita a escrita de dados no sistema de armazenamento.

- Escrita no Cache: Os dados são escritos no write cache, que geralmente é uma RAM.

- Confirmação: O sistema confirma a escrita para a aplicação, mesmo antes dos dados serem gravados no disco.

- Gravação no Disco: Os dados são eventualmente gravados no disco, em segundo plano.

Modos de Operação:

- Write-Through: Os dados são gravados simultaneamente no cache e no disco. Oferece maior segurança, pois os dados são imediatamente persistidos. No entanto, a performance é limitada pela velocidade de escrita do disco.

- Write-Back: Os dados são gravados apenas no cache inicialmente. A gravação no disco é adiada para um momento posterior. Isso oferece melhor performance, pois as operações de escrita são muito mais rápidas. No entanto, há um risco de perda de dados se o cache falhar antes dos dados serem gravados no disco.

Riscos do Write Cache:

- Perda de Dados: Em caso de falha de energia ou falha do sistema, os dados que estão no write cache (em modo write-back) e ainda não foram gravados no disco podem ser perdidos.

- Corrupção de Dados: Se a gravação no disco for interrompida no meio do processo, os dados podem ser corrompidos.

Mitigando os Riscos:

- BBU (Battery Backup Unit): Uma bateria que mantém o cache alimentado em caso de falha de energia, permitindo que os dados sejam gravados no disco antes de o sistema ser desligado.

- Supercapacitor: Similar a uma BBU, mas usa um supercapacitor em vez de uma bateria. Supercapacitores carregam e descarregam mais rapidamente e têm uma vida útil mais longa que as baterias.

- NVM (Non-Volatile Memory): Usar memória não volátil (como NVRAM) como write cache elimina o risco de perda de dados em caso de falha de energia.

Benefícios do Write Cache:

- Performance: Acelera as operações de escrita, permitindo que as aplicações respondam mais rapidamente.

- Coalescing: Permite agrupar várias operações de escrita menores em uma única operação maior, otimizando a escrita no disco. Isso é particularmente útil para HDDs, que têm melhor desempenho com escritas sequenciais.

- Write Reordering: Permite reordenar as operações de escrita para otimizar o desempenho do disco.

Hierarquia de Cache: Camadas de Desempenho

O cache não é um conceito único, mas sim uma hierarquia de camadas, cada uma com suas próprias características de velocidade e capacidade.

- CPU Cache: O cache mais rápido e menor, integrado diretamente no processador. Armazena instruções e dados que a CPU está usando ativamente. Dividido em níveis (L1, L2, L3), com L1 sendo o mais rápido e menor.

- RAM Cache (Page Cache): O cache de memória principal do sistema operacional. Armazena páginas de memória que foram recentemente acessadas, incluindo dados de arquivos e blocos de disco.

- Controlador de Storage: Alguns controladores de storage (RAID, por exemplo) possuem seu próprio cache, geralmente implementado com RAM e BBU.

- Dispositivo: SSDs e HDDs também possuem cache interno, usado para otimizar as operações de leitura e escrita.

Implicações em SSDs/NVMe: SLC Cache e Write Amplification

SSDs e NVMe utilizam memória flash NAND, que tem características diferentes dos discos rígidos. Uma das principais diferenças é o conceito de "write amplification".

Write Amplification: Cada vez que um dado é escrito em uma célula NAND, a célula se degrada um pouco. Para prolongar a vida útil do SSD, os controladores usam técnicas de "wear leveling" para distribuir as escritas uniformemente por todas as células. No entanto, isso significa que uma única operação de escrita do sistema operacional pode resultar em múltiplas operações de escrita físicas no SSD, aumentando a "write amplification".

SLC Cache: Muitos SSDs usam uma pequena porção da memória flash configurada como SLC (Single-Level Cell), que armazena apenas um bit por célula. SLC oferece maior velocidade e durabilidade, e é usado como um write cache para acelerar as operações de escrita. Quando o SLC cache está cheio, o desempenho de escrita do SSD pode diminuir significativamente.

DRAM Cache: Alguns SSDs também possuem uma DRAM cache, que funciona como um buffer para as operações de leitura e escrita. A DRAM cache pode melhorar o desempenho, mas também apresenta o risco de perda de dados em caso de falha de energia.

ZFS ARC e L2ARC: Uma Abordagem Avançada de Cache

ZFS (Zettabyte File System) é um sistema de arquivos avançado que incorpora um sofisticado sistema de cache chamado ARC (Adaptive Replacement Cache).

ARC (Adaptive Replacement Cache): Um algoritmo de cache que se adapta dinamicamente aos padrões de acesso aos dados, otimizando a taxa de "cache hits". O ARC monitora o desempenho de diferentes algoritmos de substituição (como LRU e LFU) e ajusta automaticamente o algoritmo em uso para maximizar a eficiência do cache.

L2ARC (Level 2 Adaptive Replacement Cache): Uma segunda camada de cache, geralmente implementada com SSDs ou NVMe. O L2ARC estende a capacidade do ARC, permitindo armazenar uma quantidade maior de dados em cache. Quando um dado não é encontrado no ARC (L1 cache), o sistema verifica o L2ARC antes de acessar o disco.

Como Medir e Otimizar: Ferramentas e Parâmetros

Monitorar o desempenho do cache é essencial para identificar gargalos e otimizar a configuração do sistema.

Ferramentas:

- sar (System Activity Reporter): Uma ferramenta poderosa para monitorar a atividade do sistema, incluindo o uso de CPU, memória, disco e rede.

- iostat: Uma ferramenta para monitorar a atividade de I/O do disco, incluindo a taxa de transferência, a latência e a taxa de utilização.

- ZFS arcstat: Uma ferramenta específica para monitorar o desempenho do ZFS ARC e L2ARC.

Parâmetros a Ajustar:

- Tamanho do Cache: Aumentar o tamanho do cache pode melhorar o desempenho, mas requer mais memória.

- Algoritmo de Substituição: Escolher o algoritmo de substituição mais adequado para o padrão de acesso aos dados.

- Write Cache Mode: Escolher entre write-through e write-back, considerando o trade-off entre performance e segurança de dados.

- ZFS ARC Size: Ajustar o tamanho do ZFS ARC para otimizar o desempenho do sistema de arquivos.

Exemplo: Monitorando o ZFS ARC com arcstat:

arcstat 1

Esta linha de comando exibirá estatísticas sobre o ZFS ARC a cada segundo, permitindo monitorar a taxa de "cache hits" e o uso de memória.

O Que Levar Disso: Entender o Cache É Entender a Performance

O cache é um componente fundamental dos sistemas de armazenamento modernos. Entender as diferenças entre cache de leitura e cache de escrita, os algoritmos de substituição, os riscos e benefícios de cada tipo de cache, e como monitorar e otimizar o desempenho do cache é essencial para qualquer profissional de infraestrutura que busca otimizar o desempenho de seus sistemas. Dominar esses conceitos permite diagnosticar gargalos, ajustar configurações e tomar decisões informadas sobre o hardware e software que utiliza. Em resumo, entender o cache é entender a performance.

Alexei Volkov

Ceph Cluster Administrator

Escala clusters Ceph para o infinito. Mestre em CRUSH maps e recuperação de placement groups.