vSAN vs. Open Source em 2025: Análise Real de Custo e Performance (Pós-Broadcom)

Os aumentos de licença VMware inviabilizaram seu vSAN? Comparamos arquitetura, latência e TCO real entre vSAN, Ceph (Proxmox) e ZFS para decidir seu futuro em 2025.

A poeira baixou após a aquisição da VMware pela Broadcom, e o cenário de virtualização e Hyper-Converged Infrastructure (HCI) mudou drasticamente. O que antes era uma decisão técnica ("Qual a melhor stack?") tornou-se uma crise financeira para muitos departamentos de TI. O aumento abrupto nos custos de licenciamento forçou sysadmins veteranos a fazerem a pergunta que evitavam há anos: "O Open Source está pronto para substituir o vSAN em produção crítica?"

Não estou aqui para vender o sonho do "software livre e gratuito". Nada em storage é gratuito. Se você não paga em licença, paga em hardware, em engenharia ou em horas de sono quando um disco falha às 3 da manhã. Vamos cortar o marketing e olhar para a física dos dados, os custos reais e a dor operacional.

O Dilema do Storage Definido por Software (SDS)

HCI (Hyper-Converged Infrastructure) é a consolidação de computação e armazenamento em nós x86 padrão, eliminando a necessidade de SANs proprietárias. A escolha entre vSAN e Open Source (como Ceph ou ZFS sobre iSCSI/NFS) resume-se a um trade-off fundamental: pagar um prêmio pela integração estreita no kernel e facilidade de uso (vSAN) ou investir em complexidade operacional e hardware específico para obter flexibilidade e evitar lock-in (Open Source).

O "Imposto Broadcom": Impacto no Custo do HCI

A mudança para o modelo de subscrição e o empacotamento forçado (o fim das licenças perpétuas e do vSphere Standard isolado em muitos casos) alterou a matemática do TCO (Total Cost of Ownership).

Antigamente, o vSAN era caro, mas previsível. Agora, o custo é recorrente e atrelado a núcleos de CPU. Isso penaliza servidores densos que eram ótimos para consolidação. Se você tem um cluster de 4 nós com CPUs de 64 cores, sua conta anual pode ter triplicado.

No mundo Open Source (pense em Proxmox com Ceph ou TrueNAS com ZFS), o custo de licença é zero ou baixo (suporte enterprise). Porém, o erro do novato é achar que essa economia vai direto para o lucro. O dinheiro que você economiza em licenças Broadcom precisa ser parcialmente reinvestido em hardware de maior qualidade e em capital humano.

Arquitetura vSAN vs. Ceph: Latência e Caminho de Dados

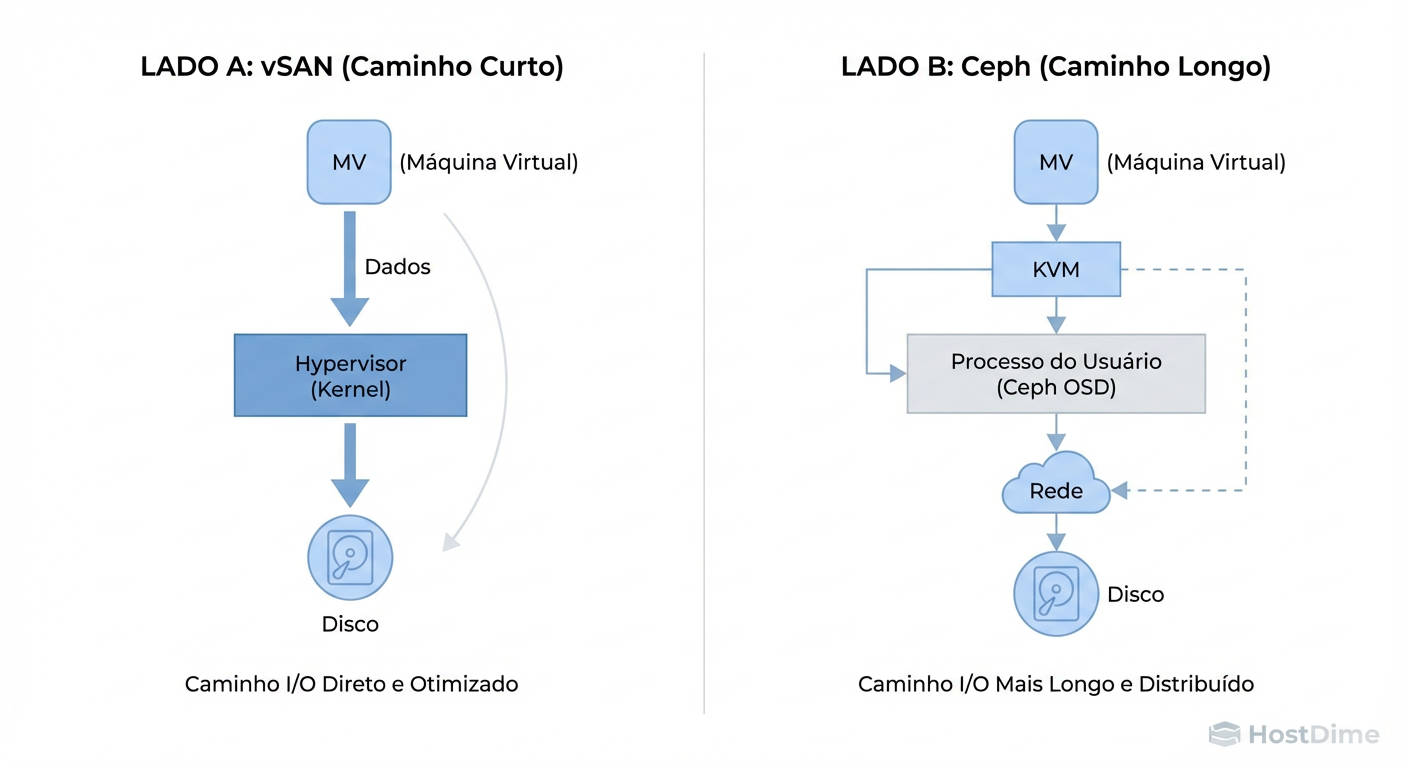

Para entender a performance, você precisa visualizar o caminho que um bit percorre desde a VM até a célula NAND do SSD. É aqui que a "mágica" do marketing morre e a engenharia de sistemas começa.

A Vantagem do Kernel (vSAN)

O vSAN roda dentro do kernel do ESXi. Não há "Virtual Storage Appliance" (VSA) de verdade no caminho crítico de I/O. Quando uma VM grava um bloco, o kernel do ESXi gerencia isso quase nativamente. Isso resulta em latência extremamente baixa e eficiência de CPU. O vSAN sabe exatamente o que é prioridade.

O Custo do Context Switch (Ceph/Open Source)

O Ceph, frequentemente usado com Proxmox ou OpenStack, roda tradicionalmente em user space. Quando uma VM (KVM) precisa gravar:

O dado sai da VM.

Passa pelo kernel do host.

Sobe para o processo do OSD (Object Storage Daemon) em user space.

O OSD processa, replica e desce para o kernel novamente para gravar no disco.

Essas trocas de contexto (context switches) custam ciclos de CPU e adicionam latência. Embora implementações modernas (como Crimson no Ceph) tentem mitigar isso, a física é implacável: quanto mais camadas, maior a latência.

Figura: O Caminho do I/O: A integração no Kernel do vSAN vs. a flexibilidade (e latência) do User-Space no Ceph.

Figura: O Caminho do I/O: A integração no Kernel do vSAN vs. a flexibilidade (e latência) do User-Space no Ceph.

A Ilusão do Hardware Genérico

Um dos maiores mitos do Open Source é: "Roda em qualquer coisa". Tecnicamente, sim. Operacionalmente, isso é suicídio.

O vSAN possui uma HCL (Hardware Compatibility List) rigorosa. Se você seguir a HCL, a performance é garantida. Se você sair dela, o suporte desliga o telefone na sua cara.

No Open Source, você é a HCL.

ZFS (TrueNAS/Proxmox): Se você usar SSDs de consumo sem proteção contra perda de energia (PLP - Power Loss Protection), sua performance de gravação síncrona (SLOG) será abismal. O ZFS precisa garantir que o dado está seguro antes de confirmar a gravação. Sem PLP, ele espera o disco físico fazer o flush, o que é lento.

Rede: O vSAN funciona "ok" em 10GbE. Um cluster Ceph saudável em produção exige 25GbE ou 100GbE, preferencialmente com RDMA/RoCE para reduzir a latência que mencionamos acima.

Regra de Ouro: Hardware para Open Source Storage deve ser Enterprise Grade. Economizar no disco é pedir para ter latência de 50ms em banco de dados.

Métricas de Performance em Storage: O Que Medir

Esqueça o "throughput máximo sequencial". Ninguém se importa se seu storage faz 10GB/s se o banco de dados SQL trava a cada 5 minutos. Sysadmins pragmáticos olham para:

Latência de Cauda (Tail Latency - p99): A média pode ser 2ms, mas se 1% das requisições leva 200ms, sua aplicação vai engasgar. O vSAN tende a ter p99 mais estável sob carga moderada devido à integração no kernel.

Write Amplification: Quanto dado é realmente gravado no disco para cada 1MB enviado pela VM? O Ceph, com sua replicação completa de objetos, pode ser "pesado" na rede de backend.

Tempo de Reconstrução (Rebuild Time): Quando um disco de 8TB falha, quanto tempo leva para o cluster voltar ao estado "Health: OK"? Durante esse tempo, sua performance cai drasticamente.

Para validar seu ambiente, não use cópia de arquivos. Use ferramentas padronizadas como fio.

Exemplo de teste de "tortura" para simular banco de dados (Random Write 4k):

# NÃO RODE ISSO EM PRODUÇÃO.

# Teste de Random Write 4k, I/O direto (sem cache do OS), simulando DB.

fio --name=random-write-test \

--ioengine=libaio --rw=randwrite --bs=4k --numjobs=4 \

--size=10G --iodepth=32 --runtime=60 --time_based \

--direct=1 --group_reporting

Se o seu storage Open Source entregar menos de 10k IOPS com latência sub-milissegundo neste teste, ele não substitui um vSAN All-Flash.

Tabela Comparativa: Realidade Operacional

| Característica | VMware vSAN | Ceph (Proxmox/Genérico) | ZFS (TrueNAS/Single Node) |

|---|---|---|---|

| Custo de Licença | Altíssimo (OpEx recorrente) | Zero (ou Baixo com suporte) | Zero (ou Baixo com suporte) |

| Integração | Nativa (Kernel ESXi) | User-space (Overhead de CPU) | Kernel Module (Alta performance local) |

| Escalabilidade | Linear até ~64 nós | Massiva (Petabytes) | Vertical (Scale-up, não out) |

| Exigência de Hardware | HCL Estrita | Hardware Enterprise Robusto | RAM ECC + Discos c/ PLP |

| Curva de Aprendizado | Baixa (GUI vCenter) | Extrema (CLI, CRUSH map) | Média (Conceitos de Pool/Dataset) |

| Risco de "Day 2" | Vendor Lock-in | Erro de Configuração Humana | Falha de Controladora (se não HA) |

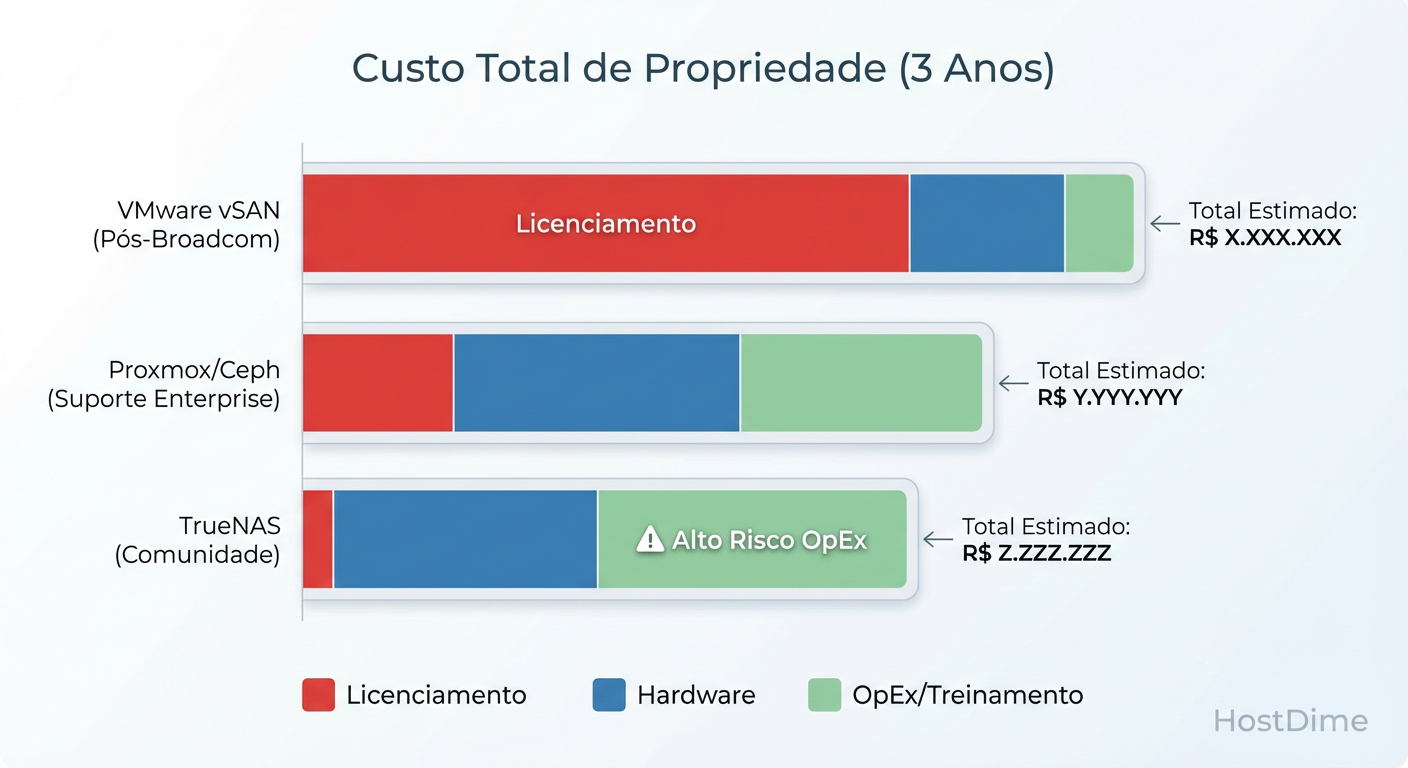

Custos Ocultos de Migração e Operação

Migrar de vSAN para Proxmox/Ceph não é apenas "converter VMs". É uma mudança de paradigma operacional.

O Custo do Talento: Encontrar um admin que clique no vCenter é fácil. Encontrar um que entenda placement groups do Ceph, scrubbing do ZFS e debugging de rede Linux custa caro. Se você não tem esse expert, você precisará de consultoria.

Backup e DR: O ecossistema VMware (Veeam, Zerto, etc.) é maduro. No mundo Open Source, embora o Proxmox Backup Server seja excelente, ele exige uma nova infraestrutura e novos processos de validação.

Networking: O vSAN abstrai muita complexidade de rede. No Ceph, você precisará configurar LACP, Jumbo Frames e talvez RDMA manualmente nos switches e hosts. Um erro de MTU aqui derruba o cluster inteiro.

Figura: Comparativo de TCO Estimado (3 Anos): Onde o dinheiro realmente vai em cada solução.

Figura: Comparativo de TCO Estimado (3 Anos): Onde o dinheiro realmente vai em cada solução.

Veredito Técnico: Quando Migrar?

A decisão não é binária. Ela depende do seu apetite por risco e da competência da sua equipe.

Fique no vSAN se:

Você tem orçamento e valoriza a paz de espírito acima do custo.

Sua equipe é pequena e generalista (não tem especialistas em Linux/Storage).

Você precisa de certificação estrita de fornecedores de software (ex: SAP HANA, Oracle RAC) que exigem VMware.

Migre para Proxmox/Ceph se:

Seu ambiente tem escala (mais de 5-10 nós). O Ceph brilha na escala; em clusters pequenos (3 nós), ele é complexo demais para o benefício.

Você tem engenheiros Linux competentes que sabem ler logs e usar CLI.

O custo de licenciamento Broadcom inviabiliza o negócio.

Migre para TrueNAS/ZFS (iSCSI/NFS) se:

Você tem um ambiente menor (SMB/Edge) e não precisa de HCI distribuído.

Você quer a integridade de dados absoluta do ZFS, mas aceita uma arquitetura de storage centralizado (ou HA com dois nós).

Performance pura local é mais importante que escalabilidade horizontal.

O "imposto Broadcom" é real, mas o "imposto da complexidade" do Open Source também é. Escolha qual conta você prefere pagar.

Referências & Leitura Complementar

VMware Performance Best Practices for vSphere 8.0 – Documentação técnica detalhando a interação do vSAN com o Kernel.

Ceph Docs: Network Configuration Reference – Detalhes sobre requisitos de latência e largura de banda para clusters saudáveis.

RFC 3720 (iSCSI) – Para entender os limites do protocolo ao usar ZFS/TrueNAS como datastore compartilhado.

Proxmox VE Administration Guide – Capítulos sobre gerenciamento de Ceph e integração com QEMU/KVM.

Sarah 'The Backup' Connor

Gerente de Recuperação de Desastres

Seus dados não estão seguros até que ela diga que estão. Especialista em estratégias de backup imutável e RPO/RTO.