Write-back vs Write-through: Riscos e Benefícios Desmistificados

O mundo do armazenamento de dados é cheio de compromissos. Uma das decisões mais cruciais que sysadmins, SREs e engenheiros de infraestrutura precisam tomar é c...

Write-back vs Write-through: Riscos e Benefícios Desmistificados

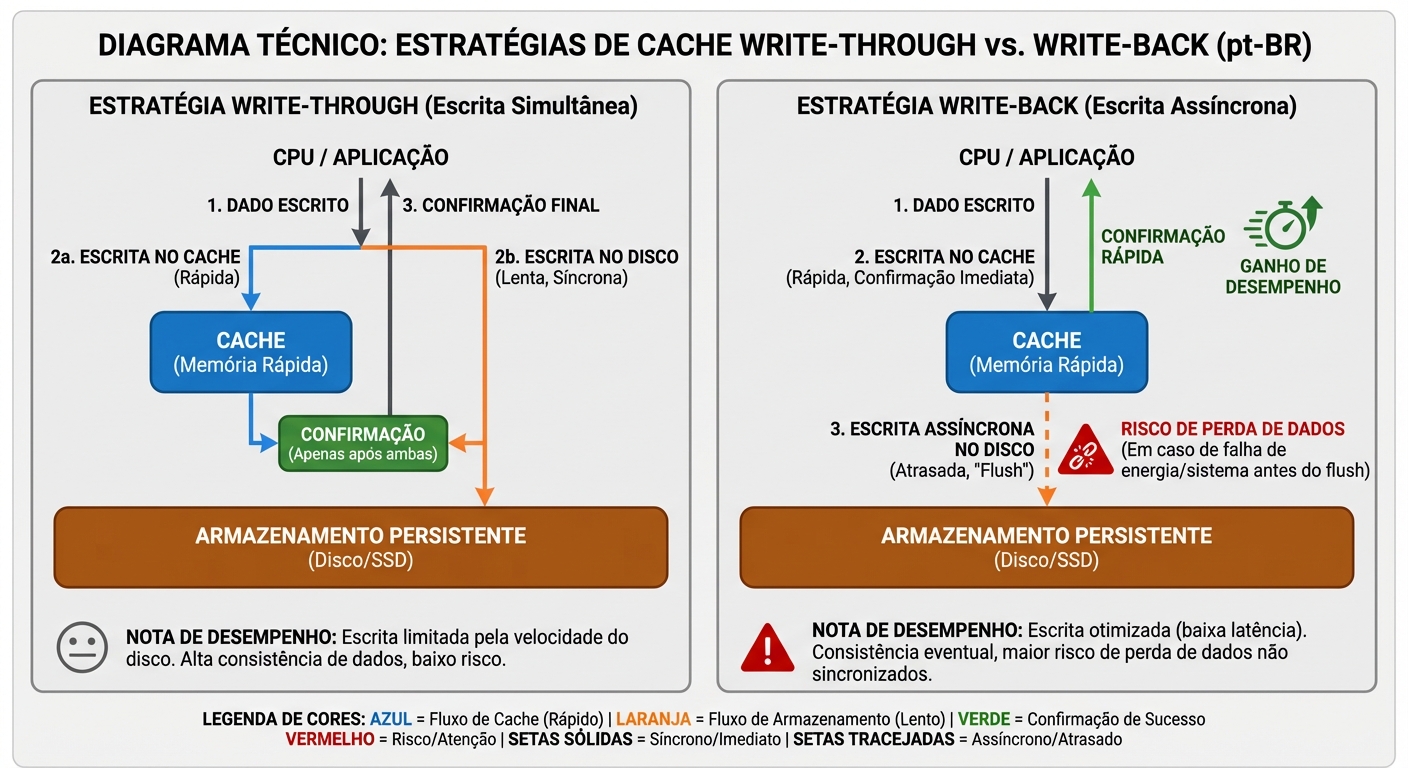

O mundo do armazenamento de dados é cheio de compromissos. Uma das decisões mais cruciais que sysadmins, SREs e engenheiros de infraestrutura precisam tomar é como lidar com as operações de escrita. Especificamente, qual estratégia de cache de escrita usar: write-through ou write-back. Ambas têm seus próprios benefícios e desvantagens, e a escolha certa depende criticamente da sua workload e tolerância ao risco. Vamos mergulhar fundo em como cada uma funciona e como elas afetam a performance e a durabilidade dos seus dados.

O Desafio da Escrita de Dados

Enquanto a leitura de dados é geralmente uma operação simples, a escrita introduz uma camada extra de complexidade. Precisamos garantir que os dados sejam gravados de forma durável (que não sejam perdidos em caso de falha) e com performance aceitável. O problema é que esses dois objetivos muitas vezes estão em conflito direto.

Imagine que você está escrevendo um arquivo em disco. A maneira mais segura de fazer isso é escrever os dados diretamente no disco rígido. Mas discos rígidos são lentos. A cada escrita, o sistema precisa esperar que a cabeça de leitura/escrita se mova para a posição correta e que o disco gire até o setor correto. Isso leva tempo.

É aí que entram as estratégias de cache de escrita. Elas atuam como um buffer entre a aplicação e o dispositivo de armazenamento (disco, SSD, etc.), permitindo que a aplicação "pense" que a escrita foi concluída mais rápido do que realmente foi. Mas essa velocidade vem com um custo: o risco de perder dados se o cache for perdido antes de ser descarregado para o armazenamento persistente.

Write-through Cache: Segurança em Primeiro Lugar

A estratégia write-through é a mais simples e segura das duas.

Como funciona:

- A aplicação solicita uma escrita de dados.

- Os dados são escritos simultaneamente no cache e no armazenamento persistente (disco, SSD, etc.).

- A aplicação recebe a confirmação de que a escrita foi concluída somente depois que os dados foram gravados com sucesso no armazenamento persistente.

Em essência, a escrita é síncrona. A aplicação espera até que os dados estejam seguros no disco.

Benefícios:

- Durabilidade dos dados: Cada escrita é imediatamente refletida no armazenamento persistente, minimizando o risco de perda de dados em caso de falha do sistema. Se a energia acabar repentinamente, no máximo você perde a última escrita em andamento, mas não dados já confirmados.

- Consistência dos dados: Como os dados são escritos tanto no cache quanto no armazenamento ao mesmo tempo, o cache e o armazenamento estão sempre sincronizados. Isso simplifica a recuperação em caso de falha.

- Simplicidade: A implementação é relativamente simples, o que reduz a probabilidade de bugs e facilita a manutenção.

Desvantagens:

- Latência de escrita: A aplicação precisa esperar que a escrita seja concluída no armazenamento persistente, o que pode ser lento, especialmente com discos rígidos tradicionais. Isso pode impactar significativamente a performance geral do sistema.

- Sobrecarga de I/O: Cada escrita gera duas operações de I/O: uma para o cache e outra para o armazenamento. Isso pode sobrecarregar o sistema de I/O, especialmente em workloads com muitas escritas.

Modelo Mental: Imagine um mensageiro entregando uma carta (dados) diretamente no destino (armazenamento persistente) e fazendo uma cópia para si mesmo (cache) ao mesmo tempo. Ele não volta para te avisar até ter certeza que a carta chegou ao destino.

Write-back Cache: Velocidade Acima de Tudo

A estratégia write-back prioriza a performance em detrimento da segurança imediata dos dados.

Como funciona:

- A aplicação solicita uma escrita de dados.

- Os dados são escritos apenas no cache.

- A aplicação recebe a confirmação de que a escrita foi concluída imediatamente, sem esperar que os dados sejam gravados no armazenamento persistente.

- Posteriormente, em algum momento futuro (determinado por algoritmos de cache), os dados do cache são "descarregados" (flushed) para o armazenamento persistente.

Em essência, a escrita é assíncrona. A aplicação acredita que a escrita está completa muito antes de estar realmente segura no disco.

Benefícios:

- Latência de escrita: A aplicação não precisa esperar que a escrita seja concluída no armazenamento persistente, o que resulta em uma latência de escrita muito menor e uma performance geral do sistema significativamente melhor.

- Coalescing de escritas: Múltiplas escritas para o mesmo bloco de dados podem ser combinadas em uma única escrita para o armazenamento persistente. Isso reduz a sobrecarga de I/O e melhora a eficiência. Imagine que você está editando um arquivo de texto e salvando-o várias vezes. Com write-back, o sistema pode esperar você terminar de editar e salvar apenas a versão final no disco.

- Amortização de escritas: Pequenas escritas podem ser agregadas em escritas maiores, que são mais eficientes para o armazenamento persistente.

Desvantagens:

- Risco de perda de dados: Se o sistema falhar (queda de energia, travamento, etc.) antes que os dados no cache sejam descarregados para o armazenamento persistente, esses dados serão perdidos. Este é o maior risco associado ao write-back.

- Complexidade: A implementação é mais complexa do que write-through, o que aumenta a probabilidade de bugs e dificulta a manutenção.

- Consistência: Em caso de falha, o cache e o armazenamento podem ficar dessincronizados, o que pode levar a problemas de consistência dos dados.

Modelo Mental: Imagine um mensageiro que anota a mensagem (dados) em um bloco de notas (cache) e te avisa imediatamente que a mensagem foi entregue. Ele pretende entregar a mensagem no destino (armazenamento persistente) mais tarde, mas se ele for atropelado por um ônibus no caminho, a mensagem se perde.

Mecanismos de Proteção: Mitigando os Riscos do Write-back

O risco de perda de dados com write-back é real, mas existem mecanismos para mitigá-lo:

BBU (Battery Backup Unit): Uma bateria que fornece energia ao cache em caso de falha de energia. Isso permite que os dados no cache sejam descarregados para o armazenamento persistente antes que o sistema desligue completamente. BBUs são comuns em controladoras RAID de alto desempenho.

Warning: BBUs têm uma vida útil limitada e precisam ser substituídas periodicamente. Além disso, o tempo de vida da bateria pode ser afetado por altas temperaturas.

Supercapacitores: Uma alternativa às BBUs. Supercapacitores carregam e descarregam muito mais rápido do que baterias e têm uma vida útil muito maior. Eles também são mais tolerantes a altas temperaturas.

Journaling em Filesystems (EXT4, XFS): Filesystems com journaling, como EXT4 e XFS, mantêm um "diário" das operações de escrita. Se o sistema falhar antes que as escritas sejam concluídas, o filesystem pode usar o diário para "reproduzir" as operações e garantir a consistência dos dados. O journaling reduz drasticamente o tempo de recuperação após uma falha. Existem diferentes modos de journaling, com diferentes compromissos entre performance e segurança. Por exemplo, o modo

orderedno EXT4 garante que os metadados sejam escritos antes dos dados, o que evita corrupção do filesystem em caso de falha.fsync(): Uma chamada de sistema que força os dados de um arquivo a serem escritos no armazenamento persistente. Usar

fsync()após uma escrita garante que os dados estejam seguros, mesmo com write-back cache habilitado. No entanto, usarfsync()com muita frequência pode degradar a performance. Bancos de dados geralmente usamfsync()para garantir a durabilidade das transações.

Implicações para Bancos de Dados e VMs

A escolha da estratégia de cache de escrita tem um impacto significativo em bancos de dados e máquinas virtuais (VMs):

- Bancos de Dados: Bancos de dados geralmente exigem alta durabilidade dos dados. Perder uma transação pode levar a inconsistências e corrupção dos dados. Por isso, muitos bancos de dados usam write-through cache ou write-back cache com proteção de BBU ou supercapacitor. Além disso, eles usam

fsync()para garantir que as transações sejam gravadas no disco antes de serem consideradas concluídas. A performance é importante, mas a integridade dos dados é fundamental. - VMs: A escolha depende do tipo de workload executada na VM. Para VMs que executam aplicações críticas, como bancos de dados, a durabilidade dos dados é crucial. Para VMs que executam aplicações menos críticas, como servidores web, a performance pode ser mais importante. Em ambientes virtualizados, a configuração do cache de escrita pode ser feita tanto no hipervisor quanto no sistema operacional convidado. É importante entender como essas configurações interagem para garantir o comportamento desejado.

- Por exemplo, um hipervisor pode configurar o armazenamento subjacente para usar write-back, enquanto o sistema operacional convidado pode configurar seu sistema de arquivos para usar write-through. Nesse caso, o sistema operacional convidado pode acreditar que os dados estão seguros no disco, mas na verdade eles estão apenas no cache do hipervisor, o que ainda apresenta um risco de perda de dados.

Escolhendo a Estratégia Certa

Não existe uma resposta única para qual estratégia de cache de escrita usar. A escolha certa depende das suas necessidades específicas:

- Priorize a durabilidade dos dados se:

- Você está lidando com dados críticos que não podem ser perdidos.

- Você está executando um banco de dados ou outra aplicação que exige alta integridade dos dados.

- Você tem um baixo nível de tolerância ao risco.

- Nesse caso, use write-through cache ou write-back cache com proteção robusta (BBU/supercapacitor) e

fsync().

- Priorize a performance se:

- Você está lidando com dados que podem ser perdidos sem grandes consequências.

- Você está executando uma aplicação que exige alta performance de escrita.

- Você tem um alto nível de tolerância ao risco.

- Nesse caso, use write-back cache sem proteção adicional. Mas esteja ciente dos riscos!

- Considere uma abordagem híbrida:

- Alguns sistemas permitem configurar diferentes estratégias de cache de escrita para diferentes volumes ou arquivos. Isso permite otimizar a performance e a durabilidade para diferentes workloads.

- Por exemplo, você pode usar write-through cache para os arquivos de log do seu banco de dados e write-back cache para os arquivos de dados.

Lembre-se de que a escolha da estratégia de cache de escrita é apenas uma parte da equação. É importante ter um plano de backup e recuperação robusto para proteger seus dados em caso de falha.

O Que Levar Disso: Balanceando Performance e Durabilidade

A escolha entre write-back e write-through é um clássico dilema de engenharia: um trade-off entre performance e segurança. Write-through garante a durabilidade imediata dos dados, mas penaliza a performance. Write-back oferece performance superior, mas introduz um risco de perda de dados.

A decisão final deve ser baseada em uma análise cuidadosa das suas necessidades específicas, da sua tolerância ao risco e dos mecanismos de proteção disponíveis. Entender como cada estratégia funciona "por baixo do capô" é crucial para tomar uma decisão informada e construir um sistema robusto e confiável. Não há bala de prata: o segredo é o balanceamento.

Elena Kovacs

Arquiteta de Cloud Infrastructure

Focada em NVMe-oF e storage definido por software. Projeta clusters de petabytes para grandes provedores de nuvem.