Acelerando ZFS: Como Configurar Special VDEVs para Metadados e Blocos Pequenos

Transforme a performance do seu pool HDD movendo metadados para NVMe. Guia completo sobre Special VDEVs no OpenZFS: configuração, riscos e benchmarking.

O desempenho de um servidor de arquivos ZFS é frequentemente definido pela velocidade do seu elo mais lento. Em configurações híbridas, onde discos rígidos mecânicos (HDDs) são usados para armazenamento em massa devido ao baixo custo por terabyte, a latência rotacional torna-se um gargalo severo. Operações de metadados (listar diretórios, buscar atributos de arquivos) e a leitura de pequenos blocos de dados fragmentam o I/O, fazendo com que o array de discos soe como uma máquina de escrever antiga enquanto o throughput cai drasticamente.

A solução nativa do OpenZFS para este cenário é o Special VDEV (Classe de Alocação Especial). Diferente do L2ARC (que é um cache de leitura e pode ser perdido sem danos) ou do SLOG (focado em gravações síncronas), o Special VDEV é um armazenamento primário dedicado. Ele permite segregar fisicamente os metadados e arquivos pequenos em armazenamento flash (SSD/NVMe), mantendo os grandes arquivos sequenciais nos discos rotacionais.

Resumo em 30 segundos

- Função: O Special VDEV armazena metadados (obrigatório) e blocos de dados pequenos (opcional) em drives rápidos, aliviando os HDDs.

- Risco Crítico: Diferente do cache, o Special VDEV contém dados únicos. Se este VDEV falhar, todo o pool de armazenamento é perdido. Redundância (RAID 1/Mirror) é obrigatória.

- Impacto: Acelera drasticamente a navegação em diretórios, buscas de arquivos e operações em bancos de dados ou VMs armazenados no pool.

O gargalo mecânico e a função da classe de alocação especial

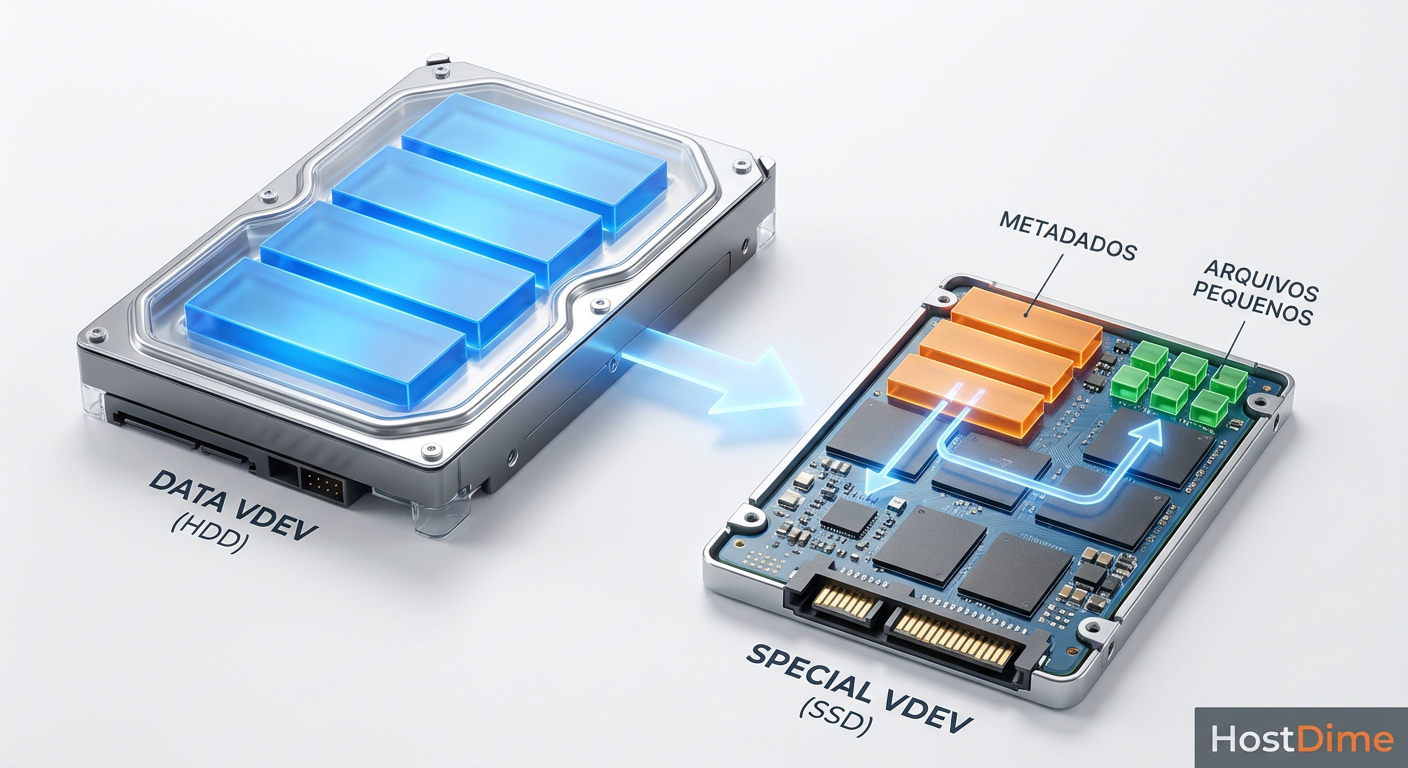

Para entender o ganho de performance, precisamos visualizar como o ZFS grava dados. Por padrão, metadados (informações sobre onde os dados estão, permissões, timestamps) são misturados com os dados normais nos mesmos discos.

Em um pool de HDDs, buscar um arquivo pequeno exige que a cabeça de leitura do disco se mova fisicamente para ler o metadado, depois se mova novamente para ler o dado. Multiplique isso por milhares de arquivos e você terá uma latência de I/O insustentável.

A "Classe de Alocação" (Allocation Class) introduzida no ZFS 0.8 permite criar um VDEV dedicado do tipo special. O ZFS automaticamente direciona todos os metadados para este dispositivo. O resultado é que os HDDs ficam livres para fazer o que fazem melhor: ler e gravar grandes fluxos contínuos de dados sequenciais.

Fig. 1: A separação física de dados: metadados e arquivos pequenos residem no flash, enquanto blocos grandes ficam nos discos rotacionais.

Fig. 1: A separação física de dados: metadados e arquivos pequenos residem no flash, enquanto blocos grandes ficam nos discos rotacionais.

A imagem acima ilustra a separação física. Note que o fluxo de dados é bifurcado antes de atingir a mídia de armazenamento, garantindo que solicitações aleatórias de 4K (comuns em metadados) nunca toquem nos discos rotacionais.

Requisitos de hardware e a regra crítica de redundância

Antes de abrir o terminal, é vital planejar a topologia física. A regra de ouro do Special VDEV é simples: a confiabilidade deste dispositivo deve ser igual ou superior à do restante do pool.

⚠️ Perigo: Ponto Único de Falha

Se você adicionar um único SSD como Special VDEV em um pool e esse SSD queimar, você perderá 100% dos dados do pool, mesmo que seus HDDs estejam em RAIDZ2 ou RAIDZ3. Os metadados necessários para montar o sistema de arquivos residiam naquele SSD falho.

Regra: Sempre configure Special VDEVs em espelhamento (Mirror/RAID 1). Se o seu pool é extremamente valioso (ex: datacenter corporativo), considere um espelhamento triplo (3-way mirror).

Dimensionamento de capacidade

Uma dúvida comum é: "Qual o tamanho do SSD eu preciso?". Para apenas metadados, uma regra empírica conservadora é calcular 0,3% a 0,5% da capacidade total do pool.

- Exemplo: Para um pool de 100 TB, um espelho de SSDs de 500 GB é mais do que suficiente para metadados puros.

Se você planeja usar o recurso de small blocks (discutido abaixo), precisará de mais espaço, dependendo da natureza dos seus dados.

Tipo de drive

Prefira SSDs NVMe para latência mínima. SSDs SATA são aceitáveis, mas a interface NVMe libera todo o potencial de IOPS. A durabilidade (TBW) é importante, pois metadados sofrem muitas reescritas. Drives de classe "Mixed Use" ou "Read Intensive" de nível enterprise são ideais. Evite drives QLC de consumo sem DRAM cache.

Fig. 4: Instalação física de drives NVMe/SSD. A redundância (RAID 1) é obrigatória para proteger a integridade do pool.

Fig. 4: Instalação física de drives NVMe/SSD. A redundância (RAID 1) é obrigatória para proteger a integridade do pool.

Adicionando o espelho de metadados ao pool existente

Vamos assumir que você já tem um pool chamado tank operando com HDDs e você instalou fisicamente dois novos SSDs para atuar como o Special VDEV.

1. Identificar os discos

Sempre use o ID do disco e não o nome da porta (/dev/sdX), pois o sdX pode mudar após um reboot.

ls -l /dev/disk/by-id/

Vamos supor que seus novos SSDs sejam:

/dev/disk/by-id/nvme-Samsung_SSD_980_S1/dev/disk/by-id/nvme-Samsung_SSD_980_S2

2. Verificar o status atual

zpool status tank

Certifique-se de que o pool está saudável (ONLINE) antes de prosseguir.

3. Adicionar o VDEV Especial

O comando abaixo adiciona os dois discos como um espelho (mirror) dedicado à classe special.

zpool add tank special mirror \

/dev/disk/by-id/nvme-Samsung_SSD_980_S1 \

/dev/disk/by-id/nvme-Samsung_SSD_980_S2

Se o comando for bem-sucedido, o retorno será silencioso. Verifique imediatamente a nova estrutura:

zpool status -v tank

A saída deverá mostrar uma nova seção special acima dos seus logs ou discos de dados:

NAME STATE READ WRITE CKSUM

tank ONLINE 0 0 0

mirror-0 ONLINE 0 0 0

wwn-0x5000cca0boc0... ONLINE 0 0 0

wwn-0x5000cca0boc1... ONLINE 0 0 0

special

mirror-1 ONLINE 0 0 0

nvme-Samsung_SSD_980_S1 ONLINE 0 0 0

nvme-Samsung_SSD_980_S2 ONLINE 0 0 0

A partir deste exato momento, todos os novos metadados criados serão gravados automaticamente nos NVMes.

💡 Dica Pro: Dados antigos (metadados existentes nos HDDs) não são movidos automaticamente para o SSD. Eles permanecerão nos HDDs até que sejam reescritos. Se você precisa de performance imediata em dados antigos, será necessário realizar um

zfs send | zfs recvpara regravar os datasets ou usar ferramentas de rebalanceamento se disponíveis na sua versão do ZFS.

Otimizando a propriedade special_small_blocks para arquivos pequenos

Aqui reside o verdadeiro poder de otimização. Além de metadados, você pode instruir o ZFS a armazenar arquivos inteiros no SSD, desde que sejam pequenos o suficiente. Isso é excelente para códigos-fonte, thumbnails de imagens ou logs.

A propriedade special_small_blocks define o limite de tamanho. Qualquer bloco de dados igual ou menor que este valor será desviado para o SSD.

Como configurar

Analise seu recordsize. O padrão do ZFS é 128K. Um valor seguro para começar é 32K ou 64K.

zfs set special_small_blocks=32K tank/projetos

A lógica do Recordsize

O special_small_blocks funciona em conjunto com o recordsize.

Se você tem um arquivo de 10MB e o

recordsizeé 128K, o arquivo será quebrado em vários blocos de 128K. Como 128K > 32K, esses blocos vão para o HDD.Se você tem um arquivo de 20KB, ele cabe em um único bloco menor que 32K. Ele vai para o SSD.

Isso garante que o SSD não seja inundado com pedaços de arquivos grandes (filmes, backups ISO), preservando o espaço flash apenas para arquivos que geram I/O aleatório ruim nos HDDs.

⚠️ Atenção ao Espaço: Configurar

special_small_blockscom um valor muito alto (ex: 128K ou igual ao recordsize) pode encher seus SSDs rapidamente. Monitore o uso de espaço com frequência. Se o Special VDEV encher, os dados voltarão a ser gravados nos HDDs, mas a performance cairá.

Monitorando a distribuição de I/O com zpool iostat

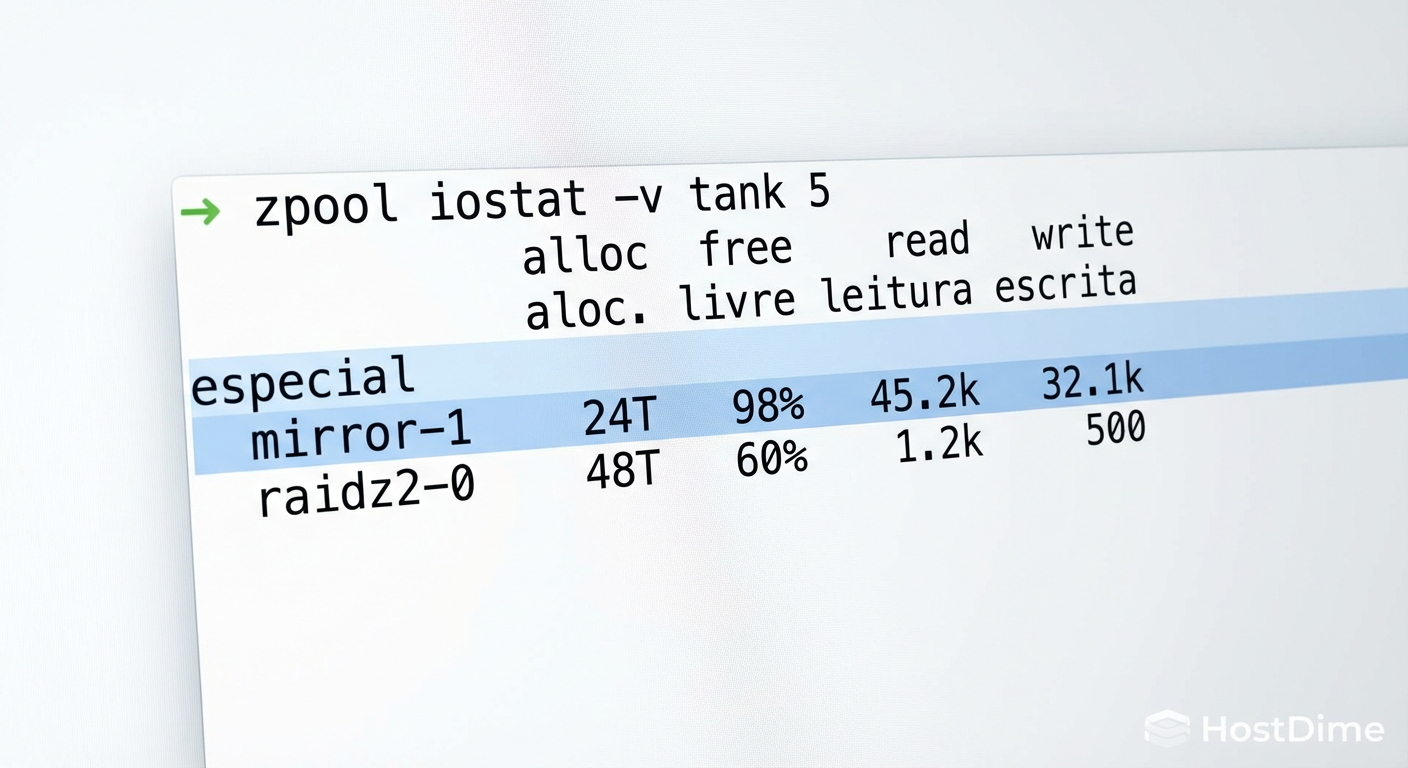

Após a configuração, é essencial verificar se o tráfego está fluindo como esperado. A ferramenta zpool iostat é sua melhor amiga aqui.

Use a flag -v para ver detalhes por VDEV e um intervalo de atualização (ex: 5 segundos).

zpool iostat -v tank 5

Fig. 2: Saída do comando zpool iostat confirmando que o tráfego intenso de IOPS está sendo absorvido pelo dispositivo especial.

Fig. 2: Saída do comando zpool iostat confirmando que o tráfego intenso de IOPS está sendo absorvido pelo dispositivo especial.

Observe as colunas de operations (IOPS) e bandwidth.

Em repouso ou navegação: Você deve ver alta atividade na seção

special(leituras de metadados) e quase zero nos discos rotacionais.Transferência de arquivos grandes: Você verá alta largura de banda nos discos

mirror-0(ou raidz) e baixa atividade nospecial(apenas atualização de metadados do arquivo).

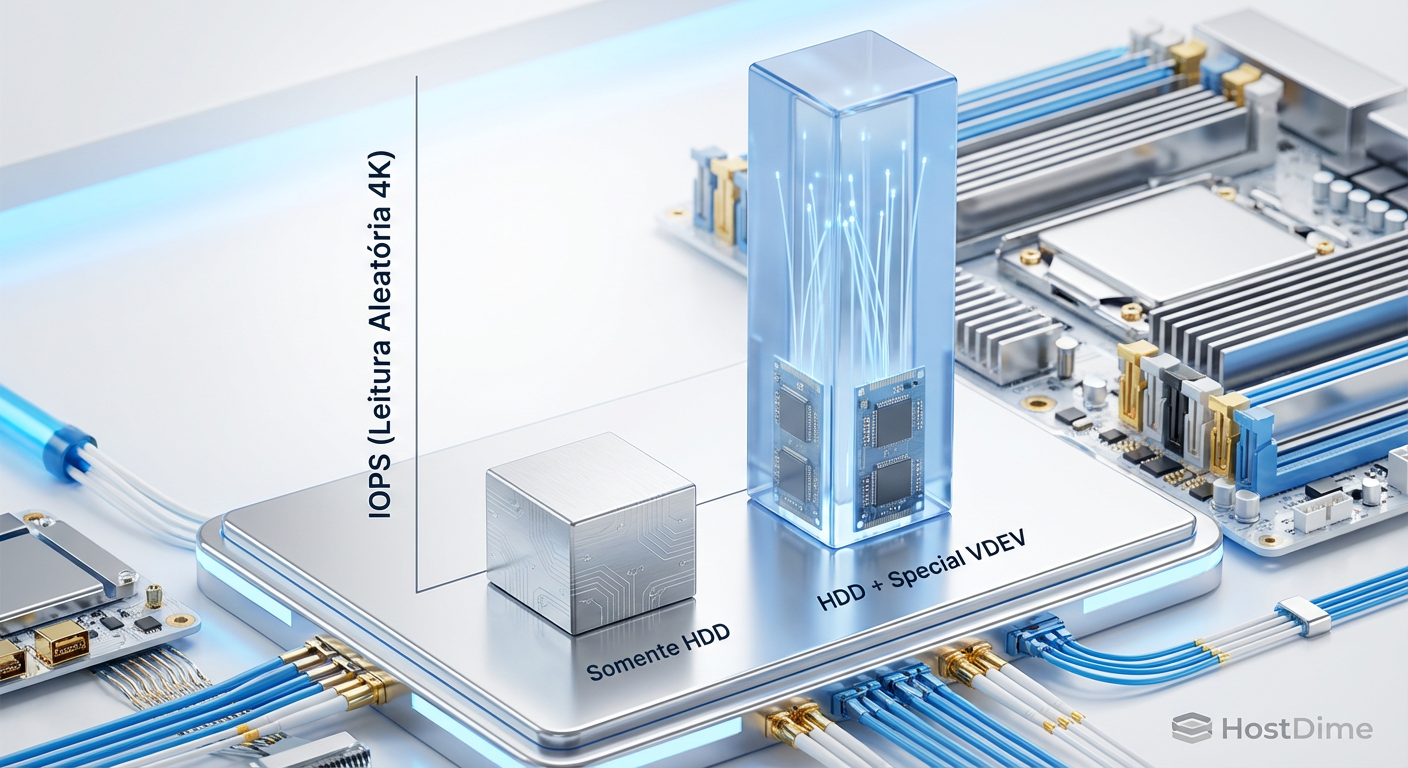

Fig. 3: Comparativo de IOPS em cargas de trabalho aleatórias (4K). A latência é drasticamente reduzida ao servir metadados via flash.

Fig. 3: Comparativo de IOPS em cargas de trabalho aleatórias (4K). A latência é drasticamente reduzida ao servir metadados via flash.

O gráfico acima demonstra a redução de latência. Em cargas de trabalho de servidor de arquivos (Samba/NFS) com muitos arquivos pequenos, a responsividade percebida pelo usuário final muda de "lenta" para "instantânea", pois o seek time mecânico foi eliminado da equação de busca.

Estratégias de recuperação e riscos de falha catastrófica

Gerenciar um pool com Special VDEVs exige disciplina operacional. A falha desses dispositivos é tratada com a mesma severidade de uma falha em um VDEV de dados principal.

Substituindo um SSD falho

Se um dos SSDs do espelho falhar, o pool entrará em estado DEGRADED, mas continuará funcionando. A substituição deve ser imediata.

Coloque o disco novo fisicamente.

Execute o comando de substituição:

zpool replace tank /dev/disk/by-id/nvme-FALHO /dev/disk/by-id/nvme-NOVO

O ZFS iniciará o resilvering (reconstrução) apenas dos metadados e blocos pequenos para o novo SSD. Como esses dispositivos são rápidos e o volume de dados costuma ser menor que o total do pool, a reconstrução é incrivelmente rápida comparada a HDDs.

Remoção do Special VDEV

Em versões modernas do OpenZFS (2.0+), é possível remover um Special VDEV apenas se o pool for composto inteiramente de espelhos (Mirrors). Se o seu pool principal utiliza RAIDZ (RAIDZ1, RAIDZ2, etc.), você não pode remover o Special VDEV. Ele é um compromisso permanente. Uma vez adicionado, a única forma de removê-lo é destruir o pool e restaurar do backup.

Portanto, valide sua configuração em um ambiente de teste ou VM antes de aplicar em produção num pool RAIDZ.

Perguntas Frequentes

P: Posso usar partições em vez de discos inteiros para o Special VDEV? R: Sim. É comum particionar dois NVMe's, usando uma partição pequena para o boot/OS, e uma partição maior para o Special VDEV. Apenas garanta que as partições estejam alinhadas corretamente.

P: O que acontece se o Special VDEV encher?

R: O ZFS é inteligente. Se o special estiver cheio, os novos metadados e blocos pequenos "transbordam" (spill over) para os HDDs normais. O sistema não para, mas a performance desses novos dados será degradada.

P: Diferença entre L2ARC e Special VDEV? R: L2ARC é cache (cópia de dados). Se falhar, nada se perde. Special VDEV é armazenamento primário. Se falhar sem redundância, o pool morre. L2ARC precisa ser "aquecido" (populado) com o uso; Special VDEV é sempre rápido desde a primeira gravação.

P: Preciso de muita memória RAM para usar Special VDEV? R: Não mais do que o normal. Na verdade, ao descarregar metadados para o SSD, você reduz a pressão sobre a ARC (cache na RAM), pois buscar metadados no SSD é rápido o suficiente para não depender tanto de mantê-los na memória RAM.

A implementação de Special VDEVs representa a modernização definitiva para arrays de armazenamento baseados em disco rígido. Ao mover a carga de trabalho aleatória para o flash, você estende a vida útil do seu hardware legado e entrega performance similar a all-flash por uma fração do custo. Monitore a saúde dos seus SSDs regularmente, pois eles agora seguram as chaves do seu reino de dados.

Roberto Lemos

Especialista em Segurança Defensiva

"Com 15 anos de experiência em Blue Team, foco no que realmente impede ataques: segmentação, imutabilidade e MFA. Sem teatro de segurança, apenas defesa real e robusta para infraestruturas críticas."