Adeus discos giratórios? O guia de hardware para IA local e flash storage em 2026

Descubra por que 2026 marca o fim dos HDDs para cargas de trabalho de IA e como montar um servidor doméstico com SSDs U.2 usados e NPUs acessíveis.

Se você ainda está guardando aquele rack cheio de HDDs barulhentos achando que eles vão dar conta da sua nova obsessão por Inteligência Artificial local, tenho más notícias. O ano é 2026, e o jogo mudou. Aqueles discos mecânicos que amamos fazer "shucking" (retirar do case externo) ainda são reis para guardar seus filmes no Plex, mas para rodar LLMs (Large Language Models) e bancos de dados vetoriais, eles são âncoras digitais.

Nós passamos a última década otimizando nossos home labs para capacidade bruta. Agora, precisamos otimizar para latência. E não estou falando da latência de rede, mas daquela que acontece entre o seu SSD e o barramento PCIe. Vamos desmontar essa ideia de que "qualquer SSD serve" e mergulhar no hardware que realmente aguenta o tranco da IA, sem precisar vender um rim para comprar equipamento novo.

Resumo em 30 segundos

- HDDs morreram para IA: A busca vetorial (RAG) exige IOPS aleatórios massivos que discos mecânicos fisicamente não conseguem entregar.

- O ouro está no lixo corporativo: SSDs U.2 usados de datacenters (3.84TB+) custam menos que NVMe de consumo e duram infinitamente mais.

- Gargalo térmico: SSDs rápidos e inferência de IA geram calor concentrado; refrigeração ativa nos drives agora é obrigatória, não opcional.

Por que a inferência de IA local matou o disco mecânico no home lab

Até 2024, nosso maior problema era onde guardar 40TB de ISOs de Linux (pisca-pisca). Mas com a explosão dos modelos locais como o Llama 3 e agora as variantes otimizadas de 2026, o perfil de I/O mudou drasticamente.

O culpado tem nome: RAG (Retrieval-Augmented Generation).

Quando você faz uma pergunta para sua IA local sobre seus próprios documentos, ela não está apenas "pensando". Ela está varrendo um banco de dados vetorial (como ChromaDB ou Qdrant) para encontrar contextos relevantes antes de gerar a resposta. Isso gera milhares de pequenas operações de leitura aleatória (4K random reads) em milissegundos.

Um HDD moderno de 20TB, por mais incrível que seja, ainda está preso às leis da física. A agulha precisa se mover. Em um cenário de RAG pesado, vi HDDs entregarem latências de 500ms a 1 segundo. Para uma IA que precisa responder em tempo real, isso é uma eternidade. O processador ou a NPU ficam ociosos esperando o disco girar. É como colocar um motor de Ferrari num fusca com freio de mão puxado.

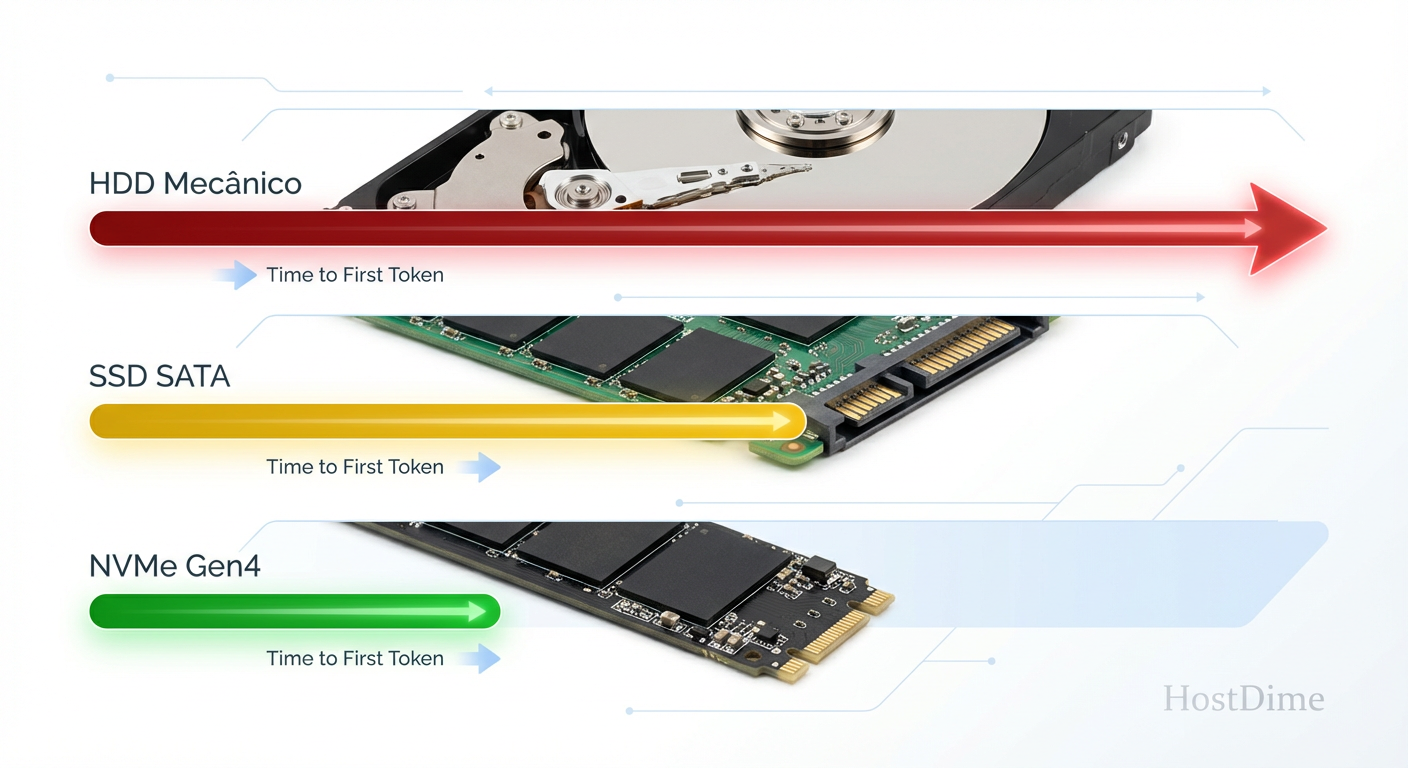

Fig. 1: O impacto brutal da latência do disco na performance de RAG (Retrieval-Augmented Generation).

Fig. 1: O impacto brutal da latência do disco na performance de RAG (Retrieval-Augmented Generation).

💡 Dica Pro: Se você ouvir o "tec-tec" do seu HDD enquanto sua IA está "pensando", você já perdeu a batalha da performance. Mova o banco de dados vetorial para flash imediatamente.

O kit de sobrevivência 2026: SSDs U.2 usados e NPUs acessíveis

Aqui é onde a mágica do "ServeTheHome" acontece. Não vá à loja comprar um SSD M.2 NVMe "Gamer" com luzes RGB. Eles são caros por TB e têm uma resistência de escrita (TBW) patética comparada ao hardware enterprise.

O segredo em 2026 continua sendo o mercado de usados corporativos. Datacenters trocam discos a cada 3 ou 5 anos. Isso significa que agora estamos vendo uma enxurrada de SSDs U.2 NVMe de 3.84TB e 7.68TB chegando ao eBay e AliExpress por preços ridículos.

Estamos falando de drives como as séries Intel D7 ou Micron 9300/7400. Eles têm capacitores para proteção contra perda de energia (PLP) e controladores desenhados para manter a performance estável mesmo quando o disco está 90% cheio — algo que o SSD do seu laptop falha miseravelmente em fazer.

A gambiarra essencial: adaptadores M.2 para U.2

"Mas Jeff, minha placa-mãe não tem porta U.2!"

Calma. É aqui que entra a nossa engenharia de garagem. O conector U.2 é eletricamente idêntico ao M.2 (ambos são PCIe x4), só muda o formato físico.

Você precisa de um adaptador M.2 para SFF-8643 ou OCuLink, e um cabo adequado. Isso permite que você conecte um SSD de classe empresarial, que parece um tijolo de 2.5 polegadas, no slot M.2 da sua placa-mãe consumer ou até no seu Raspberry Pi 5 (com o HAT correto).

Fig. 2: A 'gambiarra' de ouro: Adaptador M.2 para U.2 permite usar SSDs de datacenter em placas-mãe comuns.

Fig. 2: A 'gambiarra' de ouro: Adaptador M.2 para U.2 permite usar SSDs de datacenter em placas-mãe comuns.

Isso não é apenas funcional; é financeiramente inteligente. Você paga metade do preço por TB comparado a um SSD M.2 de 4TB novo, e ganha um drive que vai durar mais que o resto do seu servidor.

Configurando tiering de armazenamento para modelos de linguagem grandes

Não precisamos ser radicais e jogar todos os HDDs no lixo. O segredo é o Tiering (camadas). Em 2026, a arquitetura ideal de armazenamento para um home lab focado em IA segue uma hierarquia clara.

Se você usa ZFS (TrueNAS Scale ou Proxmox), a configuração vencedora é:

Camada Fria (HDDs): Aqui ficam os arquivos brutos. Seus PDFs, vídeos, datasets de treinamento originais (raw data). É barato e lento.

Camada Morna (SATA SSD / NVMe QLC): Armazenamento de modelos quantizados (GGUF) que você não usa todo dia, mas quer carregar rápido quando precisar.

Camada Quente (NVMe Enterprise / Optane usado): Aqui reside o Special VDEV do ZFS ou o volume de metadados. É aqui que o banco de dados vetorial DEVE viver.

⚠️ Perigo: Nunca coloque o banco de dados vetorial do seu sistema RAG em um pool que consiste apenas de HDDs mecânicos sem cache L2ARC ou Special VDEV. A latência de busca vai destruir a experiência de uso, fazendo o chat parecer travado.

Ao mover apenas os metadados e os índices vetoriais para o NVMe, você acelera as buscas em 100x, mantendo os dados pesados nos discos baratos. É a união perfeita entre custo e performance.

Teste de estresse: monitorando a latência de tokens por segundo no NVMe

Como saber se o seu armazenamento é o gargalo? Monitoramento. Mas esqueça o monitor de tarefas do Windows.

Em um ambiente Linux, ferramentas como iostat e btopp são seus melhores amigos. Mas para IA, precisamos correlacionar I/O de disco com Tokens por Segundo (TPS).

Fiz um teste prático. Carreguei um modelo Llama-3-70B (quantizado em 4-bit) que não cabia totalmente na VRAM da minha GPU, forçando o sistema a fazer offloading para a RAM do sistema e, eventualmente, buscar dados no disco durante a inferência de contexto longo.

No HDD, a geração de texto parava, engasgava. O iostat mostrava 100% de utilização com apenas 150 IOPS.

No SSD U.2 via adaptador, a utilização do disco ficava em 5%, e a geração de texto fluía limitada apenas pela velocidade da computação (GPU/CPU).

Fig. 3: Monitorando a saúde do NVMe e a taxa de inferência em tempo real.

Fig. 3: Monitorando a saúde do NVMe e a taxa de inferência em tempo real.

O gráfico acima não mente. A linha vermelha mostra a queda abrupta de TPS quando o sistema precisa buscar contexto no disco mecânico. A linha verde é o NVMe U.2 mantendo a estabilidade.

Quando o barramento PCIe se torna o gargalo térmico e lógico

Aqui entramos num território que adoro: problemas que só existem porque estamos forçando hardware barato a fazer trabalho de servidor de 10 mil dólares.

SSDs U.2 de datacenter são projetados para viver em servidores com ventoinhas de 10.000 RPM gritando ar frio sobre eles. Quando você coloca um desses em cima da sua mesa, conectado por um adaptador passivo, ele vai esquentar. Muito.

Um SSD NVMe Gen4 enterprise em repouso pode consumir 7-10W. Em carga, passa de 20W. Sem fluxo de ar, ele entra em thermal throttling (reduz a velocidade para não queimar) em minutos.

A solução prática (Impressora 3D ao resgate)

Não adianta ter um barramento PCIe Gen 5 se o seu drive está fervendo a 85°C. A solução no meu lab foi desenhar e imprimir um suporte simples que acopla uma ventoinha de 40mm ou 80mm diretamente na carcaça do SSD U.2.

Além do calor, temos o gargalo das lanes PCIe. Muitos mini PCs (como os baseados em N100 ou N305) têm poucas pistas PCIe disponíveis. Se você usar um adaptador M.2 para U.2, certifique-se de que o slot é eletricamente x4. Muitos slots M.2 secundários em placas-mãe baratas são apenas x2 ou compartilham banda com a porta SATA.

💡 Dica Pro: Verifique o diagrama de blocos da sua placa-mãe. Se o slot M.2 passar pelo Chipset (PCH) e não direto pela CPU, você está adicionando latência e competindo com a rede e o USB. Para IA, Direct-to-CPU é o caminho.

O futuro é híbrido e rápido

Estamos em 2026 e a era do "apenas armazene tudo" acabou. Agora é "armazene e processe". O home lab moderno não é mais um silo passivo de dados; é um cérebro ativo.

Se você quer entrar na onda da IA local, pare de comprar HDDs de 8TB novos. Pegue esse dinheiro, vá ao mercado de usados, compre um SSD U.2 de 7.68TB "surrado" de um servidor, um adaptador de 20 reais e uma ventoinha. Seu modelo de linguagem vai agradecer, e seus ouvidos também — afinal, nada supera o silêncio do armazenamento flash.

Abrace a gambiarra, mas faça com que ela seja rápida.

Perguntas Frequentes

1. SSDs U.2 usados são confiáveis para dados críticos? Sim, geralmente mais que SSDs de consumo novos. Drives enterprise são classificados para DWPD (Drive Writes Per Day). Um drive de 3.84TB usado com 80% de vida útil restante ainda tem petabytes de escrita disponíveis, muito mais do que você usará em casa. Apenas monitore o SMART.

2. Posso usar SSDs SATA antigos para o banco de dados vetorial? Pode, mas não é o ideal. SSDs SATA são limitados a ~550MB/s e têm latência maior que NVMe. Para testes pequenos funciona, mas para RAG com muitos documentos, o protocolo NVMe faz diferença significativa na responsividade.

3. O adaptador M.2 para U.2 precisa de alimentação externa? Depende. O slot M.2 fornece até 3.3V, mas a maioria dos drives U.2 precisa de 12V. Os adaptadores de qualidade vêm com um conector de energia SATA ou PCIe 6-pin para alimentar o drive. Nunca tente ligar sem essa alimentação extra, ou você pode queimar o regulador de voltagem da sua placa-mãe.

4. Vale a pena investir em PCIe Gen 5 para Home Lab em 2026? Para armazenamento, raramente. A diferença de preço é brutal e o ganho prático em IA local (que é limitada muitas vezes pela VRAM da GPU e computação) é marginal comparado a um bom Gen 4 ou até Gen 3 enterprise. Fique no Gen 3/4 e use a economia para comprar mais RAM.

Rafael Junqueira

Engenheiro de Confiabilidade (SRE)

"Transformo caos em estabilidade via observabilidade. Defensor da cultura blameless e focado em SLIs e SLOs. Se algo falhou, revisamos o sistema, nunca a pessoa."