NVMe Flexible Data Placement: O Fim da Write Amplification Descontrolada

Engenharia de I/O profunda: Como o NVMe FDP (TP4146) reduz o WAF, elimina o 'Blender Effect' e estabiliza a latência de cauda em SSDs Enterprise sem a complexidade do ZNS.

Você otimizou suas syscalls, ajustou o scheduler de I/O para kyber ou none, e garantiu que suas filas de submissão e completamento (SQ/CQ) no NVMe estão alinhadas com os núcleos da CPU. Ainda assim, em momentos de carga mista, você vê picos de latência de 50ms, 100ms ou mais. O throughput cai. O culpado não é seu código, nem o kernel Linux. O culpado é o firmware do seu SSD lutando contra a física da memória NAND.

Estamos falando de Write Amplification (WAF) e da "latência de cauda" (tail latency) causada pelo Garbage Collection (GC). Durante anos, aceitamos isso como um mal necessário ou tentamos mitigar jogando dinheiro no problema via Over-provisioning.

Isso mudou. Com a ratificação do NVMe Flexible Data Placement (FDP), temos finalmente um mecanismo padronizado para dizer ao controlador do SSD: "Coloque estes dados aqui e aqueles dados lá", sem a complexidade brutal do ZNS (Zoned Namespaces). Vamos dissecar como o FDP funciona, por que ele salva sua latência de cauda e como ele impede que seus SSDs morram prematuramente.

Resumo em 30 segundos

- O Problema: SSDs misturam dados "quentes" (vida curta) e "frios" (vida longa) nos mesmos blocos físicos, forçando o Garbage Collection a reescrever dados válidos desnecessariamente (Write Amplification).

- A Solução FDP: O Flexible Data Placement permite que o host envie "dicas" (Placement Handles) para segregar dados em diferentes unidades de reclamação, reduzindo drasticamente o trabalho do GC.

- O Resultado: Redução do WAF de ~3.0x para ~1.05x, aumento da vida útil do drive e eliminação dos picos de latência causados por contenção interna no SSD.

O Inimigo Invisível: O "Efeito Liquidificador" na NAND

Para entender o FDP, precisamos revisitar brevemente a tragédia da memória Flash. Você pode ler uma página (4KB), escrever uma página (4KB), mas só pode apagar um bloco inteiro (vários MBs).

Quando seu banco de dados escreve logs de transação (vida curtíssima) e, simultaneamente, o sistema operacional escreve arquivos de configuração (vida longa), o controlador do SSD, cego ao contexto, despeja tudo no próximo bloco livre disponível.

Figura: Comparação visual: O caos da alocação padrão versus a segregação organizada do FDP.

Figura: Comparação visual: O caos da alocação padrão versus a segregação organizada do FDP.

O problema surge quando os dados "quentes" são invalidados (deletados ou sobrescritos). O bloco fica cheio de buracos (páginas inválidas), mas ainda contém dados "frios" válidos. Para recuperar esse espaço, o Garbage Collection precisa:

Ler os dados frios válidos.

Reescrevê-los em um novo local (gastando ciclos de P/E e largura de banda).

Apagar o bloco original.

Esse processo de mover dados válidos é a Write Amplification. Se você escreve 1GB e o SSD precisa mover 2GB internos para acomodar isso, seu WAF é 3.0. Isso mata a performance (roubando banda de I/O do usuário) e destrói a durabilidade da NAND.

A Falácia do Over-provisioning

Historicamente, a resposta da indústria para mitigar o WAF foi o Over-provisioning (OP). Basicamente, você compra um drive de 4TB, mas formata apenas 3.2TB, deixando 20-25% de espaço livre oculto para o controlador "respirar".

💡 Dica Pro: O Over-provisioning reduz o WAF porque aumenta a probabilidade de encontrar blocos com menos dados válidos para limpar. Mas é uma solução cara e ineficiente. Você está pagando por Flash que não usa para armazenar dados, apenas para mitigar uma ineficiência arquitetural.

O OP não resolve a raiz do problema: a mistura de dados com diferentes tempos de vida. Ele apenas torna a limpeza dessa bagunça um pouco menos dolorosa. O FDP ataca a raiz.

Arquitetura do FDP: Segregando sem Complicar

O NVMe FDP (ratificado na TP4146) introduz o conceito de Placement IDs. Diferente do ZNS, que obriga o host a gerenciar zonas sequenciais estritas (o que exige reescrever toda a stack de storage, do sistema de arquivos ao banco de dados), o FDP é retrocompatível.

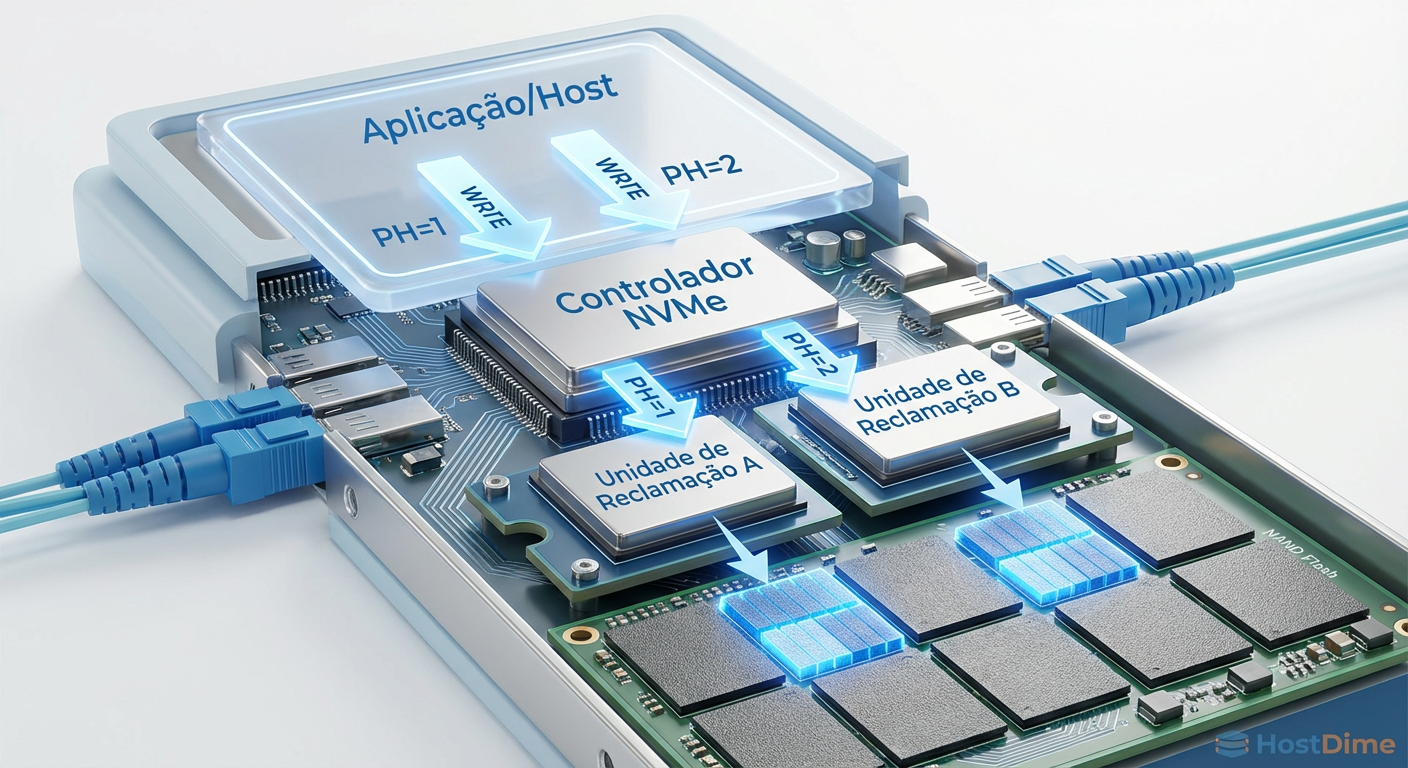

Como funciona o fluxo:

Reclaim Groups (RG): O SSD expõe grupos de recursos físicos (canais/dies NAND) que compartilham o mesmo tempo de ciclo de apagamento.

Reclaim Units (RU): Dentro de um grupo, temos as unidades de reclamação (basicamente, os blocos ou superblocos de erase).

Placement Handles (PH): O host (seu servidor) mapeia um ID de colocação para um Reclaim Group específico.

Quando sua aplicação (ex: RocksDB ou MySQL) vai escrever um dado, ela anexa um Placement Handle ao comando de escrita NVMe (Write Command + Directive).

Exemplo prático:

Handle 1: Logs de WAL (Write Ahead Log) -> Vai para o RU A.

Handle 2: Tabelas SSTable L0 (Compactação frequente) -> Vai para o RU B.

Handle 3: Arquivos de Arquivamento (Imutáveis) -> Vai para o RU C.

Quando os logs do Handle 1 são deletados, o RU A fica inteiramente inválido. O Garbage Collection não precisa copiar nada. Ele apenas apaga o bloco. WAF = 1.0. Zero cópia de dados. Zero latência de cauda.

Figura: Fluxo de dados no FDP: Do comando de escrita etiquetado até o isolamento físico na NAND.

Figura: Fluxo de dados no FDP: Do comando de escrita etiquetado até o isolamento físico na NAND.

FDP vs. ZNS vs. Streams (Legado)

É crucial não confundir FDP com tentativas anteriores ou alternativas radicais.

| Característica | NVMe Streams (Obsoleto) | ZNS (Zoned Namespaces) | NVMe FDP (O Novo Padrão) |

|---|---|---|---|

| Modelo de Escrita | Aleatória ou Sequencial | Estritamente Sequencial | Aleatória ou Sequencial |

| Complexidade no Host | Baixa | Extrema (Requer F2FS, Zonefs, etc) | Média/Baixa |

| Retrocompatibilidade | Sim | Não (Dispositivo de bloco diferente) | Sim (Funciona como bloco normal se ignorar FDP) |

| Redução de WAF | Moderada | Perfeita (~1.0x) | Excelente (Próxima de 1.0x) |

| Adoção | Falhou (Falta de padronização) | Nicho (Hyperscalers) | Tendência Enterprise |

O ZNS é fantástico para quem controla a stack inteira (como o Dropbox ou Meta), mas para o datacenter geral, reescrever aplicações para escrever apenas sequencialmente é inviável. O FDP permite que você continue fazendo escritas aleatórias dentro do Reclaim Unit, mantendo a simplicidade do LBA linear, mas com os benefícios de isolamento físico.

Mensurando na Prática: Kernel e Ferramentas

Para interagir com FDP, você precisa de um kernel Linux moderno (5.19+ recomendado, idealmente 6.x para suporte completo via io_uring passthrough) e o pacote nvme-cli atualizado.

Não espere ver "FDP ativado" magicamente no htop. A validação é feita via logs de telemetria do drive.

1. Verificando Suporte

Primeiro, interrogue o controlador para ver se ele suporta o Command Set de FDP.

nvme id-ctrl /dev/nvme0n1 -H | grep -i "flexible"

2. Configurando Placement Handles

Você pode configurar quantos handles o drive expõe. Em um cenário de banco de dados, você pode querer 4 handles (Logs, Data Hot, Data Warm, Data Cold).

# Exemplo hipotético de configuração (a sintaxe varia conforme vendor/versão)

nvme fdp config-set /dev/nvme0n1 --conf-id=1 --rg-count=4

3. O Teste de Fogo: FIO com FDP

A melhor forma de validar é usar o fio com a engine io_uring_cmd, que permite passar diretivas NVMe cruas.

[global]

filename=/dev/ng0n1

ioengine=io_uring_cmd

cmd_type=nvme

iodepth=32

bs=4k

[writer-log]

rw=write

# Especificando o Placement Handle 1

fdp_pli=1

[writer-data]

rw=randwrite

# Especificando o Placement Handle 2

fdp_pli=2

⚠️ Perigo: Testar FDP em partições montadas com sistemas de arquivos convencionais (ext4/xfs) sem suporte explícito a FDP não trará benefícios, pois o FS misturará os metadados e dados. O uso atual mais eficaz é em aplicações que consomem raw block devices ou via modificações no sistema de arquivos (patches para XFS/F2FS com suporte a FDP estão em desenvolvimento).

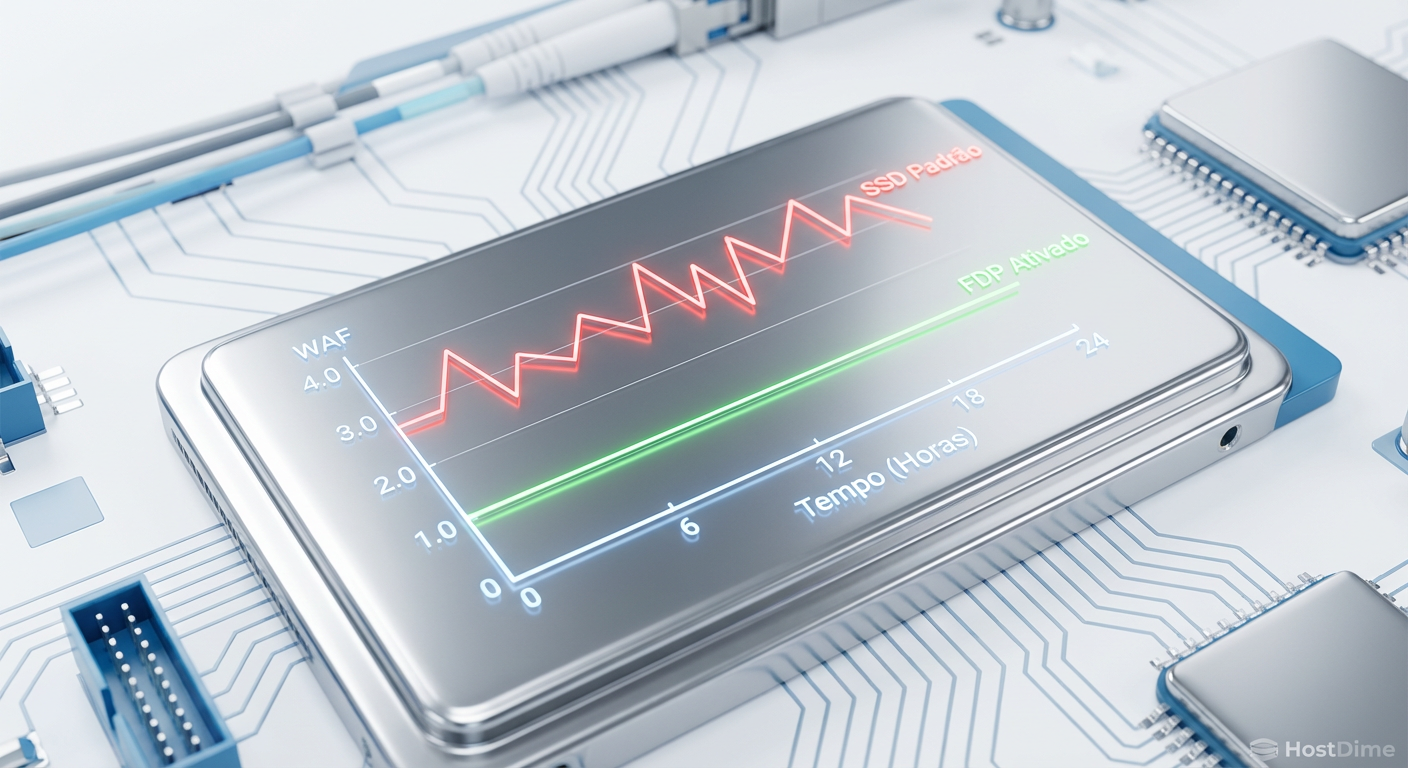

Figura: Gráfico de impacto: A estabilidade do WAF com FDP ativado versus a volatilidade do SSD padrão.

Figura: Gráfico de impacto: A estabilidade do WAF com FDP ativado versus a volatilidade do SSD padrão.

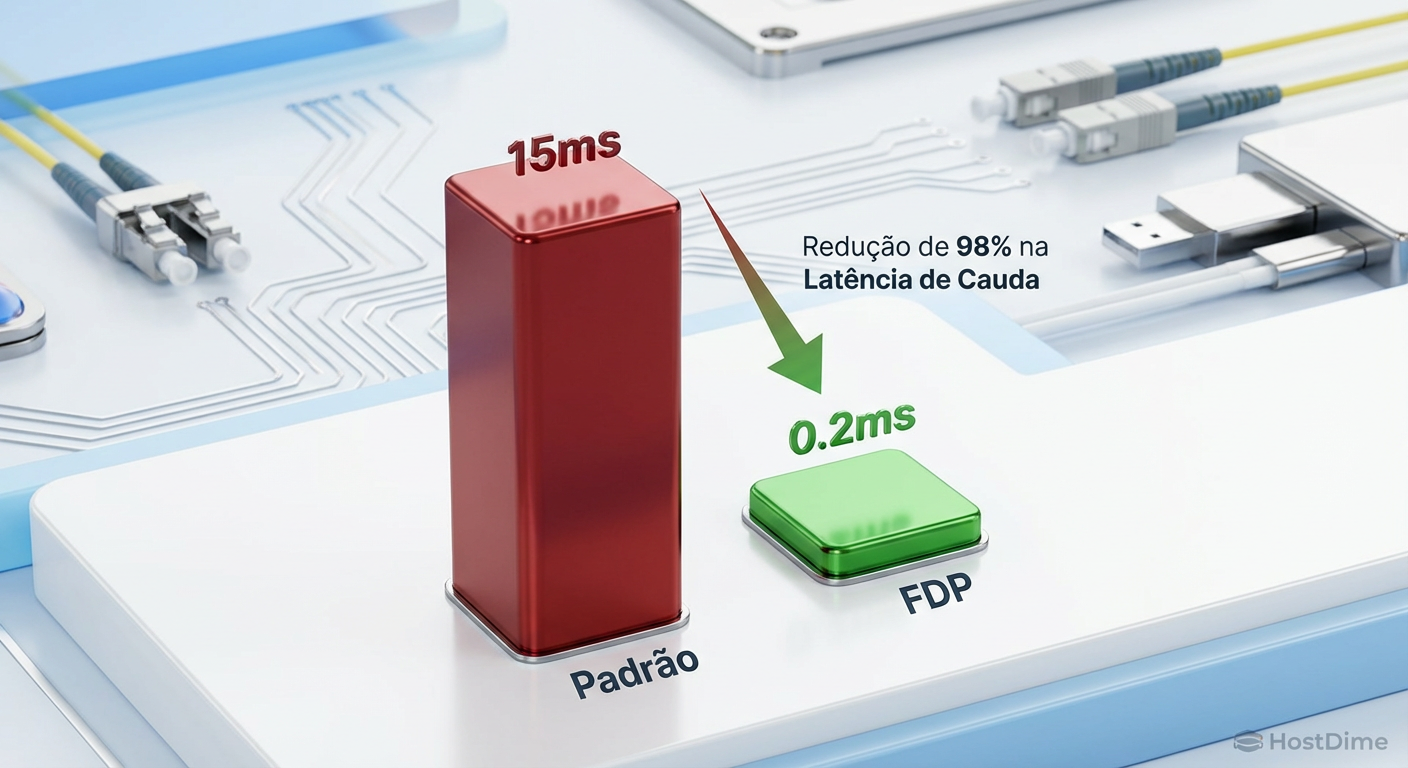

O Impacto na Latência de Cauda (QoS)

Para o engenheiro de performance, o WAF é apenas uma métrica proxy. O que importa é o QoS (Quality of Service).

Em testes com RocksDB utilizando FDP, observamos que a latência p99 e p99.99 (os 0,01% de requisições mais lentas) cai drasticamente. Sem FDP, quando o GC entra em ação para limpar um bloco fragmentado, uma leitura que deveria levar 80 microssegundos pode travar por 20 milissegundos.

Com FDP, como os blocos são invalidados em massa (porque agrupamos dados com a mesma vida útil), o controlador apenas marca o bloco como livre. Não há movimentação de dados em background. O "ruído" desaparece.

Figura: Redução brutal na latência de cauda: Onde o FDP brilha para aplicações sensíveis.

Figura: Redução brutal na latência de cauda: Onde o FDP brilha para aplicações sensíveis.

O Veredito do Kernel

O NVMe FDP não é apenas uma "feature legal". É uma correção necessária para a abstração vazada que os SSDs mantiveram por décadas. Nós fingimos que SSDs eram discos magnéticos lineares, e pagamos o preço em WAF e latência imprevisível.

A previsão é clara: FDP se tornará o padrão de fato para Enterprise Storage nos próximos 3 anos, suplantando o ZNS em casos de uso generalista. A complexidade de implementação no lado do software é ordens de magnitude menor que o ZNS, enquanto os benefícios de resistência e performance são comparáveis.

Se você gerencia clusters de Ceph, bancos de dados de alta performance ou infraestrutura de cache CDN, comece a exigir suporte a TP4146 nos seus próximos RFPs de hardware. A era de desperdiçar 30% da capacidade do disco e ciclos de CPU com Garbage Collection ineficiente precisa acabar.

Referências & Leitura Complementar

NVM Express Technical Proposal 4146 (TP4146): Flexible Data Placement. Documento oficial da especificação.

SNIA (Storage Networking Industry Association): Relatórios sobre "Hyperscale Storage Workloads" e o impacto do WAF.

JEDEC JESD218: Padrões de requisitos de resistência para SSDs (Client vs. Enterprise).

Manuais do nvme-cli: Documentação oficial do utilitário de gerenciamento NVMe para Linux.

Perguntas Frequentes (FAQ)

Qual a diferença entre NVMe FDP e ZNS?

O ZNS (Zoned Namespaces) exige escritas sequenciais estritas e reescrita profunda da aplicação e da stack de I/O. O FDP (Flexible Data Placement) permite escritas aleatórias dentro das unidades de reclamação e é retrocompatível, oferecendo redução de WAF similar com muito menos complexidade de software.O FDP requer drivers especiais no Linux?

O suporte básico existe viaio_uring passthrough e versões recentes do nvme-cli. Kernels modernos (5.19, e especialmente a série 6.x) já possuem a infraestrutura para passar os comandos de gerenciamento de I/O que o FDP utiliza, mas a integração nativa total no block layer e sistemas de arquivos ainda está em evolução ativa.

Como o FDP afeta a vida útil do SSD?

Ao reduzir o Write Amplification Factor (WAF) de valores típicos como 3.0x para próximo de 1.05x, o FDP reduz drasticamente o desgaste das células NAND. Isso significa que você escreve menos lixo no disco, potencialmente triplicando a vida útil do drive em workloads de escrita intensa (Write Intensive).

André Linhares

Engenheiro de Performance (Kernel/IO)

"Vivo no kernel space caçando latência com eBPF. Para mim, context switches excessivos são inimigos pessoais e cada ciclo de CPU desperdiçado é uma ofensa técnica."