Sobrevivendo à densidade: engenharia de confiabilidade para SSDs QLC

Descubra como mitigar a latência de cauda e a amplificação de escrita (WAF) em SSDs QLC usando Flexible Data Placement (FDP) e estratégias de SRE.

A migração para SSDs QLC (Quad-Level Cell) em datacenters não é apenas uma decisão de compras baseada em custo por terabyte; é uma mudança arquitetural que altera fundamentalmente o comportamento da camada de persistência. Para um Engenheiro de Confiabilidade (SRE), tratar um drive QLC como um mero "drop-in replacement" de um TLC (Triple-Level Cell) é a receita perfeita para esgotar seu error budget antes do fim do trimestre.

A densidade traz complexidade. Quando empilhamos 4 bits por célula, reduzimos a janela de tensão para leitura e escrita, o que exige algoritmos de correção de erro (ECC) mais pesados e, crucialmente, altera a física da gravação. O desafio não é que o QLC seja "pior", mas que ele expõe abstrações que antes ignorávamos com impunidade no mundo SLC/MLC.

Resumo em 30 segundos

- A falácia da substituição direta: Trocar SSDs TLC por QLC sem ajustar a camada de software (sistema de arquivos/banco de dados) resulta em latência de cauda (p99) imprevisível e desgaste prematuro.

- O problema da Unidade de Indireção (IU): SSDs QLC modernos operam com unidades de escrita interna de 16KB a 64KB. Escritas de 4KB do SO causam uma amplificação de escrita (WAF) massiva, matando a performance.

- A solução via FDP: O Flexible Data Placement (NVMe TP4146) é a ferramenta de engenharia que permite ao host alinhar os dados à geometria do disco, reduzindo o WAF e estabilizando a latência sem a complexidade do ZNS.

O colapso do Error Budget: Latência de cauda e consistência

Em sistemas distribuídos de armazenamento, a latência média é uma métrica de vaidade. O que acorda o engenheiro de plantão às 3 da manhã é a latência de cauda — o p99 ou p99.9.

Drives QLC Enterprise (como as séries Solidigm D5 ou Micron 6500 ION) possuem grandes caches SLC dinâmicos para absorver bursts de escrita. Enquanto você escreve dentro desse cache, a performance é estelar. O problema de confiabilidade surge quando o cache enche ou quando o drive entra em estado de Garbage Collection (GC) forçado.

Diferente do TLC, o processo de programação de células QLC é significativamente mais lento. Se o seu workload satura o buffer, a latência de I/O pode saltar de sub-milissegundos para dezenas de milissegundos. Em um cluster Ceph ou vSAN, se um único drive entra nesse estado de "latência de sufocamento", ele pode ser marcado como falho pelo monitoramento de heartbeat, desencadeando uma reconstrução de dados desnecessária que, por sua vez, satura outros discos. É o efeito cascata clássico.

⚠️ Perigo: Monitorar apenas a latência média (avg) em QLC esconde os picos de latência causados por compactação de fundo. Configure alertas específicos para latência p99 acima de 50ms em janelas de 1 minuto.

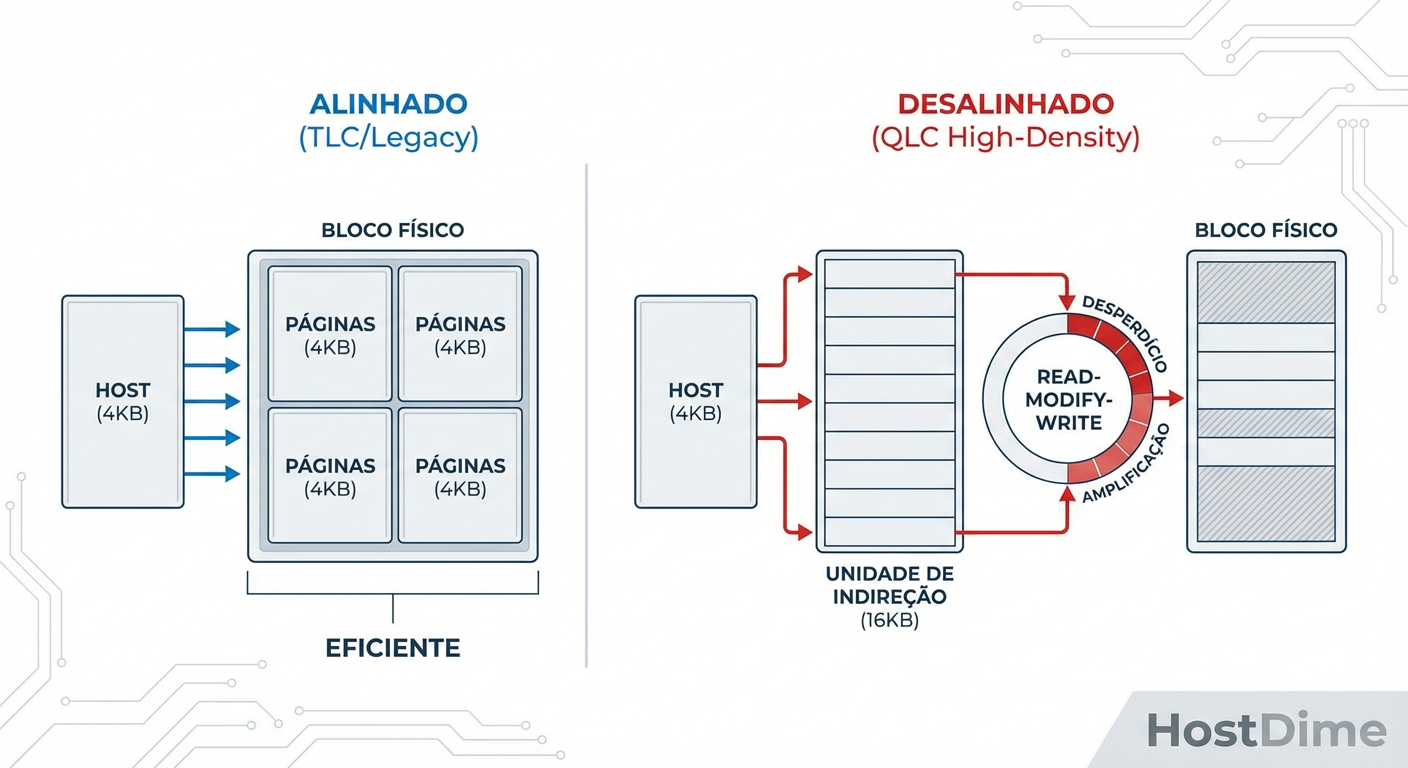

A física da Amplificação de Escrita: O problema da Unidade de Indireção (IU)

Para entender por que seus SSDs QLC estão morrendo rápido ou ficando lentos, precisamos descer ao nível do firmware. Historicamente, assumimos que a página física do NAND e a unidade lógica do setor eram alinhadas ou gerenciáveis (4KB).

No universo QLC de alta densidade, para manter a eficiência das tabelas de mapeamento (L2P - Logical to Physical) e reduzir a sobrecarga de DRAM no controlador do SSD, os fabricantes aumentaram a Unidade de Indireção (IU). Enquanto seu sistema de arquivos (ext4, XFS) e seu banco de dados (MySQL, PostgreSQL) continuam obcecados por páginas de 4KB, o SSD QLC pode estar operando internamente com uma IU de 16KB, 32KB ou até 64KB.

O cenário de desastre (Read-Modify-Write)

Quando o host envia uma escrita aleatória de 4KB em um drive com IU de 16KB:

O controlador precisa ler os 16KB inteiros da NAND para o buffer.

Ele modifica os 4KB solicitados.

Ele grava os novos 16KB em uma nova localização.

Isso gera um Write Amplification Factor (WAF) imediato de 4x apenas na camada de tradução, sem contar o Garbage Collection posterior. Se o seu workload é randômico (comum em virtualização e bancos de dados OLTP), você está efetivamente reduzindo a vida útil do drive em 4 a 16 vezes e aumentando a latência de escrita proporcionalmente.

Figura: O impacto do desalinhamento da Unidade de Indireção (IU): uma escrita de 4KB força a movimentação de 16KB ou mais em SSDs QLC modernos.

Figura: O impacto do desalinhamento da Unidade de Indireção (IU): uma escrita de 4KB força a movimentação de 16KB ou mais em SSDs QLC modernos.

Engenharia de Solução: Flexible Data Placement (FDP)

Como SREs, não podemos mudar a física do NAND, mas podemos mudar como o software interage com ele. A resposta da indústria para domar o QLC sem a complexidade proibitiva do ZNS (Zoned Namespaces) é o Flexible Data Placement (FDP), ratificado no TP4146 do padrão NVMe.

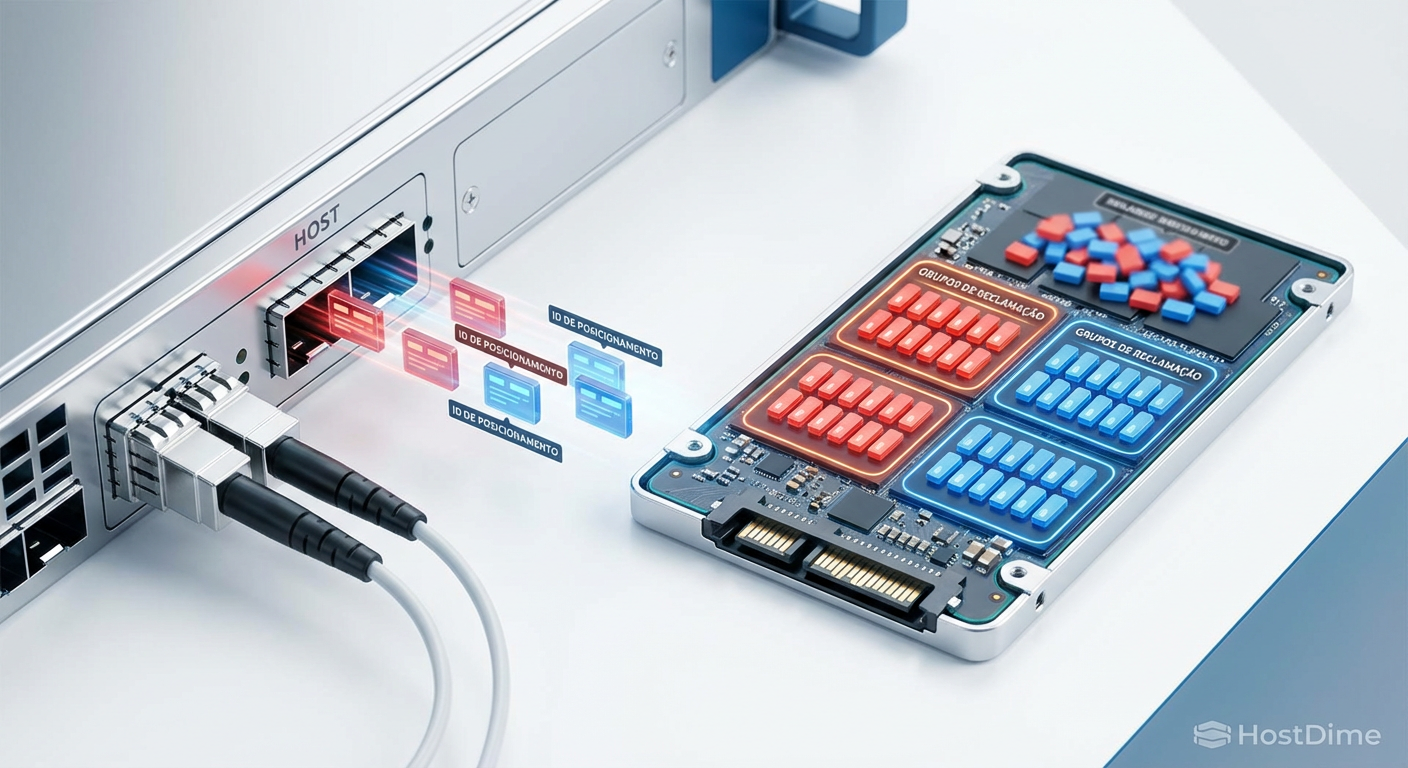

O ZNS exigia que o software de host gerenciasse explicitamente as zonas de escrita sequencial, o que obrigava a reescrita de storage engines inteiros (como o RocksDB ZenFS). O FDP é mais pragmático. Ele permite que o host envie "dicas" (Placement IDs) junto com os comandos de escrita.

Como o FDP salva o QLC

Com o FDP, o host informa ao SSD: "Estes dados pertencem ao Objeto A (ex: Journal do DB) e estes ao Objeto B (ex: Tabelas de Dados)". O SSD então garante que esses dados sejam gravados em Reclaim Groups (superblocos físicos) diferentes.

Quando o Objeto A é deletado ou atualizado, ele invalida um bloco inteiro de uma vez. O SSD pode apagar esse bloco sem precisar copiar dados válidos de outros objetos misturados (reduzindo a cópia interna do Garbage Collection).

💡 Dica Pro: Habilitar FDP em ambientes Linux modernos (Kernel 6.2+) com SSDs compatíveis pode reduzir o WAF de um workload aleatório de 3.5x para algo próximo de 1.1x. Isso triplica a vida útil efetiva do drive QLC.

Tabela Comparativa: Estratégias de Gestão de NAND

| Característica | Legado (Block Device) | ZNS (Zoned Namespaces) | FDP (Flexible Data Placement) |

|---|---|---|---|

| Complexidade de Adoção | Nula (Nativo) | Alta (Requer refatoração de SW) | Média (Requer suporte a dicas) |

| Controle de Posicionamento | Nenhum (Caixa preta) | Total (Host controla tudo) | Colaborativo (Host sugere, SSD executa) |

| Redução de WAF | Baixa (Depende de sorte/OP) | Máxima (WAF ~1) | Alta (WAF próximo de 1) |

| Compatibilidade QLC | Ruim (Alto desgaste/latência) | Excelente | Excelente |

| Caso de Uso Ideal | Boot, Logs simples | Hyperscale, Custom DBs | Enterprise Storage, Virtualização |

Figura: Flexible Data Placement em ação: segregando dados por temperatura e ciclo de vida para minimizar o trabalho do Garbage Collector.

Figura: Flexible Data Placement em ação: segregando dados por temperatura e ciclo de vida para minimizar o trabalho do Garbage Collector.

Observabilidade: O que você não mede, você quebra

Em um ambiente de alta densidade com QLC, as métricas padrão do iostat são insuficientes. Um disco pode parecer ocioso (baixo IOPS) mas estar internamente saturado por tarefas de manutenção.

Para garantir a confiabilidade, sua stack de monitoramento (Prometheus/Grafana) deve extrair dados via nvme-cli ou telemetria avançada do fornecedor (OCP Datacenter NVMe Spec).

Métricas de Ouro para QLC:

WAF Interno (Host Writes vs. NAND Writes): Se a razão entre o que você escreve e o que o disco grava na flash for maior que 2.5 em um drive QLC, você tem um problema de alinhamento ou fragmentação severa.

- Comando de debug:

nvme smart-log /dev/nvme0n1(Comparedata_units_writtencom as escritas internas do vendor log).

- Comando de debug:

Uso do Cache SLC: Monitore a saturação do buffer SLC. Se o buffer estiver constantemente cheio, o drive será forçado a escrever diretamente na QLC (modo direct-to-die), o que derruba a performance para níveis de HDD mecânico (80-160 MB/s).

Latência de Cauda por Tamanho de I/O: Diferencie a latência de escritas pequenas (4KB) das grandes (128KB+). Em QLC, escritas pequenas desalinhadas são as vilãs da latência.

Alinhando a infraestrutura ao futuro

A indústria de armazenamento está caminhando para uma bifurcação. De um lado, memória de classe de armazenamento (SCM/Optane/XL-Flash) para latência ultra-baixa; do outro, QLC e futuramente PLC (Penta-Level Cell) para capacidade massiva. O "meio termo" do TLC genérico está encolhendo.

Para o SRE, isso significa que a era do "disco burro" acabou. Não podemos mais tratar o armazenamento como uma caixa preta infinita e rápida. A confiabilidade agora depende de consciência de geometria.

A sobrevivência à densidade exige que paremos de lutar contra a física do dispositivo. Adotar tecnologias como FDP, ajustar tamanhos de bloco de sistema de arquivos para múltiplos da IU (ex: formatar XFS com sw=4 ou sw=16 dependendo da IU) e revisar as configurações de compactação em bancos de dados (como RocksDB ou Cassandra) são passos obrigatórios.

Se você ignorar a natureza do QLC, ele não falhará silenciosamente; ele falhará ruidosamente, levando consigo a performance da sua aplicação e a sanidade da sua equipe de on-call. A densidade é inevitável, mas a degradação de serviço é opcional.

Referências & Leitura Complementar

NVM Express Technical Proposal 4146 (TP4146): Flexible Data Placement. Disponível em nvmexpress.org.

OCP Hyperscale Storage Datacenter NVMe SSD Specification: Detalhes sobre requisitos de telemetria e latência para SSDs em datacenter.

SNIA (Storage Networking Industry Association): "Real World Workloads and the Impact on SSD Architecture" (Whitepapers técnicos sobre WAF).

JEDEC JESD218: Padrão para requisitos de resistência e métodos de teste para SSDs (Client e Enterprise).

FAQ: Perguntas Frequentes sobre QLC e Confiabilidade

O que é o problema da Unidade de Indireção (IU) em SSDs QLC?

É o desalinhamento crítico entre as escritas típicas do sistema operacional (geralmente páginas de 4KB) e a menor unidade de escrita granular do SSD QLC (frequentemente 16KB, 32KB ou 64KB). Isso força o SSD a ler, modificar e regravar blocos maiores para cada pequena alteração, causando severa amplificação de escrita e latência.Como o Flexible Data Placement (FDP) melhora a vida útil do SSD?

O FDP permite que o host (SO ou aplicação) indique ao SSD quais dados possuem ciclos de vida semelhantes e devem ser agrupados no mesmo bloco físico (Reclaim Group). Isso reduz drasticamente a mistura de dados "quentes" e "frios", diminuindo a necessidade de Garbage Collection interno e baixando o WAF (Write Amplification Factor) para níveis próximos de 1.Qual a diferença entre ZNS e FDP?

O ZNS (Zoned Namespaces) impõe uma restrição rígida de escrita sequencial, exigindo que o software de host gerencie zonas e proíba sobrescritas aleatórias, o que demanda grandes refatorações no código. O FDP (Flexible Data Placement) mantém a compatibilidade com escritas aleatórias, mas usa "dicas" de posicionamento para otimizar a organização interna, sendo muito mais fácil de adotar em sistemas existentes.

Rafael Junqueira

Engenheiro de Confiabilidade (SRE)

"Transformo caos em estabilidade via observabilidade. Defensor da cultura blameless e focado em SLIs e SLOs. Se algo falhou, revisamos o sistema, nunca a pessoa."