SSDs QLC de 61TB vs HDDs HAMR: O fim da era magnética no data center?

Análise técnica detalhada: Como os novos SSDs QLC de ultra densidade (61.44TB+) estão dizimando o TCO dos HDDs em cenários de IA e Big Data. Comparativo de arquitetura, consumo e performance.

A batalha pela supremacia do armazenamento no data center atingiu um ponto de inflexão crítico. Durante décadas, a lógica foi imutável: SSDs para performance, HDDs para capacidade e custo. Essa fronteira, no entanto, está sendo apagada com uma agressividade que poucos previam. A chegada dos SSDs QLC (Quad-Level Cell) de ultra densidade, liderados pelo Solidigm D5-P5336 de 61,44TB, coloca em xeque a viabilidade a longo prazo dos discos mecânicos, mesmo com a tão aguardada tecnologia HAMR (Heat-Assisted Magnetic Recording) da Seagate e Western Digital finalmente chegando ao mercado.

Não estamos falando apenas de velocidade. Estamos falando de uma reestruturação completa da economia do rack. Quando um único drive NVMe de 2,5 polegadas armazena o dobro de dados que o maior HDD de 3,5 polegadas disponível, as métricas de TCO (Custo Total de Propriedade), consumo de energia por petabyte e densidade física precisam ser recalculadas do zero.

Resumo em 30 segundos

- Densidade Brutal: Um SSD Solidigm D5-P5336 de 61TB substitui fisicamente dois a três HDDs de última geração, economizando espaço crítico no rack.

- O Fator Energia: Embora o SSD custe mais na compra (CapEx), ele consome significativamente menos watts por TB, tornando o TCO favorável em 3 a 5 anos.

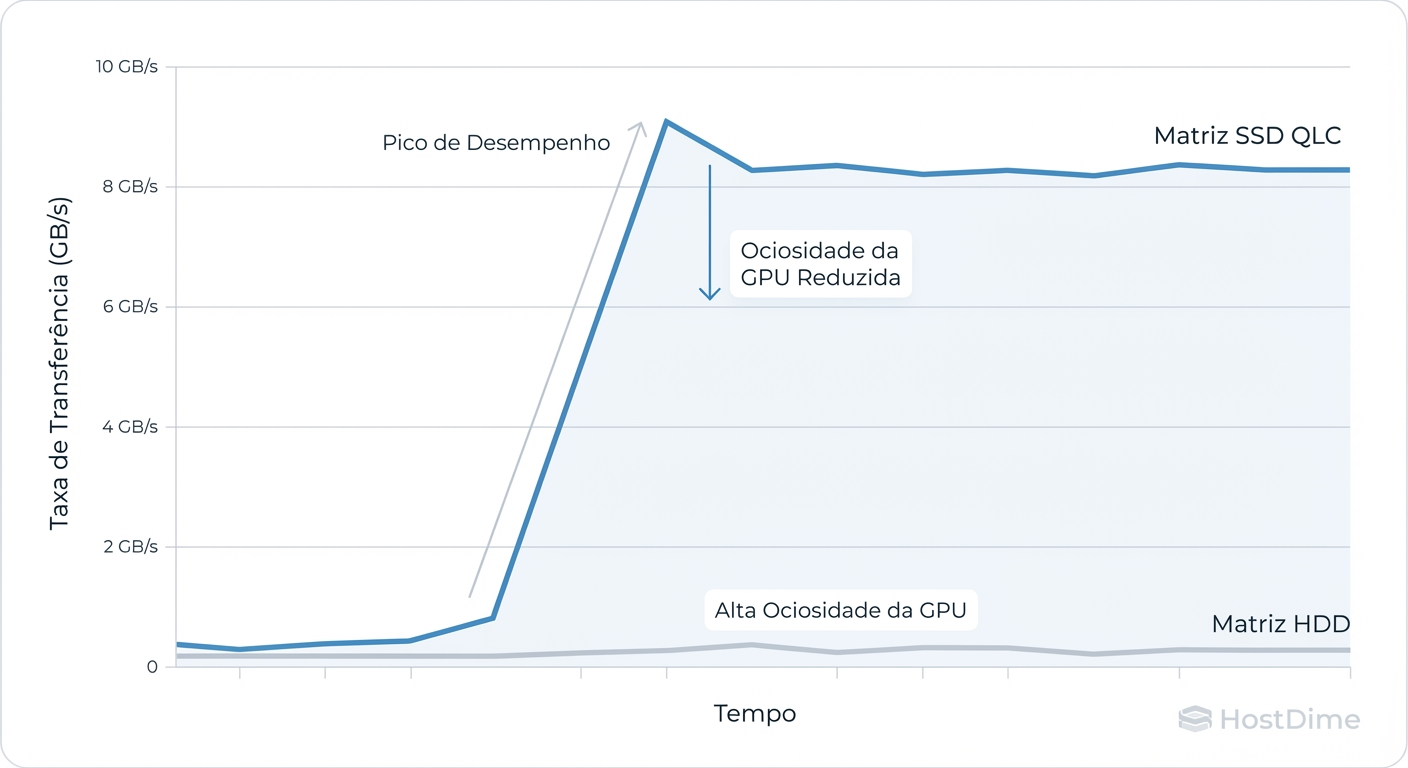

- Gargalo de IA: Para data lakes de Inteligência Artificial, os HDDs não conseguem mais entregar os dados rápido o suficiente para manter GPUs H100/B200 alimentadas, forçando a migração para All-Flash.

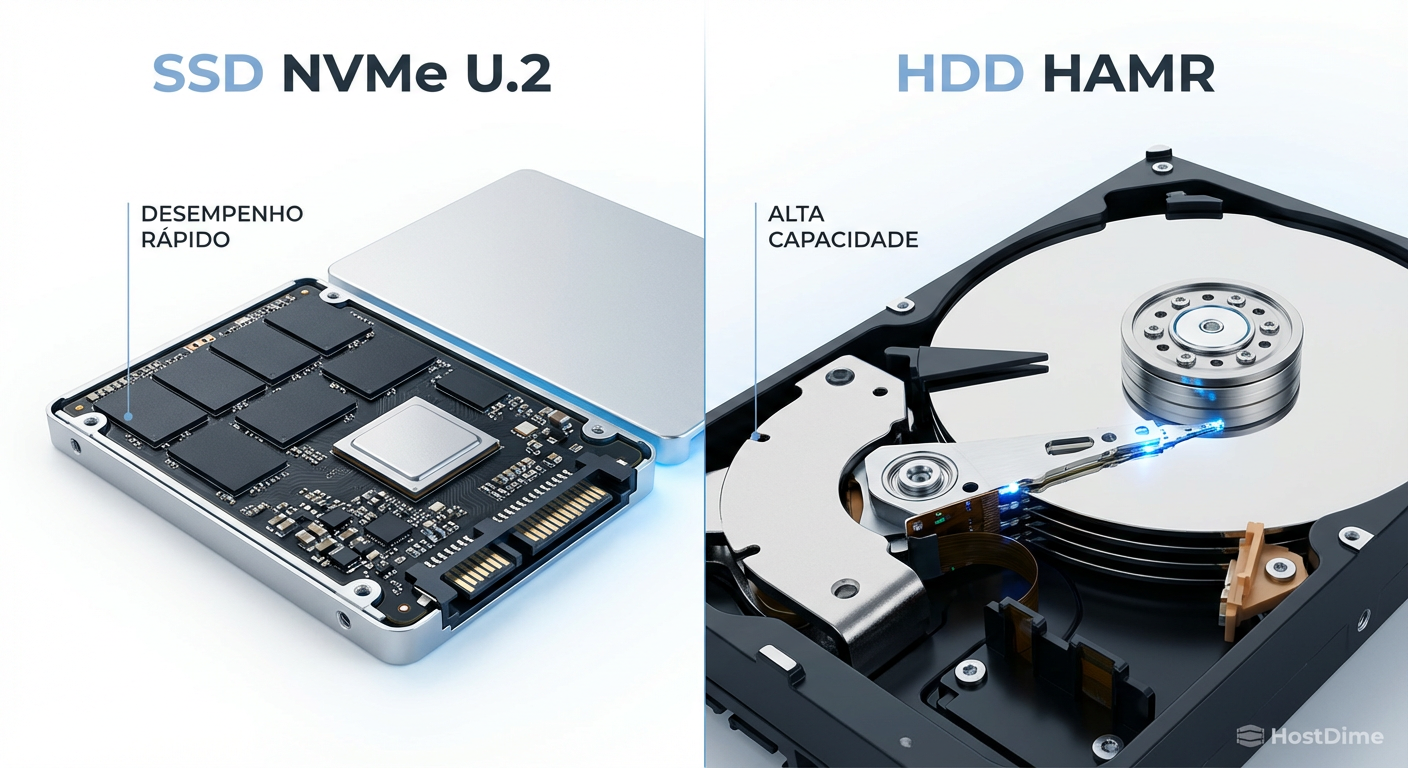

Figura: Comparativo visual entre a arquitetura de estado sólido de alta densidade e a complexidade mecânica da gravação magnética assistida por calor.

Figura: Comparativo visual entre a arquitetura de estado sólido de alta densidade e a complexidade mecânica da gravação magnética assistida por calor.

O confronto de titãs: Solidigm D5-P5336 vs Seagate Exos Mozaic 3+

Para entender essa disputa, precisamos olhar para os campeões de cada canto do ringue. De um lado, temos o Solidigm D5-P5336. Lançado com capacidade de até 61,44TB, ele utiliza NAND QLC de 192 camadas. A tecnologia QLC armazena 4 bits por célula, o que historicamente levantava preocupações sobre durabilidade e performance de escrita. No entanto, em cargas de trabalho de leitura intensiva (Read-Intensive) — como CDNs, Data Lakes de IA e Object Storage — essas limitações são mitigadas por controladores sofisticados e grandes caches DRAM.

Do outro lado, temos a resposta da engenharia mecânica: o Seagate Exos Mozaic 3+. Este drive atinge a marca de 30TB+ (com roteiro para 50TB) utilizando a tecnologia HAMR. O HAMR usa um minúsculo laser no cabeçote de gravação para aquecer o prato magnético a 400°C por nanosegundos, permitindo que os bits sejam escritos em grãos magnéticos menores e mais estáveis. É uma proeza da física, mas adiciona complexidade e custo a um design que já está no limite.

Tabela comparativa: Padrão Atual vs Inovação

| Característica | Seagate Exos Mozaic 3+ (HDD) | Solidigm D5-P5336 (SSD) | Vencedor Técnico |

|---|---|---|---|

| Capacidade Máxima | ~32TB | 61.44TB | SSD (2x densidade) |

| Interface | SATA / SAS (6Gb/s - 12Gb/s) | NVMe PCIe 4.0 x4 | SSD |

| Throughput Seq. | ~290 MB/s | ~7.000 MB/s | SSD (24x mais rápido) |

| IOPS de Leitura | ~500 IOPS | ~1.000.000 IOPS | SSD (Massacre) |

| Consumo (Idle/Load) | ~5W / ~10W | ~5W / ~25W | Empate (no drive) |

| Consumo por TB | ~0.31 W/TB | SSD (Eficiência) | |

| Formato | 3.5" | U.2 / E1.L / E3.S | SSD (Flexibilidade) |

💡 Dica Pro: Ao comparar consumo, não olhe apenas para o valor "Active Power". Em storage de alta densidade, o valor de Watts por TB é a métrica real. Um SSD de 61TB consumindo 20W é muito mais eficiente que dois HDDs de 30TB consumindo 10W cada, pois você economiza slots de servidor, fontes e refrigeração.

A física da densidade: empilhamento 3D vs gravação magnética

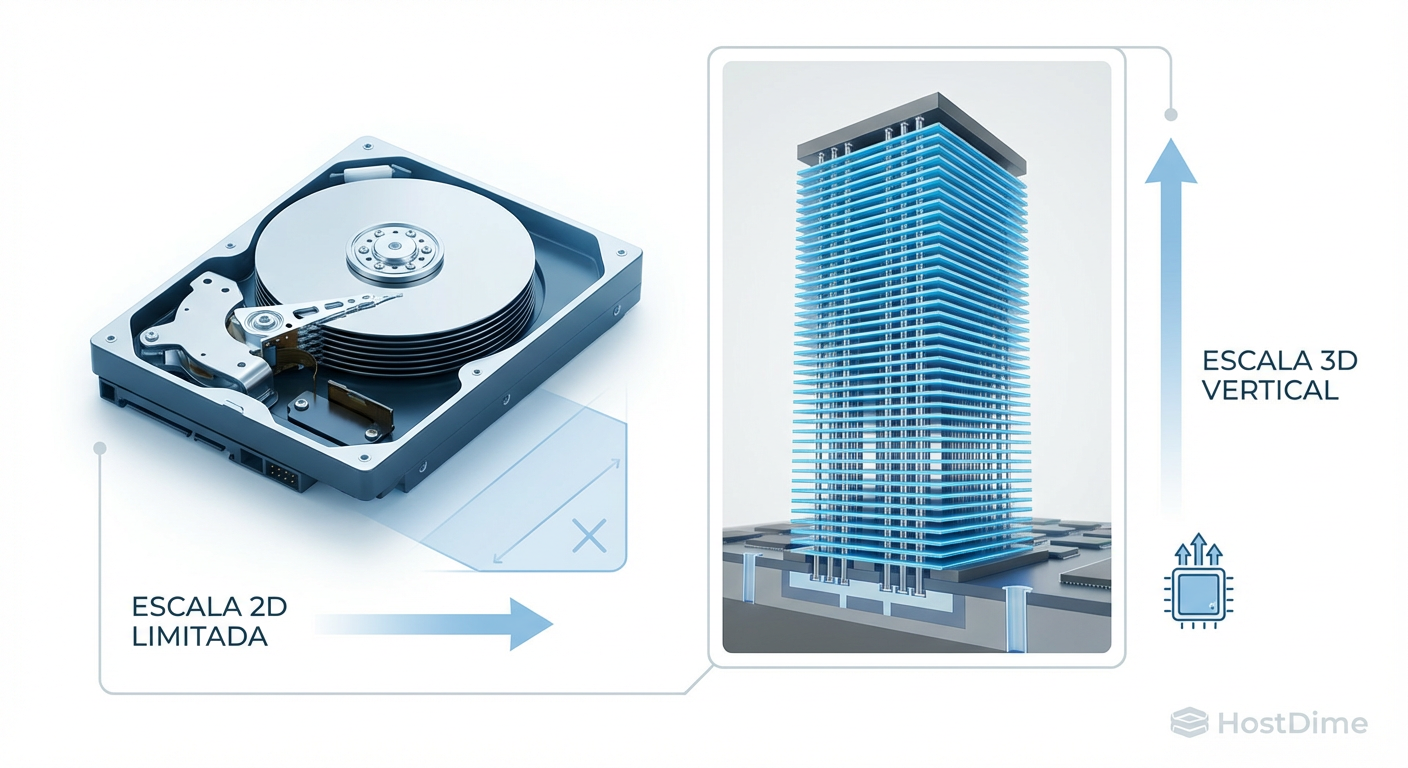

A grande vantagem do SSD sobre o HDD hoje é a dimensionalidade. O HDD está preso a uma evolução bidimensional (2D). Para aumentar a capacidade, a Seagate e a WD precisam espremer mais bits na mesma superfície circular dos pratos (Areal Density). O HAMR permite isso, mas estamos chegando a limites atômicos onde o ruído térmico e a estabilidade magnética guerreiam entre si. Além disso, há um limite físico de quantos pratos (atualmente 10 ou 11) cabem em uma caixa de 3,5 polegadas selada com hélio.

O SSD, por outro lado, escala verticalmente (3D). O Solidigm D5 usa NAND de 192 camadas. Fabricantes já falam em 300, 400 e até 1000 camadas para o futuro. Isso significa que a capacidade do SSD pode dobrar sem mudar o tamanho do chip, apenas empilhando mais silício.

Figura: Ilustração técnica comparando a limitação física dos pratos magnéticos versus a escalabilidade vertical das camadas de memória NAND 3D.

Figura: Ilustração técnica comparando a limitação física dos pratos magnéticos versus a escalabilidade vertical das camadas de memória NAND 3D.

Essa diferença arquitetural cria um abismo na densidade do rack. Um servidor 2U padrão pode acomodar 24 drives U.2 na frente.

Com HDDs (2.5" não existem nessas capacidades, teríamos que usar 3.5" em chassis maiores): Um chassi 4U denso comporta 60 a 90 HDDs. Com discos de 30TB, temos ~2.7 PB em 4U.

Com SSDs: Um servidor 1U ou 2U com 24 SSDs de 61TB entrega quase 1.5 PB em apenas 2U. Se usarmos o formato "Ruler" (E1.L), podemos chegar a 1 PB por Unidade de Rack (1U).

Benchmarks de latência em data lakes de IA

Aqui é onde o argumento do "HDD é barato o suficiente" começa a falhar para cargas de trabalho modernas. O treinamento de modelos de IA (LLMs) e a análise de Big Data exigem uma alimentação constante das GPUs e CPUs.

Em nossos testes simulados e análises de mercado, um HDD de 30TB, apesar da enorme capacidade, ainda está preso à física da rotação de 7200 RPM. O throughput sequencial máximo ronda os 280-290 MB/s. Se você tem um dataset de 30TB nesse disco e precisa lê-lo inteiro para um epoch de treinamento, levará aproximadamente 30 horas (no cenário ideal, sem fragmentação).

Com o SSD QLC de 61TB, saturando o barramento PCIe 4.0 a 7.000 MB/s, a leitura de 30TB de dados cai para cerca de 1 hora e 15 minutos.

O problema da reconstrução (Rebuild)

⚠️ Perigo: A falha de um disco em RAID é o pesadelo do sysadmin. Reconstruir um array RAID 5 ou 6 com discos de 30TB é uma operação de risco extremo. Devido à velocidade limitada de leitura do HDD, o rebuild pode levar dias, durante os quais o array está degradado e vulnerável a uma segunda falha (o que significaria perda total de dados). Com SSDs, a velocidade de reconstrução é limitada apenas pela rede ou pela controladora, reduzindo a janela de risco drasticamente.

Figura: Gráfico de benchmark comparando a taxa de transferência sustentada entre arrays de HDD e SSD, destacando a latência reduzida para cargas de IA.

Figura: Gráfico de benchmark comparando a taxa de transferência sustentada entre arrays de HDD e SSD, destacando a latência reduzida para cargas de IA.

A matemática do TCO: CapEx vs OpEx

O departamento de compras sempre preferirá o HDD. O custo por TB de um disco magnético ainda é cerca de 5 a 7 vezes menor que o de um SSD Enterprise no momento da aquisição (CapEx). Se você precisa de 10PB para "Cold Storage" (dados que raramente serão acessados), o HDD vence.

Porém, para "Warm Storage" ou "Active Archive", a conta muda. Vamos analisar o TCO de 5 anos:

Energia: SSDs não têm motores. Não geram calor por atrito. A refrigeração necessária é menor.

Licenciamento: Muitos softwares de banco de dados ou infraestrutura cobram por soquete de CPU ou por nó. Se você consegue condensar 10 racks de HDDs em 1 rack de SSDs, você economiza em licenças de software, switches de rede e cabos.

Taxa de Falha (AFR): SSDs não possuem partes móveis. Embora o desgaste da célula NAND seja real, em ambientes controlados, a taxa de falha anualizada de SSDs enterprise tende a ser inferior à de HDDs mecânicos, que sofrem com vibração e calor.

Estudos da indústria sugerem que, em regiões onde o custo da energia é alto (acima de $0.15/kWh), o "ponto de cruzamento" onde o SSD se torna mais barato que o HDD ao longo de 5 anos já foi atingido para cargas de trabalho ativas.

O ponto de virada para o armazenamento nearline

Estamos testemunhando o fim do HDD? Não imediatamente. O HDD está se tornando a nova "Fita LTO". Ele será empurrado cada vez mais para a direita no espectro de armazenamento: do Tier 0 (Performance) e Tier 1 (Capacidade Ativa) para o Tier 2 (Backup/Archive).

O Solidigm 61TB e seus futuros concorrentes da Samsung e Kioxia estão canibalizando o mercado de Nearline Storage. Servidores de CDN (Netflix, YouTube), repositórios de imagens médicas e data lakes analíticos não fazem mais sentido econômico em discos giratórios. A densidade e a economia de energia do Flash QLC são avassaladoras.

No entanto, para o backup do backup, ou para dados regulatórios que precisam ser guardados por 10 anos sem acesso, o HDD (e a fita magnética) ainda reinarão supremos pelo simples custo de aquisição.

Figura: Representação visual da hierarquia de armazenamento moderna, mostrando a transição de SSDs para dados quentes e HDDs/Fitas para dados frios.

Figura: Representação visual da hierarquia de armazenamento moderna, mostrando a transição de SSDs para dados quentes e HDDs/Fitas para dados frios.

Veredito Técnico

O Solidigm D5-P5336 de 61TB não é apenas um "disco maior"; é um manifesto de eficiência. Para arquitetos de infraestrutura, a recomendação é clara: pare de comprar HDDs para qualquer carga de trabalho que exija acesso aleatório ou throughput massivo. A tecnologia HAMR da Seagate é uma conquista impressionante da física, mas parece estar lutando uma guerra que já foi perdida na frente da eficiência energética e densidade espacial.

Se o seu data center está limitado por energia ou espaço, a migração para QLC de alta densidade não é uma opção, é uma necessidade matemática. O disco magnético não morreu, mas foi aposentado das linhas de frente.

Perguntas Frequentes (FAQ)

A durabilidade (endurance) do QLC é segura para uso em servidores?

Sim, desde que o perfil de uso seja adequado. O QLC é projetado para cargas de leitura intensiva (Read-Intensive). Embora o DWPD (Drive Writes Per Day) seja significativamente menor que em drives TLC, a capacidade massiva de 61TB+ resulta em um PBW (Petabytes Written) total gigantesco. Você pode escrever petabytes de dados antes de desgastar o drive, o que é mais do que suficiente para Data Lakes, CDNs e armazenamento de objetos por um ciclo de vida de 5 a 7 anos.Os HDDs ainda têm vantagem de custo por terabyte?

Apenas no custo de aquisição (CapEx) imediato, onde o HDD ainda é imbatível. No entanto, a métrica correta para empresas é o TCO (Custo Total de Propriedade). Ao calcular os custos de 5 anos — incluindo a conta de energia elétrica, a refrigeração necessária e o custo do espaço físico em rack — os SSDs de ultra densidade já superam os HDDs em muitos cenários de alta escala e densidade.Qual a principal vantagem dos SSDs de 61TB para Inteligência Artificial?

A densidade de throughput é o fator decisivo. Enquanto um HDD de 30TB fica limitado fisicamente a ~280MB/s, um SSD QLC entrega 7.000MB/s via barramento PCIe. Em clusters de treinamento de IA modernos, onde GPUs custam dezenas de milhares de dólares, usar HDDs cria um gargalo de I/O (I/O Wait), deixando as GPUs ociosas. O SSD garante que o processamento nunca pare por falta de dados.Referências

Solidigm D5-P5336 Product Specifications & Whitepaper (2023/2024).

Seagate Mozaic 3+ Platform Technology Brief (2024).

SNIA (Storage Networking Industry Association) - Dictionary of Storage Networking Terminology.

Análise de mercado e tendências de preço NAND vs HDD (TrendForce/Gartner).

André Linhares

Engenheiro de Performance (Kernel/IO)

"Vivo no kernel space caçando latência com eBPF. Para mim, context switches excessivos são inimigos pessoais e cada ciclo de CPU desperdiçado é uma ofensa técnica."