ZFS Special VDEVs: Arquitetura, Dimensionamento e a Cura para a Latência

Descubra como os Special VDEVs do OpenZFS eliminam o gargalo de IOPS em pools de HDDs. Guia avançado de arquitetura, dimensionamento (0.3% rule) e riscos de implementação.

A latência é o assassino silencioso da infraestrutura de armazenamento. Enquanto o marketing vende throughput sequencial em gigabytes por segundo, a realidade de um administrador de sistemas é vivida na casa dos milissegundos, lutando contra o tempo de busca (seek time) de discos mecânicos.

Se você já construiu um pool ZFS massivo com dezenas de discos rígidos (HDDs), conhece a sensação: o throughput de streaming é fenomenal, mas listar um diretório com milhões de arquivos ou realizar um rsync parece arrastar uma âncora no fundo do oceano. O culpado quase sempre é o mesmo: a física. A cabeça de leitura de um disco mecânico não pode estar em dois lugares ao mesmo tempo, e o ZFS, por sua natureza Copy-on-Write (CoW), fragmenta metadados ao longo do tempo.

É aqui que entram os Special VDEVs (Classes de Alocação Especial). Introduzidos no OpenZFS 0.8, eles representam a mudança arquitetural mais significativa desde a criação do ZFS, permitindo que segreguemos fisicamente a estrutura óssea do sistema de arquivos (metadados) da carne (dados).

Resumo em 30 segundos

- Não é Cache: Diferente do L2ARC (leitura) ou SLOG (escrita síncrona), o Special VDEV é armazenamento primário persistente. Se ele morrer, você perde o pool.

- Aceleração Cirúrgica: Ele move metadados (dnodes, blocos indiretos) e pequenos arquivos para SSDs/NVMe, deixando os HDDs livres para o que fazem melhor: leituras sequenciais grandes.

- Hibridismo Real: Com a configuração

special_small_blocks, você pode transformar um pool de HDDs lentos em um array all-flash para cargas de trabalho de arquivos pequenos e bancos de dados.

O paradoxo do throughput alto e IOPS anêmico

Para entender a necessidade do Special VDEV, precisamos revisitar a anatomia de um gargalo de armazenamento. Um HDD moderno de 20TB ou 22TB, lançado em 2024, ainda opera sob as mesmas restrições mecânicas de um disco de 1990: ele só consegue realizar cerca de 100 a 150 IOPS (Operações de Entrada/Saída por Segundo) aleatórias.

O ZFS é um sistema de arquivos transacional baseado em uma Árvore de Merkle. Cada bloco de dados possui um pai (bloco indireto) que contém seu checksum. Para ler um arquivo, o sistema precisa caminhar por essa árvore de ponteiros.

Em um pool puramente magnético, essa "caminhada" exige múltiplos movimentos mecânicos da cabeça de leitura. Seus metadados estão espalhados entre os dados. Quando você solicita um arquivo pequeno, o disco gasta 8ms buscando o metadado, 0,1ms lendo o dado, e mais 8ms buscando o próximo metadado. O disco passa mais tempo buscando do que transferindo. O resultado é um sistema que pode mover 2GB/s em um filme, mas engasga para deletar uma pasta com 50.000 e-mails.

Por que o L2ARC e o SLOG não resolvem o problema estrutural

Muitos administradores tentam resolver isso jogando cache no problema. Embora ajude, não é a cura.

L2ARC (Level 2 Adaptive Replacement Cache): É um cache de leitura volátil. Ele precisa ser "aquecido". Se os dados não foram lidos recentemente, eles não estão lá. Além disso, o L2ARC consome RAM para indexar a si mesmo, roubando espaço do ARC (cache primário), o que pode ser contraproducente em sistemas com pouca memória.

SLOG (Separate ZFS Intent Log): Resolve apenas a latência de escritas síncronas (como NFS ou bancos de dados). Ele não acelera leituras, nem escritas assíncronas, e não ajuda na navegação da estrutura de diretórios.

O Special VDEV não é cache. É uma Classe de Alocação. Ele instrui o alocador do ZFS (o DMU - Data Management Unit) a colocar tipos específicos de blocos em dispositivos físicos específicos permanentemente.

Arquitetura da classe de alocação especial no OpenZFS

Ao adicionar um VDEV do tipo special ao seu pool, você está criando um local VIP para os blocos mais críticos do sistema. Por padrão, assim que esse VDEV é criado, todas as novas alocações de metadados são direcionadas para ele.

Isso inclui:

Dnodes: As estruturas que representam arquivos e diretórios.

Blocos Indiretos: Os ponteiros que formam a árvore do sistema de arquivos.

Diretórios: As listas de arquivos dentro das pastas.

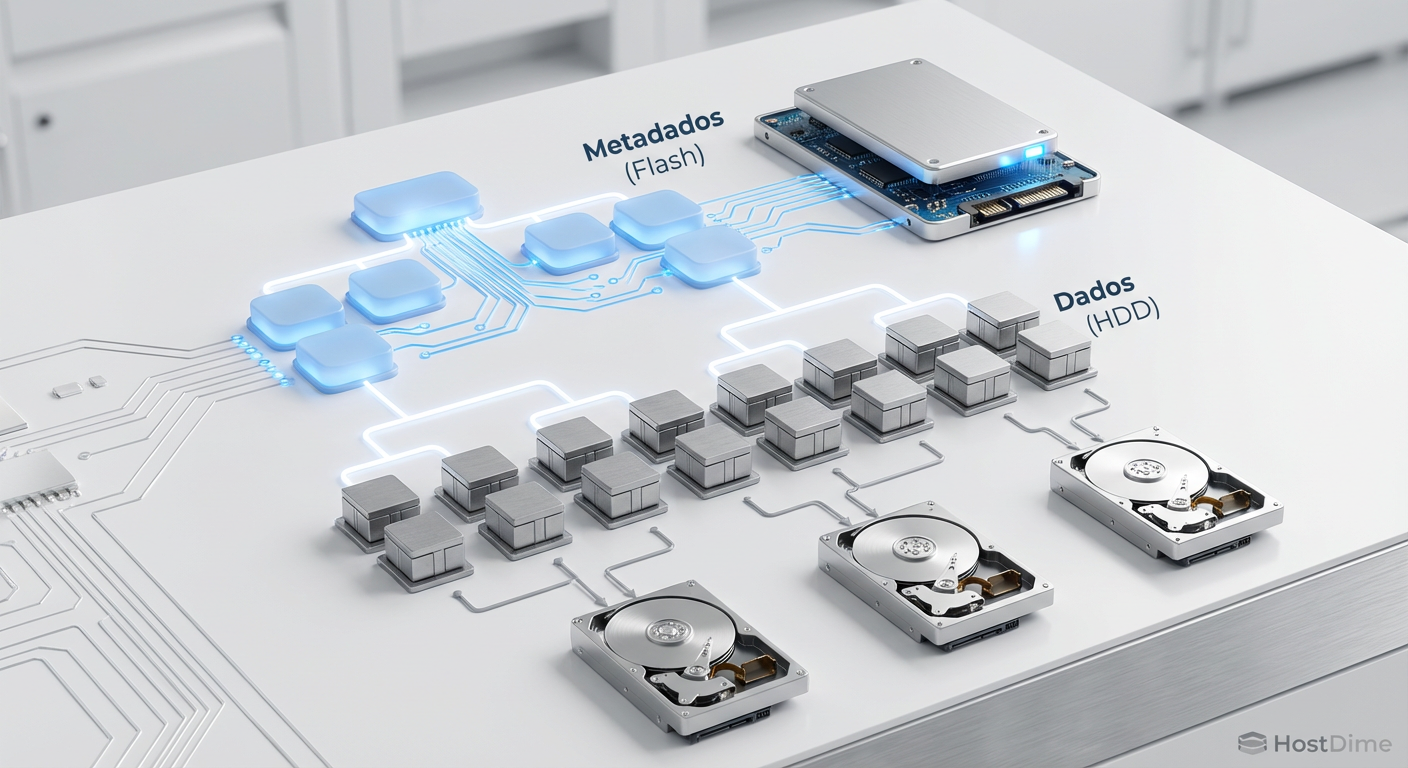

Fig. 1: A separação física de metadados e dados transformando a árvore de ponteiros do ZFS.

Fig. 1: A separação física de metadados e dados transformando a árvore de ponteiros do ZFS.

Ao mover esses elementos para um espelho de SSDs NVMe, as operações de "caminhada na árvore" tornam-se instantâneas. A latência de busca cai de milissegundos para microssegundos. O efeito colateral mais bonito é que seus HDDs rotacionais ficam subitamente silenciosos. Eles param de fazer o "thrashing" (barulho de busca frenética) e passam a operar quase exclusivamente em leituras e escritas lineares de dados brutos (payload).

💡 Dica Pro: Em pools existentes, adicionar um Special VDEV afeta apenas novos dados. Para migrar os metadados antigos para o flash, você precisará reescrever os dados. A maneira mais simples é usar o

zfs send | zfs recvou, em versões mais recentes do OpenZFS, o recurso de rebalanceamento (ainda em maturação) ou simplesmente mover os arquivos de pasta.

Otimizando pequenos blocos e tabelas de deduplicação

A mágica real acontece quando vamos além dos metadados. O ZFS permite configurar o parâmetro special_small_blocks.

Este parâmetro define um limite de tamanho (em potências de 2). Qualquer arquivo ou bloco de dados igual ou menor que esse tamanho será armazenado no Special VDEV (Flash), e não nos HDDs.

Imagine um servidor de arquivos que armazena imagens médicas (grandes) e arquivos de texto de laudos (pequenos). Se definirmos zfs set special_small_blocks=32K tank/medicos:

Os Raios-X (50MB) vão para os HDDs (barato).

Os laudos em texto (10KB) vão para o NVMe (rápido).

Isso elimina o problema de "Write Amplification" e desperdício de IOPS nos discos rotacionais para arquivos que são, essencialmente, poeira digital em termos de tamanho, mas custosos em termos de busca.

Fig. 2: O impacto da configuração 'special_small_blocks'. Arquivos à esquerda do corte residem puramente no flash.

Fig. 2: O impacto da configuração 'special_small_blocks'. Arquivos à esquerda do corte residem puramente no flash.

A Tabela de Deduplicação (DDT)

Se você for corajoso (ou louco) o suficiente para usar Deduplicação no ZFS, o Special VDEV é obrigatório. A Tabela de Deduplicação (DDT) mapeia o checksum de cada bloco para sua localização física. Em HDDs, consultar a DDT para cada escrita destrói a performance. Colocar a DDT no Special VDEV torna a deduplicação utilizável, embora ainda consuma muita CPU e RAM.

Para dedicar um VDEV apenas para deduplicação, usa-se a classe dedup, mas na prática, o special engloba essa função se não houver um vdev dedup específico.

Dimensionando a capacidade: Recordsize e Inodes

O erro número um ao implementar Special VDEVs é subdimensionar o tamanho, o que leva ao transbordamento (spillover). Quando o Special VDEV enche, os metadados voltam a ser gravados nos HDDs, e a performance se torna inconsistente.

Para dimensionar corretamente, precisamos de matemática, não de adivinhação.

1. Cálculo Base de Metadados

A regra geral da comunidade OpenZFS é que os metadados ocupam cerca de 0.3% da capacidade do pool.

Para 100TB de HDDs, você precisaria de ~300GB de Special VDEV apenas para metadados puros.

No entanto, se você usa

recordsizepequeno (ex: 4K ou 8K para iSCSI/VMs), a quantidade de metadados explode. Blocos menores geram mais ponteiros indiretos.Se o seu

recordsizefor o padrão de 128K ou 1M (para mídia), a proporção de metadados é minúscula (0.1%).

2. Cálculo com Small Blocks

Se você ativar special_small_blocks, o cálculo muda drasticamente. Você precisa analisar sua distribuição de arquivos atual.

Ferramentas como zdb -Lbbbs poolname podem mostrar um histograma dos tamanhos de blocos no seu pool atual.

Se você descobrir que 10% do seu espaço ocupado é composto por arquivos menores que 64K, e você ativar special_small_blocks=64K, seu Special VDEV precisará ter 10% do tamanho total do pool, mais margem de segurança.

⚠️ Perigo: Nunca encha um Special VDEV acima de 75-80%. A fragmentação em SSDs degrada a performance de escrita e aumenta o desgaste (wear leveling). Superdimensione sempre. SSDs são baratos comparados ao custo de reconstruir um pool lento.

Riscos de falha catastrófica e a necessidade de espelhamento

Aqui é onde o tom pedagógico se torna um aviso severo.

O Special VDEV é parte integrante do pool. Não é um cache que pode ser perdido sem consequências. Se você perder seu Special VDEV, você perde todos os metadados. Um pool sem metadados é apenas uma sopa de bits aleatórios irrecuperáveis. Seus dados nos HDDs estarão intactos, mas você não terá o mapa para encontrá-los.

Portanto, a redundância é inegociável.

Nunca use um único SSD: Isso é suicídio de dados.

Espelhamento (Mirror) é o mínimo: Use pelo menos um RAID-1 de 2 SSDs.

Espelhamento Triplo (3-way Mirror) é o ideal: Para ambientes corporativos ou datacenters, onde a confiabilidade deve exceder a dos HDDs subjacentes.

Fig. 3: Redundância é inegociável. A perda de um VDEV Especial é fatal para o pool.

Fig. 3: Redundância é inegociável. A perda de um VDEV Especial é fatal para o pool.

Qualidade do Hardware (Endurance)

Não use SSDs de consumo (QLC/TLC baratos sem DRAM) para Special VDEVs em ambientes de escrita intensa. Os metadados sofrem muitas pequenas escritas e reescritas. Procure por:

NVMe Enterprise: Séries como Intel/Solidigm D7, Micron 7450/9400, ou Samsung PM9A3.

PLP (Power Loss Protection): Essencial para garantir que as transações de metadados sejam comitadas em caso de queda de energia, evitando corrupção.

Alta Resistência (DWPD): Procure drives com pelo menos 1 DWPD (Drive Writes Per Day) ou 3 DWPD se for usar para bancos de dados intensos.

Configuração Prática

Vamos supor que você tenha um pool chamado tank e adquiriu dois SSDs NVMe (/dev/nvme0n1 e /dev/nvme1n1).

1. Adicionando o Special VDEV:

zpool add tank special mirror /dev/nvme0n1 /dev/nvme1n1

Nota: Sempre use IDs persistentes (/dev/disk/by-id/...) na vida real.

2. Configurando Small Blocks (Por Dataset): Não ative isso globalmente a menos que tenha certeza. Ative por dataset conforme a carga de trabalho.

zfs set special_small_blocks=32K tank/documentos

# Para um dataset de compilação de código (muitos arquivos pequenos)

zfs set special_small_blocks=64K tank/builds

# Para ISOs e Backups (não desperdice SSD aqui)

zfs set special_small_blocks=0 tank/backups

3. Monitoramento:

Use o comando zpool iostat -v para ver o fluxo de dados. Você verá uma nova linha special e poderá confirmar se as escritas estão indo para lá.

O veredito do Guru

A introdução dos Special VDEVs é a "cura" para a latência em sistemas de armazenamento híbridos. Ela nos permite quebrar a ditadura da física dos discos rotacionais sem o custo proibitivo de migrar petabytes inteiramente para flash.

No entanto, com grandes poderes vêm grandes responsabilidades arquiteturais. Implementar Special VDEVs sem entender o perfil dos seus dados ou negligenciar a redundância dos SSDs é um convite para o desastre. Trate seus VDEVs especiais com mais carinho e paranóia do que seus discos de dados. Se os metadados são a alma do ZFS, o Special VDEV é o corpo físico que a sustenta. Não deixe esse corpo falhar.

Perguntas Frequentes

P: Posso remover um Special VDEV depois de adicionado? R: Depende da versão do OpenZFS e da configuração de RAID. Em versões modernas (OpenZFS 2.0+), é possível remover um mirror de topo se houver espaço suficiente nos outros VDEVs para onde os dados possam ser evacuados. O ZFS copiará os metadados de volta para os HDDs. No entanto, é uma operação intensiva e arriscada. Planeje para que seja permanente.

P: O que acontece se o Special VDEV encher? R: O ZFS não para. Ele fará o "spill over" (transbordo) e começará a gravar novos metadados/small blocks nos HDDs normais. A performance cairá para esses novos dados, mas o sistema continua operando. O perigo é a fragmentação que isso gera.

P: Preciso de SSDs do mesmo tamanho dos HDDs?

R: Absolutamente não. Como regra prática, para armazenamento genérico, 0.5% a 1% da capacidade bruta do pool é um bom ponto de partida se não usar small_blocks agressivos. Para 100TB de HDD, um par de SSDs de 1TB (RAID1) é geralmente superabundante e seguro.

Referências & Leitura Complementar

OpenZFS Documentation - Allocation Classes: Detalhamento técnico oficial sobre a implementação de classes de alocação.

ZFS on Linux Commit #9594 (2019): O commit original de Don Brady (Intel) introduzindo a funcionalidade Allocation Classes.

Arpaci-Dusseau, R. H., & Arpaci-Dusseau, A. C. Operating Systems: Three Easy Pieces. (Capítulos sobre Log-Structured File Systems e Fast File Systems para entender a teoria de base).

Jude, J., & Lucas, M. W. FreeBSD Mastery: ZFS. (A bíblia prática para administradores, cobrindo conceitos aplicáveis também ao ZFS on Linux).

Roberto Lemos

Guru de Sistemas de Arquivos (ZFS/Btrfs)

"Dedico minha carreira à integridade dos dados. Para mim, o bit rot é o inimigo e o Copy-on-Write é a salvação. Exploro a fundo ZFS, Btrfs e a beleza dos checksums."